机器学习-决策树和随机森林

Posted 徐卜灵

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了机器学习-决策树和随机森林相关的知识,希望对你有一定的参考价值。

这节课终于不是那么迷糊了,如果100分满分的话,听懂程度有70分了,初学者就是这么容易满足。 :| 老师说这是这20次课里最简单的一次。。。oh。。。no。

不废话了,接着记笔记吧。

CART:classsification and regression tree

三种决策树:ID3,C4.5,CART

树是最重要的数据结构。

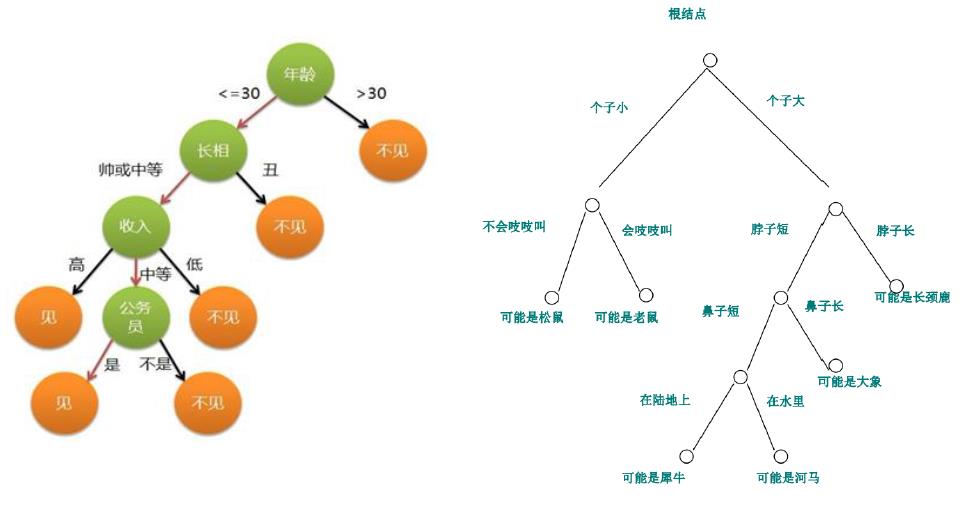

决策树示意图:

决策树最重要的知识点:

决策树学习采用的是自顶向下的递归方法,其基本思想是以信息熵为度量构造一棵熵值下降最快的树,到叶子节点处的熵值为零。此时每个叶节点中的实例都属于同一类。

算法最大的优点是可以自学习。不需要使用者了解过多知识背景,只需要对训练实例进行较好的标注,就能够进行学习。属于有监督学习。

从一类无序、无规则的事物中推理决策树表示的分类规则。

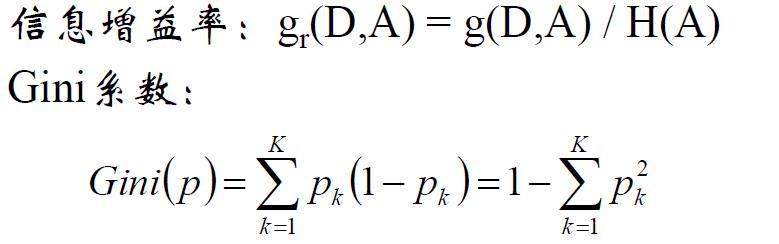

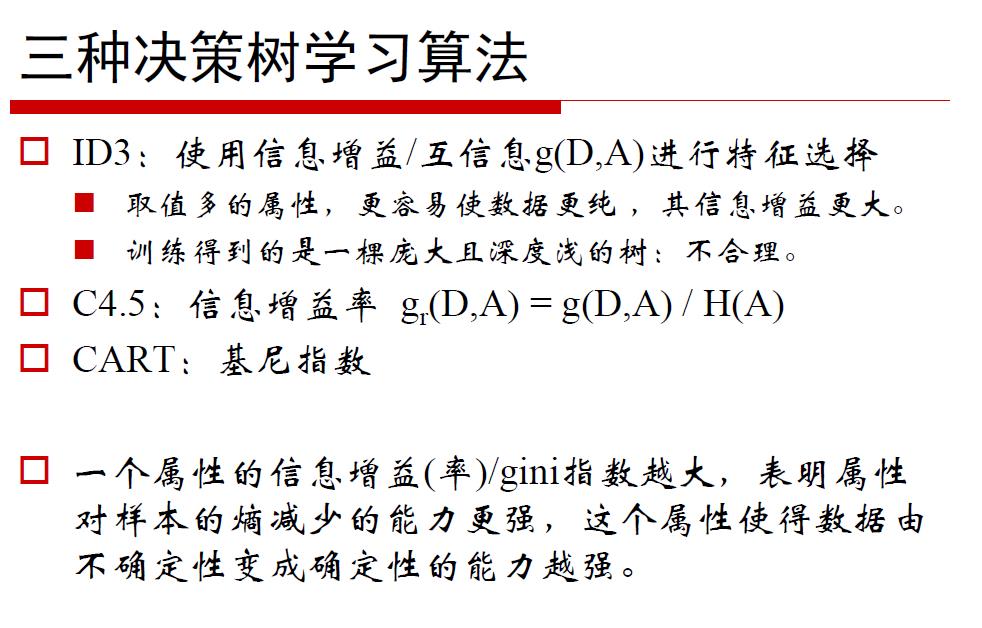

建立决策树的关键:即在当前状态下选择哪个属性作为分类依据。根据不同的目标函数,建立决策树主要有以下三种算法:ID3,C4.5,CART.

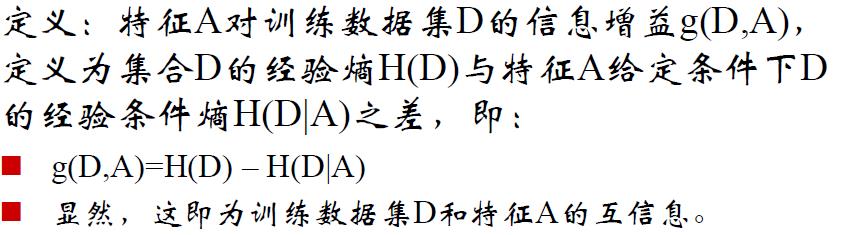

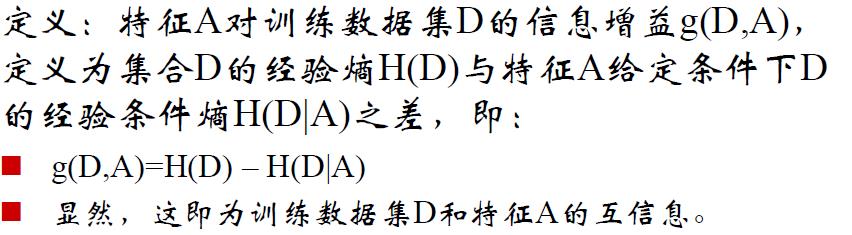

经验熵:由数据估计概率得到的熵。

经验条件熵:有数据估计概率得到的条件熵。

信息增益:得知特征A的信息而使类X的信息的不确定性减少的程度。

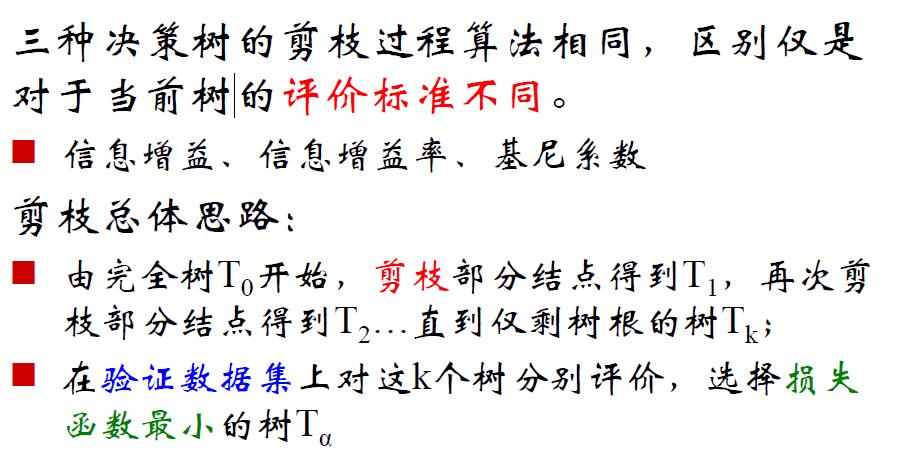

剪枝是为了防止过拟合,提高泛化能力。(为了适应测试)

分为前剪枝和后剪枝。

前剪枝:比如约束树的高度,叶子节点的个数。

后剪枝:树建好了以后再以某种标准进行剪枝。

Bagging:

可以加权。

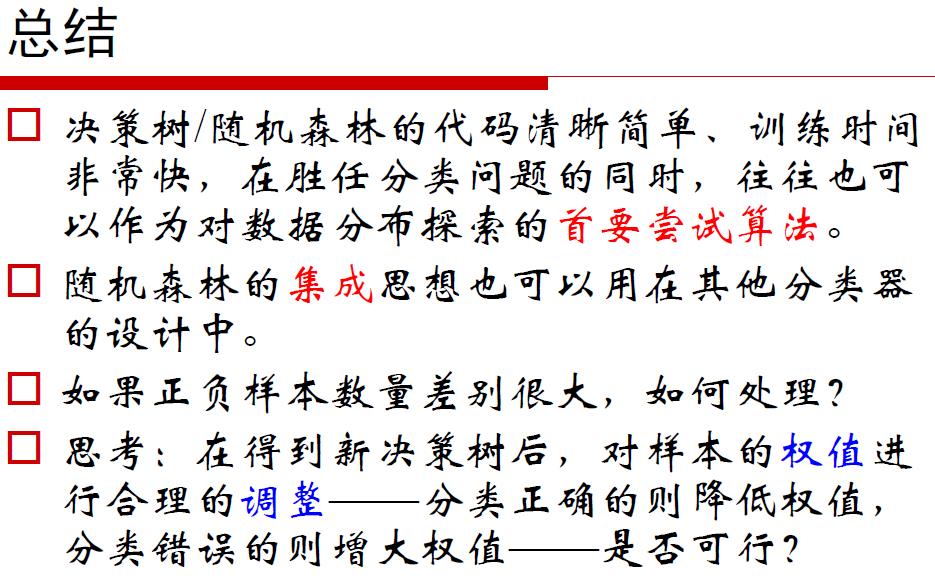

最后邹老师的总结。

*********************************************分割线*********************************************

现在回过头来,看开头说听懂了70%说高了。555555555555555555555555.............不灰心,不放弃。下午更新最爱的SVM。不知道看了几遍了,看能总结成什么样吧。

以上是关于机器学习-决策树和随机森林的主要内容,如果未能解决你的问题,请参考以下文章