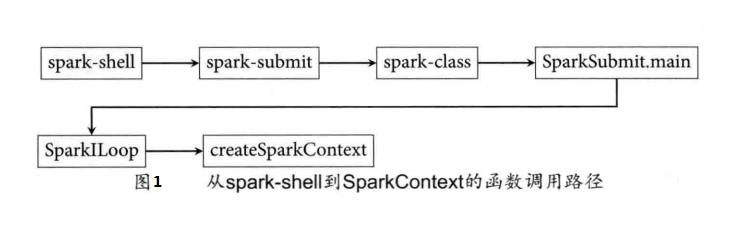

从Spark-Shell到SparkContext的函数调用路径过程分析(源码)

Posted 大数据和人工智能躺过的坑

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了从Spark-Shell到SparkContext的函数调用路径过程分析(源码)相关的知识,希望对你有一定的参考价值。

不急,循序渐进,先打好基础

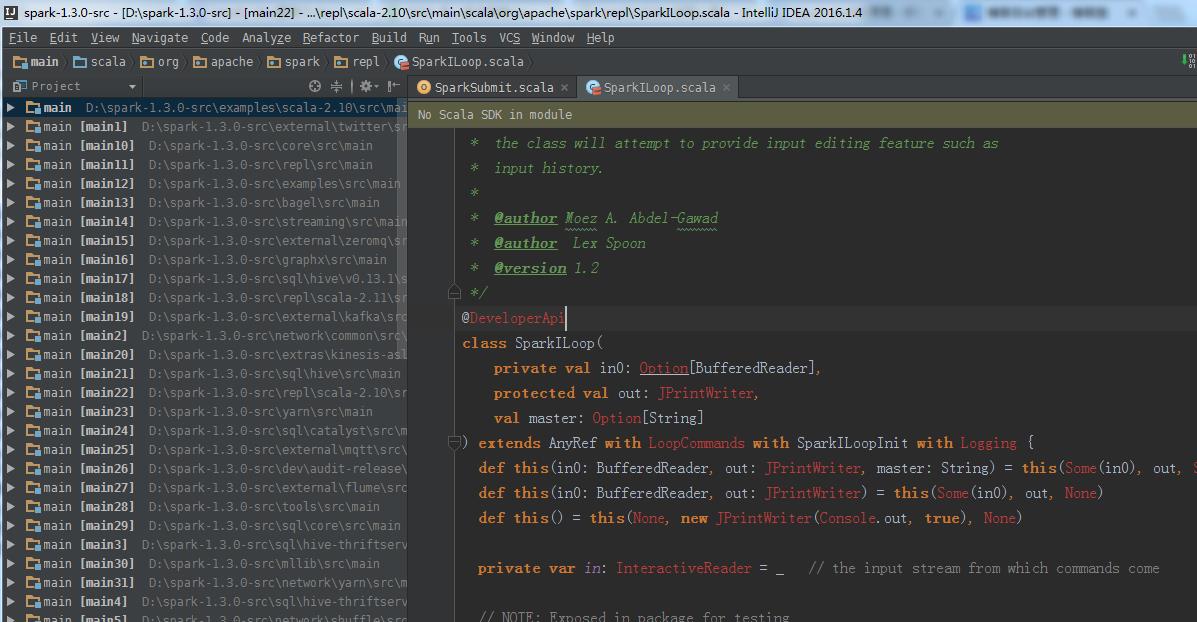

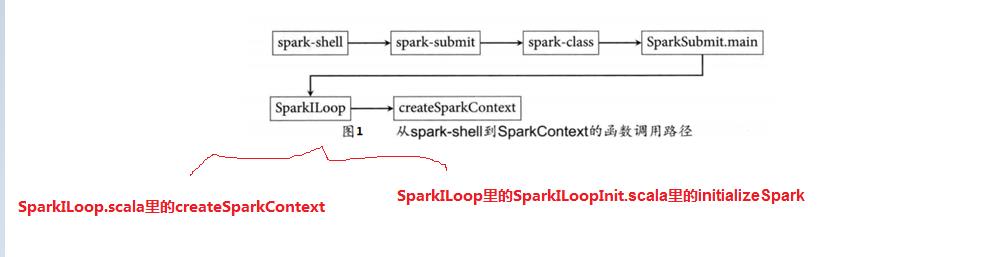

Spark shell的原理

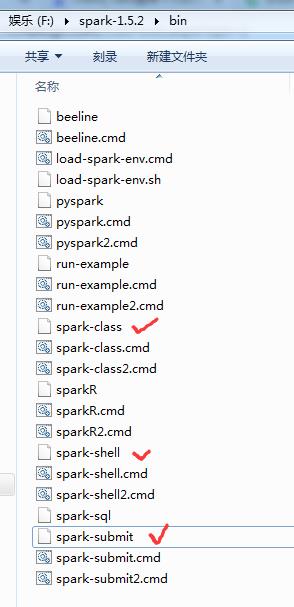

首先,我们清晰定位找到这几个。

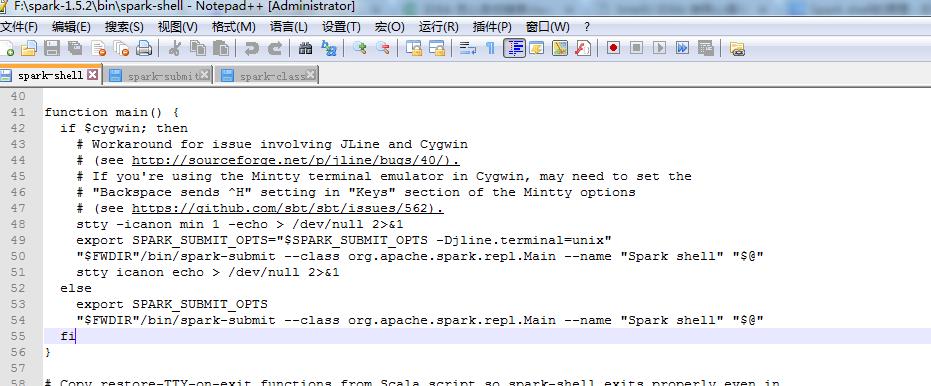

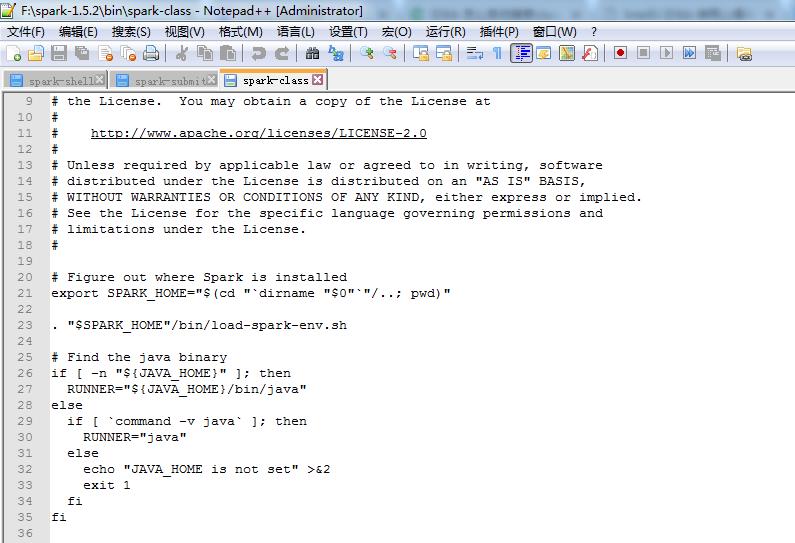

1、spark-shell

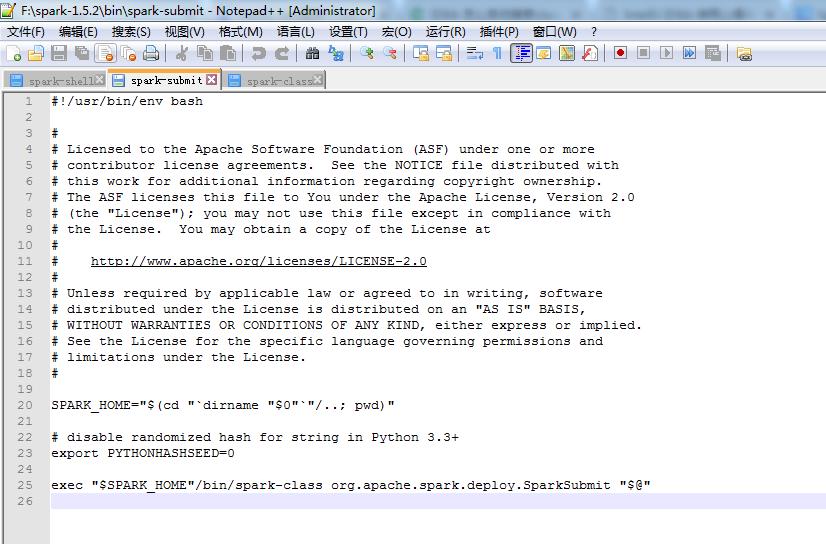

2、 spark-submit

3、spark-class

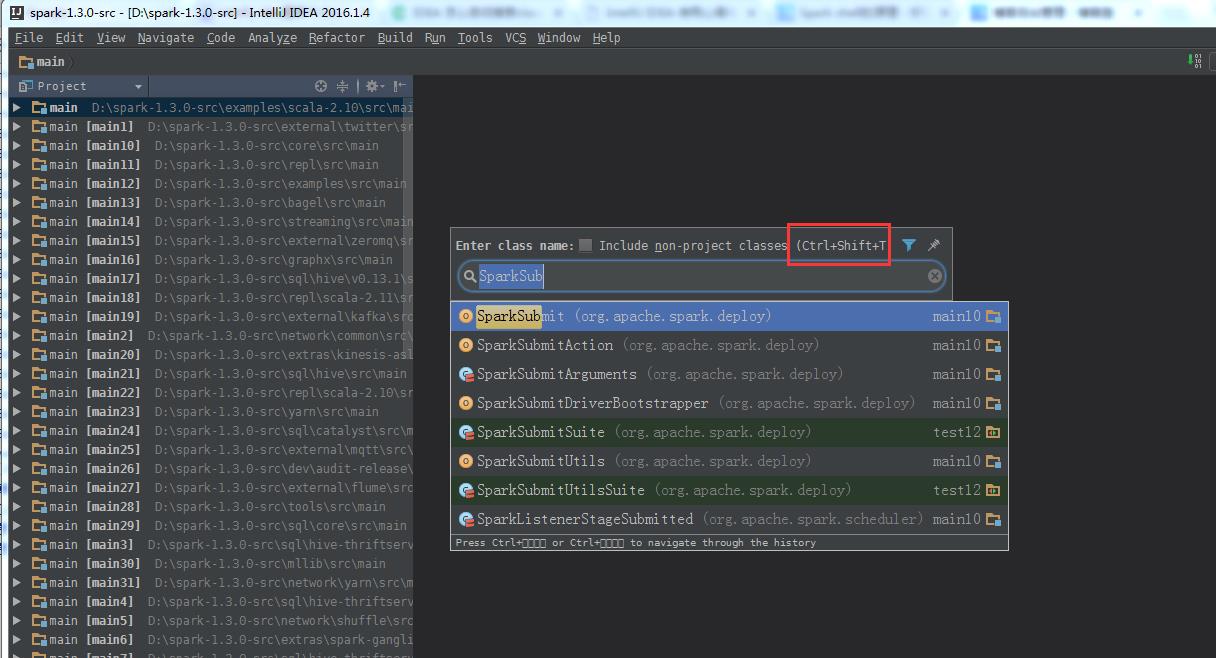

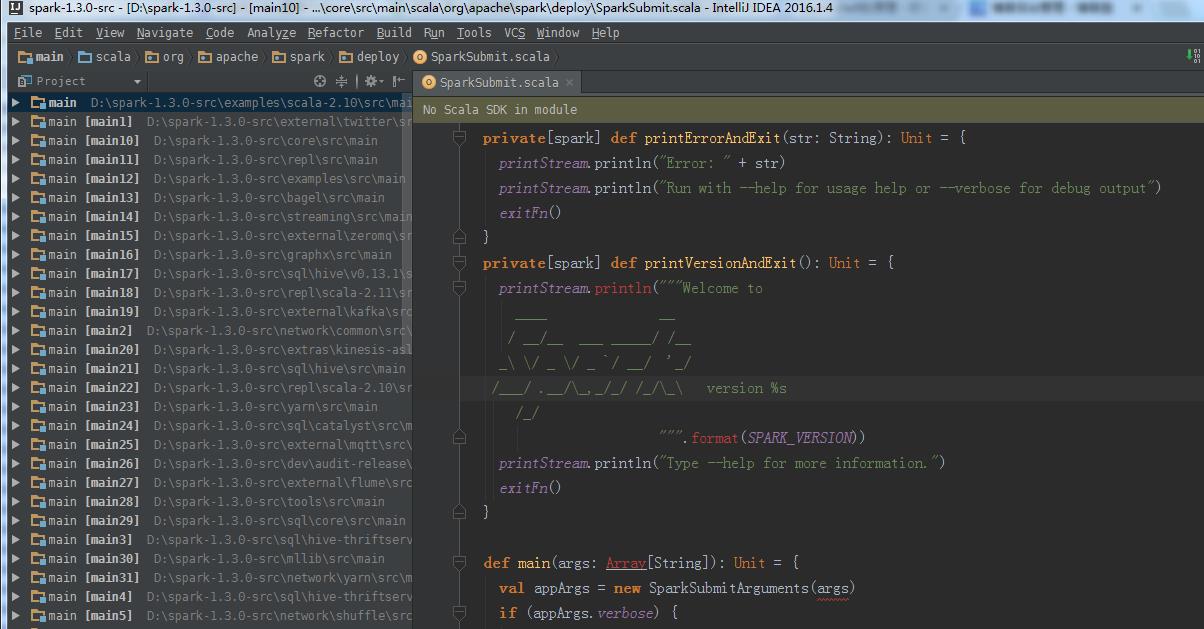

4、SparkSubmit.scala

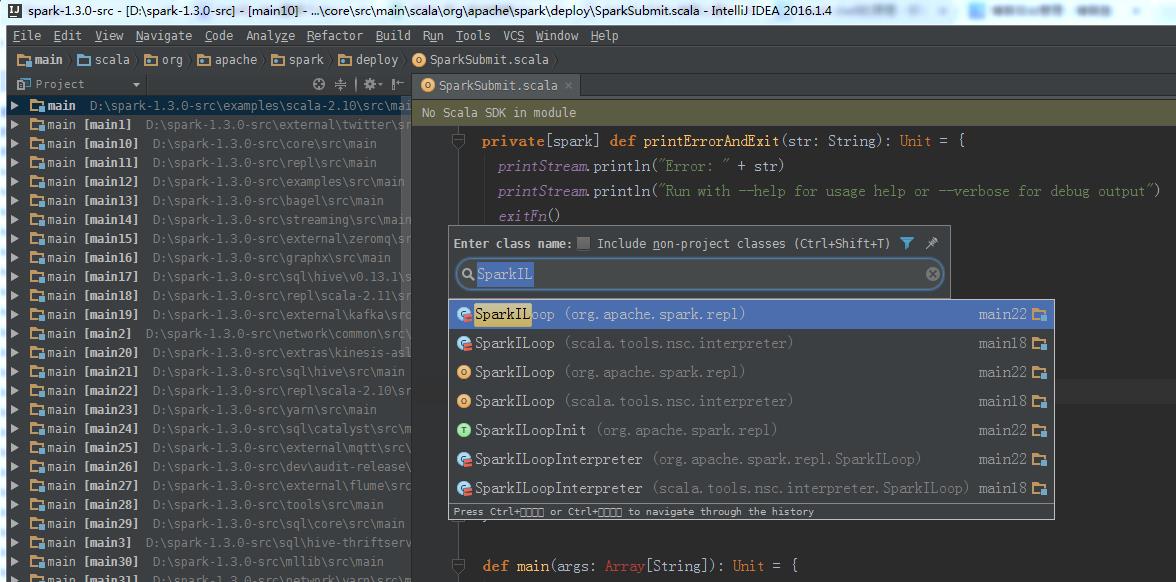

5、SparkILoop.scala

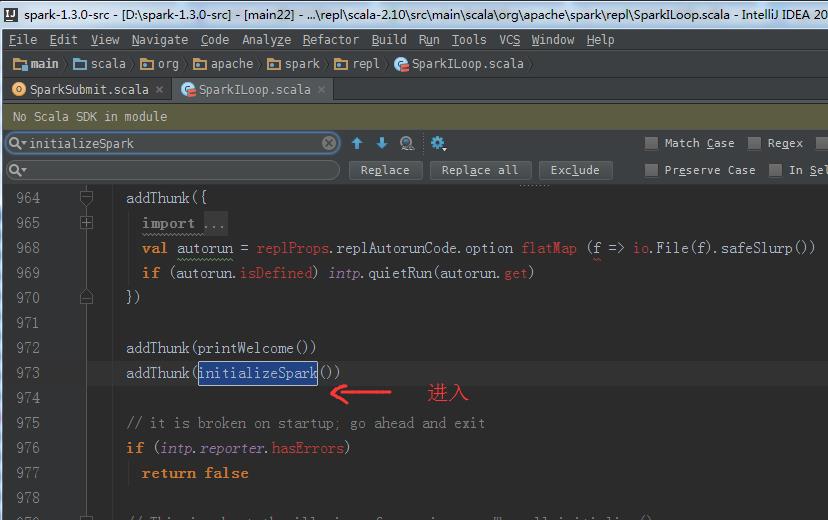

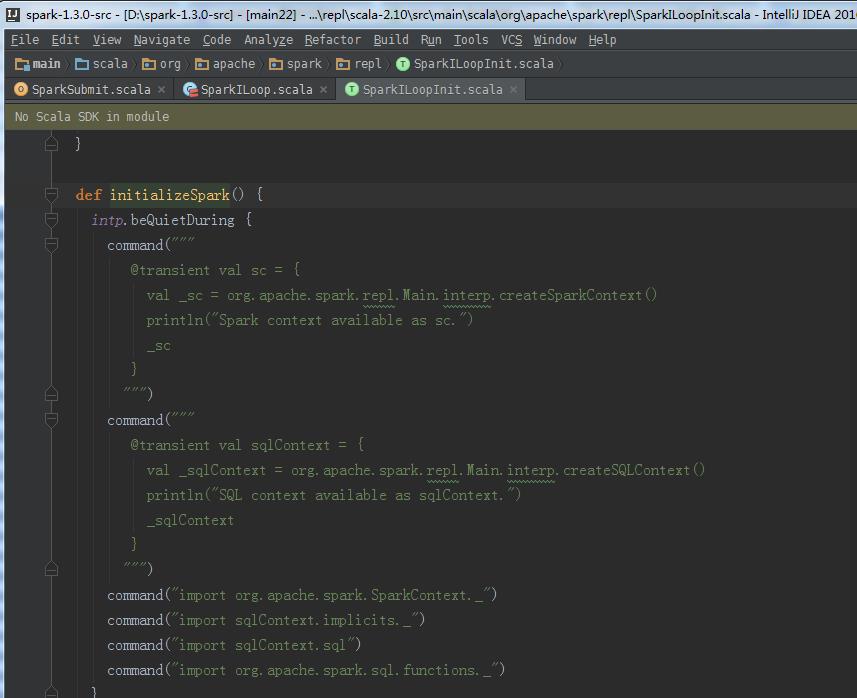

initializeSpark的源码

def initializeSpark() {

intp.beQuietDuring {

command("""

@transient val sc = {

val _sc = org.apache.spark.repl.Main.interp.createSparkContext()

println("Spark context available as sc.")

_sc

}

""")

command("""

@transient val sqlContext = {

val _sqlContext = org.apache.spark.repl.Main.interp.createSQLContext()

println("SQL context available as sqlContext.")

_sqlContext

}

""")

command("import org.apache.spark.SparkContext._")

command("import sqlContext.implicits._")

command("import sqlContext.sql")

command("import org.apache.spark.sql.functions._")

}

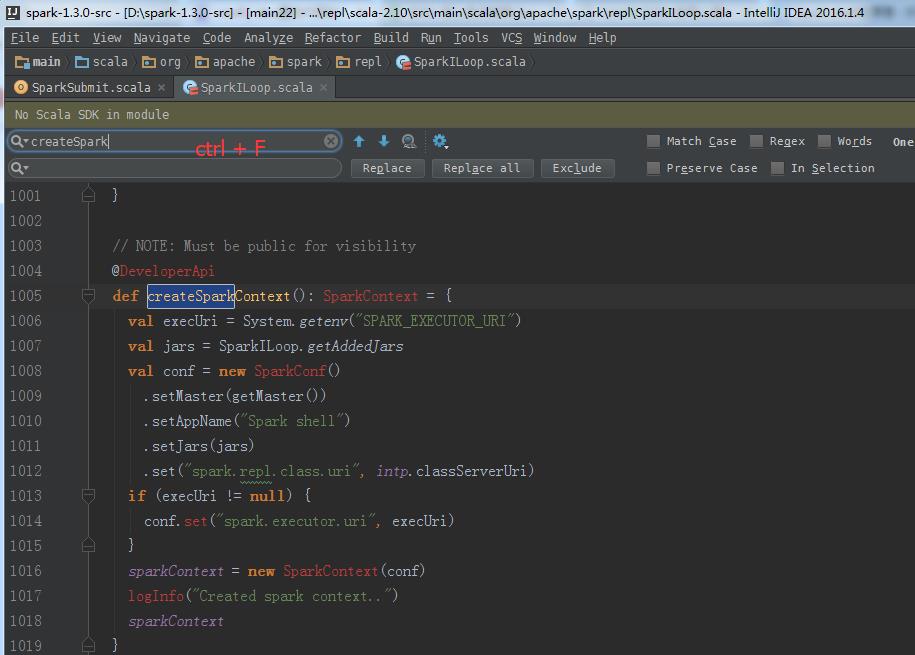

createSparkContext的源码

// NOTE: Must be public for visibility

@DeveloperApi

def createSparkContext(): SparkContext = {

val execUri = System.getenv("SPARK_EXECUTOR_URI")

val jars = SparkILoop.getAddedJars

val conf = new SparkConf()

.setMaster(getMaster())

.setAppName("Spark shell")

.setJars(jars)

.set("spark.repl.class.uri", intp.classServerUri)

if (execUri != null) {

conf.set("spark.executor.uri", execUri)

}

sparkContext = new SparkContext(conf)

logInfo("Created spark context..")

sparkContext

}

总结

以上是关于从Spark-Shell到SparkContext的函数调用路径过程分析(源码)的主要内容,如果未能解决你的问题,请参考以下文章

使用spark-shell时,使用sparkConf.set(..)自定义SparkContext

Spark 报错解决--Error initializing SparkContext

Win安装Spark问题:ERROR SparkContext: Error initializing SparkContext