局部加权回归(HGL的机器学习笔记3)

Posted LeonHuo

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了局部加权回归(HGL的机器学习笔记3)相关的知识,希望对你有一定的参考价值。

局部加权回归(Locally Weighted Regression, LWR)

局部加权回归使一种非参数方法(Non-parametric)。在每次预测新样本时会重新训练临近的数据得到新参数值。意思是每次预测数据需要依赖训练训练集,所以每次估计的参数值是不确定的。

局部加权回归优点:

- 需要预测的数据仅与到训练数据的距离有关,距离越近,关系越大,反之越小;

- 可以有效避免欠拟合,减小了较远数据的干扰,仅与较近的数据有关。

局部加权回归原理:

图1 局部加权回归原理

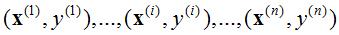

对于一般训练集:

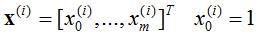

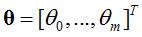

参数系统为:

线性模型为:

线性回归损失函数J(θ):

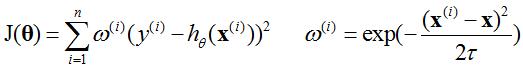

局部加权回归的损失函数J(θ):

其中,τ为波长函数[1],权重之所以采取指数形式是因为这个形式最常见。

[1] 机器学习。

原创文章,转载请注明出处!

以上是关于局部加权回归(HGL的机器学习笔记3)的主要内容,如果未能解决你的问题,请参考以下文章