读《数学之美》有感

Posted snowlxy

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了读《数学之美》有感相关的知识,希望对你有一定的参考价值。

刚开始老师让我们看《数学之美》这本书我是表示很不理解的,因为我想又不是语文课,为什么要写读后感,又不是数学课为什么要看数学之美,但是看了之后,我才发现这本书真的很有用。

其实我还没有读几章节,但是前面讲统计语言模型不仅引起了我很大的兴趣,而且给了我很大的启发。书中提到,如果想知道一个S序列在文中出现的概率,就是将该序列中每个词出现的概率相乘,如P(S)=P(w1)P(w2|w1)P(w3|w1 w2)......P(wn | w1 w2.....wn-1),其中P(w2 | w1)是在已知第一个词出现的情况下,第二个词出现的概率。但是如果要推算一个词出现的概率,要与前面n-1个词都有关,计算量过于庞大且计算难度高因此,有了马尔可夫假设,即任意一个词wi出现的概率只同它在前面的词wi-1有关。公式也简化如下:P(S)=P(w1)P(w2 |w1)P(w3 | w2).....P(wi |wi-1) 。

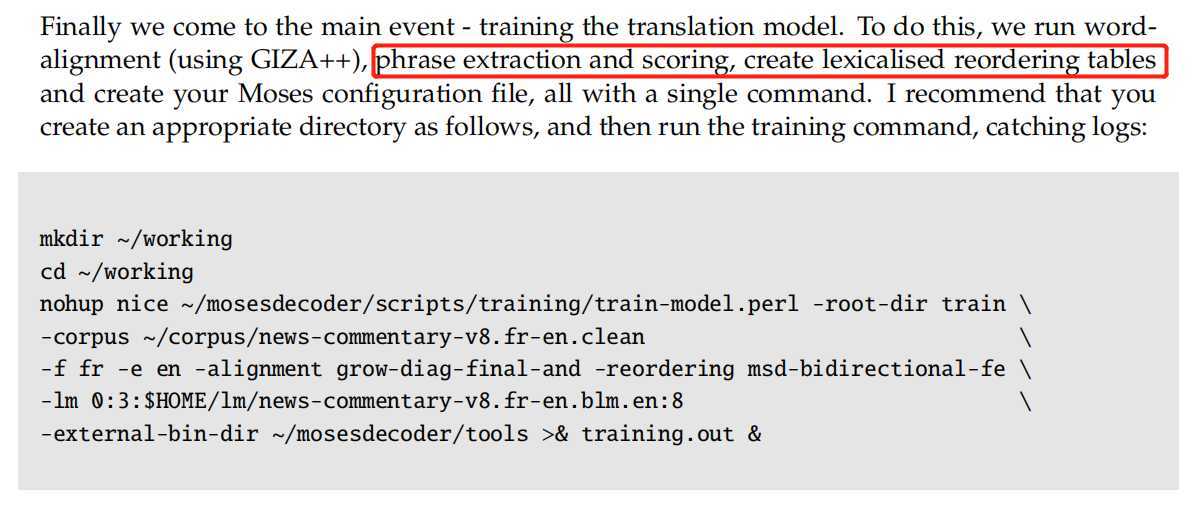

这让我联想到了我大一在实验室装的Moses基于统计的机器翻译系统,在每个机器翻译系统装完后,我们都需要测试BLEU值。BLEU值是用来判断两个句子的相似程度的,举一个简单的栗子:两个句子S1=I learn C++;S2:I learn Java;这两个句子的相似度就是2/3,分子是一个候选翻译的单词有多少出现在参考翻译中(不管是不是在同一句参考翻译中),分母是这个候选翻译的词汇数。为什么说不管是不是在同一句参考翻译中,这是因为BLEU是将一句机器翻译的话语相对应的几个参考翻译作比较,算出一个综合分数,因此不是与一句话相比较,而是与多句参考翻译相比较。为了避免常用词干扰,我们还用了改进的多元精度比较句中某词在每个参考翻译中出现的次数,在将比较得到的结果去最大的,得到最后的BLEU。

除此之外还利用了统计模型解决了中文的分词二义性问题,利用统计语言模型算出每种分词后的句子出现的概率,找出其中概率最大的就是最好的分词方法。这又让我联想到了,Moses的安装在Corpus Preparation的过程中。

而在语料的预处理过程中,需要先将中文语料进行分词,便于之后利用GIZA++对平行语料进行对齐。

而在语料的预处理过程中,需要先将中文语料进行分词,便于之后利用GIZA++对平行语料进行对齐。

我相信《数学之美》中提到的统计语言模型对统计机器翻译的帮助是很大的。

我相信《数学之美》中提到的统计语言模型对统计机器翻译的帮助是很大的。

慢慢看下去《数学之美》我发现能够学到很多东西,数学和计算机还是分不开的,很多算法,训练模型都与数学有关,之后我还会继续看《数学之美》,相信我会有更深的体会。

以上是关于读《数学之美》有感的主要内容,如果未能解决你的问题,请参考以下文章