03.Scala编程实战 Posted 2022-08-13 mediocreworld

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了03.Scala编程实战相关的知识,希望对你有一定的参考价值。

Scala编程实战

1. 课程目标

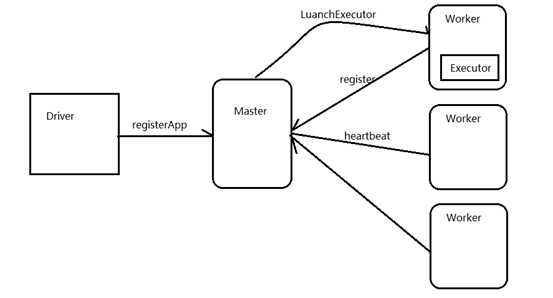

1.1. 目标:使用Akka实现一个简易版的spark通信框架

2. 项目概述

2.1. 需求

Hivesql----------> select count(*) from user----->整个表只有1条数据

Map 0% reduce 0%

Map 10% reduce 0%

Map 20% reduce 0%

目前大多数的分布式架构底层通信都是通过RPC实现的,RPC框架非常多,比如前我们学过的Hadoop项目的RPC通信框架,但是Hadoop在设计之初就是为了运行长达数小时的批量而设计的,在某些极端的情况下,任务提交的延迟很高,所以Hadoop的RPC显得有些笨重。

Spark 的RPC是通过Akka类库实现的,Akka用Scala语言开发,基于Actor并发模型实现,Akka具有高可靠、高性能、可扩展等特点,使用Akka可以轻松实现分布式RPC功能。

2.2. Akka简介

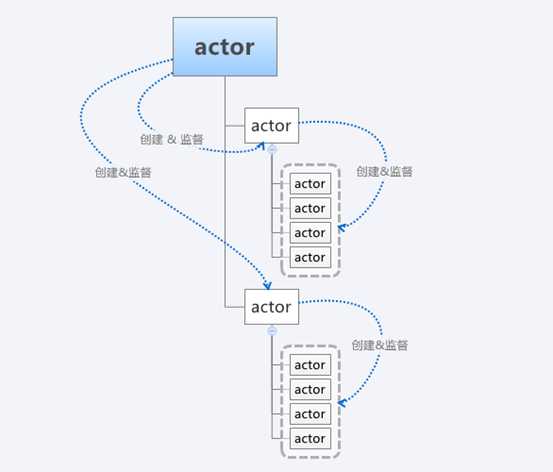

Akka基于Actor模型,提供了一个用于构建可扩展的(Scalable)、弹性的(Resilient)、快速响应的(Responsive)应用程序的平台。

Actor模型:在计算机科学领域,Actor模型是一个并行计算(Concurrent Computation)模型,它把actor作为并行计算的基本元素来对待:为响应一个接收到的消息,一个actor能够自己做出一些决策,如创建更多的actor,或发送更多的消息,或者确定如何去响应接收到的下一个消息。

Actor是Akka中最核心的概念,它是一个封装了状态和行为的对象,Actor之间可以通过交换消息的方式进行通信,每个Actor都有自己的收件箱(Mailbox)。通过Actor能够简化锁及线程管理,可以非常容易地开发出正确地并发程序和并行系统,Actor具有如下特性:

(1)、提供了一种高级抽象,能够简化在并发(Concurrency)/并行(Parallelism)应用场景下的编程开发

(2)、提供了异步非阻塞的、高性能的事件驱动编程模型

(3)、超级轻量级事件处理(每GB堆内存几百万Actor)

3. 项目实现

3.1. 实战一:

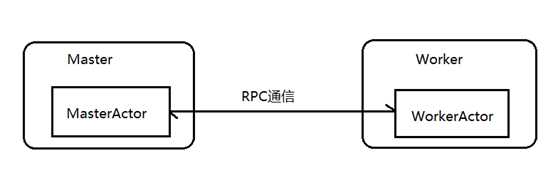

利用 Akka 的 actor 编程模型,实现 2 个进程间的通信。

3.1.1. 架构图

3.1.2. 重要类介绍

ActorSystem : 在Akka中,ActorSystem是一个重量级的结构,他需要分配多个线程,所以在实际应用中,ActorSystem通常是一个单例对象,我们可以使用这个ActorSystem创建很多Actor。

注意:

(1)、ActorSystem是一个进程中的老大,它负责创建和监督actor

(2)、ActorSystem是一个单例对象

(3)、actor负责通信

3.1.3. Actor

在Akka中,Actor负责通信,在Actor中有一些重要的生命周期方法。

(1)preStart() 方法:该方法在Actor对象构造方法执行后执行,整个Actor生命周期中仅执行一次。

(2)receive() 方法:该方法在Actor的preStart方法执行完成后执行,用于接收消息,会被反复执行。

3.1.4. 具体代码

① Master 类

package cn.itcast.rpcimport akka.actor.Actor, ActorRef, ActorSystem, Propsimport com.typesafe.config.ConfigFactorytodo: 利用akka的actor模型实现2个进程间的通信-----Master端 class Master extends Actorprintln ("master constructor invoked")override def preStart(): Unit = println ("preStart method invoked")override def receive: Receive = case "connect" =>println ("a client connected")object Masterdef main(args: Array[String]): Unit = val host=args(0)val port=args(1)val configStr=$ host"$ port"val config=ConfigFactory.parseString (configStr)val masterActorSystem = ActorSystem ("masterActorSystem",config)val masterActor: ActorRef = masterActorSystem.actorOf(Props (new Master),"masterActor")

② Worker 类

package cn.itcast.rpcimport akka.actor.Actor, ActorRef, ActorSelection, ActorSystem, Propsimport com.typesafe.config.ConfigFactorytodo: 利用akka中的actor实现2个进程间的通信-----Worker端 class Worker extends Actorprintln ("Worker constructor invoked")override def preStart(): Unit = println ("preStart method invoked")val master: ActorSelection = context .actorSelection("akka.tcp://masterActorSystem@172.16.43.63:8888/user/masterActor")override def receive: Receive = case "connect" =>println ("a client connected")case "success" =>println ("注册成功")object Workerdef main(args: Array[String]): Unit = val host=args(0)val port=args(1)val configStr=$ host"$ port"val config=ConfigFactory.parseString (configStr)val workerActorSystem = ActorSystem ("workerActorSystem",config)val workerActor: ActorRef = workerActorSystem.actorOf(Props (new Worker),"workerActor")

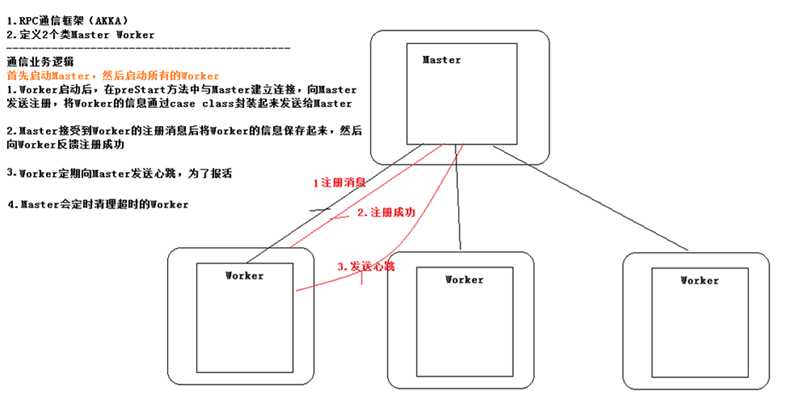

3.2. 实战二

使用 Akka 实现一个简易版的 spark 通信框架

3.2.1. 架构图

3.2.2. 具体代码

① Master 类

package cn.itcast.sparkimport akka.actor.Actor, ActorRef, ActorSystem, Propsimport com.typesafe.config.ConfigFactoryimport scala.collection.mutableimport scala.collection.mutable.ListBufferimport scala.concurrent.duration._todo: 利用akka实现简易版的spark通信框架-----Master端 class Master extends Actorprintln ("master constructor invoked")private val workerMap = new mutable.HashMap[String,WorkerInfo]()private val workerList = new ListBuffer[WorkerInfo]val CHECK_OUT_TIME_INTERVAL =15000 //15秒override def preStart(): Unit = println ("preStart method invoked")import context .dispatchercontext .system.scheduler.schedule(0 millis,CHECK_OUT_TIME_INTERVAL millis,self ,CheckOutTime)override def receive: Receive = case RegisterMessage (workerId,memory,cores) =>if (!workerMap .contains(workerId))val workerInfo = new WorkerInfo(workerId,memory,cores)workerMap .put(workerId,workerInfo)workerList +=workerInfoRegisteredMessage (s"workerId:$ workerId 注册成功")case SendHeartBeat (workerId)=>if (workerMap .contains(workerId))val workerInfo: WorkerInfo = workerMap (workerId)val lastTime: Long = System.currentTimeMillis ()lastHeartBeatTime =lastTimecase CheckOutTime=>val outTimeWorkers: ListBuffer[WorkerInfo] = workerList .filter(x => System.currentTimeMillis () -x.lastHeartBeatTime > CHECK_OUT_TIME_INTERVAL )for (workerInfo <- outTimeWorkers)val workerId: String = workerInfo.workerIdworkerMap .remove(workerId)workerList -= workerInfoprintln ("超时的workerId:" +workerId)println ("活着的worker总数:" + workerList .size)println (workerList .sortBy(x => x.memory).reverse.toList)object Masterdef main(args: Array[String]): Unit = val host=args(0)val port=args(1)val configStr=$ host"$ port"val config=ConfigFactory.parseString (configStr)val masterActorSystem = ActorSystem ("masterActorSystem",config)val masterActor: ActorRef = masterActorSystem.actorOf(Props (new Master),"masterActor")

② Worker 类

package cn.itcast.sparkimport java.util.UUIDimport akka.actor.Actor, ActorRef, ActorSelection, ActorSystem, Propsimport com.typesafe.config.ConfigFactoryimport scala.concurrent.duration._todo: 利用akka实现简易版的spark通信框架-----Worker端 class Worker(val memory:Int,val cores:Int,val masterHost:String,val masterPort:String) extends Actorprintln ("Worker constructor invoked")private val workerId : String = UUID.randomUUID ().toStringval SEND_HEART_HEAT_INTERVAL =10000 //10秒var master : ActorSelection=_override def preStart(): Unit = println ("preStart method invoked")master = context .actorSelection(s"akka.tcp://masterActorSystem@$ masterHost:$ masterPort/user/masterActor")master ! RegisterMessage (workerId ,memory,cores)override def receive: Receive = case RegisteredMessage (message) =>println (message)import context .dispatchercontext .system.scheduler.schedule(0 millis,SEND_HEART_HEAT_INTERVAL millis,self ,HeartBeat)case HeartBeat =>master ! SendHeartBeat (workerId )object Workerdef main(args: Array[String]): Unit = val host=args(0)val port=args(1)val memory=args(2).toIntval cores=args(3).toIntval masterHost=args(4)val masterPort=args(5)val configStr=$ host"$ port"val config=ConfigFactory.parseString (configStr)val workerActorSystem = ActorSystem ("workerActorSystem",config)val workerActor: ActorRef = workerActorSystem.actorOf(Props (new Worker(memory,cores,masterHost,masterPort)),"workerActor")

③ WorkerInfo 类

package cn.itcast.sparkclass WorkerInfo(val workerId:String,val memory:Int,val cores:Int) var lastHeartBeatTime :Long=_override def toString: String = $ workerId , memory:$ memory , cores:$ cores"

④ 样例类

package cn.itcast.sparktrait RemoteMessage extends Serializablecase class RegisterMessage(val workerId:String,val memory:Int,val cores:Int) extends RemoteMessagecase class RegisteredMessage(message:String) extends RemoteMessagecase object HeartBeatcase class SendHeartBeat(val workerId:String) extends RemoteMessagecase object CheckOutTime

以上是关于03.Scala编程实战的主要内容,如果未能解决你的问题,请参考以下文章

Shell脚本编程实战

Java并发编程实战 04死锁了怎么办?

Java并发编程实战 04死锁了怎么办?

树莓派Python编程入门与实战 PDF

SHELL编程开发实战Apache虚拟主机

gconf/dconf实战编程利用dconf库读写配置实战以及诸多配套工具演示