hibernate之二级缓存

Posted ztbk

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了hibernate之二级缓存相关的知识,希望对你有一定的参考价值。

1. 为什么需要缓存

拉高程序的性能

关系型数据库:数据与数据之间存在关系(联系)的数据库 mysql/Oracle、sqlserver

非关系型数据库:数据与数据之间是不存在关系的,key-value

1、基于文件存储的数据库:ehcache

2、基于内存存储的数据库:redis、memcache

3、基于文档存储的数据库:mongodb

2. 什么样的数据需要缓存

很少被修改或根本不改的数据 数据字典

业务场景比如:耗时较高的统计分析sql、电话账单查询sql等

3. ehcache是什么

Ehcache 是现在最流行的纯Java开源缓存框架,配置简单、结构清晰、功能强大

注1:本章介绍的是2.X版本,3.x的版本和2.x的版本API差异比较大

4. ehcache的特点

4.1 够快

Ehcache的发行有一段时长了,经过几年的努力和不计其数的性能测试,Ehcache终被设计于large, high concurrency systems.

4.2 够简单

开发者提供的接口非常简单明了,从Ehcache的搭建到运用运行仅仅需要的是你宝贵的几分钟。其实很多开发者都不知道自己用在用Ehcache,Ehcache被广泛的运用于其他的开源项目

4.3 够袖珍

关于这点的特性,官方给了一个很可爱的名字small foot print ,一般Ehcache的发布版本不会到2M,V 2.2.3 才 668KB。

4.4 够轻量

核心程序仅仅依赖slf4j这一个包,没有之一!

4.5 好扩展

Ehcache提供了对大数据的内存和硬盘的存储,最近版本允许多实例、保存对象高灵活性、提供LRU、LFU、FIFO淘汰算法,基础属性支持热配置、支持的插件多

4.6 监听器

缓存管理器监听器 (CacheManagerListener)和 缓存监听器(CacheEvenListener),做一些统计或数据一致性广播挺好用的

4.7 分布式缓存

从Ehcache 1.2开始,支持高性能的分布式缓存,兼具灵活性和扩展性

先配置pom.xml

<project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance" xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/maven-v4_0_0.xsd"> <modelVersion>4.0.0</modelVersion> <groupId>com.jt</groupId> <artifactId>hibernate1</artifactId> <packaging>war</packaging> <version>0.0.1-SNAPSHOT</version> <name>hibernate1 Maven Webapp</name> <url>http://maven.apache.org</url> <properties> <project.build.sourceEncoding>UTF-8</project.build.sourceEncoding> <maven.compiler.source>1.8</maven.compiler.source> <maven.compiler.target>1.8</maven.compiler.target> <junit.version>4.12</junit.version> <servlet.version>4.0.0</servlet.version> <hibernate.version>5.2.12.Final</hibernate.version> <mysql.driver.version>5.1.46</mysql.driver.version> <ehcache.version>2.10.0</ehcache.version> <slf4j-api.version>1.7.7</slf4j-api.version> <log4j-api.version>2.9.1</log4j-api.version> </properties> <dependencies> <dependency> <groupId>junit</groupId> <artifactId>junit</artifactId> <version>$junit.version</version> <scope>test</scope> </dependency> <dependency> <groupId>javax.servlet</groupId> <artifactId>javax.servlet-api</artifactId> <version>$servlet.version</version> <scope>provided</scope> </dependency> <dependency> <groupId>org.hibernate</groupId> <artifactId>hibernate-core</artifactId> <version>$hibernate.version</version> </dependency> <dependency> <groupId>mysql</groupId> <artifactId>mysql-connector-java</artifactId> <version>$mysql.driver.version</version> </dependency> <dependency> <groupId>net.sf.ehcache</groupId> <artifactId>ehcache</artifactId> <version>$ehcache.version</version> </dependency> <dependency> <groupId>org.hibernate</groupId> <artifactId>hibernate-ehcache</artifactId> <version>$hibernate.version</version> </dependency> <!-- slf4j核心包 --> <dependency> <groupId>org.slf4j</groupId> <artifactId>slf4j-api</artifactId> <version>$slf4j-api.version</version> </dependency> <dependency> <groupId>org.slf4j</groupId> <artifactId>jcl-over-slf4j</artifactId> <version>$slf4j-api.version</version> <scope>runtime</scope> </dependency> <!--用于与slf4j保持桥接 --> <dependency> <groupId>org.apache.logging.log4j</groupId> <artifactId>log4j-slf4j-impl</artifactId> <version>$log4j-api.version</version> </dependency> <!--核心log4j2jar包 --> <dependency> <groupId>org.apache.logging.log4j</groupId> <artifactId>log4j-api</artifactId> <version>$log4j-api.version</version> </dependency> <dependency> <groupId>org.apache.logging.log4j</groupId> <artifactId>log4j-core</artifactId> <version>$log4j-api.version</version> </dependency> </dependencies> <build> <finalName>hibernate1</finalName> <plugins> <plugin> <groupId>org.apache.maven.plugins</groupId> <artifactId>maven-compiler-plugin</artifactId> <version>3.7.0</version> <configuration> <source>$maven.compiler.source</source> <target>$maven.compiler.target</target> <encoding>$project.build.sourceEncoding</encoding> </configuration> </plugin> </plugins> </build> </project>

导入工具类EhcacheUtil.java

package com.jt6.util; import net.sf.ehcache.Cache; import net.sf.ehcache.CacheManager; import net.sf.ehcache.Element; import java.io.InputStream; public class EhcacheUtil private static CacheManager cacheManager; static try InputStream is = EhcacheUtil.class.getResourceAsStream("/ehcache.xml"); cacheManager = CacheManager.create(is); catch (Exception e) throw new RuntimeException(e); private EhcacheUtil() public static void put(String cacheName, Object key, Object value) Cache cache = cacheManager.getCache(cacheName); if (null == cache) //以默认配置添加一个名叫cacheName的Cache cacheManager.addCache(cacheName); cache = cacheManager.getCache(cacheName); cache.put(new Element(key, value)); public static Object get(String cacheName, Object key) Cache cache = cacheManager.getCache(cacheName); Element element = cache.get(key); return null == element ? null : element.getValue(); public static void remove(String cacheName, Object key) Cache cache = cacheManager.getCache(cacheName); cache.remove(key);

log4j2.xml

<?xml version="1.0" encoding="UTF-8"?> <!-- status : 指定log4j本身的打印日志的级别.ALL< Trace < DEBUG < INFO < WARN < ERROR < FATAL < OFF。 monitorInterval : 用于指定log4j自动重新配置的监测间隔时间,单位是s,最小是5s. --> <Configuration status="WARN" monitorInterval="30"> <Properties> <!-- 配置日志文件输出目录 $sys:user.home --> <Property name="LOG_HOME">/root/workspace/lucenedemo/logs</Property> <property name="ERROR_LOG_FILE_NAME">/root/workspace/lucenedemo/logs/error</property> <property name="WARN_LOG_FILE_NAME">/root/workspace/lucenedemo/logs/warn</property> <property name="PATTERN">%dyyyy-MM-dd HH:mm:ss.SSS [%t-%L] %-5level %logger36 - %msg%n</property> </Properties> <Appenders> <!--这个输出控制台的配置 --> <Console name="Console" target="SYSTEM_OUT"> <!-- 控制台只输出level及以上级别的信息(onMatch),其他的直接拒绝(onMismatch) --> <ThresholdFilter level="trace" onMatch="ACCEPT" onMismatch="DENY" /> <!-- 输出日志的格式 --> <!-- %dyyyy-MM-dd HH:mm:ss, SSS : 日志生产时间 %p : 日志输出格式 %c : logger的名称 %m : 日志内容,即 logger.info("message") %n : 换行符 %C : Java类名 %L : 日志输出所在行数 %M : 日志输出所在方法名 hostName : 本地机器名 hostAddress : 本地ip地址 --> <PatternLayout pattern="$PATTERN" /> </Console> <!--文件会打印出所有信息,这个log每次运行程序会自动清空,由append属性决定,这个也挺有用的,适合临时测试用 --> <!--append为TRUE表示消息增加到指定文件中,false表示消息覆盖指定的文件内容,默认值是true --> <File name="log" fileName="logs/test.log" append="false"> <PatternLayout pattern="%dyyyy-MM-dd HH:mm:ss.SSS [%t] %-5level %logger36 - %msg%n" /> </File> <!-- 这个会打印出所有的info及以下级别的信息,每次大小超过size, 则这size大小的日志会自动存入按年份-月份建立的文件夹下面并进行压缩,作为存档 --> <RollingFile name="RollingFileInfo" fileName="$LOG_HOME/info.log" filePattern="$LOG_HOME/$$date:yyyy-MM/info-%dyyyy-MM-dd-%i.log"> <!--控制台只输出level及以上级别的信息(onMatch),其他的直接拒绝(onMismatch) --> <ThresholdFilter level="info" onMatch="ACCEPT" onMismatch="DENY" /> <PatternLayout pattern="%dyyyy-MM-dd HH:mm:ss.SSS [%t] %-5level %logger36 - %msg%n" /> <Policies> <!-- 基于时间的滚动策略,interval属性用来指定多久滚动一次,默认是1 hour。 modulate=true用来调整时间:比如现在是早上3am,interval是4,那么第一次滚动是在4am,接着是8am,12am...而不是7am. --> <!-- 关键点在于 filePattern后的日期格式,以及TimeBasedTriggeringPolicy的interval, 日期格式精确到哪一位,interval也精确到哪一个单位 --> <!-- log4j2的按天分日志文件 : info-%dyyyy-MM-dd-%i.log --> <TimeBasedTriggeringPolicy interval="1" modulate="true" /> <!-- SizeBasedTriggeringPolicy:Policies子节点, 基于指定文件大小的滚动策略,size属性用来定义每个日志文件的大小. --> <!-- <SizeBasedTriggeringPolicy size="2 kB" /> --> </Policies> </RollingFile> <RollingFile name="RollingFileWarn" fileName="$WARN_LOG_FILE_NAME/warn.log" filePattern="$WARN_LOG_FILE_NAME/$$date:yyyy-MM/warn-%dyyyy-MM-dd-%i.log"> <ThresholdFilter level="warn" onMatch="ACCEPT" onMismatch="DENY" /> <PatternLayout pattern="%dyyyy-MM-dd HH:mm:ss.SSS [%t] %-5level %logger36 - %msg%n" /> <Policies> <TimeBasedTriggeringPolicy /> <SizeBasedTriggeringPolicy size="2 kB" /> </Policies> <!-- DefaultRolloverStrategy属性如不设置,则默认为最多同一文件夹下7个文件,这里设置了20 --> <DefaultRolloverStrategy max="20" /> </RollingFile> <RollingFile name="RollingFileError" fileName="$ERROR_LOG_FILE_NAME/error.log" filePattern="$ERROR_LOG_FILE_NAME/$$date:yyyy-MM/error-%dyyyy-MM-dd-HH-mm-%i.log"> <ThresholdFilter level="error" onMatch="ACCEPT" onMismatch="DENY" /> <PatternLayout pattern="%dyyyy-MM-dd HH:mm:ss.SSS [%t] %-5level %logger36 - %msg%n" /> <Policies> <!-- log4j2的按分钟 分日志文件 : warn-%dyyyy-MM-dd-HH-mm-%i.log --> <TimeBasedTriggeringPolicy interval="1" modulate="true" /> <!-- <SizeBasedTriggeringPolicy size="10 MB" /> --> </Policies> </RollingFile> </Appenders> <!--然后定义logger,只有定义了logger并引入的appender,appender才会生效 --> <Loggers> <!--过滤掉spring和mybatis的一些无用的DEBUG信息 --> <logger name="org.springframework" level="INFO"></logger> <logger name="org.mybatis" level="INFO"></logger> <!-- 第三方日志系统 --> <logger name="org.springframework" level="ERROR" /> <logger name="org.hibernate" level="ERROR" /> <logger name="org.apache.struts2" level="ERROR" /> <logger name="com.opensymphony.xwork2" level="ERROR" /> <logger name="org.jboss" level="ERROR" /> <!-- 配置日志的根节点 --> <root level="all"> <appender-ref ref="Console" /> <appender-ref ref="RollingFileInfo" /> <appender-ref ref="RollingFileWarn" /> <appender-ref ref="RollingFileError" /> </root> </Loggers> </Configuration>

ehcache.xml

<?xml version="1.0" encoding="UTF-8"?> <ehcache xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance" xsi:noNamespaceSchemaLocation="http://ehcache.org/ehcache.xsd" updateCheck="false"> <!--磁盘存储:将缓存中暂时不使用的对象,转移到硬盘,类似于Windows系统的虚拟内存--> <!--path:指定在硬盘上存储对象的路径--> <!--java.io.tmpdir 是默认的临时文件路径。 可以通过如下方式打印出具体的文件路径 System.out.println(System.getProperty("java.io.tmpdir"));--> <diskStore path="D://xxx"/> <!--defaultCache:默认的管理策略--> <!--eternal:设定缓存的elements是否永远不过期。如果为true,则缓存的数据始终有效,如果为false那么还要根据timeToIdleSeconds,timeToLiveSeconds判断--> <!--maxElementsInMemory:在内存中缓存的element的最大数目--> <!--overflowToDisk:如果内存中数据超过内存限制,是否要缓存到磁盘上--> <!--diskPersistent:是否在磁盘上持久化。指重启jvm后,数据是否有效。默认为false--> <!--timeToIdleSeconds:对象空闲时间(单位:秒),指对象在多长时间没有被访问就会失效。只对eternal为false的有效。默认值0,表示一直可以访问--> <!--timeToLiveSeconds:对象存活时间(单位:秒),指对象从创建到失效所需要的时间。只对eternal为false的有效。默认值0,表示一直可以访问--> <!--memoryStoreEvictionPolicy:缓存的3 种清空策略--> <!--FIFO:first in first out (先进先出)--> <!--LFU:Less Frequently Used (最少使用).意思是一直以来最少被使用的。缓存的元素有一个hit 属性,hit 值最小的将会被清出缓存--> <!--LRU:Least Recently Used(最近最少使用). (ehcache 默认值).缓存的元素有一个时间戳,当缓存容量满了,而又需要腾出地方来缓存新的元素的时候,那么现有缓存元素中时间戳离当前时间最远的元素将被清出缓存--> <defaultCache eternal="false" maxElementsInMemory="1000" overflowToDisk="true" diskPersistent="false" timeToIdleSeconds="600" timeToLiveSeconds="900" memoryStoreEvictionPolicy="LRU"/> <!--name: Cache的名称,必须是唯一的(ehcache会把这个cache放到HashMap里)--> <cache name="com.jt.entity.User" eternal="false" maxElementsInMemory="100" overflowToDisk="false" diskPersistent="false" timeToIdleSeconds="0" timeToLiveSeconds="300" memoryStoreEvictionPolicy="LRU"/> </ehcache>

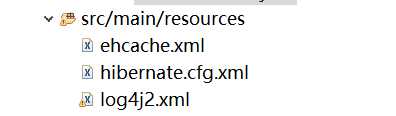

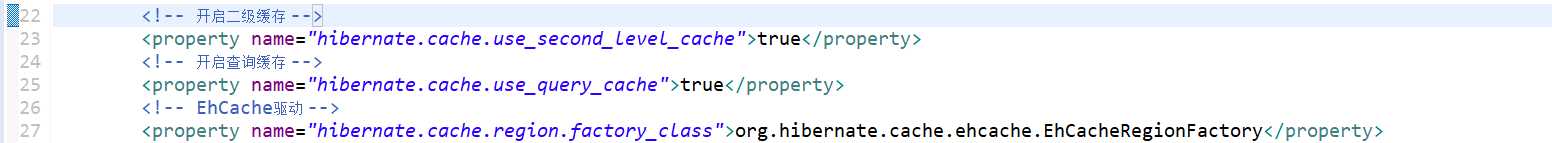

在hibernate.cfg.xml中配置一下

在user.hbm.xml的class标签下面添加:

<cache usage="read-write" region="com.zl.entity.User"/>`

测试类EhcacheDemo1.java

package com.jt6.test; import java.util.HashMap; import java.util.Map; /** * 利用map集合简易实现缓存原理 * @author Administrator * */ public class EhcacheDemo1 static Map<String, Object> cache = new HashMap<String, Object>(); static Object getValue(String key) Object value = cache.get(key); System.out.println("从内存中读取数据"); if(value == null) System.out.println("从数据库中读取数据"); cache.put(key, new String[] "zs"); return cache.get(key); return value; public static void main(String[] args) System.out.println(getValue("sname")); System.out.println(getValue("sname")); //从内存忠读取数据 //从数据库中读取数据 //zs //从内存中读取数据 //zs

EhcacheDemo2.java

package com.jt6.test; import com.jt6.util.EhcacheUtil; /** * 演示利用缓存存储数据 * @author Administrator * */ public class EhcacheDemo2 public static void main(String[] args) System.out.println(System.getProperty("java.io.tmpdir")); EhcacheUtil.put("com.jt.entity.User", 11, "zhangsan"); System.out.println(EhcacheUtil.get("com.jt.entity.User", 11));

EhcacheDemo3.java

package com.jt6.test; import org.hibernate.Session; import org.hibernate.Transaction; import com.jt.entity.User; import com.jt2.util.SessionFactoryUtils; /** * 演示查单个用户使用了缓存 * @author Administrator * */ public class EhcacheDemo3 /** * 默认情况下,sql语句形成了三次,这里为了提高性能,必须使用二级缓存SessionFactory缓存 * <!-- 开启二级缓存 --> * <property name="hibernate.cache.use_second_level_cache">true</property> <!-- 开启查询缓存 --> <property name="hibernate.cache.use_query_cache">true</property> <!-- EhCache驱动 --> <property name="hibernate.cache.region.factory_class">org.hibernate.cache.ehcache.EhCacheRegionFactory</property> 映射文件中添加标签 <cache usage="read-write" region="com.javaxl.one.entity.User"/> 这里的region指的是Ehcache.xml中cacheName * @param args */ public static void main(String[] args) // UserDao userDao = new UserDao(); // User u = new User(); // u.setId(7); // User user = userDao.get(u); // System.out.println(user); // User user2 = userDao.get(u); // System.out.println(user2); // User user3 = userDao.get(u); // System.out.println(user3); /** * 同一个session,sql语句只生成一次,这里用到了一级缓存 */ public static void test1() Session session = SessionFactoryUtils.openSession(); Transaction transaction = session.beginTransaction(); User user = session.get(User.class, 7); System.out.println(user); User user2 = session.get(User.class, 7); System.out.println(user2); User user3 = session.get(User.class, 7); System.out.println(user3); transaction.commit(); session.close();

EhcacheDemo4.java

package com.jt6.test; import java.util.List; import org.hibernate.Session; import org.hibernate.Transaction; import org.hibernate.query.Query; import com.jt2.util.SessionFactoryUtils; /** * hibernate二级缓存不会同时缓存多条数据 * @author Administrator * */ public class EhcacheDemo4 public static void main(String[] args) Session session = SessionFactoryUtils.openSession(); Transaction transaction = session.beginTransaction(); Query query = session.createQuery("from User"); query.setCacheable(true); List list = query.list(); System.out.println(list); List list2 = query.list(); System.out.println(list2); List list3 = query.list(); System.out.println(list3); transaction.commit(); session.close();

今天就到这里了

以上是关于hibernate之二级缓存的主要内容,如果未能解决你的问题,请参考以下文章