一文读懂多元回归分析

Posted little-li

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了一文读懂多元回归分析相关的知识,希望对你有一定的参考价值。

一、多元回归分析简介

用回归方程定量地刻画一个应变量与多个自变量间的线性依存关系,称为多元回归分析(multiple linear regression),简称多元回归(multiple regression)。

多元回归分析是多变量分析的基础,也是理解监督类分析方法的入口!实际上大部分学习统计分析和市场研究的人的都会用回归分析,操作也是比较简单的,但能够知道多元回归分析的适用条件或是如何将回归应用于实践,可能还要真正领会回归分析的基本思想和一些实际应用手法!

回归分析的基本思想是:虽然自变量和因变量之间没有严格的、确定性的函数关系,但可以设法找出最能代表它们之间关系的数学表达形式。

二、多元回归线性分析的运用

具体地说,多元线性回归分析主要解决以下几方面的问题。

(1)确定几个特定的变量之间是否存在相关关系,如果存在的话,找出它们之间合适的数学表达式;

(2)根据一个或几个变量的值,预测或控制另一个变量的取值,并且可以知道这种预测或控制能达到什么样的精确度;

(3)进行因素分析。例如在对于共同影响一个变量的许多变量(因素)之间,找出哪些是重要因素,哪些是次要因素,这些因素之间又有什么关系等等。

在运用多元线性回归时主要需要注意以下几点:

首先,多元回归分析应该强调是多元线性回归分析!强调线性是因为大部分人用回归都是线性回归,线性的就是直线的,直线的就是简单的,简单的就是因果成比例的;理论上讲,非线性的关系我们都可以通过函数变化线性化,就比如:Y=a+bLnX,我们可以令 t=LnX,方程就变成了 Y=a+bt,也就线性化了。

第二,线性回归思想包含在其它多变量分析中,例如:判别分析的自变量实际上是回归,尤其是Fisher线性回归方程;Logistics回归的自变量也是回归,只不过是计算线性回归方程的得分进行了概率转换;甚至因子分析和主成分分析最终的因子得分或主成分得分也是回归算出来的;当然,还有很多分析最终也是回归思想!

第三:什么是“回归”,回归就是向平均靠拢。

第四:如果你用线性回归方式去解释过去,你只能朝着一个趋势继续,但未来对过去的偏离有无数种可能性;

第五:线性回归方程纳入的自变量越多,越应该能够反应现实,但解释起来就越困难;

第六:统计学家往往追求的是简约的模型和更高的解释度,往往关注模型R平方,共线性和回归诊断问题;

第七:市场研究人员往往注重模型的解释合理性,是否与预设的直觉一直,是否支持了我的市场假设等;

多元线性回归分析的主要目的是:解释和预测

三、多元回归模型的建立

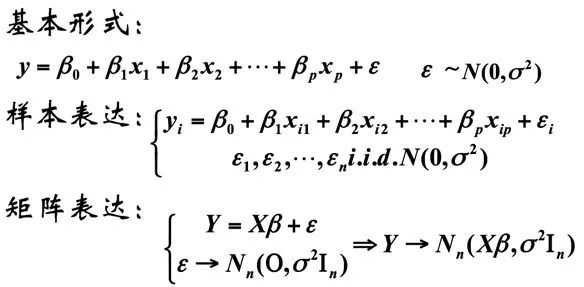

模型的表达形式如下:

在此征用一个网络上的例子来做详细讲解:

假设我们收集了100个企业客户经理对我产品的总体满意度和分项指标的满意度评价,我期望知道,什么分项指标对我总体满意度有重要影响,它的改进更能够提升总体满意度;如果建立预测模型,我期望知道了分项指标的评价就能够预测总体满意度数值;

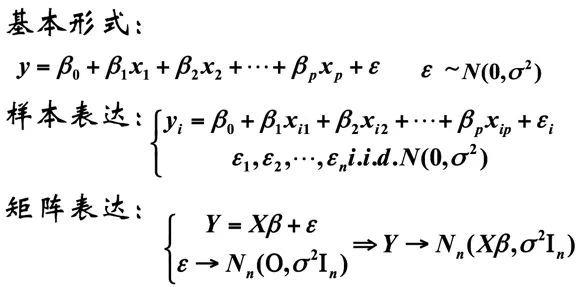

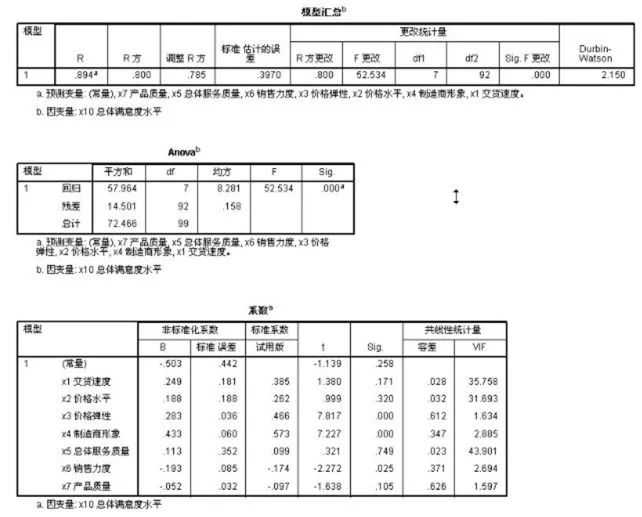

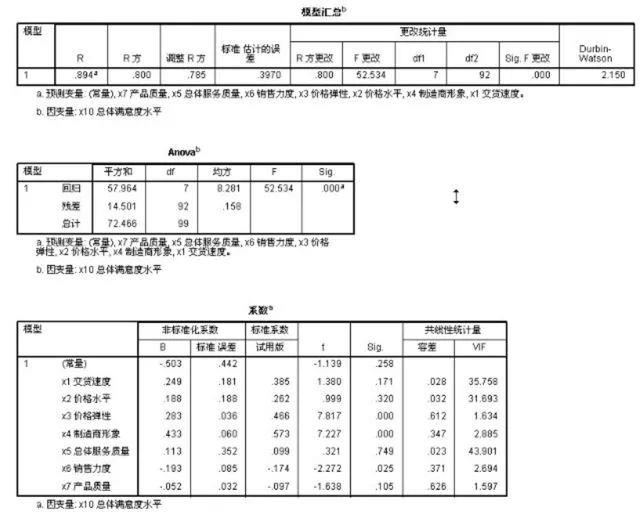

在SPSS中选择回归分析后,把X10作为因变量,X1到X7作为自变量,选择相应的统计参数和输出结果:

R平方是我们最需要关注的,该值说明了方程的拟合好坏,R平方=0.80非常不错了,说明:1)总体满意度的80%的变差都可以由7个分项指标解释,或者说,7个分项指标可以解释总体满意度80%的变差!2)R平方如果太大,大家不要高兴太早,社会科学很少有那么完美的预测或解释,一定存在了共线性!

方程分析表的显著性表明了回归具有解释力!

线性回归方程给出可预测的计算系数,但是,社会科学很少进行预测,重要的是解释;

这里要注意的是如果自变量的测量尺度是统一的话,我们可以直接比较系数的大小,但是如果自变量的测量尺度不统一的话,我们必须看标准化回归系数,标准化回归系数去掉的量纲,且反应了重要性!我们就是需要重要性测量!

当然,这个时候,研究人员应该关注每个指标的回归系数是否真的等于零,要进行假设检验!

四、多元回归模型的显著性检验

上文中有提到,若R平方过大,拟合优度很好的情况下,可能存在多重共线性,而多重共线性便是多元回归模型产生误差的主要原因。

造成多重共线性的原因有一下几种:

1、解释变量都享有共同的时间趋势;

2、一个解释变量是另一个的滞后,二者往往遵循一个趋势;

3、由于数据收集的基础不够宽,某些解释变量可能会一起变动;

4、某些解释变量间存在某种近似的线性关系;

判别:

1、发现系数估计值的符号不对;

2、某些重要的解释变量t值低,而R方不低

3、当一不太重要的解释变量被删除后,回归结果显著变化;

检验:

1、相关性分析,相关系数高于0.8,表明存在多重共线性;但相关系数低,并不能表示不存在多重共线性;

2、vif检验;

3、条件系数检验;

解决方法:

克服主成分分析的统计方式有主成分回归、岭回归、逐步回归,其定义分别为:

主成分回归:主成分分析法作为多元统计分析的一种常用方法在处理多变量问题时具有其一定的优越性,其降维的优势是明显的,主成分回归方法对于一般的多重共线性问题还是适用的,尤其是对共线性较强的变量之间。当采取主成分提取了新的变量后,往往这些变量间的组内差异小而组间差异大,起到了消除共线性的问题。

岭回归:岭回归分析实际上是一种改良的最小二乘法,是一种专门用于共线性数据分析的有偏估计回归方法。岭回归分析的基本思想是当自变量间存在共线性时,解释变量的相关矩阵行列式近似为零,X‘X是奇异的,也就是说它的行列式的值也接近于零,此时OLS估计将失效。此时可采用岭回归估计。岭回归就是用X‘X+KI代替正规方程中的X‘X,人为地把最小特征根由minli提高到min(li+k),希望这样有助于降低均方误差。

逐步回归:逐步回归(Stepwise Regression)是一种常用的消除多重共线性、选取“最优”回归方程的方法。其做法是将逐个引入自变量,引入的条件是该自变量经F检验是显著的,每引入一个自变量后,对已选入的变量进行逐个检验,如果原来引入的变量由于后面变量的引入而变得不再显著,那么就将其剔除。引入一个变量或从回归方程中剔除一个变量,为逐步回归的一步,每一步都要进行F 检验,以确保每次引入新变量之前回归方程中只包含显著的变量。这个过程反复进行,直到既没有不显著的自变量选入回归方程,也没有显著自变量从回归方程中剔除为止。

处理多重共线性的原则:

1、 多重共线性是普遍存在的,轻微的多重共线性问题可不采取措施;

2、 严重的多重共线性问题,一般可根据经验或通过分析回归结果发现。如影响系数符号,重要的解释变量t值很低。要根据不同情况采取必要措施。

3、 如果模型仅用于预测,则只要拟合程度好,可不处理多重共线性问题,存在多重共线性的模型用于预测时,往往不影响预测结果;

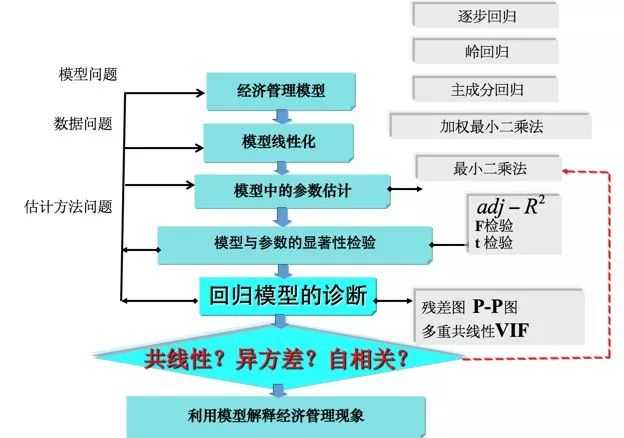

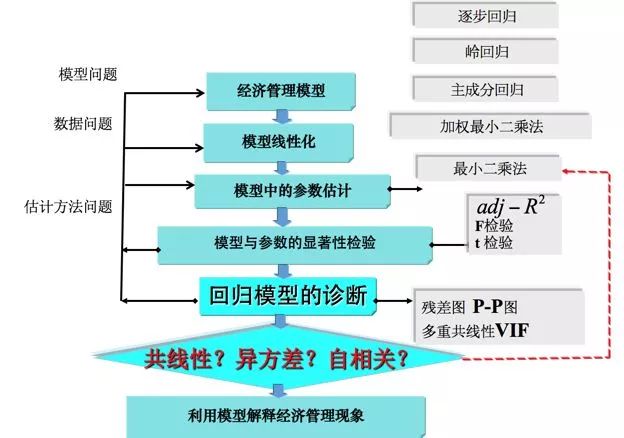

五、总概模型图

以上是关于一文读懂多元回归分析的主要内容,如果未能解决你的问题,请参考以下文章