常用的激活函数

Posted little-horse

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了常用的激活函数相关的知识,希望对你有一定的参考价值。

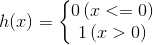

1.阶跃函数

1 def step_function(x): 2 return np.array(x>0,dtype=np.int)

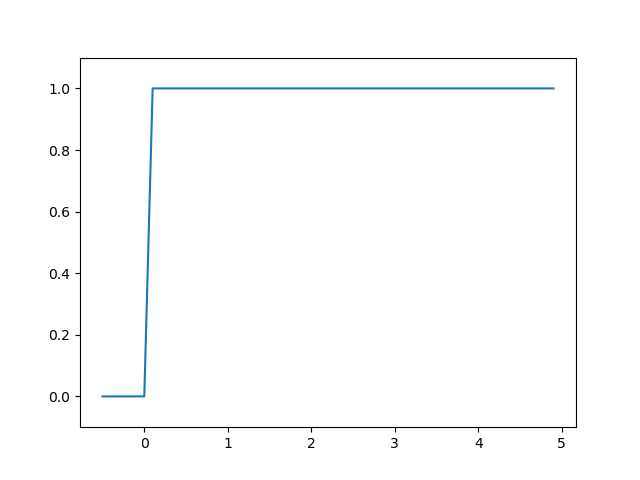

2.sigmoid函数

1 def sigmoid(x): 2 return 1/(1+np.exp(-x))

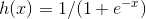

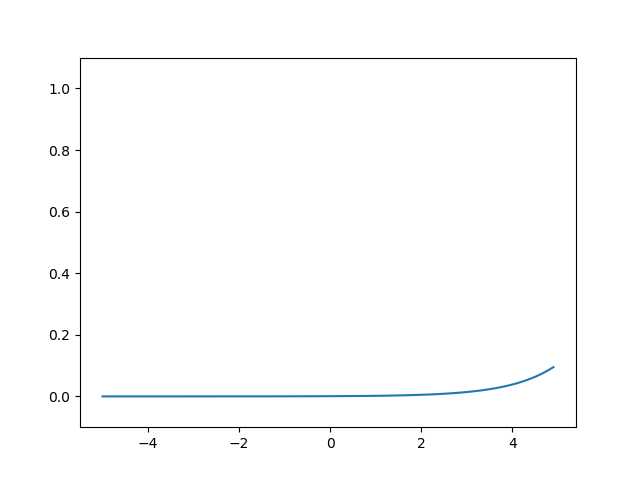

3.relu函数

1 def relu(x): 2 return np.maximum(0,x)

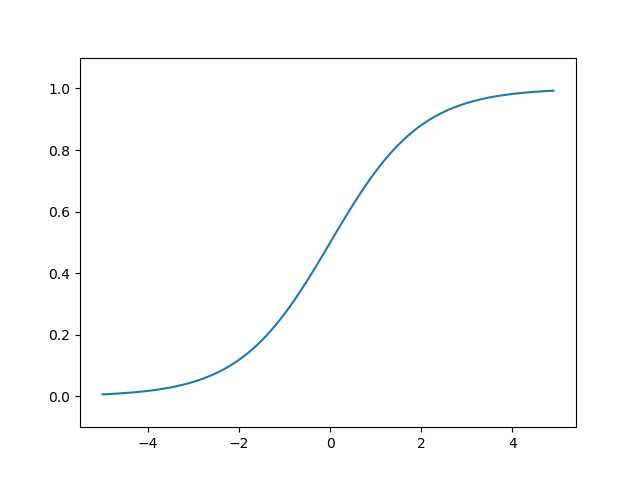

4.softmax

1 def softmax(x): 2 e_a = np.exp(x) 3 sum_e_a = np.sum(e_a) 4 y=e_a/sum_e_a 5 return y 6 #或者,考虑可能出现内存溢出问题,减去一个常数 7 def softmax(x): 8 c=np.max(x) 9 e_a = np.exp(x-c) 10 sum_e_a = np.sum(e_a) 11 y=e_a/sum_e_a 12 return y

以上是关于常用的激活函数的主要内容,如果未能解决你的问题,请参考以下文章