Spark基于Yarn提交任务两种方式

Posted xiangyuguan

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Spark基于Yarn提交任务两种方式相关的知识,希望对你有一定的参考价值。

-

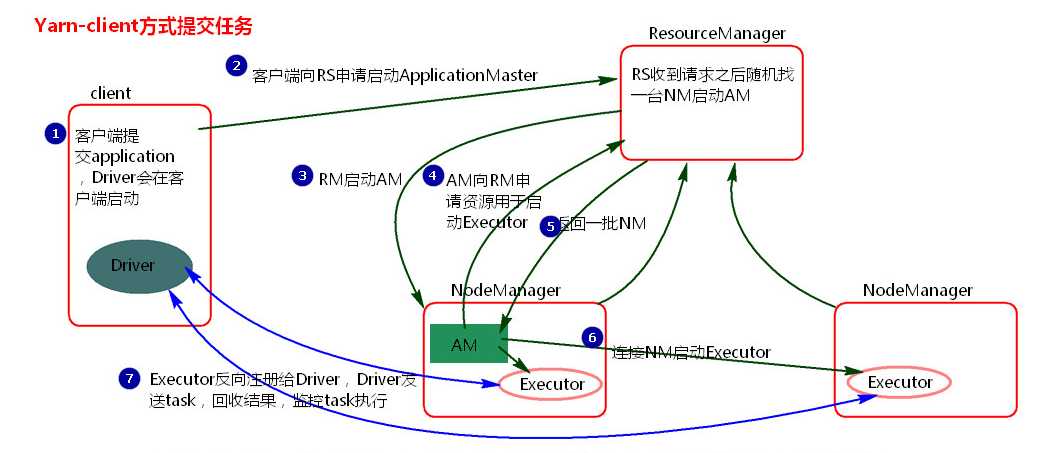

yarn-client提交任务方式

-

客户端提交一个Application,在客户端启动一个Driver进程

-

Driver进程会向RS(ResourceManager)发送请求,启动AM(ApplicationMaster)的资源

-

RS收到请求,随机选择一台NM(NodeManager)启动AM。这里的NM相当于Standalone中的Worker节点

-

AM启动后,会向RS请求一批container资源,用于启动Executor

-

RS会找到一批NM返回给AM,用于启动Executor

-

AM会向NM发送命令启动Executor

-

Executor启动后,会反向注册给Driver,Driver发送task到Executor,执行情况和结果返回给Driver端

-

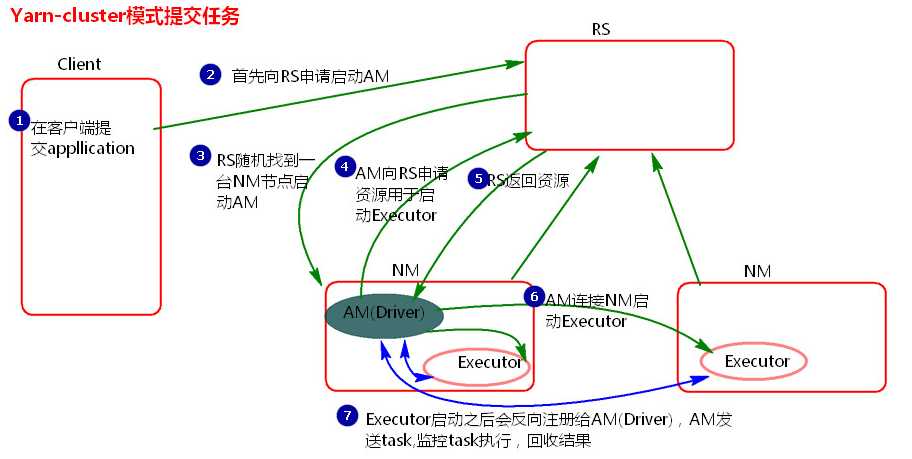

yarn-cluster提交任务方式

-

客户机提交Application应用程序,发送请求到RS(ResourceManager),请求启动AM(ApplicationMaster)

-

RS收到请求后随机在一台NM(NodeManager)上启动AM(相当于Driver端)

-

AM启动,AM发送请求到RS,请求一批container用于启动Executor

-

RS返回一批NM节点给AM

-

AM连接到NM,发送请求到NM启动Executor

-

Executor反向注册到AM所在的节点的Driver。Driver发送task到Executor

以上是关于Spark基于Yarn提交任务两种方式的主要内容,如果未能解决你的问题,请参考以下文章