softmax求导cross-entropy求导及label smoothing

Posted peyton-li

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了softmax求导cross-entropy求导及label smoothing相关的知识,希望对你有一定的参考价值。

softmax求导

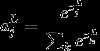

softmax层的输出为

其中, 表示第L层第j个神经元的输入,

表示第L层第j个神经元的输入, 表示第L层第j个神经元的输出,e表示自然常数。

表示第L层第j个神经元的输出,e表示自然常数。

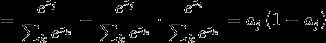

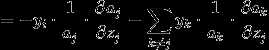

现在求 对

对 的导数,

的导数,

如果j=i,

1

1

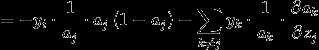

如果j i,

i,

2

2

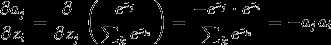

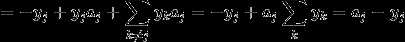

cross-entropy求导

loss function为

对softmax层的输入 求导,如下

求导,如下

label smoothing

对于ground truth为one-hot的情况,使用模型去拟合这样的函数具有两个问题:首先,无法保证模型的泛化能力,容易导致过拟合; 其次,全概率和零概率将鼓励所属类别和非所属类别之间的差距会被尽可能拉大,因为模型太过相信自己的预测了。

为了解决这一问题,使得模型没有那么肯定,提出了label smoothing。

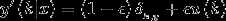

原ground truth为 ,添加一个与样本无关的分布

,添加一个与样本无关的分布 ,得到

,得到

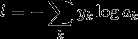

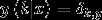

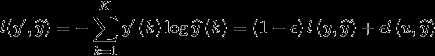

用 表示预测结果,则loss function为

表示预测结果,则loss function为

label smoothing是论文《Rethinking the Inception Architecture for Computer Vision》中提出的,文中表明,使用label smoothing后结果有一定程度的提升。在论文中, ,k表示类别,

,k表示类别, 。

。

以上是关于softmax求导cross-entropy求导及label smoothing的主要内容,如果未能解决你的问题,请参考以下文章