使用root配置的hadoop启动时报错

Posted mr-nie

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了使用root配置的hadoop启动时报错相关的知识,希望对你有一定的参考价值。

一、报错信息:

Starting namenodes on [master]

ERROR: Attempting to operate on hdfs namenode as root

ERROR: but there is no HDFS_NAMENODE_USER defined. Aborting operation.

Starting datanodes

ERROR: but there is no HDFS_NAMENODE_USER defined. Aborting operation.

Starting datanodes

ERROR: Attempting to operate on hdfs datanode as root

ERROR: but there is no HDFS_DATANODE_USER defined. Aborting operation.

ERROR: but there is no HDFS_DATANODE_USER defined. Aborting operation.

Starting secondary namenodes [slave1]

ERROR: Attempting to operate on hdfs secondarynamenode as root

ERROR: but there is no HDFS_SECONDARYNAMENODE_USER defined. Aborting operation.

二、解决办法

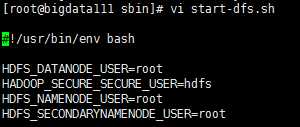

在/hadoop/sbin路径下:

将start-dfs.sh,stop-dfs.sh两个文件顶部添加以下参数

HDFS_DATANODE_USER=root

HDFS_DATANODE_SECURE_USER=hdfs

HDFS_NAMENODE_USER=root

HDFS_SECONDARYNAMENODE_USER=root

如下图:

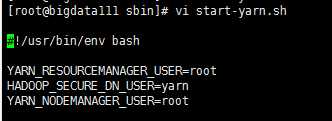

start-yarn.sh,stop-yarn.sh顶部也添加以下参数

YARN_RESOURCEMANAGER_USER=root

HADOOP_SECURE_DN_USER=yarn

YARN_NODEMANAGER_USER=root

如下图:

三、添加完启动遇到如下警告:

WARNING: HADOOP_SECURE_DN_USER has been replaced by HDFS_DATANODE_SECURE_USER.

需要将第二句:HADOOP_SECURE_DN_USER=hdfs 改为 HDFS_DATANODE_SECURE_USER=hdfs

以上是关于使用root配置的hadoop启动时报错的主要内容,如果未能解决你的问题,请参考以下文章