风格迁移学习三

Posted yunkail

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了风格迁移学习三相关的知识,希望对你有一定的参考价值。

论文:

Instance Normalization: The Missing Ingredient for Fast Stylization

提出背景:

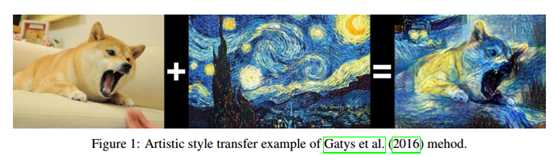

在论文《Image style transfer using convolutional neural networks》中提出了风格迁移算法,将一个图像的风格转移到另一个图像中,这个被风格化的图像同时匹配风格图和内容图,风格统计和内容统计都是从预训练好的用于图像分类的深度神经网络中提取出来的。风格统计是从浅层提取的,并且在空间位置上是均匀的,内容统计的提取则是从较深的层中提取,并且保留了空间位置上的信息。在这种方式中,风格统计信息是捕获风格图像的“纹理”,而内容统计是捕获内容图像的“结构”。如下图。

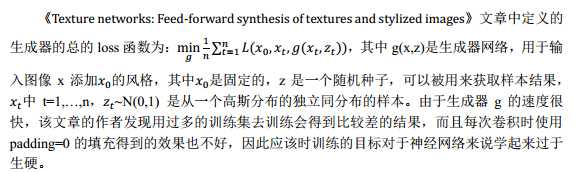

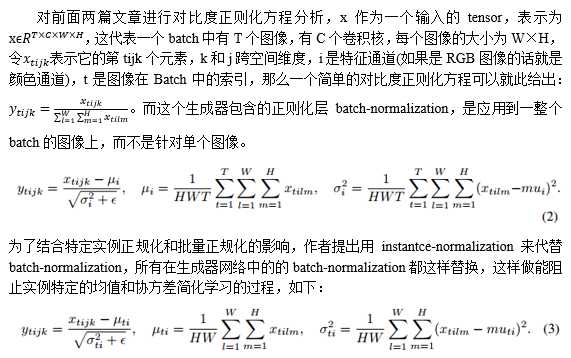

该论文中提出的方法可以产生很好的结果,但是计算效率比较差,为了改进计算效率,后来在另外两篇文章《Perceptual losses for real-time style transfer and superresolution》和《Texture networks: Feed-forward synthesis of textures and stylized images》中提出了通过学习等效的前馈生成网络,以便在单方向产生风格化的图像,这两种方法的不同在于生成器的结构细节不同,以及产生的结果的质量不同,然而,这两人产出结果从质量上看都没有最开始提出的慢的方法好。

因此作者重新复现了《Texture networks: Feed-forward synthesis of textures and stylized images》中的前馈网络进行图像的风格化,对生成器的结构提出了小的改变,从而带来性能的提升,可以达到和最初慢的方法相媲美的质量。

方法:

作者认为,图像风格化的结果不应该取决于内容图的对比度,而是取决于风格图像的对比度,所以在生成器中必须忽略内容图的对比度信息,而可以通过对CNN网络中正则化的改变来修改对内容图的对比度信息。

实验:

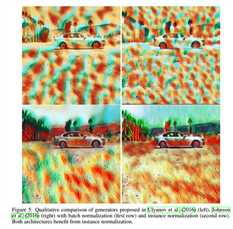

对比了batch-normalization和instantce-normalization两种方法,结果如下:

看出这两种方法的生成器的质量是相近的,但是第二行采用instantce-normalization的效果要比第一行采用batch-normalization效果要好。

参考文章:

以上是关于风格迁移学习三的主要内容,如果未能解决你的问题,请参考以下文章