算法的时间复杂度

Posted lo-me

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了算法的时间复杂度相关的知识,希望对你有一定的参考价值。

我们假设计算机运行一行基础代码需要执行一次运算

int aFunc(void) { printf("Hello, World!\\n"); // 需要执行 1 次 return 0; // 需要执行 1 次 }

上面这个方法需要执行 2 次运算

int aFunc(int n) { for(int i = 0; i<n; i++) { // 需要执行 (n + 1) 次 printf("Hello, World!\\n"); // 需要执行 n 次 } return 0; // 需要执行 1 次 }

这个方法需要 (n + 1 + n + 1) = 2n + 2 次运算

我们把 算法需要执行的运算次数 用 输入大小n 的函数 表示,即 T(n) 。此时为了 估算算法需要的运行时间 和 简化算法分析,我们引入时间复杂度的概念

定义:存在常数 c 和函数 f(N),使得当 N >= c 时 T(N) <= f(N),表示为 T(n) = O(f(n))

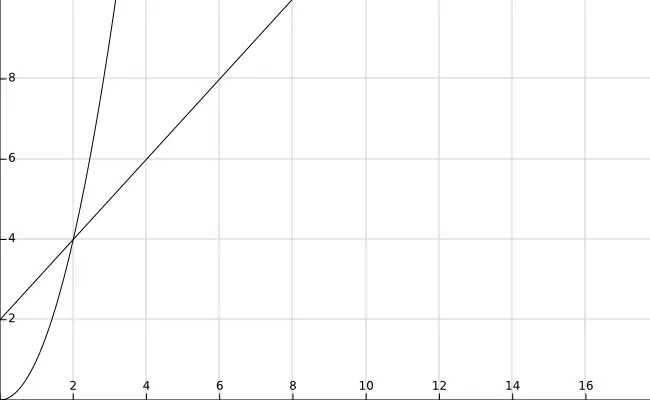

当 N >= 2 的时候,f(n) = n^2 总是大于 T(n) = n + 2 的,于是我们说 f(n) 的增长速度是大于或者等于 T(n) 的,也说 f(n) 是 T(n) 的上界,可以表示为 T(n) = O(f(n))。

以上是关于算法的时间复杂度的主要内容,如果未能解决你的问题,请参考以下文章