机器学习单词记录--02章单变量相性回归

Posted amyheartxy

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了机器学习单词记录--02章单变量相性回归相关的知识,希望对你有一定的参考价值。

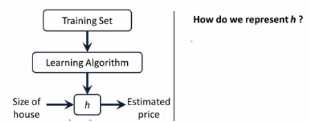

Liner regression 线性回归

The overall process of x x的整个过程

区分监督学习和无监督学习--看是否有“正确答案”和已知的预测值

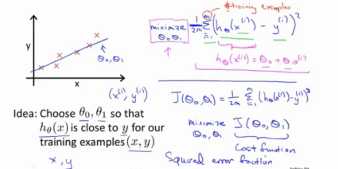

Cost function代价函数

M--denote the number of training examples表示训练样本的数量

Lowercase x 小写字母x

Output variables 输出变量

Training set训练集

Hypothesis 假设

Corresponding 相应的

Represent表示

Subscript下标 plus加

Shorthand缩写

Linear regression 线性回归(univariate单变量)

Figure out弄清楚

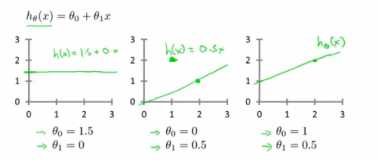

Straight line直线

Parameters of the model模型参数

Cost function 代价函数(the squared error function平方误差函数)

Mathematical definition数学定义

get back to 回去

Intuition直觉

Recap复习

Form 形成

Optimization objective 优化目标

Visualize可视化

Work with 与...合作

Theta Θ

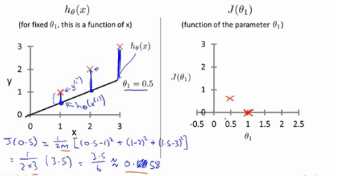

To minimize J of theta one 减少J(Θ_1)的值

Corresponds to相当于

Simplified definition 简化的定义

Pass through the point(0,0) 过点(0,0)

Concept概念

Hypothesis function假设函数

Θ_1,which controls the slope of the straight line它控制着直线的斜率

Temporary 暂时

Compute计算

One over 2m of my usual cost function 代价函数的1/2m倍

Square 平方

Vertical distance 垂直距离

The predicted value h of x i 预测值h(x^i)

Example样本

Math error计算错误

Flat line 水平线

Negative value 负数

Minus减

By computing the range of values 通过一系列数值的计算

For each value of theta one corresponds to a different hypothesis

每一个Θ_1都对应一个不同的假设函数

Trace out 追踪

Minimize 最小化

Assume 假设

Be familiar with x 对x熟悉

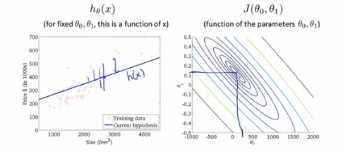

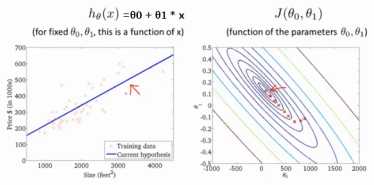

Contour plot 高等线

Contour figures高等图像

illustrator 图像

make sense to 对xx有意义

Problem 问题、课题、难题

Generate生成

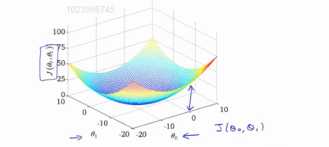

Bowl shaped function 碗状函数

3-D surface plot 3-D曲面图

axes 、axis 轴

Vary 改变

Rotate this plot around 旋转这个图形

Ovals、Ellipse 椭圆

The middle of the these concentric ellipse同心椭圆的中心

Intersect 相交

Manually read off the numbers 手工读出数

High dimensional figures with more parameters 具有更多参数、更高维的图形

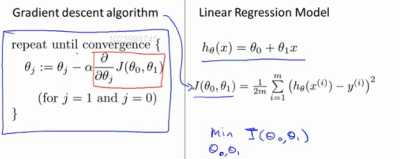

Gradient descent for minimizing the cost function J 代价函数J最小化的梯度下降法

Arbitrary 随意的

Setup 体系、概述

J(θ0,θ1)是代价函数

J(θ0,θ1)是代价函数

For solving this more general problem 为了去解决更一般的问题

For the sake of brevity 简短起见

The sake of 为了

Succinctness 简洁

Notation 符号

Pretend 假装

Wind up 直到、结束

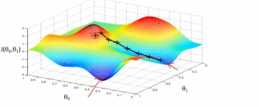

The height of surface 曲面的高度

Pick挑

initialize 初始化

Hill 山

Landscape 景色

Grassy park 青草公园

Spin 360 degrees around and just look all around us旋转360度,看看我们的周围

If I were to take a little baby step in some direction ,and I want to go downhill as quickly as possible,what direction do I take that little baby step in if I want to physically walk down this hill as rapidly as possible?

如果我要在某个方向上走一步,并且我想尽快下山的话,我应该朝什么方向迈步?

Converge、convergence汇合

Property 属性、特点

Local optimum 局部最佳

Intuition 直觉

Subtract 减去

Equation 公式

Detail 细节

Unpack 解压、解释

Assignment 分配、赋值

Assignment operator 赋值运算符

Take the value in b 取b的值

Assert 断言

Claim声明

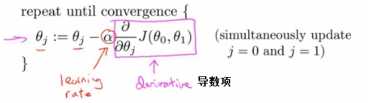

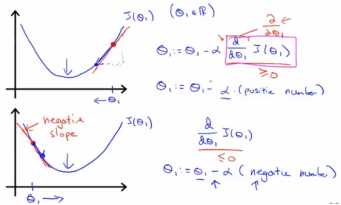

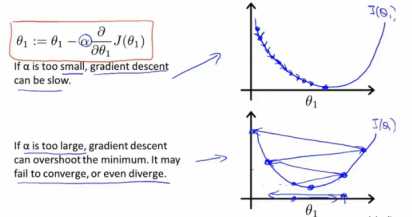

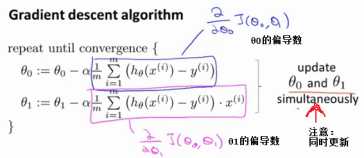

Alpha α---- learning rate 学习速率(永远是个正数)

Learning rate 学习率

Aggressive 侵略性、迅速

Term 术语

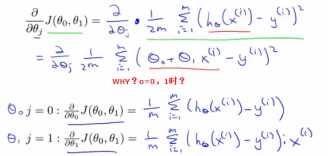

Derivative 导数

Derive this derivative term 推导这个导数项

Calculus微积分

Subtle 微妙

Update更新

Expression 表达式

Simultaneously 同时

Simultaneous updates同步更新

Behave 表现

Partial derivatives 偏导数

Derivatives 导数

α--- it controls how big a step we take when updating my parameter theta J

(他控制我们以多大的幅度更新这个参数θ_J)

Convey 解释

Tangent 切线

Positive slope 正斜率

The slope of that line 这条线的斜率

Multiple 多

Minimum 最低点

Global minimum全局最低点

Overshoot 越过

Iteration 迭代

Fail to converge or even diverge 无法收敛甚至发散

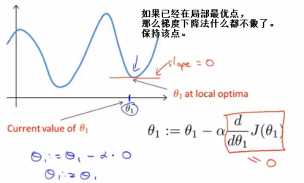

At local optimum your derivative would be equal to zero

(在局部最优点的导数等于0)

Magnitude 大小

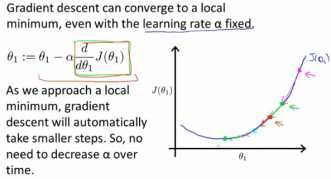

导数越小,θ更新幅度越小

Square cost function 平方代价函数

Put together gradient descent with our cost function 将梯度下降和代价函数结合

Linear regression model线性回归模型

h线性假设、J(θ0,θ1)平方代价函数

Apply应用

This piece of code 这段代码

Multivariate calculus 多元微积分

Respective 对应的

Be susceptible to 易受影响

梯度下降算法的代价函数往往是一个碗状bow-shaped function的图形

Convex function 凸函数--------doesn’t have any local optima , except for the one global optimum

没有局部最优解,只有一个全局最优

Specific 具体

down left 左下

This global minimum corresponds to this hypothesis which gives me a good fit to the data

这个全局最小对应的假设曲线让我一个很好地拟合了数据

Batch gradient descent:

其他的梯度算法:

do not look at the entire training set,

but look at small subsets of the traing sets at a time

没有查看整个训练集,而是每次只关注了小子集

linear regression with gradient descent

啥是使用了梯度下降的线性回归?

advanced linear algebra 高等线性代数

iterative algorithm 迭代算法

generalization 通用

以上是关于机器学习单词记录--02章单变量相性回归的主要内容,如果未能解决你的问题,请参考以下文章