jieba(结巴)常用方法

Posted ltb6w

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了jieba(结巴)常用方法相关的知识,希望对你有一定的参考价值。

第一步:先安装jieba库

输入命令:pip install jieba

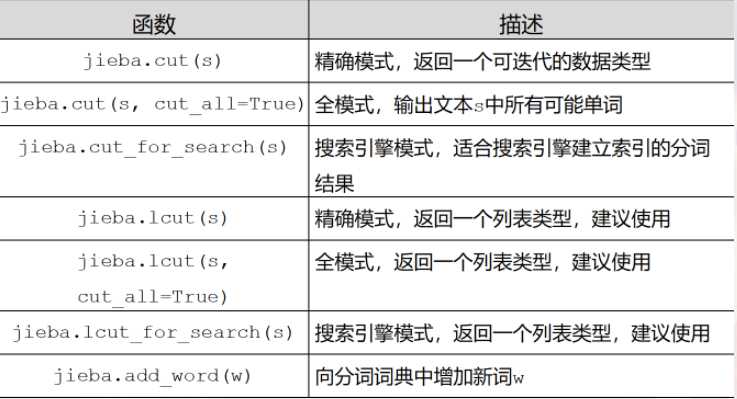

jieba库常用函数:

jieba库分词的三种模式:

1、精准模式:把文本精准地分开,不存在冗余

2、全模式:把文中所有可能的词语都扫描出来,存在冗余

3、搜索引擎模式:在精准模式的基础上,再次对长词进行切分

精准模式:

>>> import jieba

>>> jieba.lcut("中国是一个伟大的国家")

Building prefix dict from the default dictionary ...

Loading model from cache C:\\Users\\25282\\AppData\\Local\\Temp\\jieba.cache

Loading model cost 0.869 seconds.

Prefix dict has been built succesfully.

[‘中国‘, ‘是‘, ‘一个‘, ‘伟大‘, ‘的‘, ‘国家‘]

全模式:

>>> jieba.lcut("中国是一个伟大的国家",cut_all=True)

[‘中国‘, ‘国是‘, ‘一个‘, ‘伟大‘, ‘的‘, ‘国家‘]

搜索引擎模式:

>>> jieba.lcut_for_search("中华人民共和国是伟大的")

[‘中华‘, ‘华人‘, ‘人民‘, ‘共和‘, ‘共和国‘, ‘中华人民共和国‘, ‘是‘, ‘伟大‘, ‘的‘]

向分词词典增加新词:

>>> jieba.add_word("蟒蛇语言")

>>> jieba.lcut("python是蟒蛇语言")

[‘python‘, ‘是‘, ‘蟒蛇语言‘]

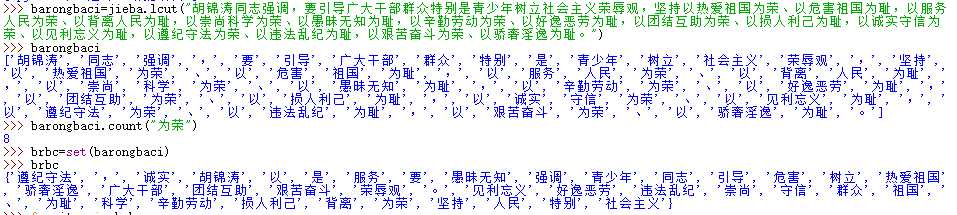

jieba库应用举例1 ——统计八荣八耻中出现的词汇

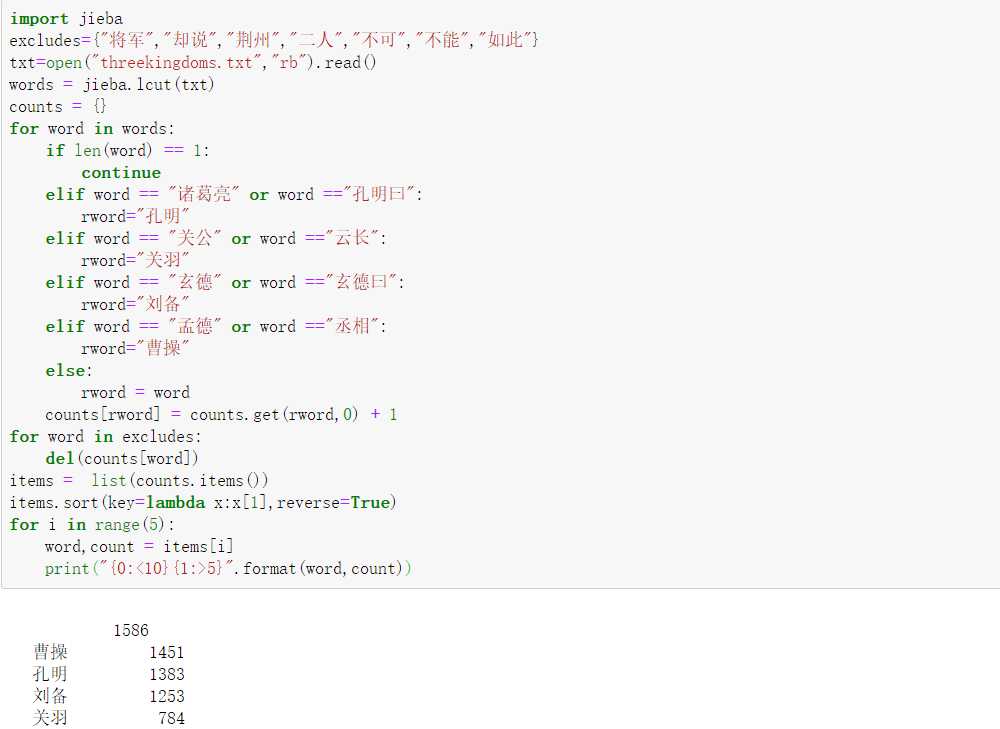

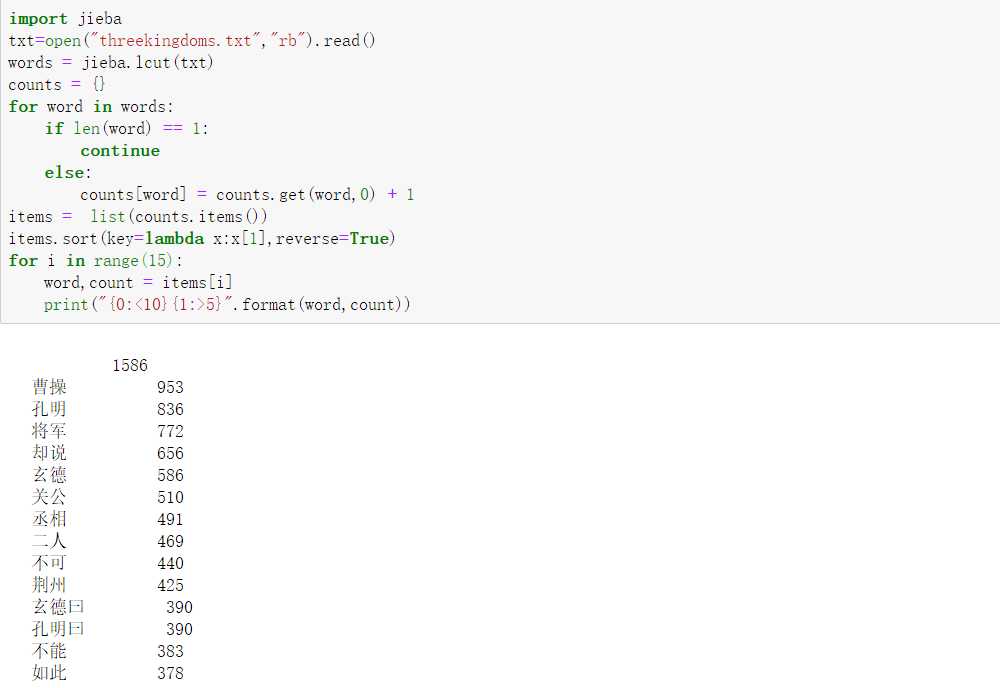

jieba库分词统计实例2--三国演义词汇

(1)查找出“threekingdoms.txt”文件中出现频率前十位的词汇

(2)统计出“threekingdoms.txt”文件 “关羽”、“曹操”、“诸葛亮”、“刘备” 等人名出现的次数