CDH搭建和集成sparkkafka操作

Posted niutao

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了CDH搭建和集成sparkkafka操作相关的知识,希望对你有一定的参考价值。

包下载:

由于是离线部署,因此需要预先下载好需要的文件。 需要准备的文件有: Cloudera Manager 5 文件名: cloudera-manager-centos7-cm5.14.0_x86_64.tar.gz 下载地址: https://archive.cloudera.com/cm5/cm/5/ CDH安装包(Parecls包) 版本号必须与Cloudera Manager相对应 下载地址: https://archive.cloudera.com/cdh5/parcels/5.14.0/ 需要下载下面3个文件: CDH-5.14.0-1.cdh5.14.0.p0.23-el7.parcel CDH-5.14.0-1.cdh5.14.0.p0.23-el7.parcel.sha1 manifest.json mysql jdbc驱动 文件名: mysql-connector-java-.tar.gz 下载地址: https://dev.mysql.com/downloads/connector/j/ 解压出: mysql-connector-java-bin.jar

步骤:

所有节点上传cloudera-manager-centos7-cm5.14.0_x86_64.tar.gz文件并解压 # tar -zxvf cloudera-manager-centos7-cm5.14.0_x86_64.tar.gz -C /opt 所有节点手动创建文件夹 # mkdir /opt/cm-5.14.0/run/cloudera-scm-agent 所有节点创建cloudera-scm用户 # useradd --system --home=/opt/cm-5.14.0/run/cloudera-scm-server --no-create-home --shell=/bin/false --comment "Cloudera SCM User" cloudera-scm 初始化数据库(只需要在Cloudera Manager Server节点执行) 首先需要将mysql jdbc驱动放入相应位置: # cp /path/to/mysql-connector-java-5.1.42-bin.jar /opt/cm-5.14.0/share/cmf/lib/ 然后执行命令: # /opt/cm-5.14.0/share/cmf/schema/scm_prepare_database.sh mysql -h df2 -uroot -proot --scm-host df1 scm scm scm 脚本参数说明: ${数据库类型} -h ${数据库所在节点ip/hostname} -u${数据库用户名} -p${数据库密码} –scm-host ${Cloudera Manager Server节点ip/hostname} scm scm scm 提示下面这个说明执行成功: All done, your SCM database is configured correctly! 所有节点修改Agent配置 # vim /opt/cm-5.14.0/etc/cloudera-scm-agent/config.ini 将其中的server_host参数修改为Cloudera Manager Server节点的主机名 将如下文件放到Server节点的/opt/cloudera/parcel-repo/目录中: CDH-5.14.0-1.cdh5.14.0.p0.23-el7.parcel CDH-5.14.0-1.cdh5.14.0.p0.23-el7.parcel.sha1 manifest.json 重命名sha1文件 # mv CDH-5.14.0-1.cdh5.14.0.p0.23-el7.parcel.sha1 CDH-5.14.0-1.cdh5.14.0.p0.23-el7.parcel.sha 所有节点更改cm相关文件夹的用户及用户组 # chown -R cloudera-scm:cloudera-scm /opt/cloudera # chown -R cloudera-scm:cloudera-scm /opt/cm-5.14.0 启动Cloudera Manager Server节点: # /opt/cm-5.14.0/etc/init.d/cloudera-scm-server start # /opt/cm-5.14.0/etc/init.d/cloudera-scm-agent start 其它节点: # /opt/cm-5.14.0/etc/init.d/cloudera-scm-agent start

集成spark

CDH版本是5.14.0

spark安装版本是:2.1.0

包下载:

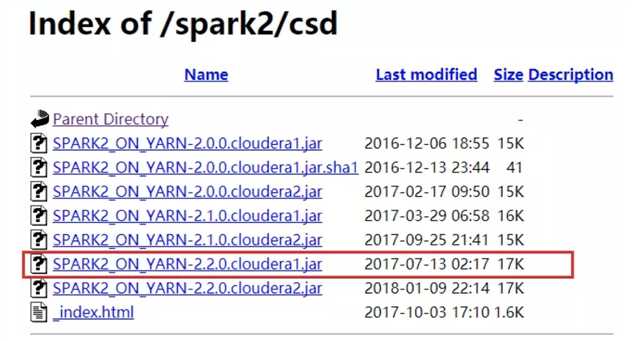

CSD包下载 http://archive.cloudera.com/spark2/csd/

parcel包下载 http://archive.cloudera.com/spark2/parcels/

安装spark2

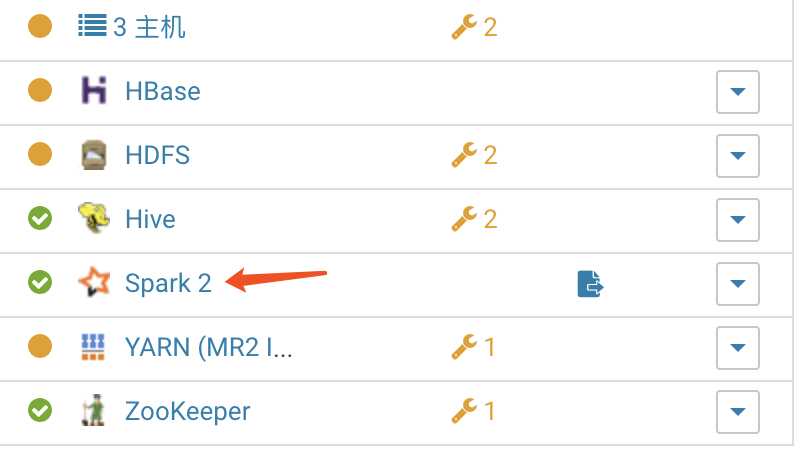

在所有节点进行下面操作 上传CSD包到机器的/opt/cloudera/csd目录。注意如果本目录下有其他的jar包,把删掉或者移到其他目录 修改SPARK_ON_YARN-2.2.0.cloudera1.jar的用户和组 chown cloudera-scm:cloudera-scm SPARK_ON_YARN-2.1.0.cloudera1.jar 将parcel包上传到机器的/opt/cloudera/parcel-repo目录。注意: 如果有其他的安装包,不用删除 ,但是如果本目录下有其他的重名文件比如manifest.json文件,把它重命名备份掉。然后把那3个parcel包的文件放在这里。 停掉CM和集群,现在将他们停掉。然后运行命令 service cloudera-scm-agent restart service cloudera-scm-server restart 把CM和集群启动起来。然后点击主机->Parcel页面,看是否多了个spark2的选项。如下图,你这里此时应该是分配按钮,点击,等待操作完成后,点击激活按钮

还要注意的是:在spark historyserver这台机器上,创建本队文件夹路径,并赋予权限,不然你的sparkhistory是启动不了的

[[email protected] csd]# mkdir -p /user/spark/spark2ApplicationHistory [[email protected] csd]# chown -R spark:spark /user/spark

激活后,点击你的群集-》添加服务,添加spark2服务。注意,如果你这里看不到spark2服务,就请检查你的CSD包和parcel包是否对应,上面的步骤是否有漏掉。正常情况下,应该是能用了。

以上是关于CDH搭建和集成sparkkafka操作的主要内容,如果未能解决你的问题,请参考以下文章