Spark-core学习之三 Spark集群搭建

Posted cac2020

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Spark-core学习之三 Spark集群搭建相关的知识,希望对你有一定的参考价值。

环境

虚拟机:VMware 10

Linux版本:CentOS-6.5-x86_64

客户端:Xshell4

FTP:Xftp4

jdk1.8

scala-2.10.4(依赖jdk1.8)

spark-1.6

组建方案:

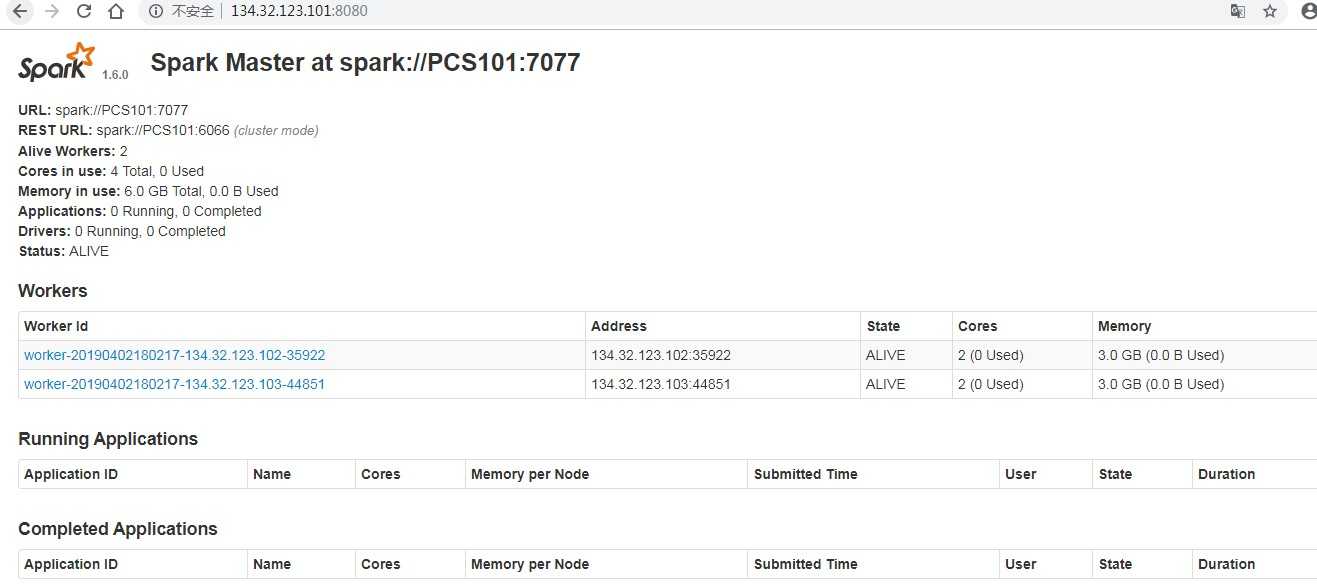

master:PCS101,slave:PCS102、PCS103

搭建方式一:Standalone

步骤一:解压文件 改名

[[email protected] src]# tar -zxvf spark-1.6.0-bin-hadoop2.6.tgz -C /usr/local [[email protected] local]# mv spark-1.6.0-bin-hadoop2.6 spark-1.6.0

步骤一:修改配置文件

1、slaves.template 设置从节点

[[email protected] conf]# cd /usr/local/spark-1.6.0/conf && mv slaves.template slaves && vi slaves PCS102 PCS103

2、spark-config.sh 设置java_home

export JAVA_HOME=/usr/local/jdk1.8.0_65

3、spark-env.sh

[[email protected] conf]# mv spark-env.sh.template spark-env.sh && vi spark-env.sh #SPARK_MASTER_IP:master的ip export SPARK_MASTER_IP=PCS101 #SPARK_MASTER_PORT:提交任务的端口,默认是7077 export SPARK_MASTER_PORT=7077 #SPARK_WORKER_CORES:每个worker从节点能够支配的core的个数 export SPARK_WORKER_CORES=2 #SPARK_WORKER_MEMORY:每个worker从节点能够支配的内存数 export SPARK_WORKER_MEMORY=3g #SPARK_MASTER_WEBUI_PORT:sparkwebUI端口 默认8080 或者修改spark-master.sh export SPARK_MASTER_WEBUI_PORT=8080

步骤三、分发spark到另外两个节点

[[email protected] local]# scp -r /usr/local/spark-1.6.0 [email protected]:`pwd` [[email protected] local]# scp -r /usr/local/spark-1.6.0 [email protected]:`pwd`

步骤四:启动集群

[[email protected] sbin]# /usr/local/spark-1.6.0/sbin/start-all.sh

步骤五:关闭集群

[[email protected] sbin]# /usr/local/spark-1.6.0/sbin/stop-all.sh

搭建方式二:Yarn

以上是关于Spark-core学习之三 Spark集群搭建的主要内容,如果未能解决你的问题,请参考以下文章