深度残差网络

Posted weilonghu

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了深度残差网络相关的知识,希望对你有一定的参考价值。

- 神经网络的层数决定了模型的容量

- 网络层数加深,容易陷入局部最优解,梯度消失问题严重

ResNet

- 解决或缓解深层的神经网络训练中的梯度消失问题

- 层数更深的网络反而具有更大的训练误差,很大程度归结于梯度消失问题

- 误差传播涉及非常多的参数和导数的连乘,很容易导致梯度消失或者膨胀

- ResNet

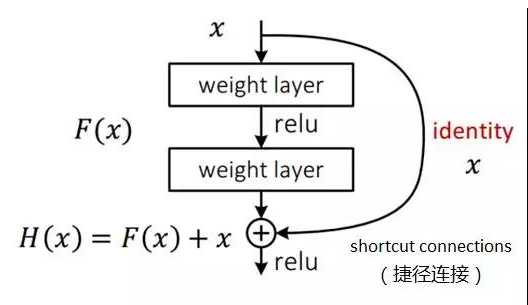

- 既然离输入近的神经网络层较难训练,那么可以将它短接到更靠近输出的层

- (x)经过两层的变换得到(F(x))

- 短接后,两层的网络模块输出(H(x)=F(x)+x)

- (F(x))被设计为只需要拟合(x)与目标输出( ilde{H}(x))的残差( ilde{H}(x))

- 跳过的两层只需要拟合上层输出和目标之间的残差

以上是关于深度残差网络的主要内容,如果未能解决你的问题,请参考以下文章