深度之眼PyTorch训练营第二期---14正则化

Posted cola-1998

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了深度之眼PyTorch训练营第二期---14正则化相关的知识,希望对你有一定的参考价值。

一、正则化与偏差-方差分解

Regularization:减少方差的策略

误差可分解为:偏差,方差与噪声之和,即误差 = 偏差 + 方差 + 噪声之和

偏差:度量了学习算法的期望预测与真实结果的偏离程度,即刻画了学习算法本身的拟合能力

方差:度量了同样大小的训练集的变动所导致的学习性能的变化,即刻画了数据扰动所造成的影响

噪声:表达了再当前任务上任何学习算法所能达到的期望泛化误差的下界

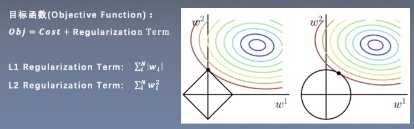

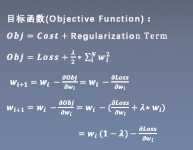

二、pytorch中的L2正则化---weight decay

L2 Regularization = weight decay(权值衰减)

三、Dropout概念

Dropout随机失活

随机:dropout probability

失活:weight = 0

数据尺度变化:测试时,所有权重乘以1 - drop_prob

drop_prob = 0.3 1 - drop_prob = 0.7

nn.Dropout

功能:Dropout层

参数:

p:被舍弃的概率,失活概率

实现细节:训练时权重均除以1-p

以上是关于深度之眼PyTorch训练营第二期---14正则化的主要内容,如果未能解决你的问题,请参考以下文章