mysql如何分批导出超150万行数据表,因为CSV文件用excel打开最多容纳104万行?

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了mysql如何分批导出超150万行数据表,因为CSV文件用excel打开最多容纳104万行?相关的知识,希望对你有一定的参考价值。

mysqldump -u用户名 -p密码 -t -T /var/lib/mysql-files/ 数据库名 表名 --where="筛选条件" --fields-terminated-by=',' --fields-enclosed-by='\"'参数说明:

-t 不打印表的创建信息

-T 以 txt 文本输出/var/lib/mysql-files/,输出的地址为 show variables like 'secure_file_priv'; 查询出的

--fields-terminated-by 字段之间以,分割

--fields-enclosed-by 每个字段用“包含

输出的文件在/var/lib/mysql-files/,文件名为表名.txt 参考技术A 是的excel最大保存1048576行,你最好分两次导出 参考技术B 用的是什么mysql工具?

可以使用sql语句根据主键排序查出前100万导出一次,再查出后50万再导出一次。

php+mysql实现数据分批插入

上周需要将云端的数据有条件的录入到mysql中,最开始是使用遍历数据然后一条条的插入的笨方法,结果速度慢的要死,所以又随便写了个笨方法2.0,记录一下自己菜鸟的成长历程。同时这也是在博客园的第一篇文章,目的仅仅是单纯的记录一下自己的狗屎代码,因为我是菜鸟,哈哈。。。

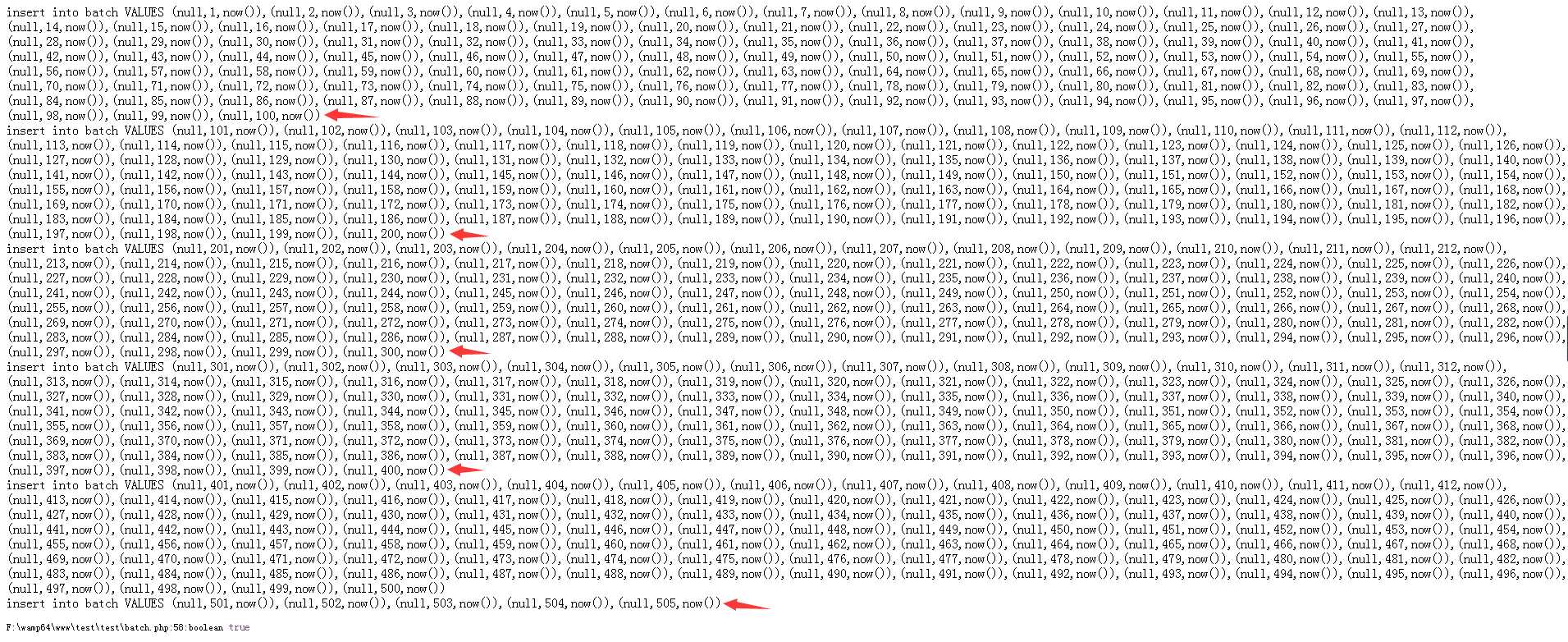

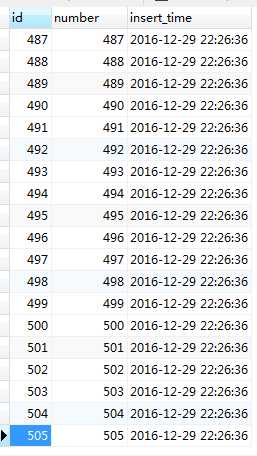

比如说有10001条数据,每次插入1000条,分11次插入完成,代码如下:

1 <?php 2 /** 3 * Created by PhpStorm. 4 * User: Soup 5 * Date: 2016/12/29 6 * Time: 21:04 7 */ 8 9 $mysqli = new mysqli(‘localhost‘,‘root‘,‘123456‘,‘test‘); 10 11 12 13 if ($mysqli->connect_error) { 14 die(‘Connect Error (‘ . $mysqli->connect_errno . ‘) ‘ 15 . $mysqli->connect_error); 16 } 17 18 /* 19 *@param $data array 要插入的数据 20 *@param $each int 每次插入的条数 21 */ 22 function batchInsert($data,$each){ 23 24 $num = count($data); // 数据总数 25 $step = ceil( $num/$each); // insert执行总次数 26 27 28 $j = 1; 29 $s = $step; 30 31 foreach ($data as $val){ // 目前仅仅是起到循环作用 32 if($j > $step) break; 33 $arr2 = array_slice($data, ($step - $s) * $each, $each); // 每次取100条 34 $sql = "insert into batch VALUES "; 35 foreach($arr2 as $v){ 36 $exist = $GLOBALS[‘mysqli‘]->query("select * from batch where number = ‘$v‘ limit 1 "); // 检查要插入的数据是否已存在 37 $row = $exist->fetch_array(MYSQLI_ASSOC); 38 if(empty($row)){ 39 $sql .= "(null,$v,now()),"; // 将sql语句拼接起来 40 } 41 } 42 $sql = rtrim($sql, ‘,‘); 43 $result = $GLOBALS[‘mysqli‘]->query($sql); 44 echo $sql,‘<br>‘; 45 46 47 $j++; 48 $s--; 49 } 50 return $result; 51 } 52 53 // 先测试简单的数字插入 54 for ($i = 1;$i <= 505;++$i){ 55 $arr[$i] = $i; 56 } 57 58 var_dump(batchInsert($arr,100));

测试505条数据,每次插入100条,分6次插入完成。

以上是关于mysql如何分批导出超150万行数据表,因为CSV文件用excel打开最多容纳104万行?的主要内容,如果未能解决你的问题,请参考以下文章

将Mysql中的2000万条数据分批。请建议一种更快的方法?