nodes had volume node affinity conflict

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了nodes had volume node affinity conflict相关的知识,希望对你有一定的参考价值。

参考技术A 1 node(s) had taints that the pod didn't tolerate, 2 node(s) had volume node affinity conflict.销毁tidb cluster 之后,再次部署tidbcluster后发现 tikv都是pending,describe发现如下

1个节点存在pod无法容忍的污染,2个节点存在卷节点亲和冲突

是之前数据卷中的数据没清理导致的

删除之前的数据

删除之前的数据后 ,再重新 helm install tidb-cluster

1.范式

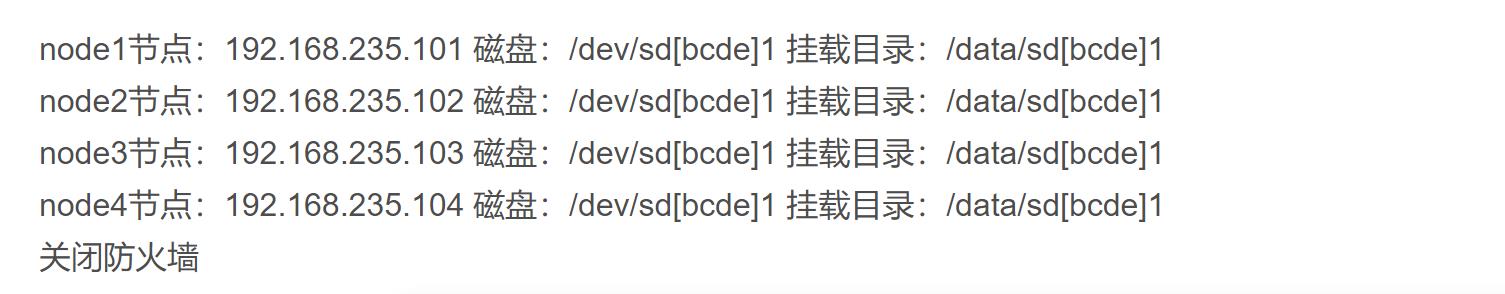

GFS 磁盘 分布文件系统

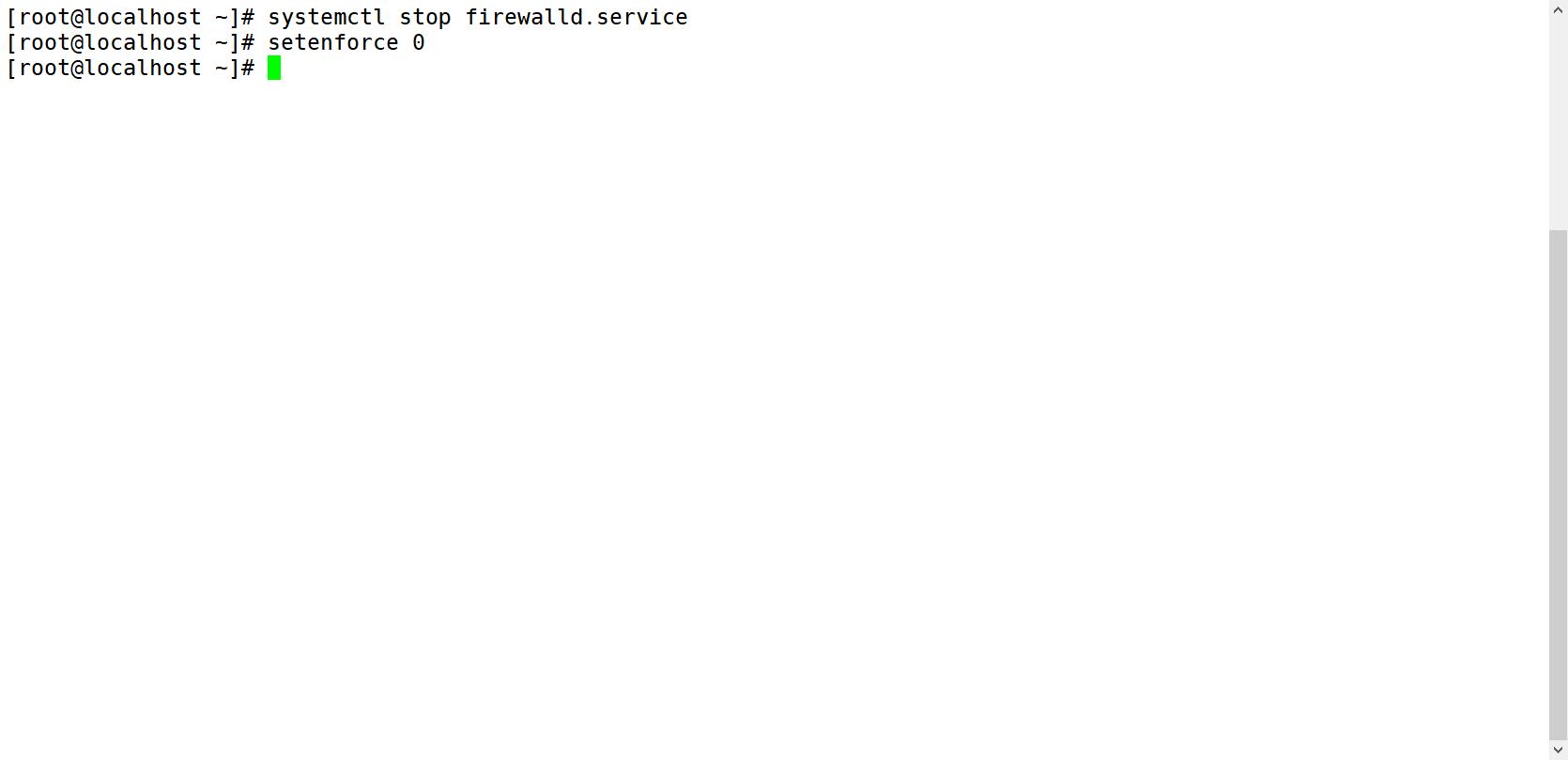

一、准备环境(每一台都要设置)

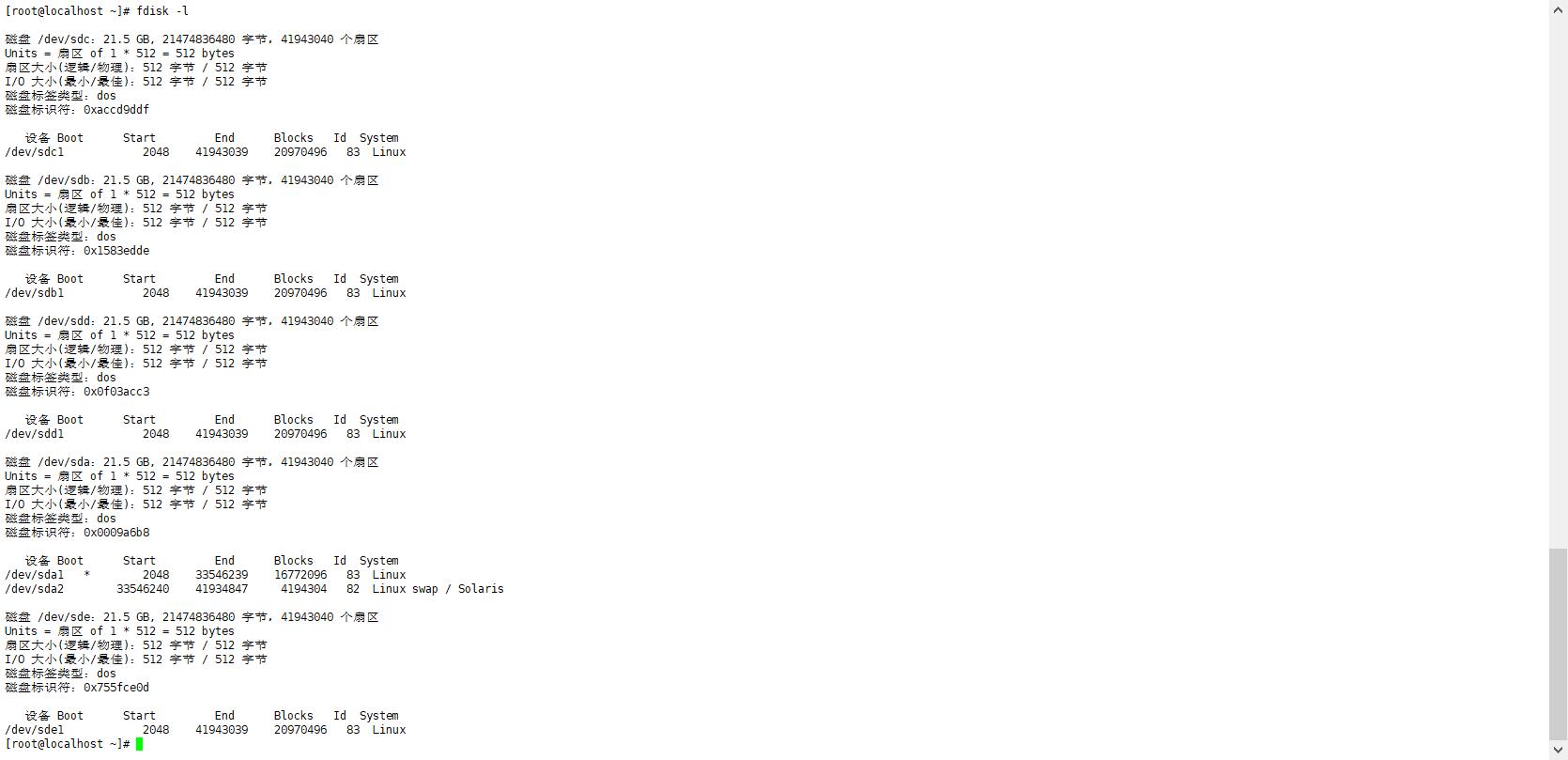

1.磁盘分区、挂载

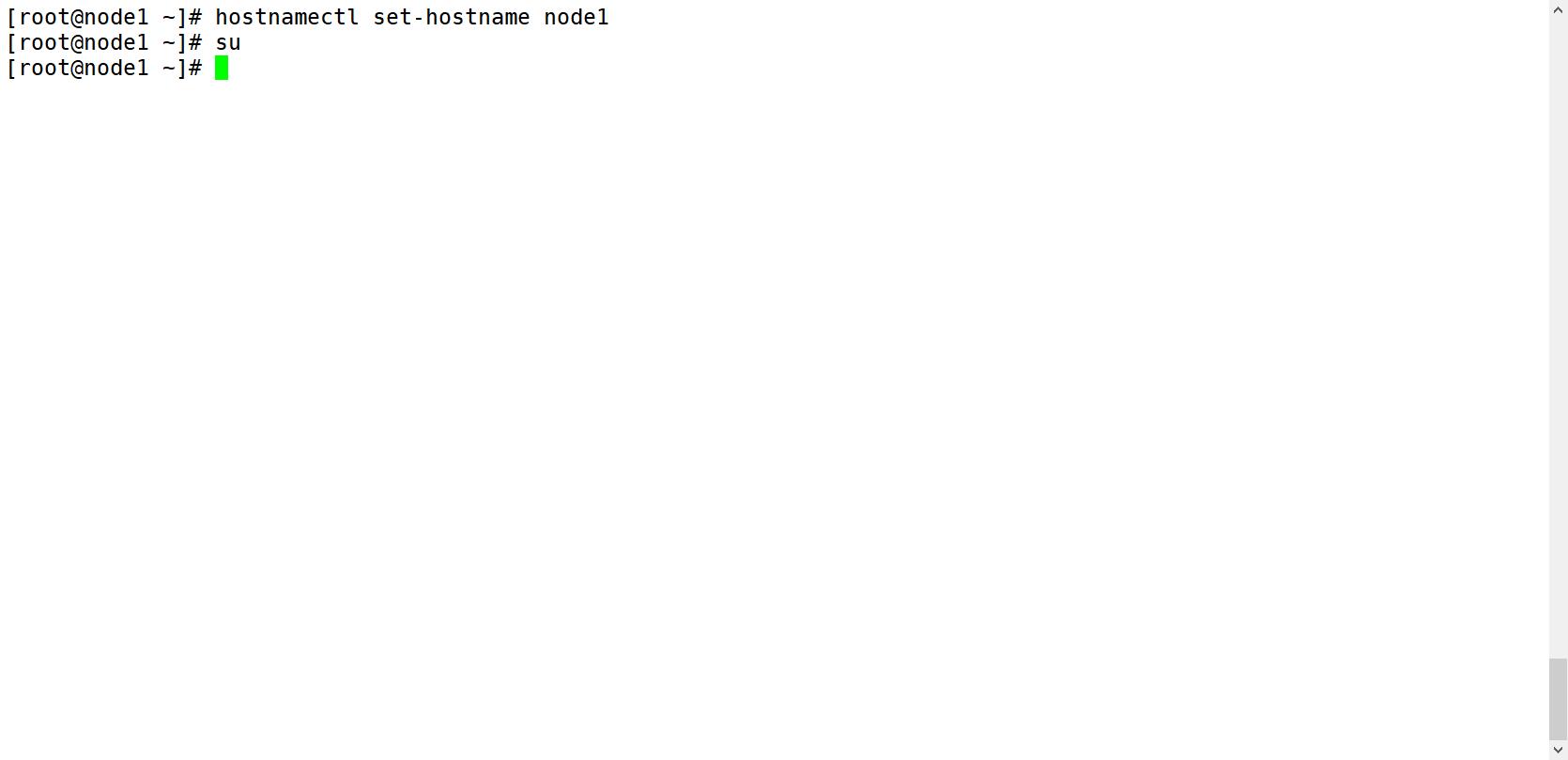

2.修改主机名

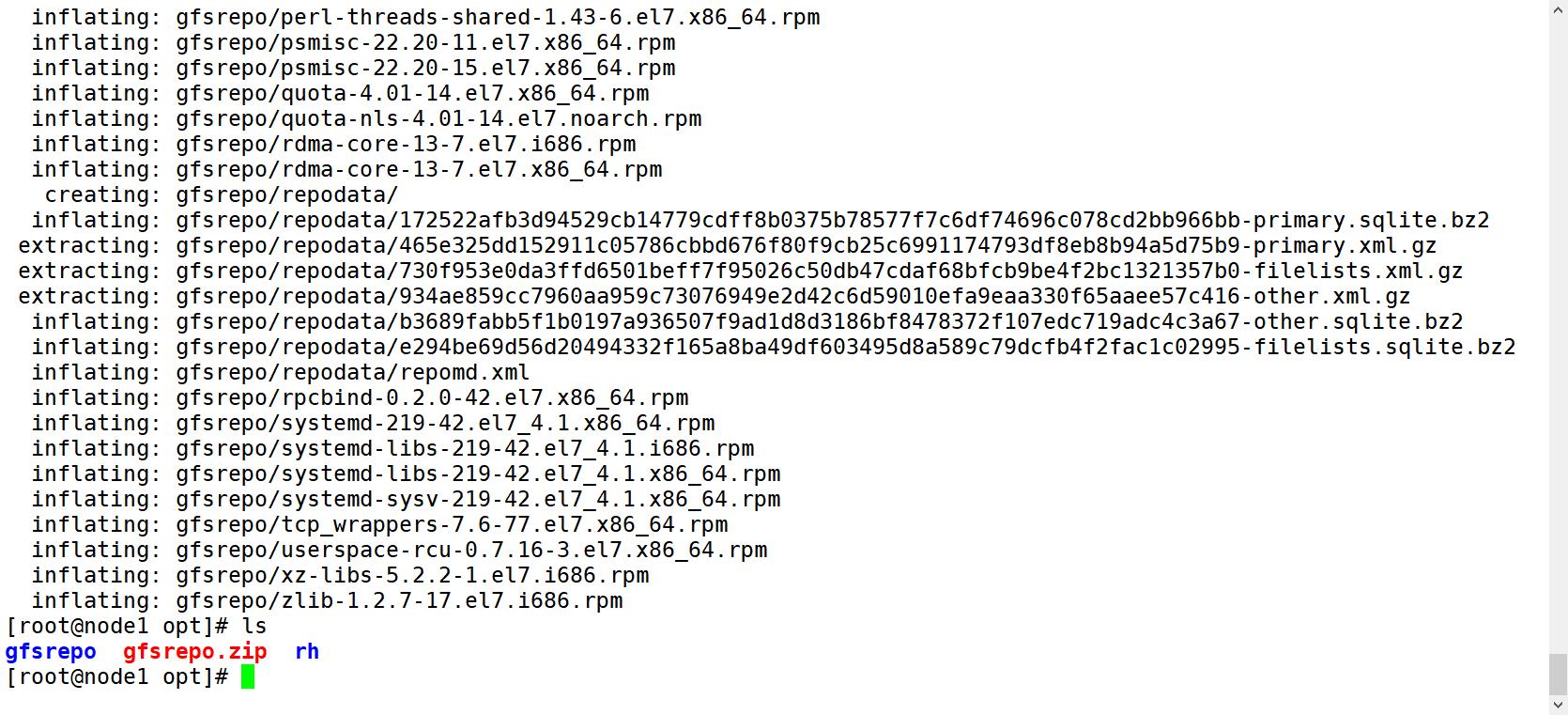

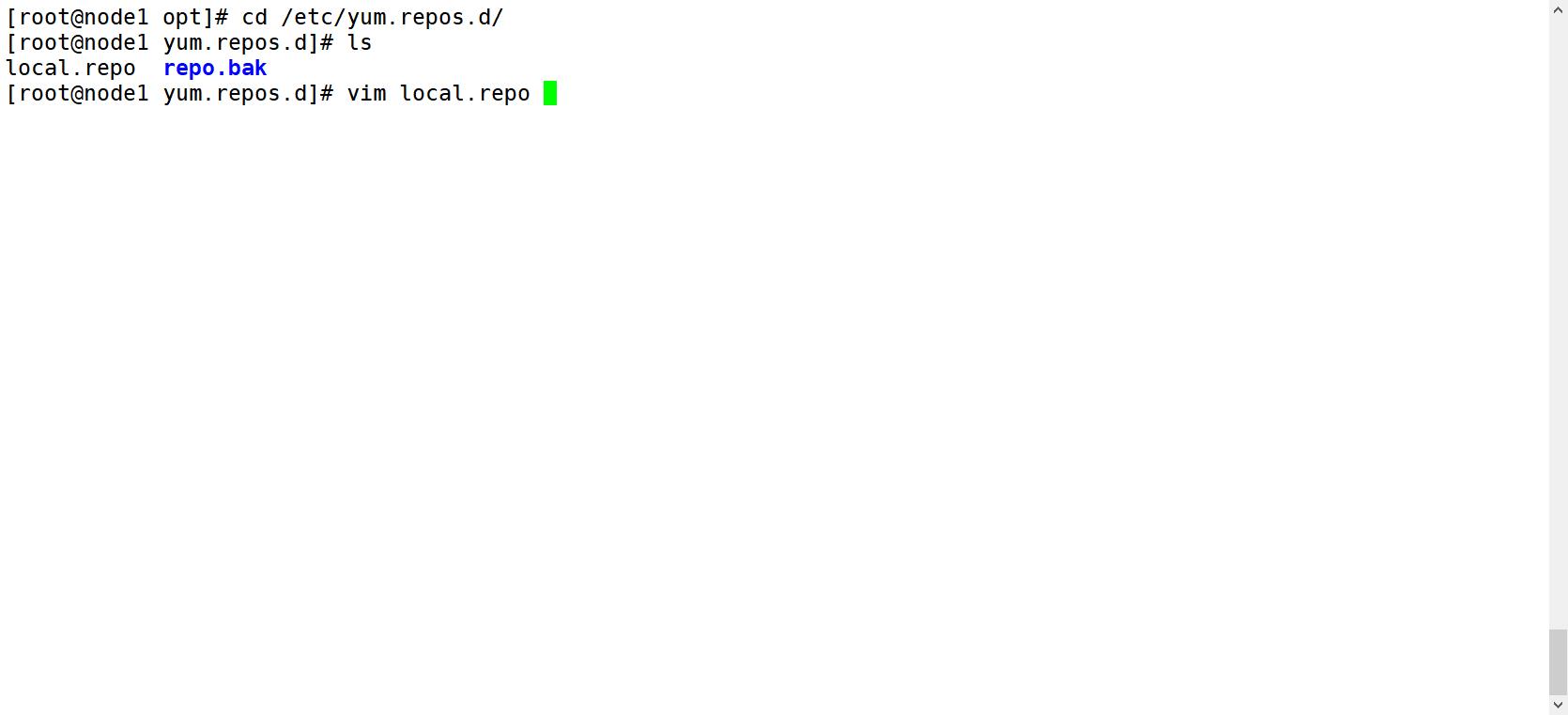

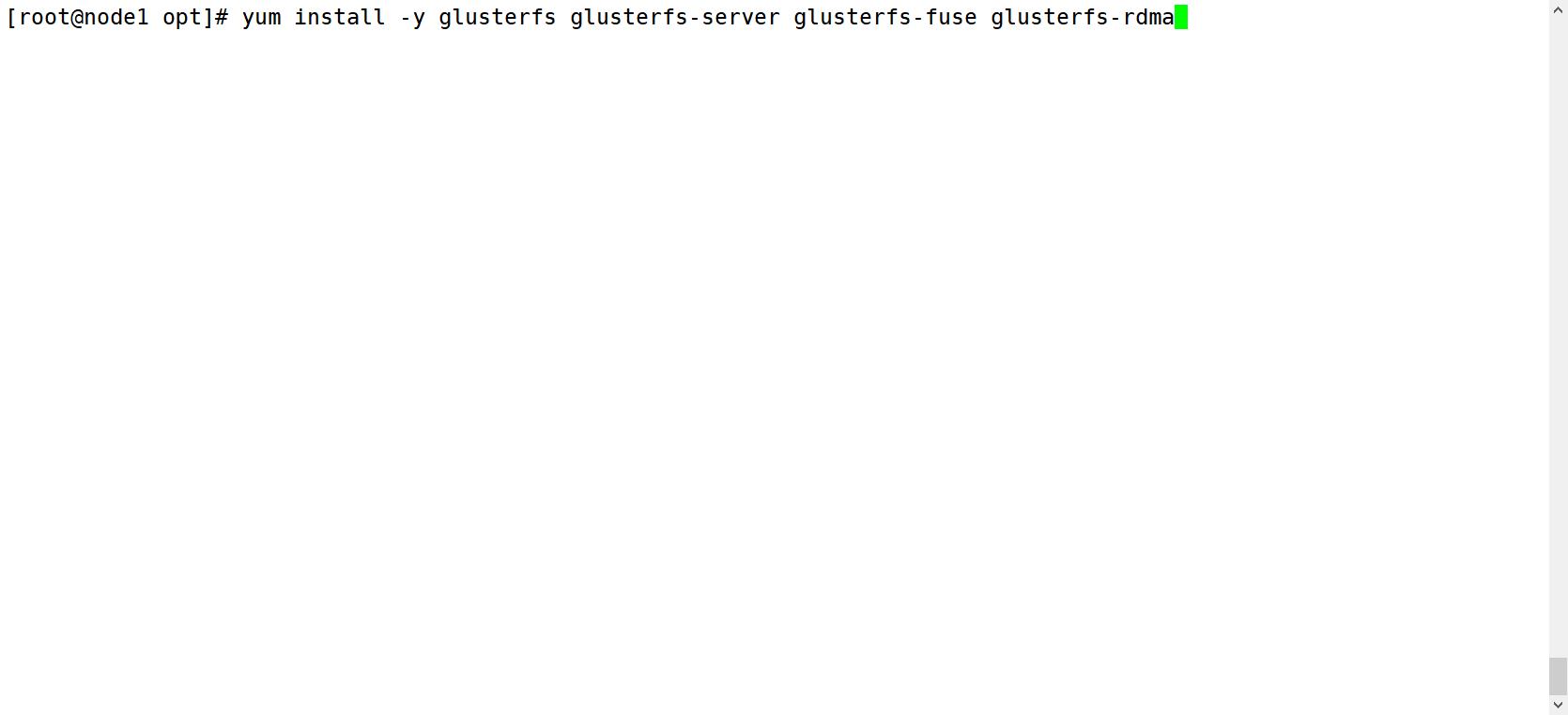

3.安装、启动GFS

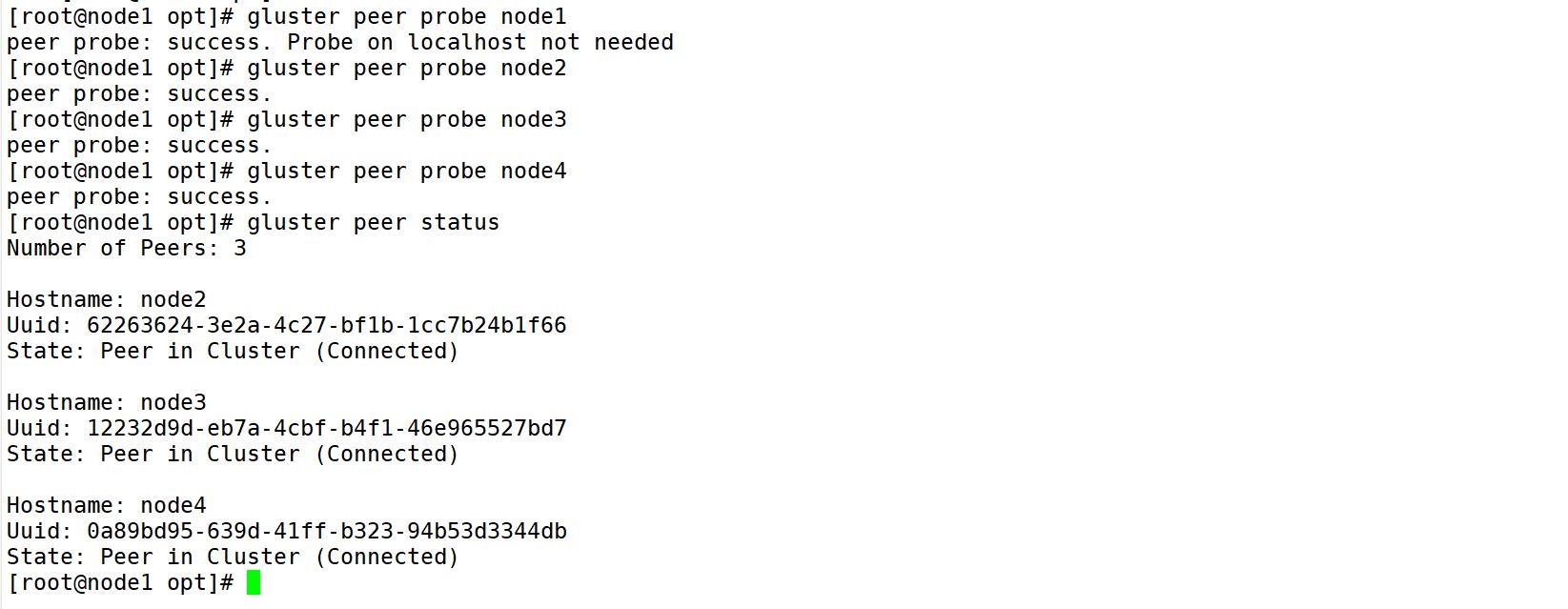

4.添加节点到储存信任池上(在node1节点上操作即可)

5.创建卷

dis-volume 分布式卷 node1(/data/sdb1)、node2(/data/sdb1)

stripe-volume 条带卷 node1(/data/sdc1)、node2(/data/sdc1)

rep-volume 复制卷 node3(/data/sdb1)、node4(/data/sdb1)

dis-stripe 分布式条带卷 node1(/data/sdd1)、node2(/data/sdd1)、node3(/data/sdd1)、node4(/data/sdd1)

dis-rep 分布式复制卷 node1(/data/sde1)、node2(/data/sde1)、node3(/data/sde1)、node4(/data/sde1)

(1)创建分布式卷

gluster volume create dis-volume node1:/data/sdb1 node2:/data/sdb1 force

(2)创建条带卷

gluster volume create stripe-volume stripe 2 node1:/data/sdc1 node2:/data/sdc1 force

(3)创建复制卷

gluster volume create rep-volume replica 2 node3:/data/sdb1 node4:/data/sdb1 force

(4)创建分布式条带卷

gluster volume create dis-stripe stripe 2 node1:/data/sdd1 node2:/data/sdd1 node3:/data/sdd1 node4:/data/sdd1 force

(5)创建分布式复制卷

gluster volume create dis-rep replica 2 node1:/data/sde1 node2:/data/sde1 node3:/data/sde1 node4:/data/sde1 force

二、部署Gluster客户端

1.安装客户端软件

和上面安装方法相同,导入压缩包解压后,使用yum安装yum -y install glusterfs glusterfs-fuse。

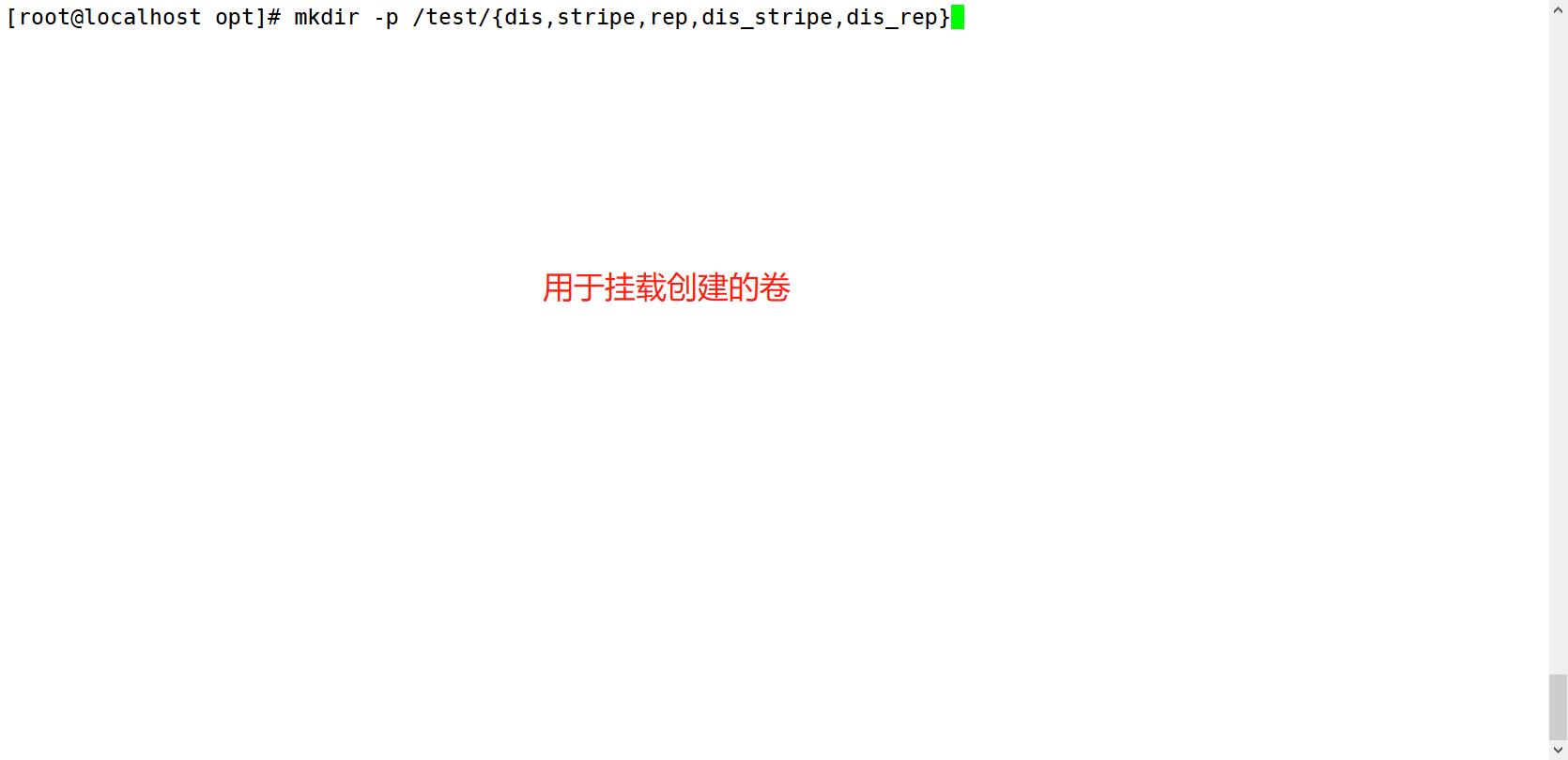

2.创建挂载目录

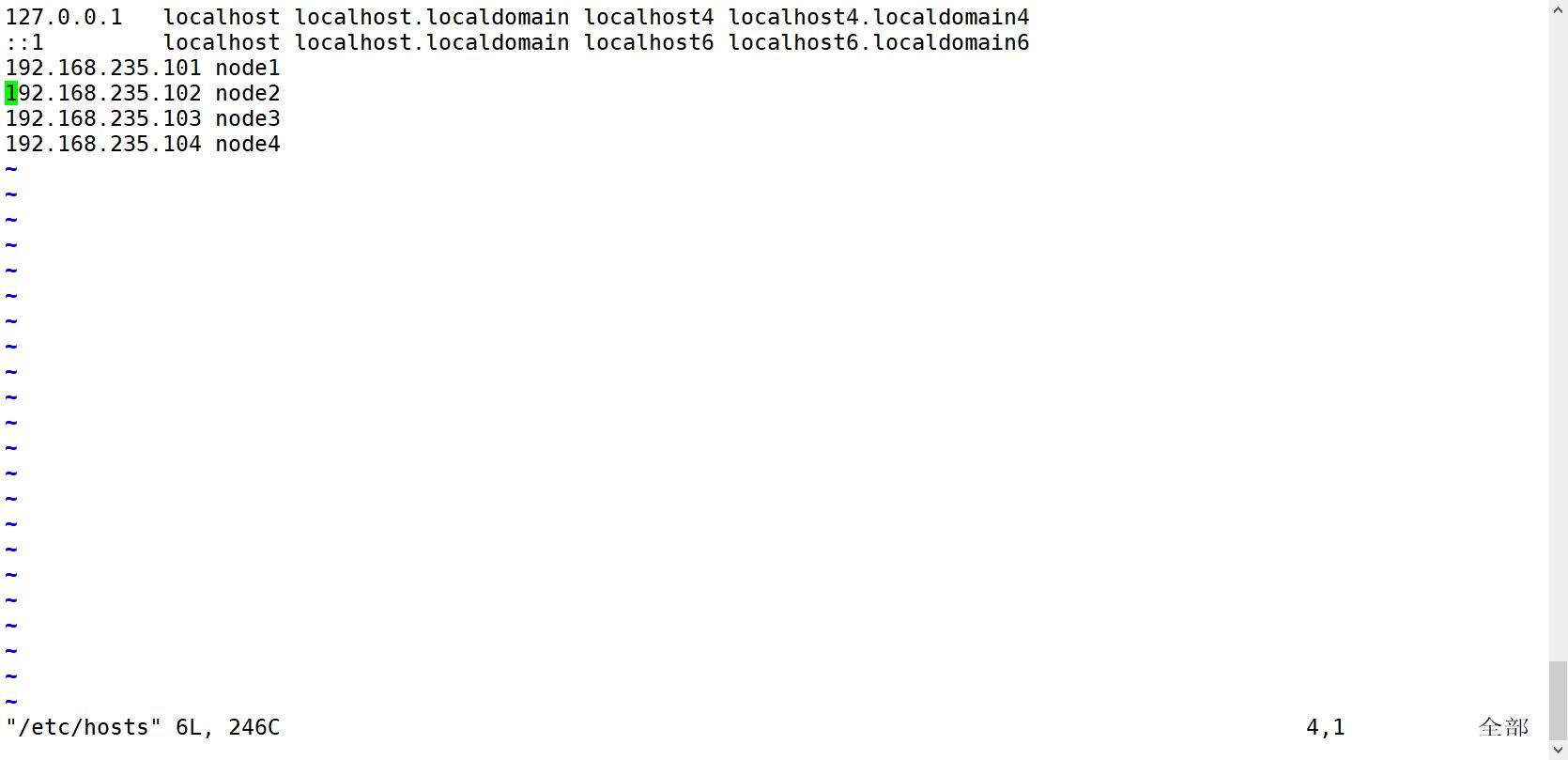

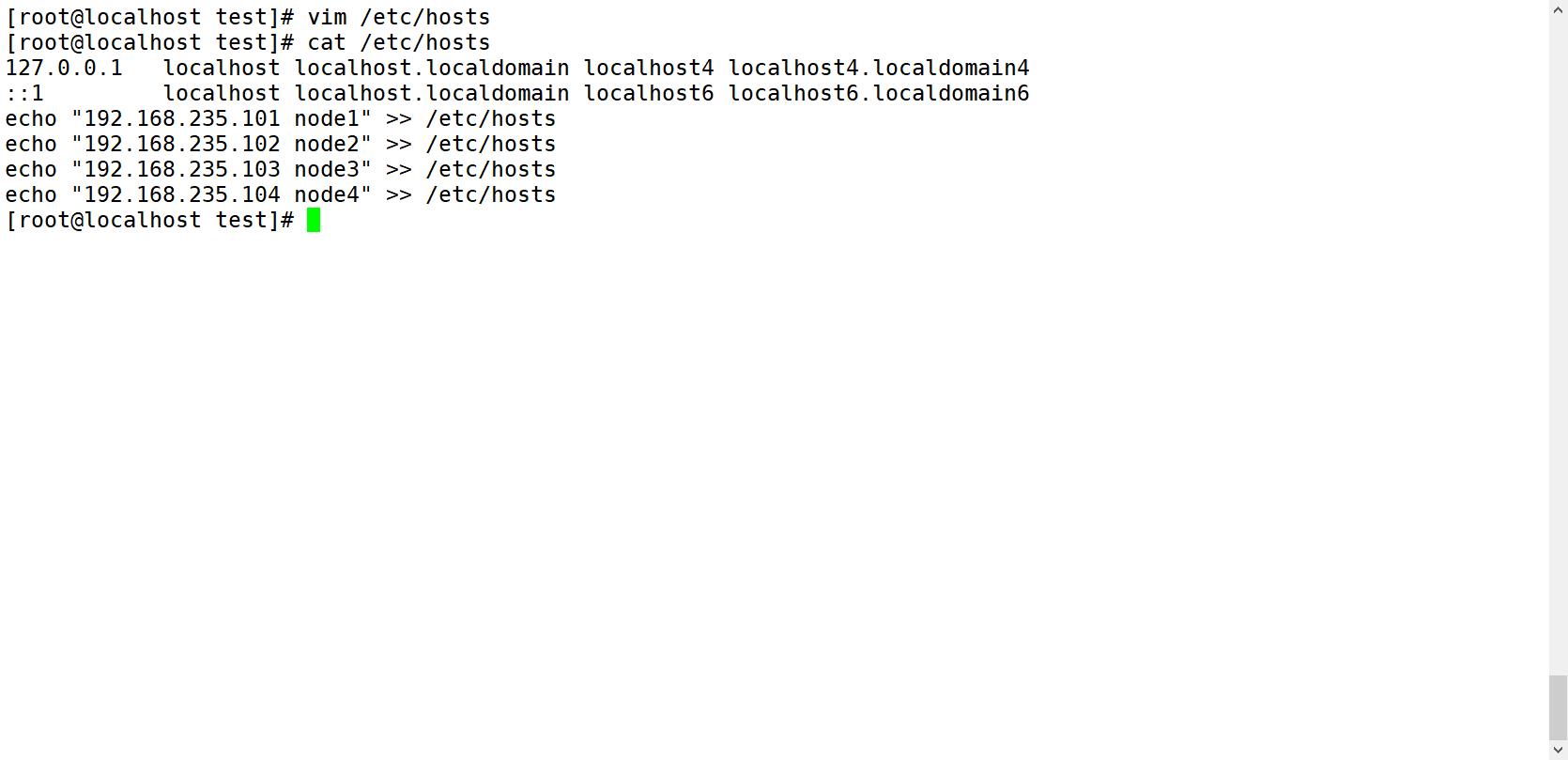

3.配置/etc/hosts文件

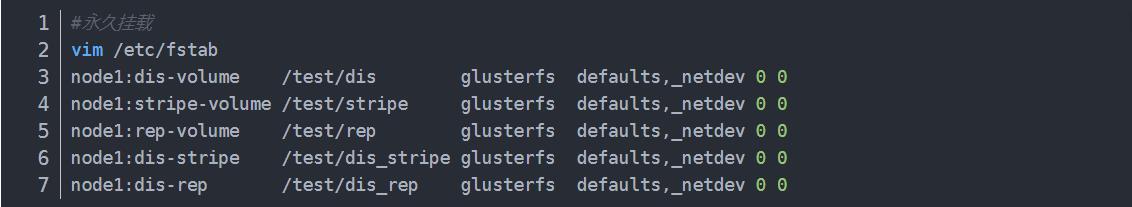

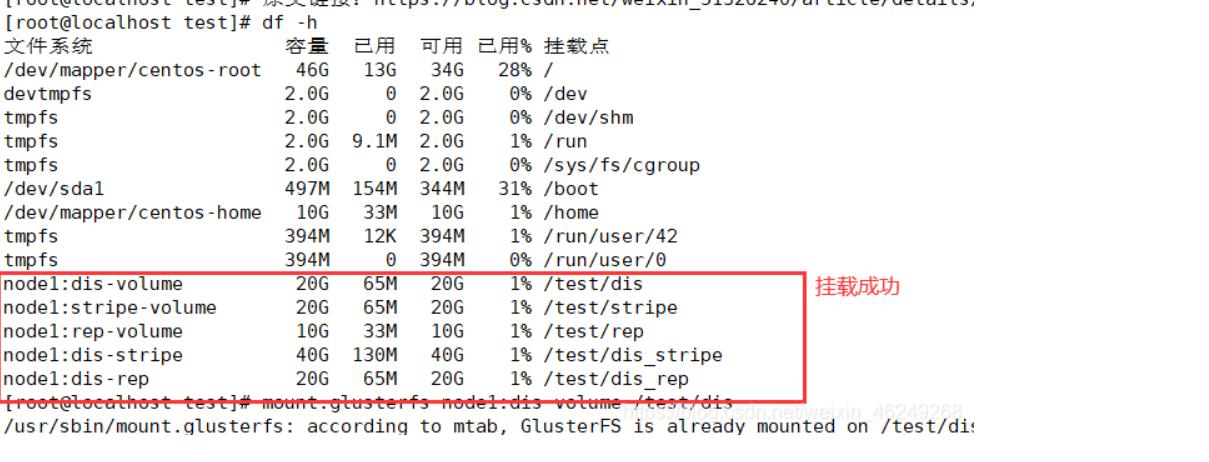

4.挂载Gluster文件系统

两种挂载方法

挂载完成以后,我们就可以在挂载目录里面写入内容,其内容就会根据挂载目录对应的卷的规则进行保存。

附:其他的维护命令

1.查看GlusterFS卷

gluster volume list

2.查看所有卷的信息

gluster volume info

3.查看所有卷的状态

gluster volume status

4.停止一个卷

gluster volume stop dis-stripe

5.删除一个卷。注意:删除卷时,需要先停止卷,且信任池中不能有主机处于宕机状态,否则删除不成功

gluster volume delete dis-stripe

6.设置卷的访问控制

gluster volume set dis-rep auth.allow 192.168.121.550

gluster volume set dis-rep auth.allow 192.168.80.*(#设置192.168.80.0网段的所有IP地址都能访问dis-rep卷(分布式复制卷))

以上是关于nodes had volume node affinity conflict的主要内容,如果未能解决你的问题,请参考以下文章

1 node(s) didn‘t match node selector, 2 node(s) didn‘t find available persistent volumes to bind.(代码