吴恩达《机器学习》课程总结神经网络表述

Posted ys99

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了吴恩达《机器学习》课程总结神经网络表述相关的知识,希望对你有一定的参考价值。

8.1非线性假设

(1)无论线性回归还是逻辑回归当特征量太多时,计算的负荷会非常大。如50x50像素有2500特征,如果两两组合将会有25002/2个(接近300万个特征)。普通的线性回归和逻辑回归模型不能有效处理这么多特征,这时候需要用神经网络了。

8.2神经元和大脑

大脑的某一块可以经过学习,学会其他功能,比如某一块感受触觉,但是接受视觉训练之后,能够感受视觉。

8.3模型表示1

(1)神经元有树突和轴突,许多树突接受电信号,一个轴突发送电信号。

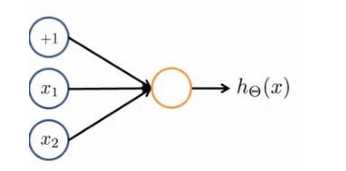

(2)根据神经元模型,创建逻辑回归模型:

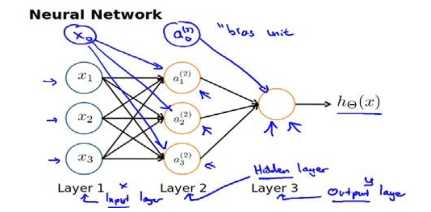

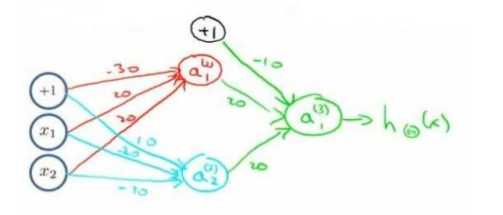

(3)多神经元、多层时,分别称为输入层,掩藏层,输出层:

8.4模型表示2

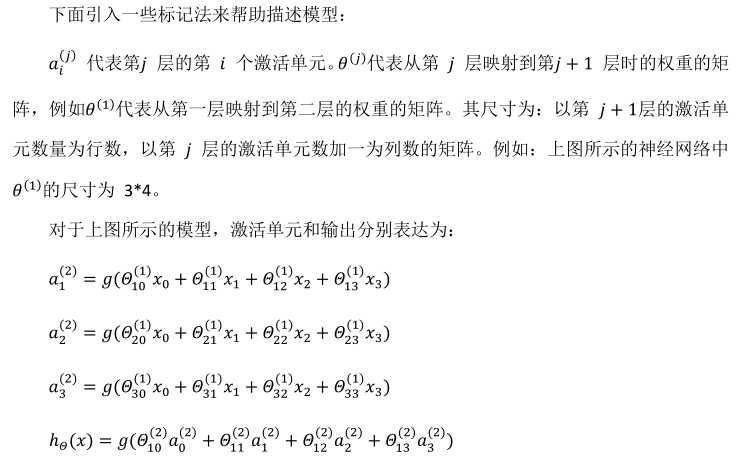

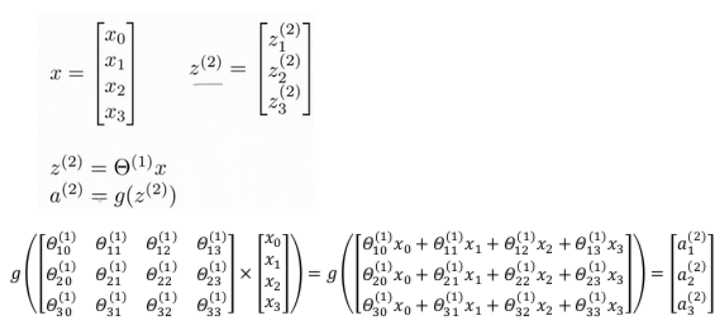

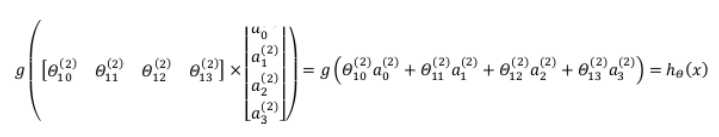

(1)向量表示比循环编码更高效:

以上只是针对一个训练实例,如果是整个训练集进行计算的话,需要将X进行转置,使得同一个实例在一列。

(2)神经网络比线性回归和逻辑回归更强大,在于前者将特征不断进行高级化。

8.5特征和直观理解1

(1)从本质上讲,神经网络能够通过学习得出其自身的一系列特征。

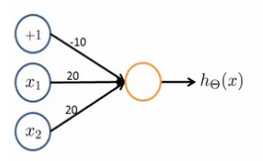

(2)逻辑与运算

其中θ为[-30,20,20]T.

(3)逻辑或运算

其中θ为[-10,20,20]T。

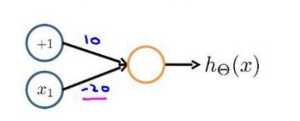

(4)非运算

8.6样本和直观理解II

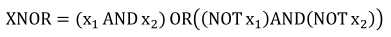

通过上一节的简单运算构造出复杂运算(同为1或者同为0时取1)

按照这种方法我们可以逐步构造出越来越复杂的函数,也能得到更加厉害的特征值。这就是神经网络厉害之处。

8.7多类分类

如要在一个图片中识别路人,汽车,摩托车,卡车四类,这是神经网络可以设置四个输出,每一个用1或0代表是否有某一类即可。

以上是关于吴恩达《机器学习》课程总结神经网络表述的主要内容,如果未能解决你的问题,请参考以下文章