hadoop集群搭建(Hadoop 3.1.3 /Hive 3.1.2/Spark 3.0.0)

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了hadoop集群搭建(Hadoop 3.1.3 /Hive 3.1.2/Spark 3.0.0)相关的知识,希望对你有一定的参考价值。

参考技术A 完全分布式HA服务器规划

技术栈包含

hdfs

hive on spark

presto

doris

superset

azkaban

kafka

fluent\flume

sqoop\kettle\flink-cdc

atlas

禁用swap/selinux

修改 IP/修改主机名/及主机名和 IP 地址的映射

时间同步/设置时区/自动时间同步

关闭防火墙

关闭SELINUX

新建用户

免密登录(先升级openssh)

发送密钥(dw01上执行)

授权

Tencent Kona v8.0.8-GA

腾讯开源的konaJDK,针对大数据场景下优化

解压并重命名至安装地址:/usr/local/java/

zookeeper-3.5.9

解压并重命名至安装地址:/usr/local/zookeeper

apache-hadoop-3.1.3 解压至安装地址:/usr/local/hadoop

修改环境变量

/usr/local/zookeeper/conf

启动zookeeper集群(每台执行)

三台服务器启动

格式化namenode(dw01执行)

启动namenode(dw01上执行)

在[nn2]和[nn3]上分别执行,同步 nn1 的元数据信息

启动nn2 nn3,分别执行

所有节点上启动datanode

将[nn1]切换为 Active

查看状态

配置yarn-site.xml

配置mapred-site.xml

分发配置文件,启动yarn(dw03 启动)

dw03节点

dw01节点

dw01执行

dw03执行

测试样例

启动脚本

HA切换namenode手动

修改yarn显示log的bug

大数据实战——hadoop集群安装搭建

前言

本节内容我们主要来介绍如何搭建hadoop集群,将hadoop的基础环境搭建完成,便于我们使用hadoop集群。在搭建hadoop集群搭建之前,我们需要先安装java环境,并且我们需要规划我们hadoop集群的组件分布,保证hadoop集群服务器能发挥其最大的价值。

hadoop集群组件分布如下:

| hadoop101 | hadoop102 | hadoop103 | |

|---|---|---|---|

| HDFS | NameNode DataNode | DataNode | SecondaryNameNode DataNode |

| YARN | NodeManager | ResourceManager NodeManager | NodeManager |

正文

- java环境安装

①上传java安装包到hadoop101服务器

②解压java安装包到/opt/module目录

命令:tar -zxvf jdk-8u212-linux-x64.tar.gz -C /opt/module/

③在/etc/profile.d目录下,新建环境变量配置文件my_env.sh

④在配置文件my_env.sh中添加java环境变量配置

#JAVA_HOME export JAVA_HOME=/opt/module/jdk1.8.0_212 export PATH=$PATH:$JAVA_HOME/bin

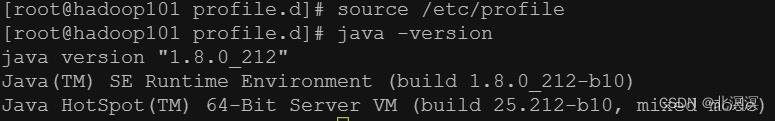

⑤让新的环境变量 PATH 生效,查看java环境配置是否生效

source /etc/profile

⑥分发java安装包到hadoop102和hadoop103服务器

hsync /opt/module/jdk1.8.0_212

⑦分发环境配置文件my_env.sh到hadoop102和hadoop103服务器

hsync /etc/profile.d/my_env.sh

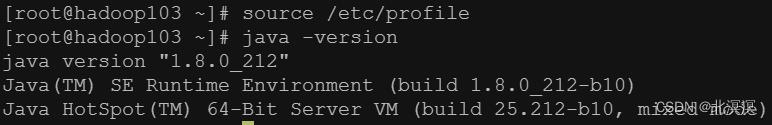

⑧分别在hadoop102与hadoop103上面执行source /etc/profile,查看java是否安装完成

- hadoop安装

①上传hadoop安装包到hadoop101服务器

② 解压hadoop安装包到/opt/module目录

命令:tar -zxvf hadoop-3.1.3.tar.gz -C /opt/module/

③获取hadoop安装目录/opt/module/hadoop-3.1.3

④在/etc/profile.d/my_env.sh环境变量配置文件中配置hadoop的环境变量

#HADOOP_HOME export HADOOP_HOME=/opt/module/hadoop-3.1.3 export PATH=$PATH:$HADOOP_HOME/bin export PATH=$PATH:$HADOOP_HOME/sbin

⑤使配置的环境变量生效,并查看hadoop的安装情况

source /etc/profile

⑥分发hadoop安装包到hadoop102和hadoop103服务器

命令:hsync /opt/module/hadoop-3.1.3/

⑦分发环境配置文件my_env.sh到hadoop102和hadoop103服务器

hsync /etc/profile.d/my_env.sh

⑧分别在hadoop102与hadoop103上面执行source /etc/profile,查看hadoop是否安装完成

结语

本节内容到这里就结束了,关于hadoop的组件运行及启动,由于篇幅所限,我们在下节内容中再详细介绍,后会有期。。。。。。

以上是关于hadoop集群搭建(Hadoop 3.1.3 /Hive 3.1.2/Spark 3.0.0)的主要内容,如果未能解决你的问题,请参考以下文章