Proxmox支持虚拟机和容器的虚拟化平台

Posted rayylee

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Proxmox支持虚拟机和容器的虚拟化平台相关的知识,希望对你有一定的参考价值。

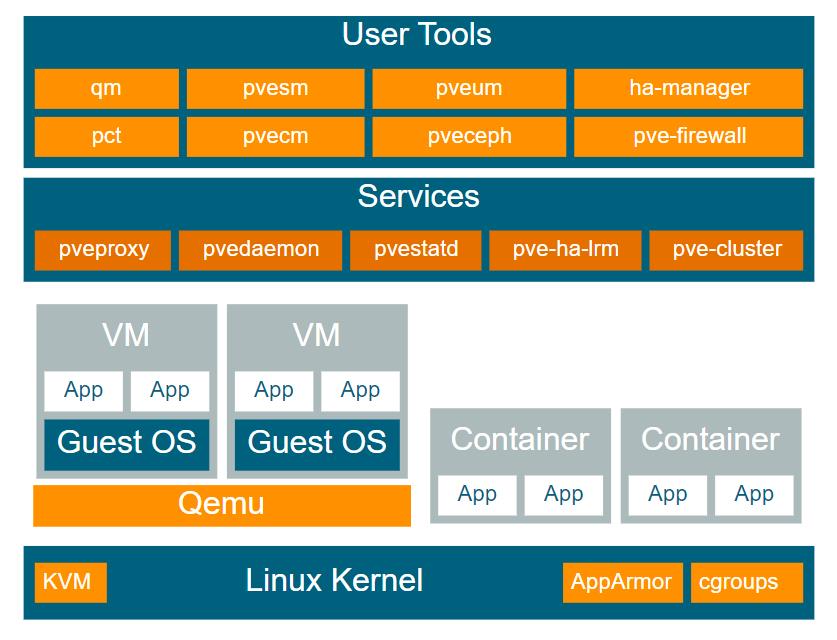

Proxmox VE是可以运行在虚拟机和容器的虚拟化平台。Proxmox VE基于 Debian Linux开发,并且完全开源。出于灵活性的考虑,Proxmox VE同时支持两种虚拟化 技术:KVM 虚拟机和 LXC 容器。

Proxmox VE的一个重要设计目标就是尽可能简化管理员的工作。用单机模式使用 Proxmox VE,也可以组建多节点 Proxmox VE集群。所有的管理工作都可以通过基于 web 页面的管理界面完成,即使是一个小白用户也可以在几分钟内上手安装使用 Proxmox VE。

Proxmox VE可以横向扩展为一个拥有大量节点的集群。Proxmox VE的默认安装方式中就已经包含了全套的集群套件。内嵌的WebGUI 管理控制台可以让你纵览所有的 KVM 虚拟机、LXC 容器和整个集群。可以通过 WebGUI 轻松管理你的虚拟机、容器、存储和集群。完全没有必要另外安装单独 的管理服务器。

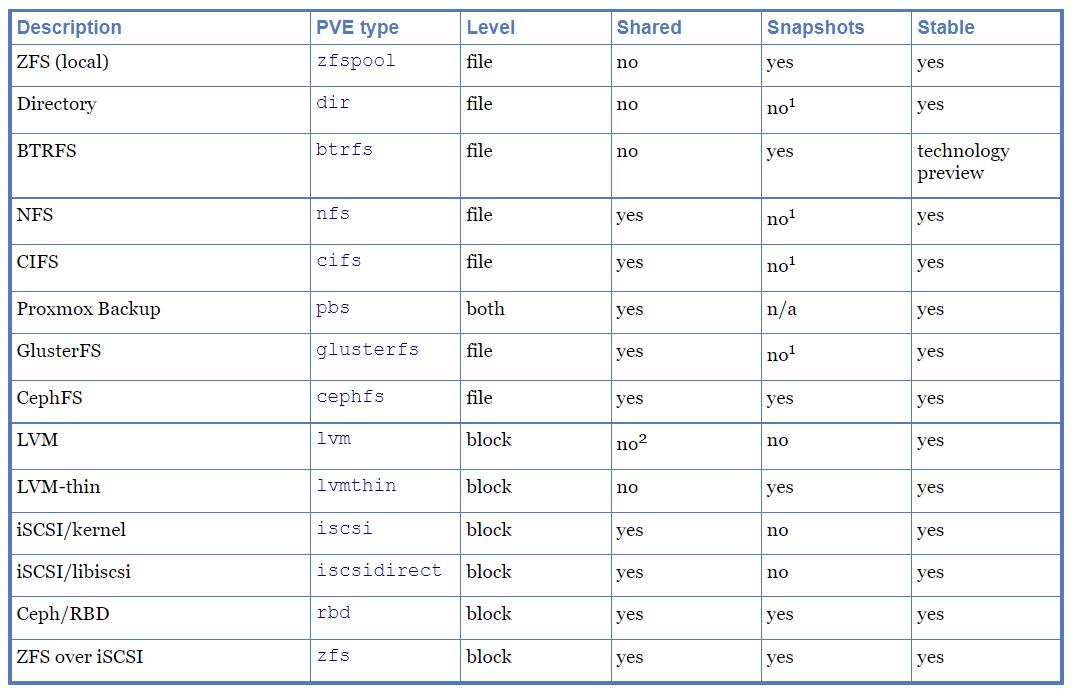

Proxmox VE支持多种存储技术。虚拟机镜像既可以保存在服务器本地存储,也可以保存在基于 NFS 或 SAN 的共享存储设备上。实际上,Debian Linux 支持的所有类型的存储技术都可以用于 Proxmox VE。用共享存储来保存虚拟机镜像有一个很大的好处,那就是 Proxmox VE 集群中的所有节点都 可以直接访问到该虚拟机镜像,虚拟机就可以从一个 Proxmox VE 节点在线迁移到其他节点 运行,并且虚拟机在迁移过程中可以保持连续运行,无需关机。

Proxmox VE目前支持的网络共享存储类型如下:

- LVM 卷组(基于 iSCSI 网络存储)

- iSCSI 网络存储设备

- NFS 共享存储

- CIFS 共享存储

- Ceph RBD

- iSCSI 卷

- GlusterFS

Proxmox VE服务器管理

多节点 Proxmox VE HA 集群支持用户自定义配置高可用的虚拟机。Proxmox VE HA 集群基 于久经考验的 Linux HA 技术,能够提供稳定可靠的 HA 服务。

多网口绑定(也称为网卡组或链路聚合)是一种将多个网卡绑定成单个网络设备的技术。利 用该技术可以实现某个或多个目标,例如提高网络链路容错能力,增加网络通信性能等。链路聚合技术可以有效减少虚拟机在线迁移的时延,并提高 Proxmox VE 集群服务器节点之 间的数据复制速度。目前一共有 7 种网口绑定模式:

- 轮询模式(blance-rr)

网络数据包将按顺序从绑定的第一个网卡到最后一个网卡 轮流发送。这种模式可以同时实现负载均衡和链路容错效果。 - 主备模式(active-backup)

该模式下网卡组中只有一个网卡活动。只有当活动的 网卡故障时,其他网卡才会启动并接替该网卡的工作。整个网卡组使用其中一块网 卡的 MAC 地址作为对外通信的 MAC 地址,以避免网络交换机产生混乱。这种模式 仅能实现链路容错效果。 - 异或模式(balance-xor)

网络数据包按照异或策略在网卡组中选择一个网卡发送 ([源 MAC 地址 XOR 目标 MAC 地址] MOD 网卡组中网卡数量)。对于同一个目 标 MAC 地址,该模式每次都选择使用相同网卡通信。该模式能同时实现负载均衡 和链路容错效果。 - 广播模式(broadcast)

网络数据包会同时通过网卡组中所有网卡发送。该模式能 实现链路容错效果。 - IEEE 802.3ad 动态链路聚合模式(802.3ad)(LACP)

该模式会创建多个速度和 双工配置一致的聚合组。并根据 802.3ad 标准在活动聚合组中使用所有网卡进行通信。 - 自适应传输负载均衡模式(balance-tlb)

该 Linux 网卡绑定模式无须交换机支持 即可配置使用。根据当前每块网卡的负载情况(根据链路速度计算的相对值),流 出的网络数据包流量会自动进行均衡。流入的网络流量将由当前指定的一块网卡接 收。如果接收流入流量的网卡故障,会自动重新指定一块网卡接收网络数据包,但 该网卡仍沿用之前故障网卡的 MAC 地址。 - 自适应负载均衡模式(均衡的 IEEE 802.3ad 动态链路聚合模式(802.3ad) (LACP):-alb)

该模式是在 blance-tlb 模式的基础上结合了 IPV4 网络流量接收 负载均衡(rlb)特性,并且无须网络交换机的专门支持即可配置使用。网络流量接收负载均衡基于 ARP 协商实现。网卡组驱动将自动截获本机的 ARP 应答报文,并 使用网卡组中其中一块网卡的 MAC 地址覆盖 ARP 报文中应答的源 MAC 地址,从而 达到不同的网络通信对端和本机不同 MAC 地址通信的效果。

在网络交换机支持 LACP(IEEE 802.3ad)协议的情况下,推荐使用 LACP 绑定模式(802.3ad), 其他情况建议使用 active-backup 模式。

对于Proxmox 集群网络的网卡绑定,目前仅支持 active-backup 模式,其他模式均不支持。下面所列的网卡绑定配置示例可用于分布式/共享存储网络配置。其主要优势是能达到更高 的传输速度,同时实现网络链路容错的效果。

基于Proxmox VE 的Ceph服务

Proxmox VE 统一了计算和存储功能。集群的物理节点既可以同时用于计算(运行虚拟机和 容器)和多副本存储。传统的计算资源和存储资源管理功能可以由统一的超融合应用实现, 无需再部署专用存储网络设备(SANs)和网络存储设备(NAS)。通过集成开源软件定义 存储平台 Ceph,Proxmox VE 能够直接在虚拟机服务器节点上运行和管理 Ceph 存储。

对于中小规模部署场景,可以直接将 Ceph 安装到 Proxmox VE 服务器,以实现 RADOS 块 设备(RBD)功能。。当前主流硬件拥有 足够强大的 CPU 和内存资源,能够满足在同一节点同时运行虚拟机和存储服务的需要。为简化管理,Proxmox VE 提供了 pveceph 工具来安装管理Ceph服务。

Proxmox集群文件系统(pmxcfs)

Proxmox 集群文件系统是一个数据库驱动的文件系统,用于保存配置文件,并利用 corosync 在集群节点间实现配置文件的实时同步。我们利用这个文件系统来管理 PVE 的配置文件。该文件系统一方面将所有数据保存在磁盘上的一个数据库文件中,同时在内存中保存了一个 拷贝。该设计引入了文件系统总容量的上限,目前该上限为 30MB,但仍然足以保存几千台 虚拟机的配置信息。

Proxmox VE存储

Proxmox VE提供了非常灵活的存储配置模型。虚拟机镜像既可以保存在一种或多种服务器 本地存储上,也可以保存在多种共享存储上,例如 NFS 或 iSCSI(NAS,SAN)。你可以自 由地配置多种存储池,想配多少就配多少,完全没有任何限制。事实上,Debian Linux 支持 的所有存储技术都可以拿过来用。

Qemu/KVM虚拟机

Qemu(Qemu 模拟器的简称)是一个开源的虚拟机管理软件,主要功能是模拟物理计算机。在运行 Qemu 的主机看来,Qemu 就是一个普通的用户进程,将主机拥有的硬盘分区、文 件、网卡等本地资源虚拟成物理硬件设备并映射给模拟计算机使用。

模拟计算机的操作系统访问这些虚拟硬件时,就好像在访问真正的物理硬件设备一样。例如, 当设置 Qemu参数向模拟计算机映射一个 ISO 镜像时,模拟计算机的操作系统就会看到 一个插在CD驱动器里的CDROM光盘。Qemu 能够模拟包括从 ARM 到 sparc 在内的一大批硬件设备,但 Proxmox VE仅仅使用了其 中的 32 位和 64 位 PC 平台模拟硬件,而这也是当前绝大部分服务器所使用的硬件环境。

此外,借助 CPU 的虚拟化扩展功能,Qemu 模拟相同架构硬件环境的速度可以被大大提高, 虚拟 PC 硬件也是当前 Qemu 支持的运行速度最快的虚拟硬件环境。

以上是关于Proxmox支持虚拟机和容器的虚拟化平台的主要内容,如果未能解决你的问题,请参考以下文章