ELK日志分析平台之Elasticsearch

Posted S4061222

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了ELK日志分析平台之Elasticsearch相关的知识,希望对你有一定的参考价值。

目录

elasticsearch简介

- Elasticsearch 是一个开源的分布式搜索分析引擎,建立在一个全文搜索引擎库 Apache Lucene基础之上。

- Elasticsearch 不仅仅是 Lucene,并且也不仅仅只是一个全文搜索引擎:

- 一个分布式的实时文档存储,每个字段 可以被索引与搜索

- 一个分布式实时分析搜索引擎

- 能胜任上百个服务节点的扩展,并支持 PB 级别的结构化或者非结构化数据

-

基础模块

cluster:管理集群状态,维护集群层面的配置信息。

alloction:封装了分片分配相关的功能和策略。

discovery:发现集群中的节点,以及选举主节点。

gateway:对收到master广播下来的集群状态数据的持久化存储。

indices:管理全局级的索引设置。

http:允许通过JSON over HTTP的方式访问ES的API。

transport:用于集群内节点之间的内部通信。

engine:封装了对Lucene的操作及translog的调用。 -

elasticsearch

应用场景:

信息检索

日志分析

业务数据分析

数据库加速

运维指标监控

官网:https://www.elastic.co/cn/

一 ES安装与集群部署

1 单节点elasticsearch安装

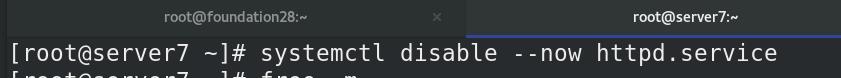

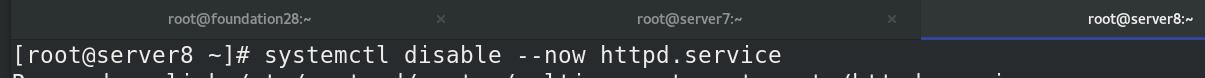

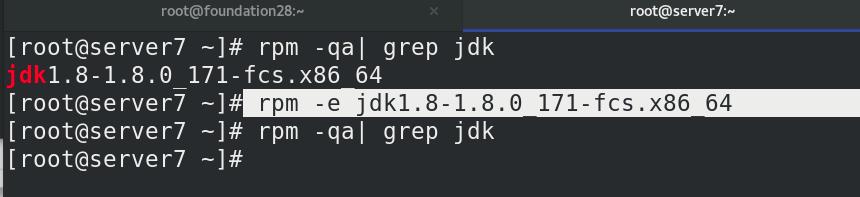

清理实验环境:

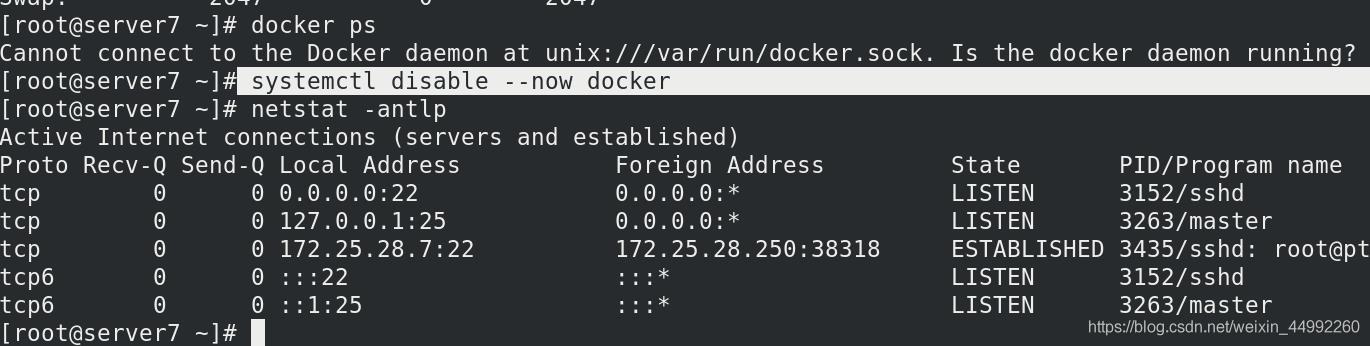

ELK对应三个软件,注意版本匹配(7.6.1,自带jdk),需要提前删除之前安装的 jdk

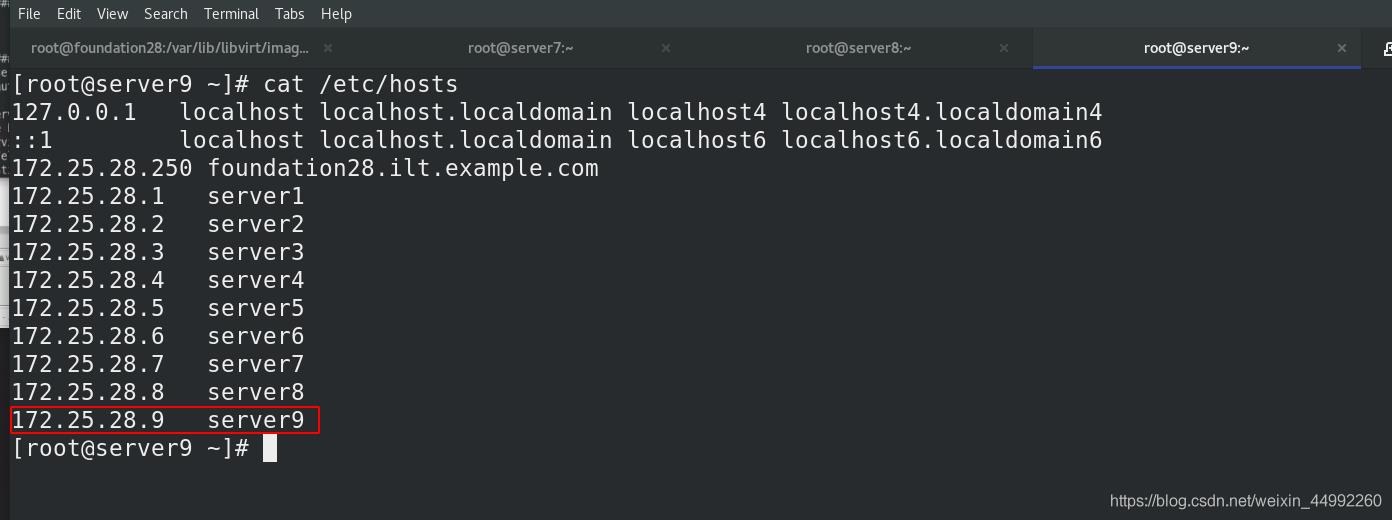

所有主机添加解析

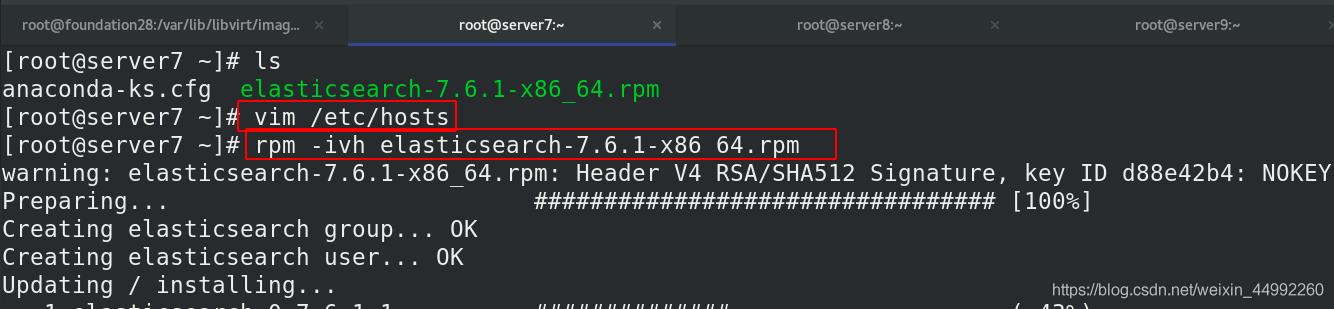

server7主机中安装与配置elasticsearch

server7给予2G内存

安装软件,7.6版本自带jdk,无需再次安装下载jdk

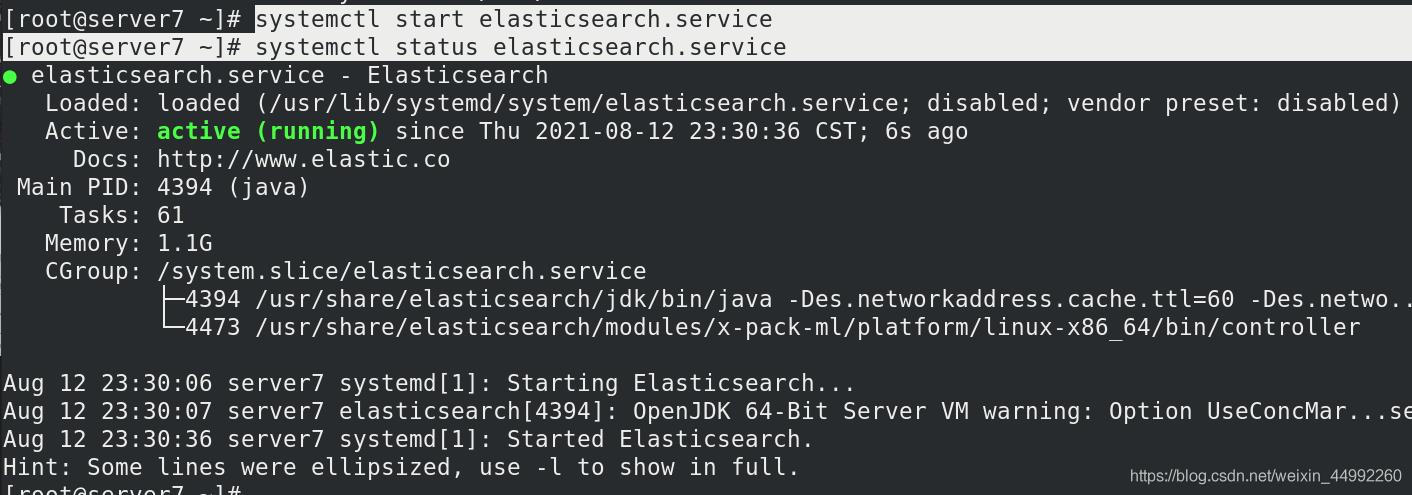

设置服务自启

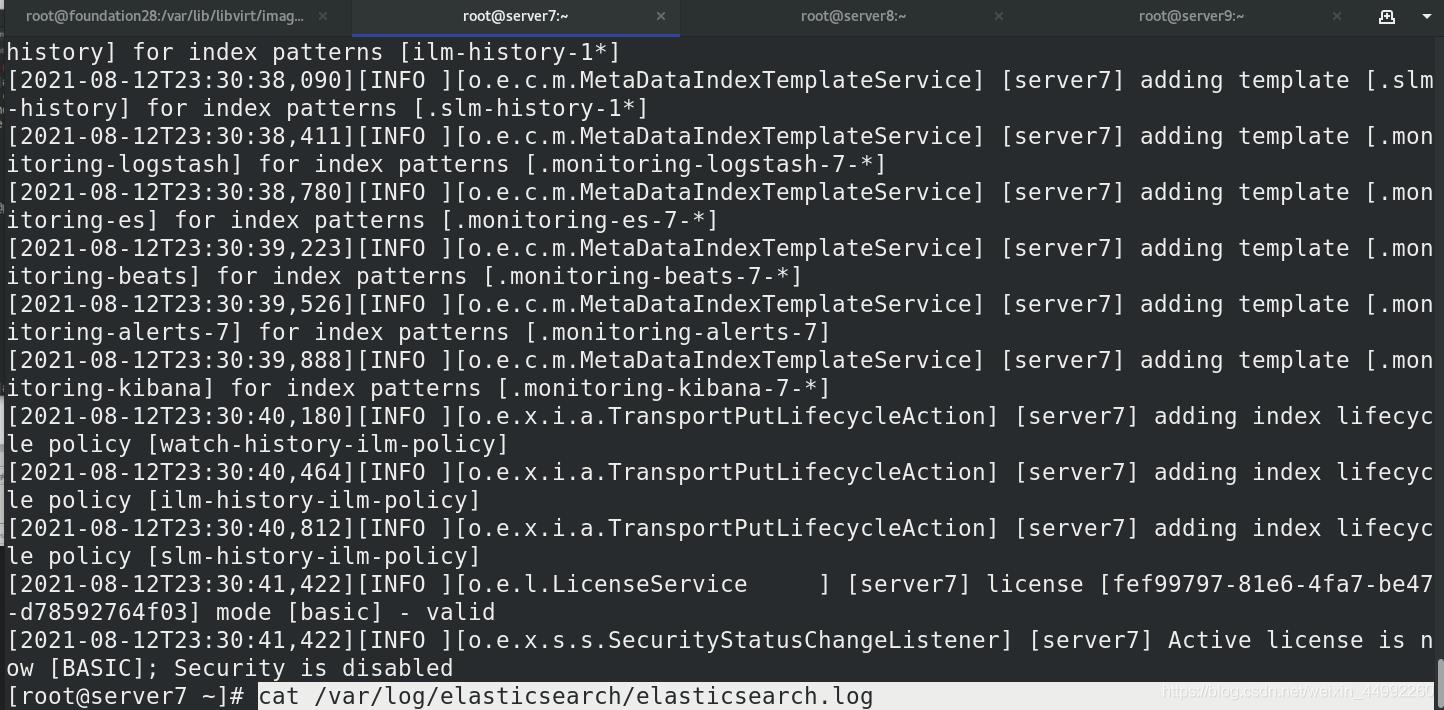

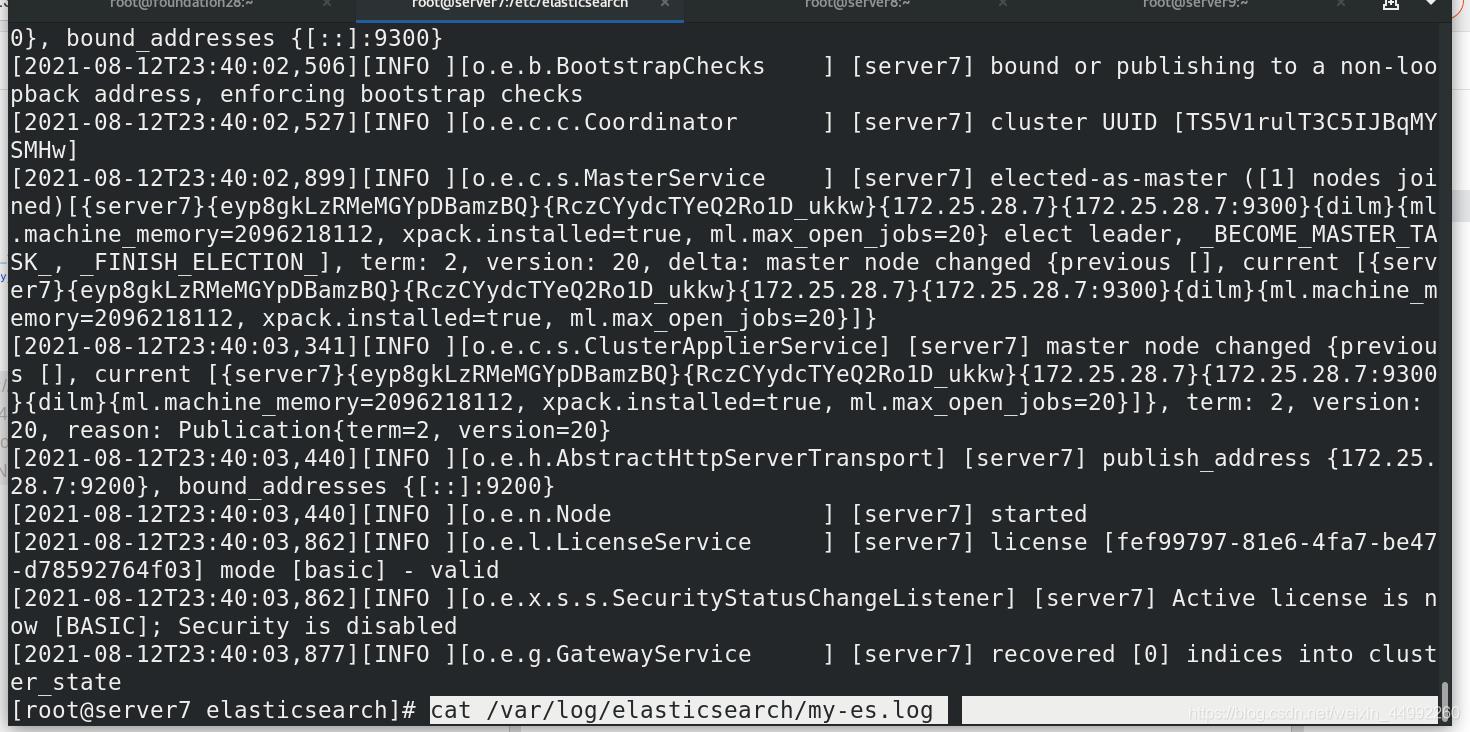

查看日志

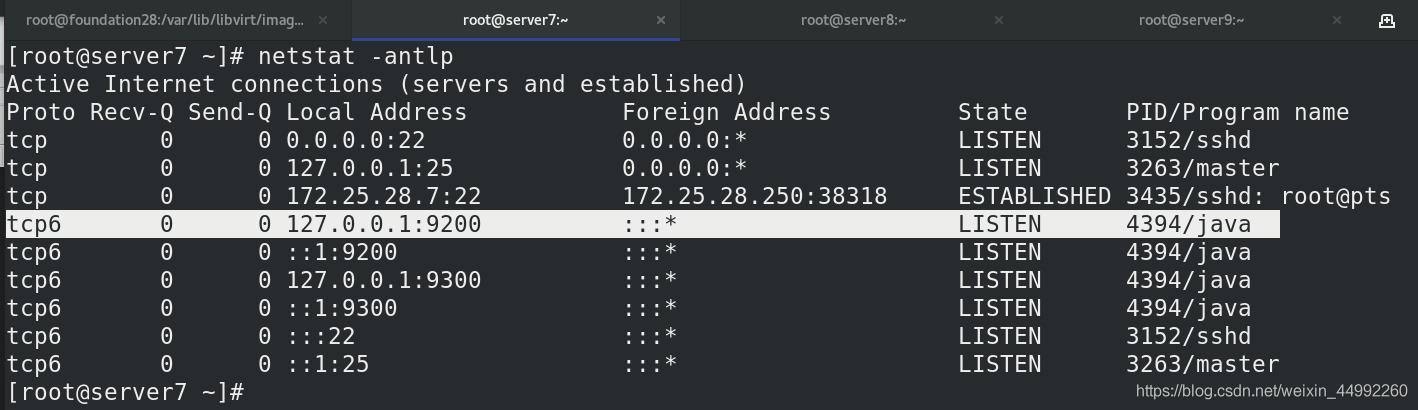

查看elasticsearch的端口:9200

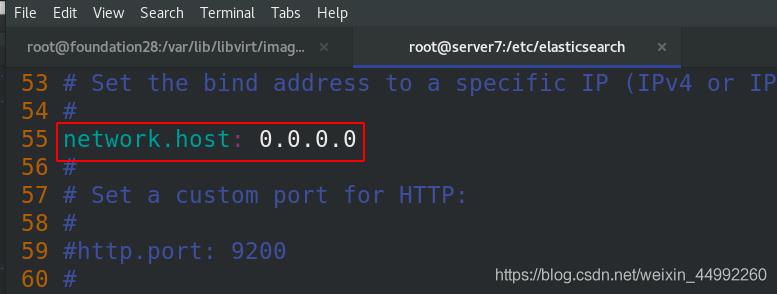

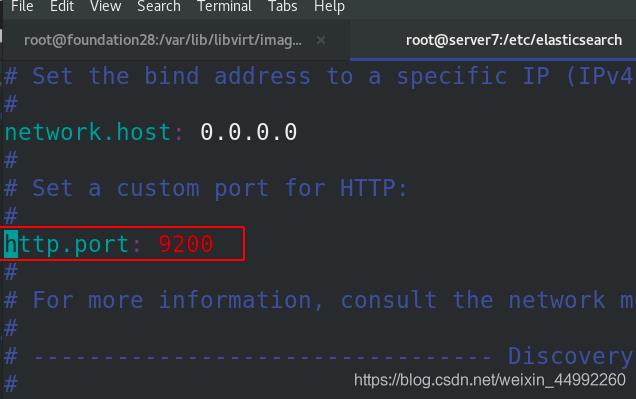

编辑elasticsearch.yaml文件,使全部网段都可访问

cat jvm.options

-Xms1g

-Xmx1g

Xmx设置不超过物理RAM的50%,以确保有足够的物理RAM留给内核文件系统缓存。但不要超过32G。

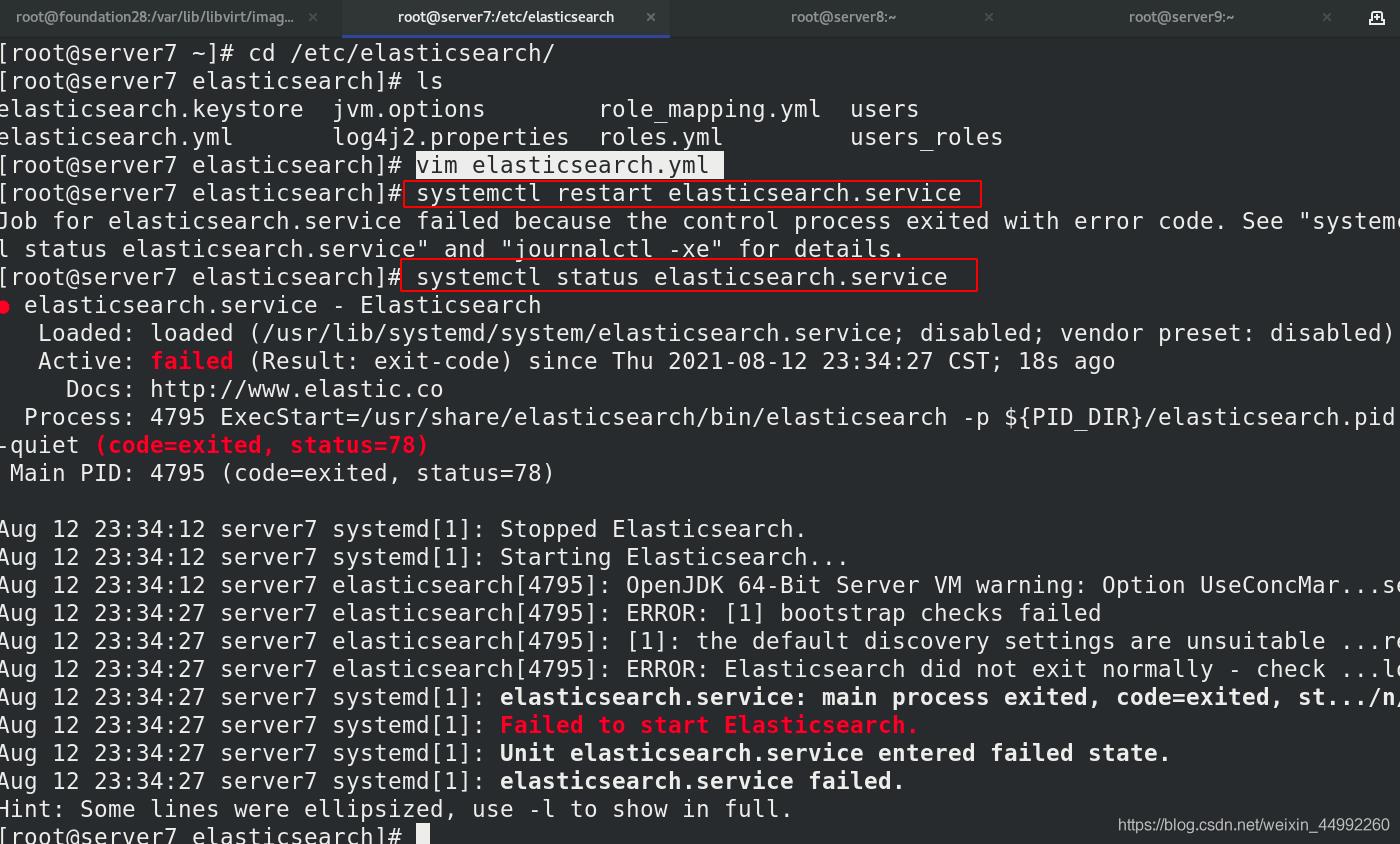

重启elasticsearch失败

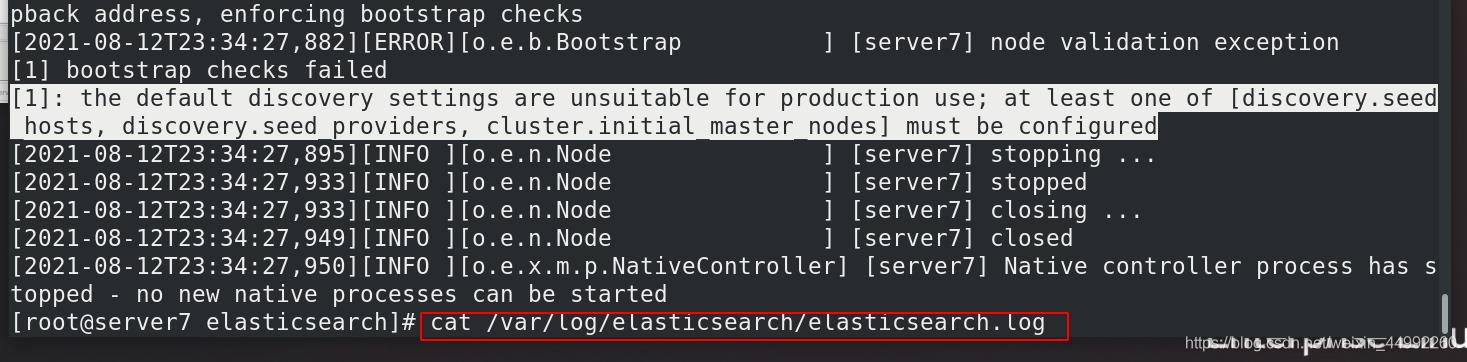

查看日志:

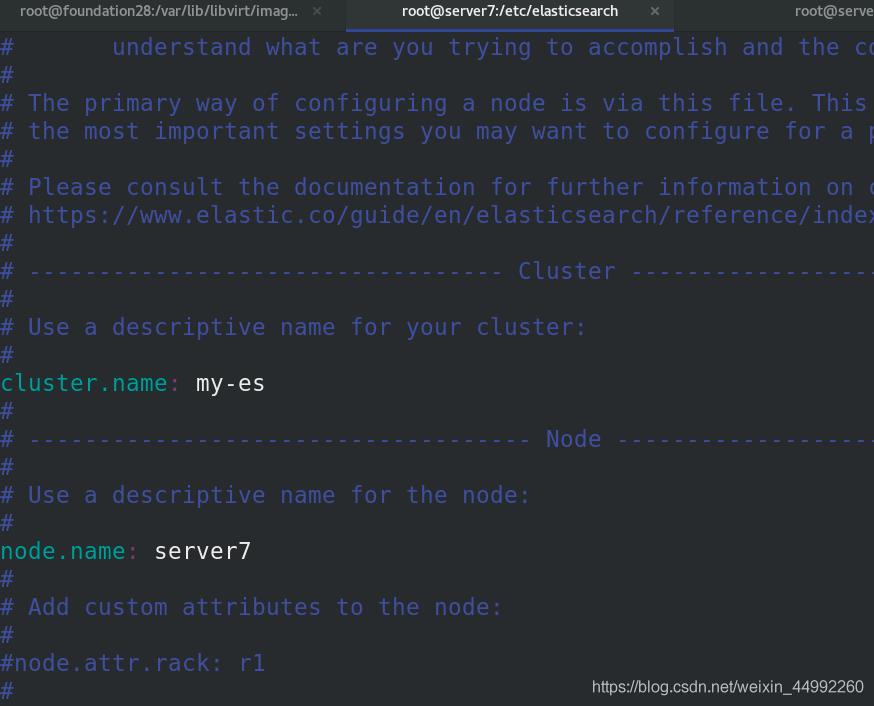

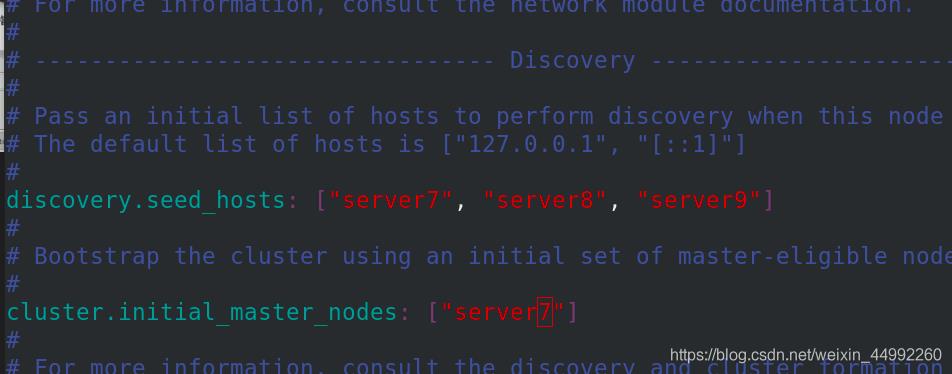

继续编辑elasticsearch.yaml文件,集群名称:my-es,节点设定

索死1G内存的话需要修改系统限制 (/etc/security/limits.conf) 修改systemd启动文件(/usr/lib/systemd/system/elasticsearch.service),重启systemctl daemon-reload

!!!此处没有设定锁死 bootstrap.memory_lock: true #锁定内存分配 ,没有打开

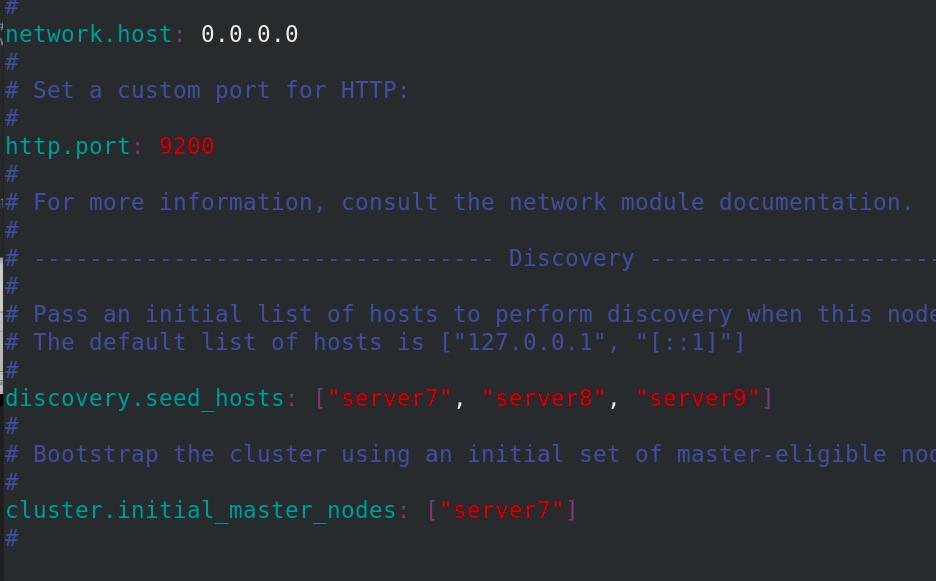

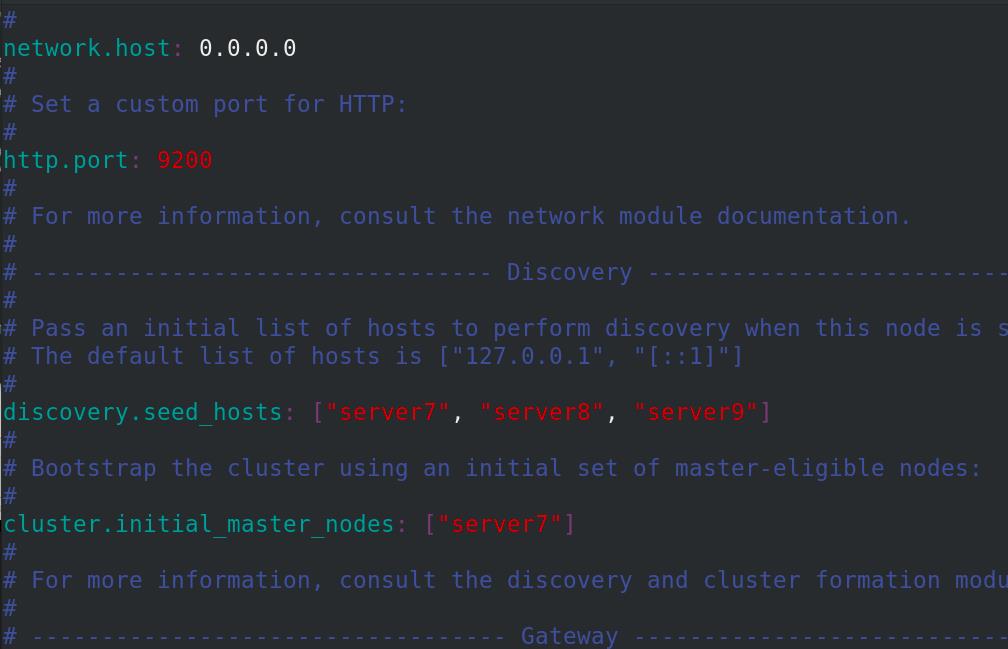

三台主机都设定,指向server7主机

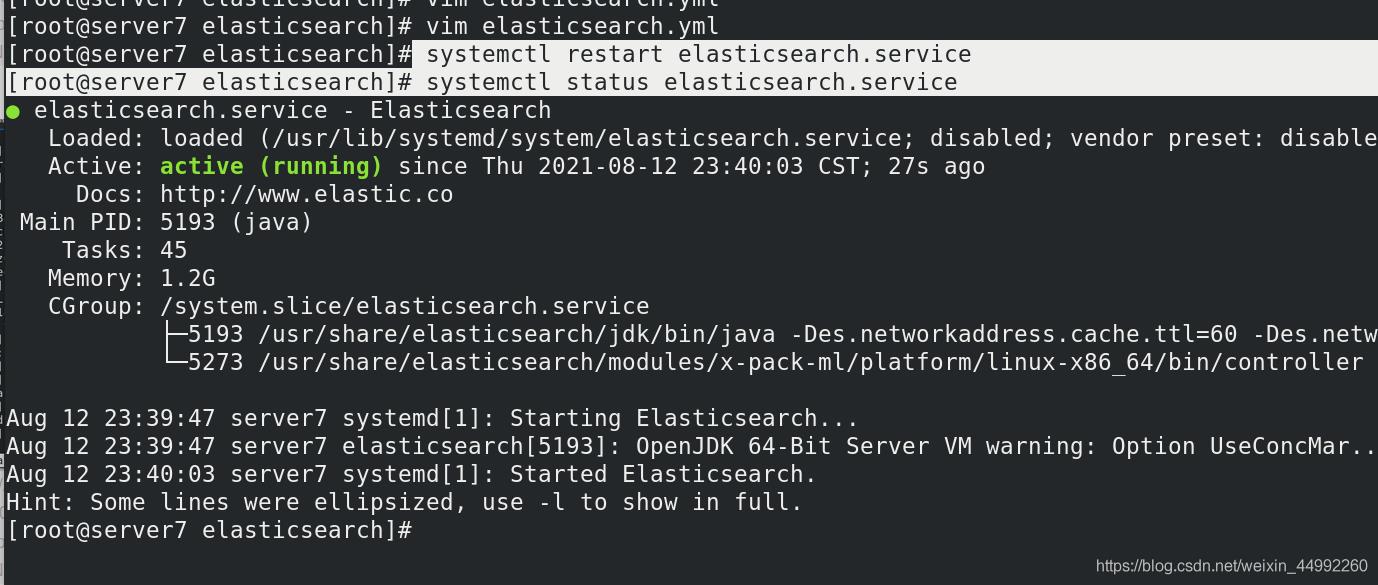

重启服务成功

查看日志,注意查看日志的名称已改变:my-es.log

测试:

外部访问成功

此处禁用swap分区:实验效果更加流畅,如果内存不够,可以不用禁止

2 搭建elasticsearch集群

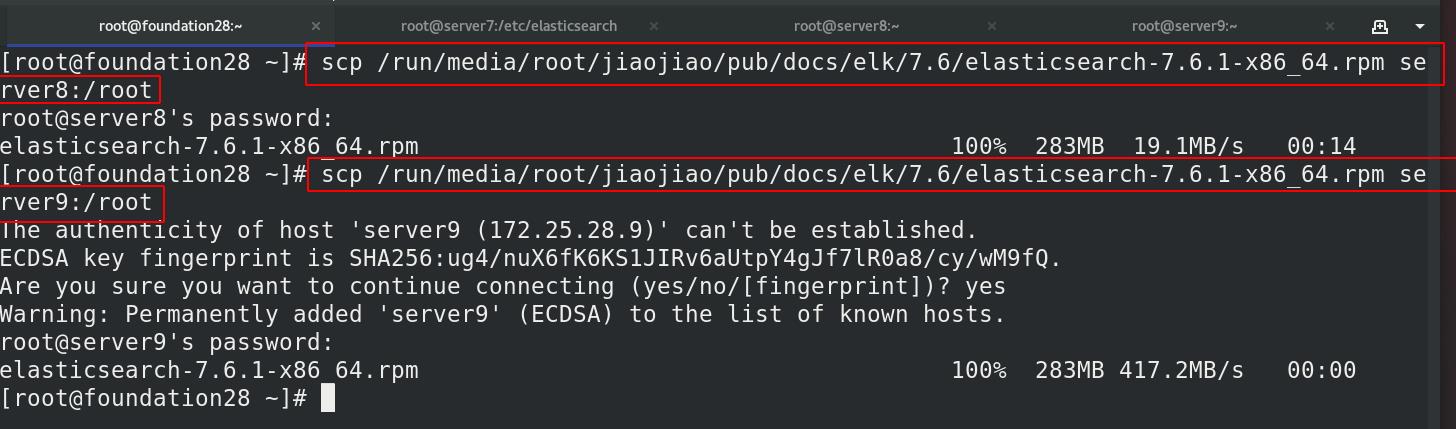

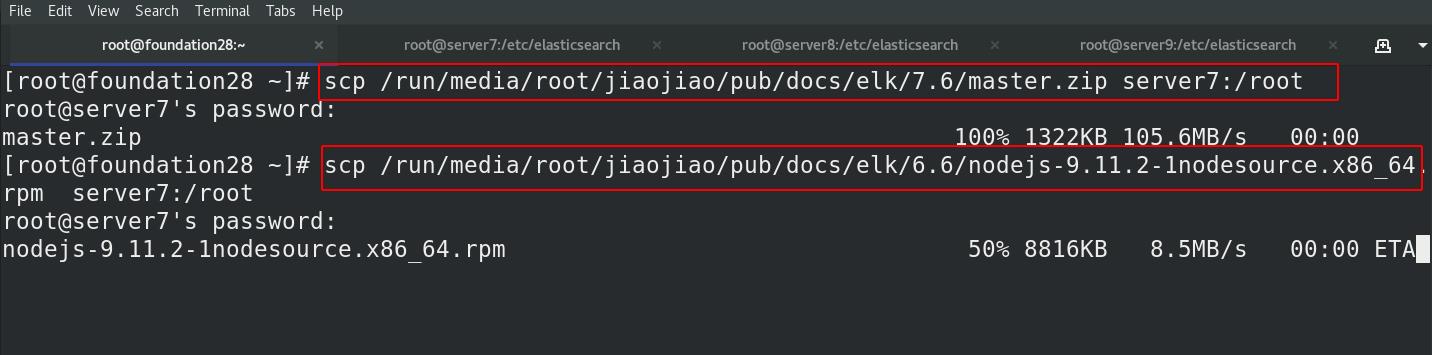

复制elasticsearch的安装包给server9和server8

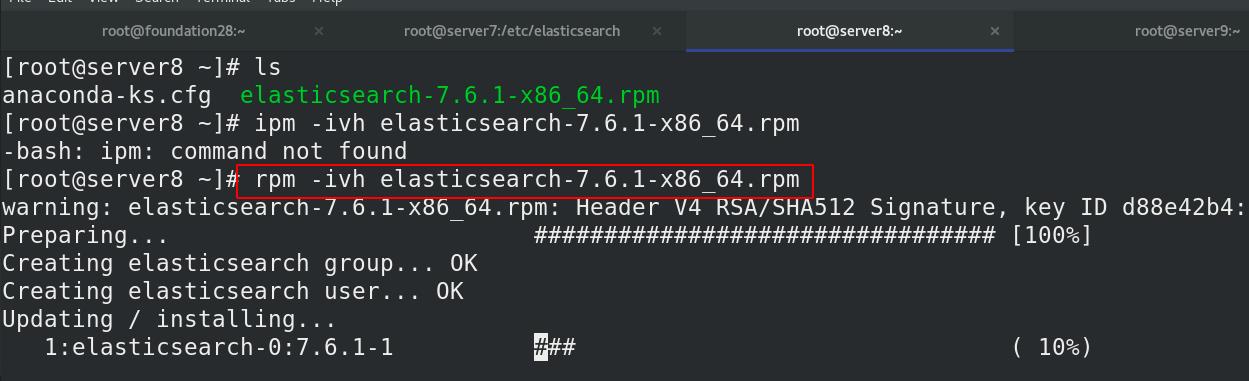

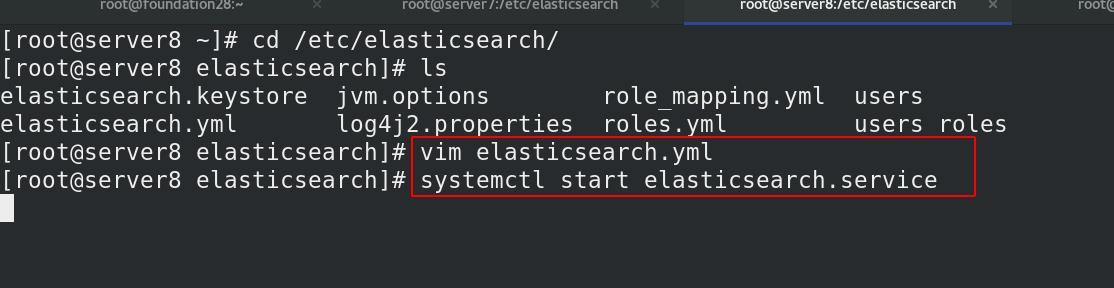

server8安装elasticsearch

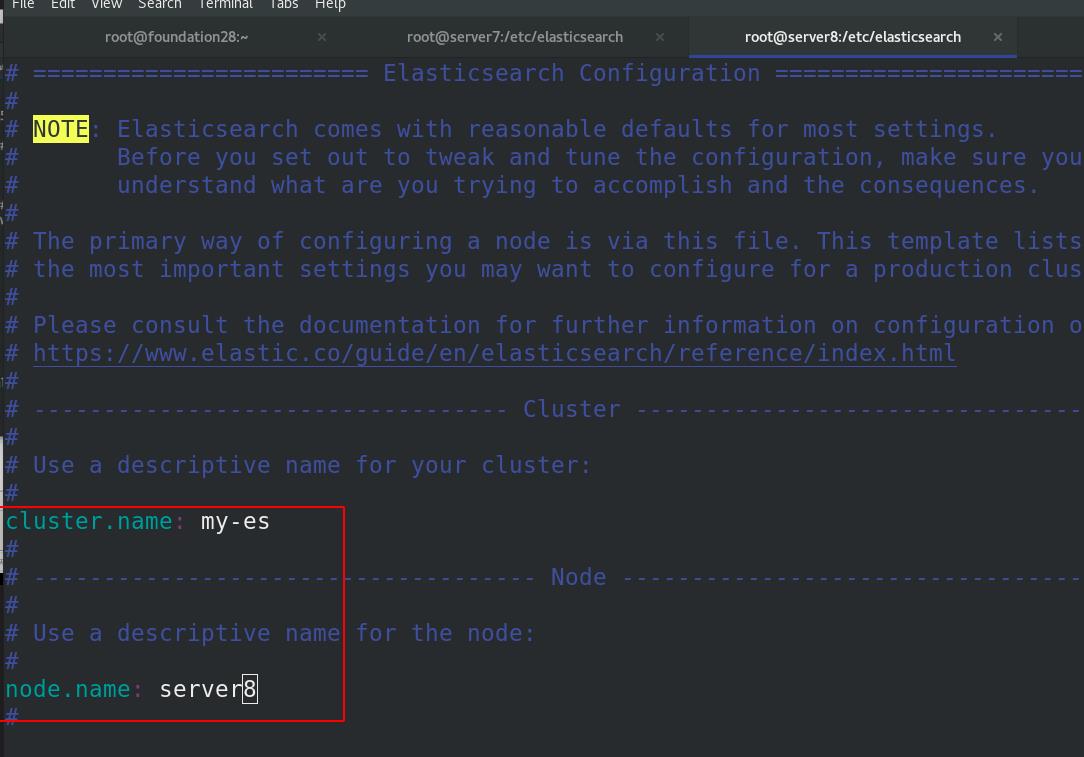

server8修改elasticsearch配置文件

server8重启服务

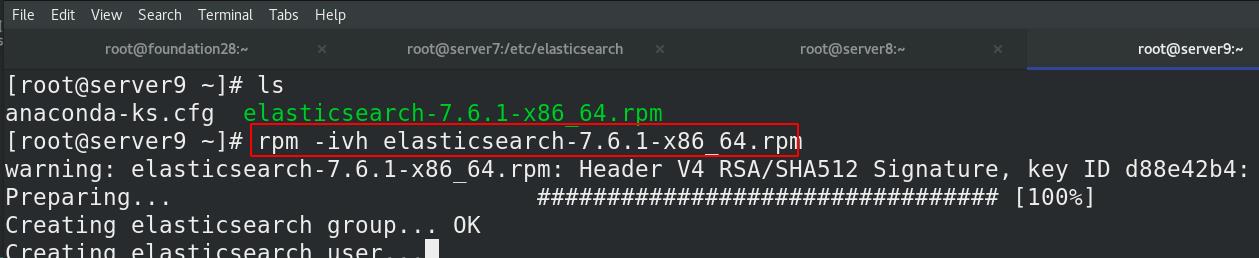

server9安装elasticsearch

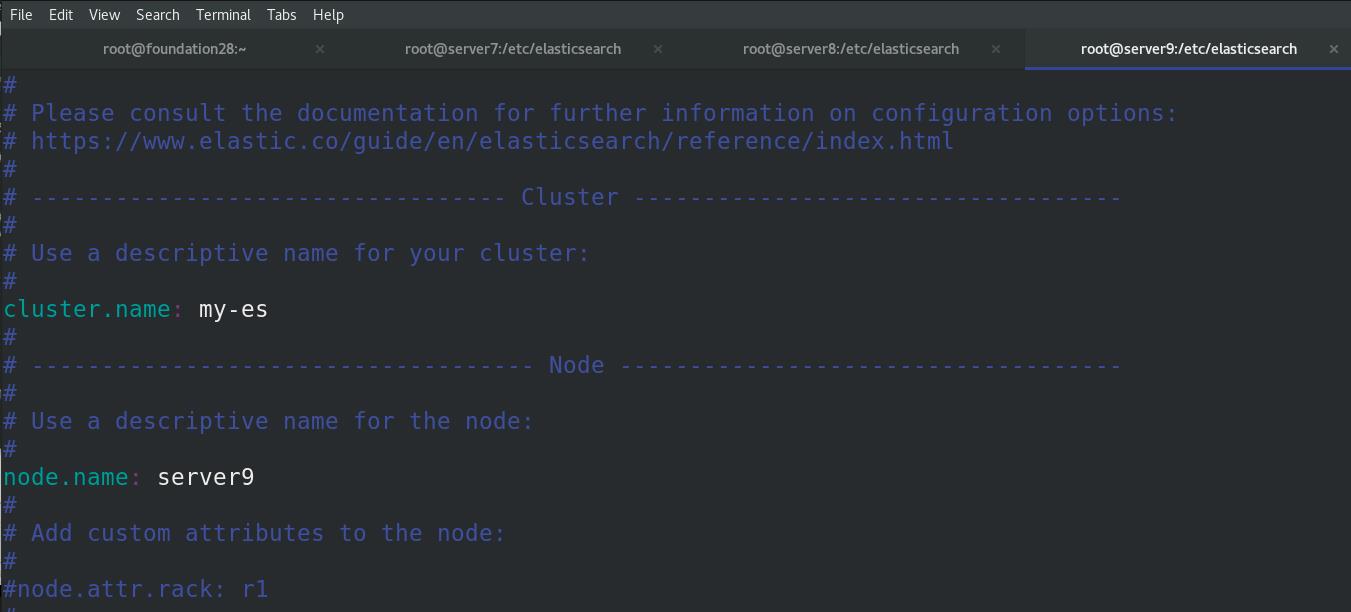

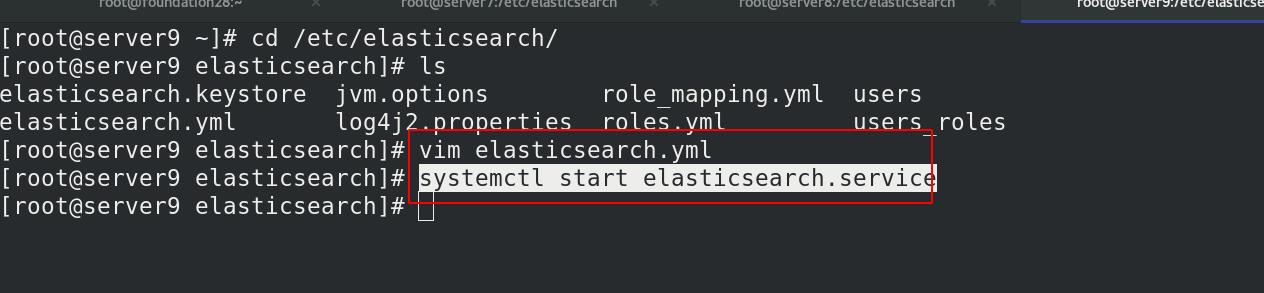

server9修改elasticsearch配置文件

server9重启服务

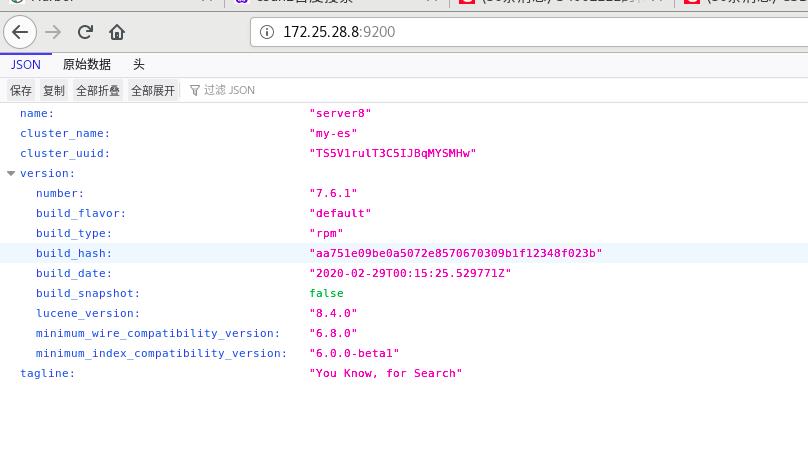

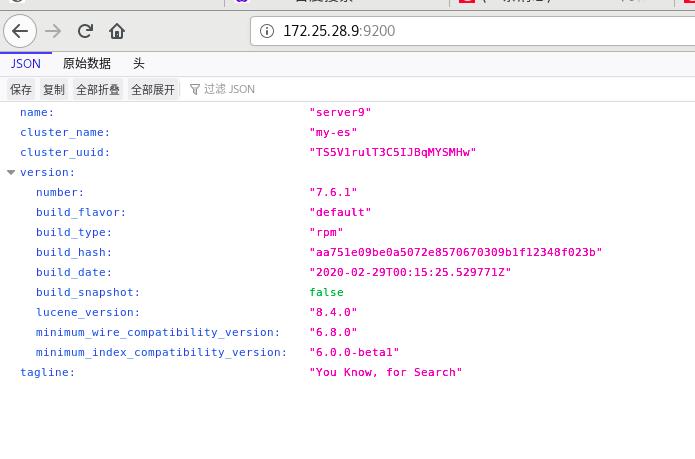

测试:

外部访问server8和server9

二 elasticsearch集群监控–可视化

1 elasticsearch-head插件

elasticsearch-head是elasticsearch自带插件

下载elasticsearch-head插件, head插件本质上是一个nodejs的工程,因此需要安装node

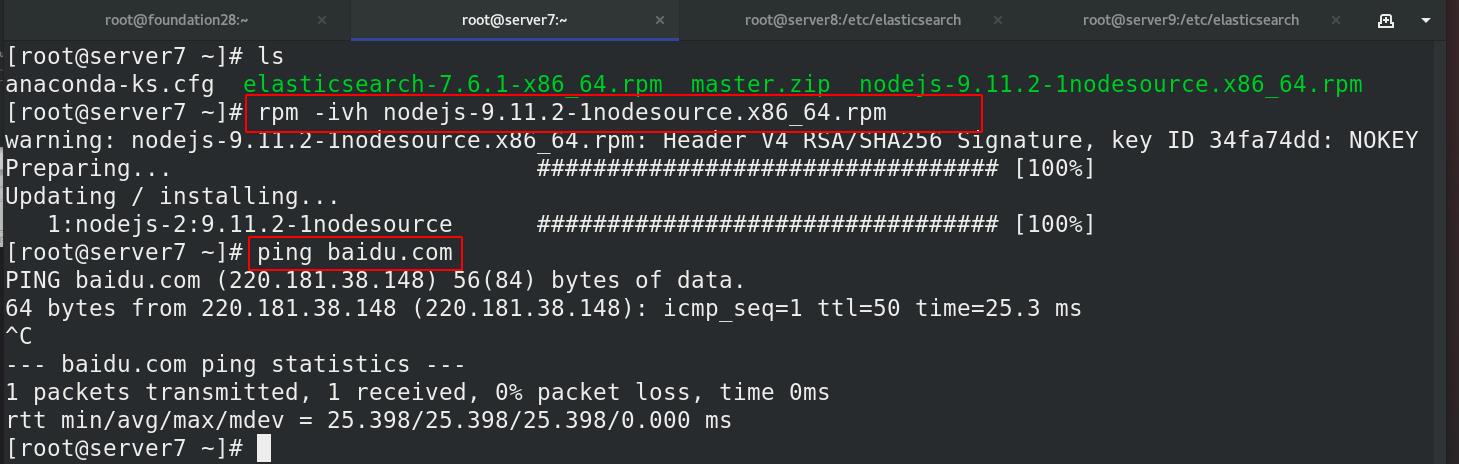

安装node

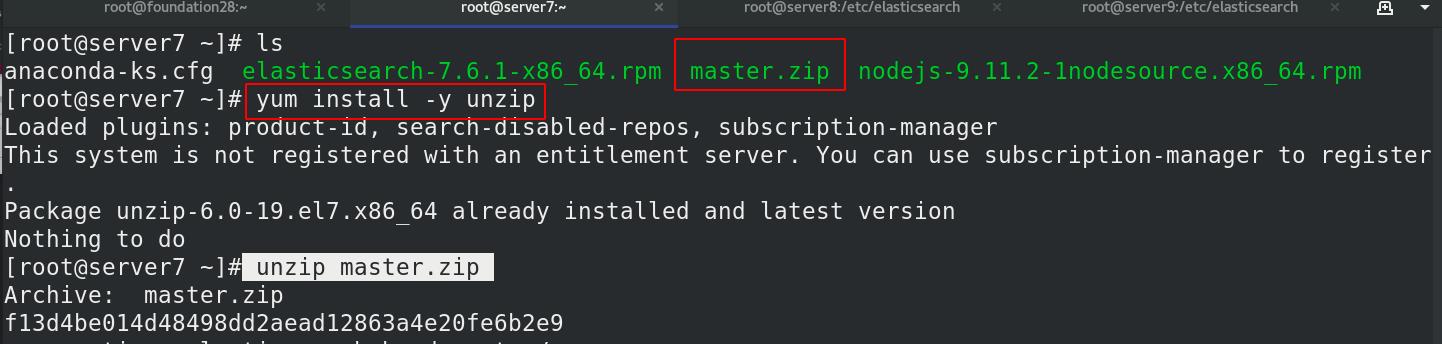

由于master.zip需要解压工具,所以安装unzip,解压master

保证可以上网,

更换npm源安装(由于npm慢,所以更换为cnpm源)

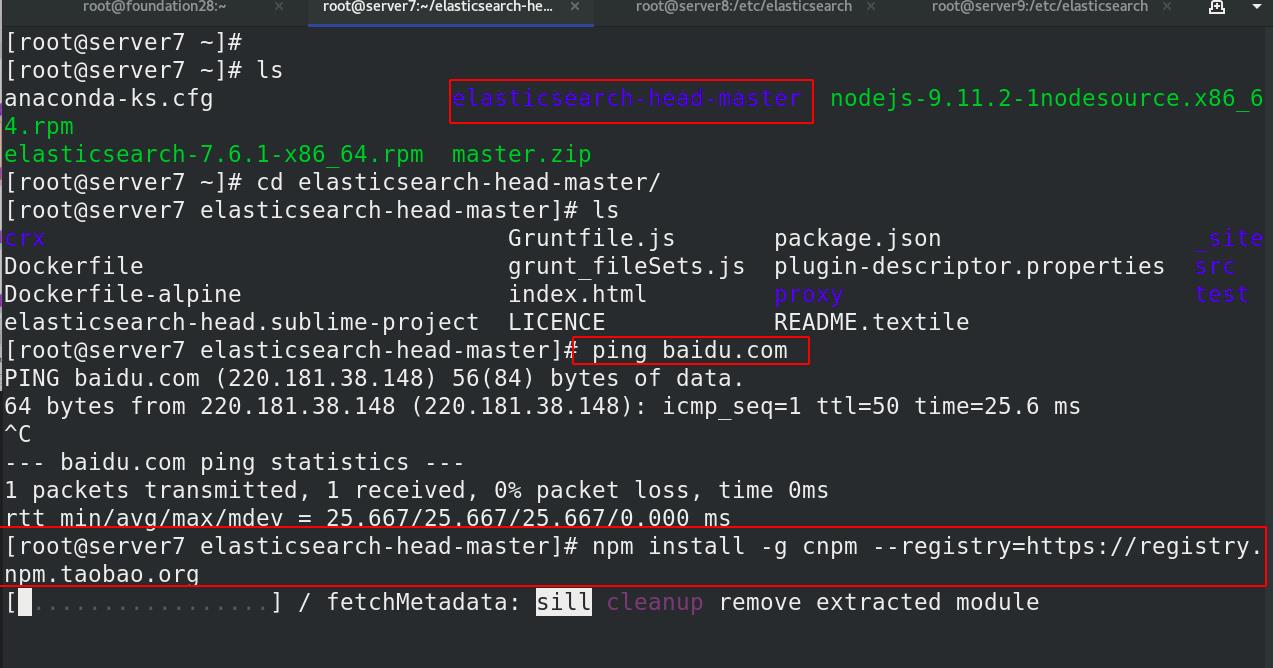

cd elasticsearch-head-master/

npm install -g cnpm --registry=https://registry.npm.taobao.org

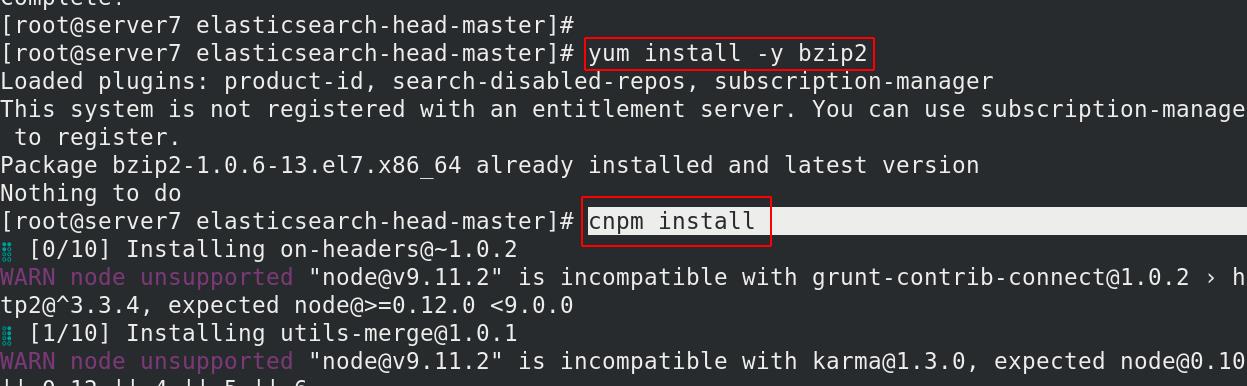

安装cnpm,(bzip,安装cnpm需要用到)

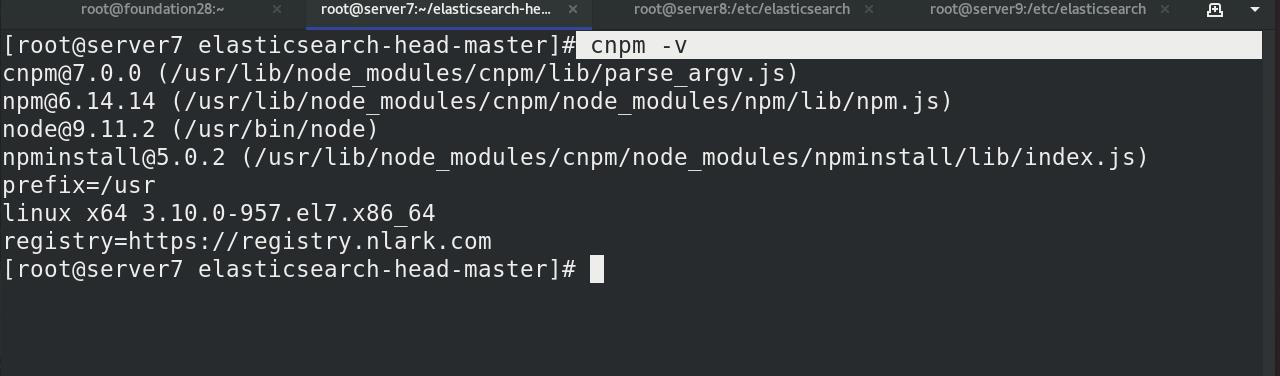

cnpm -v 查看版本号

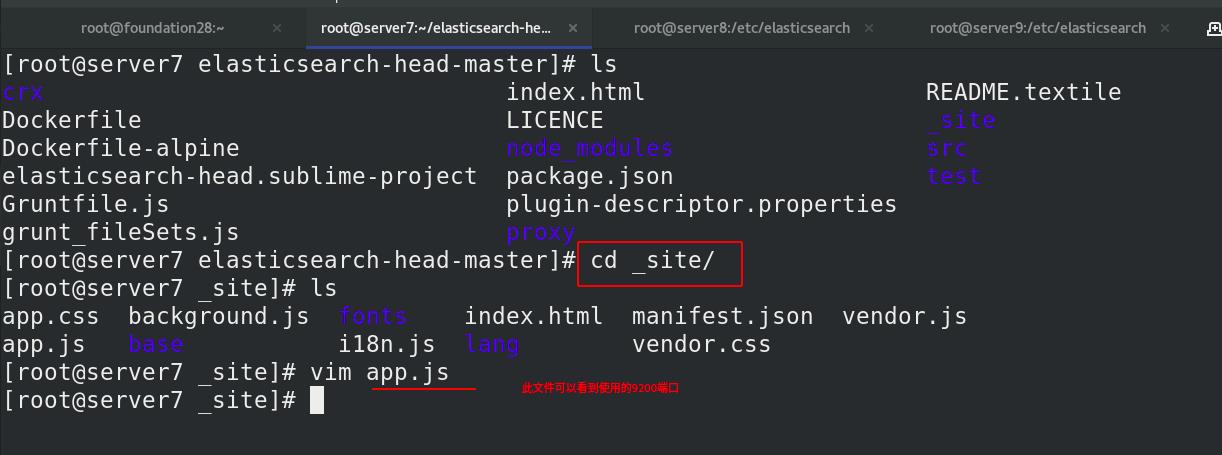

进入_site/子目录,查看app.js文件

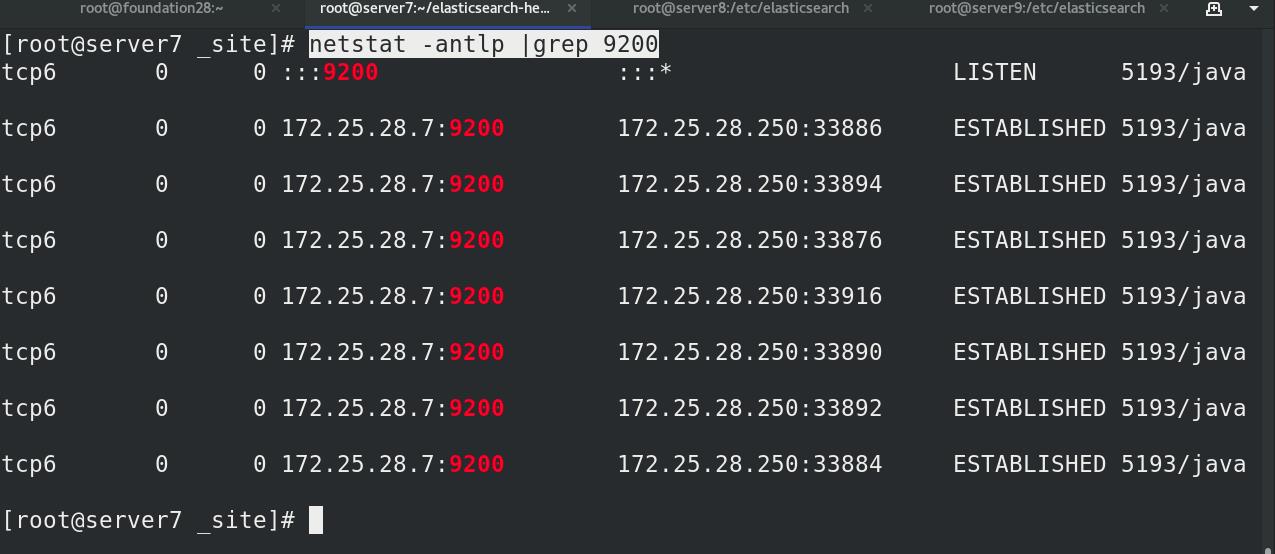

查看ES主机端口:9200

端口查看

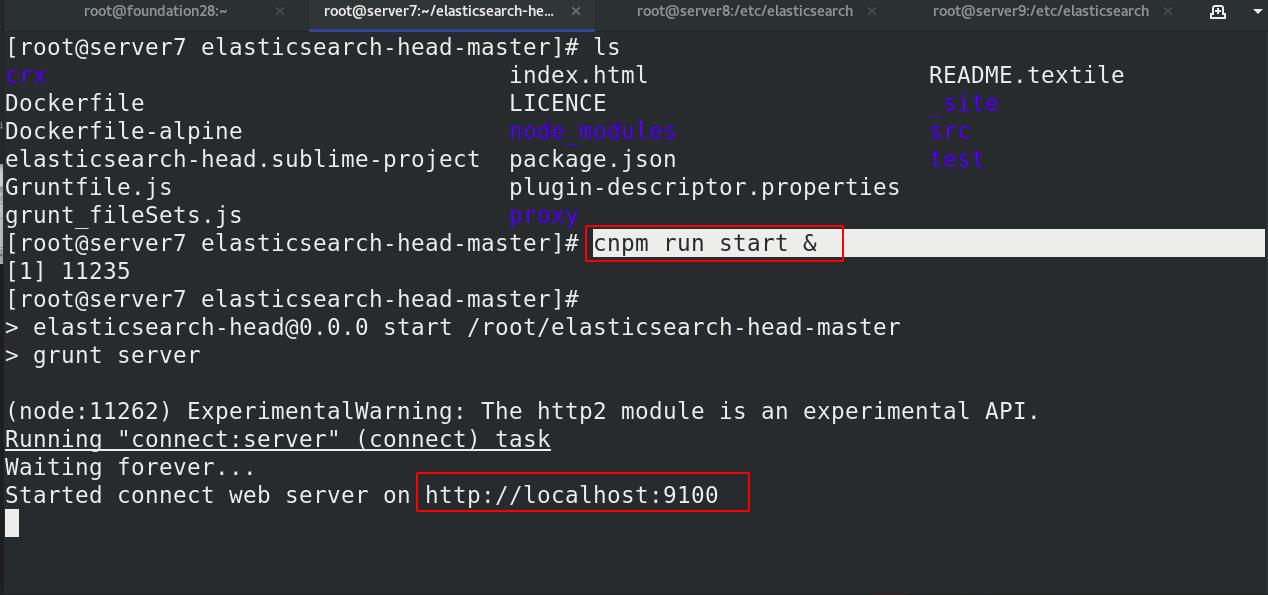

server7 启动head插件,打入后台运行 , 本机开启端口为9100

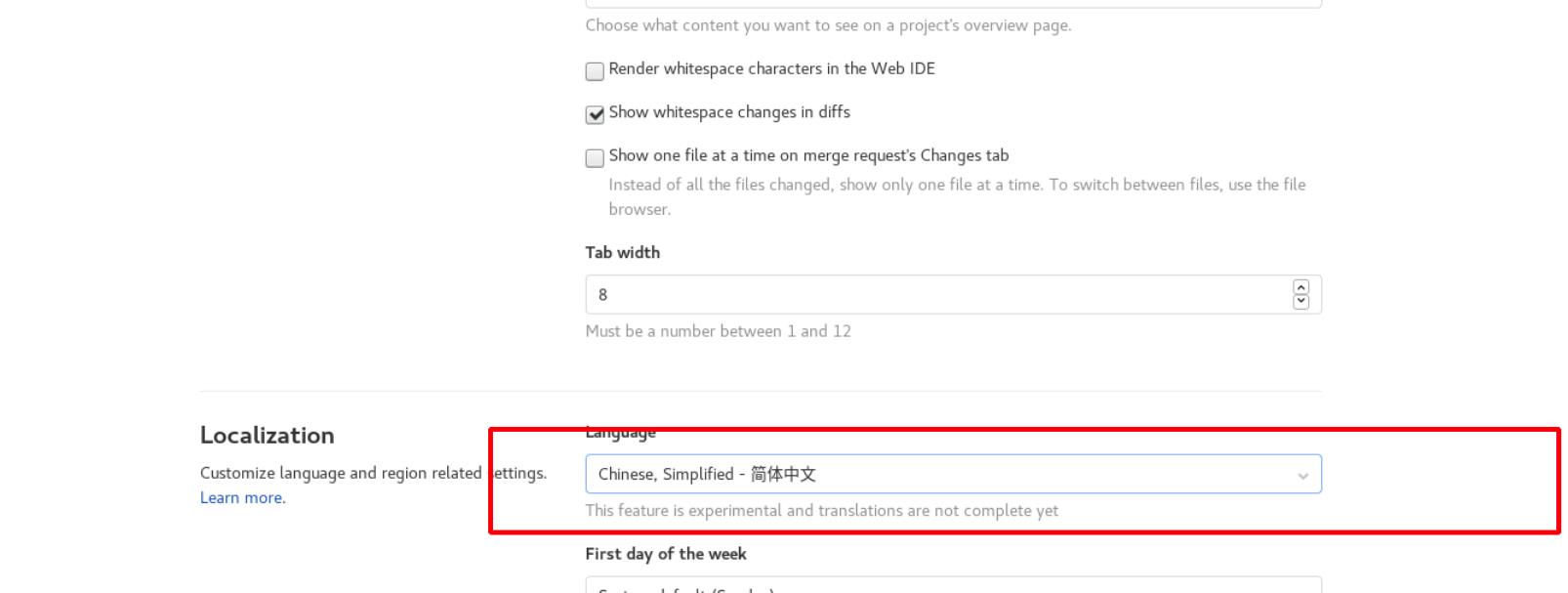

设为中文,访问head插件服务

访问失败

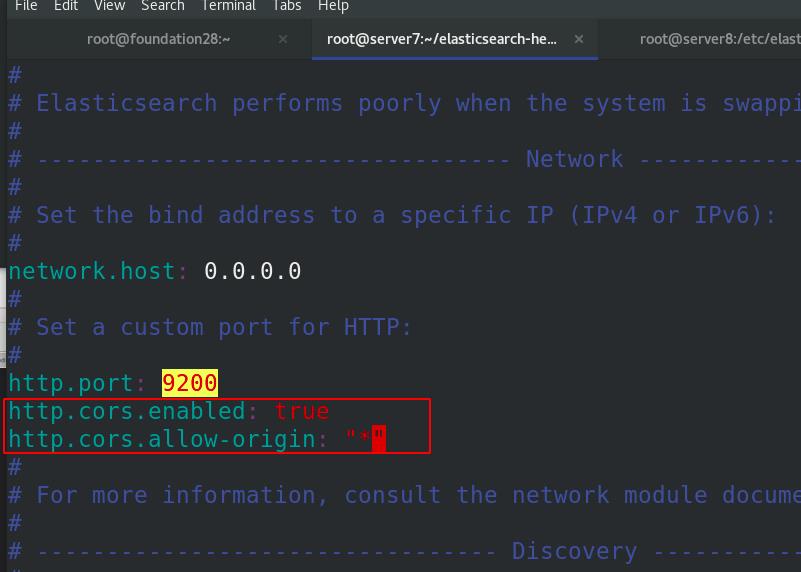

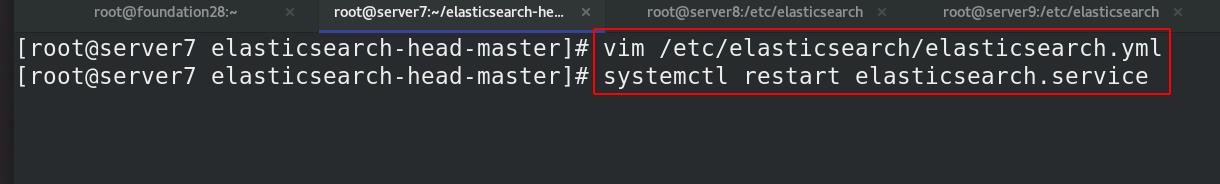

需要在主配置文件elasticsearch.yml中加入以下内容

修改ES跨域主持

http.cors.enabled: true # 是否支持跨域

http.cors.allow-origin: "*" # *表示支持所有域名

重启ES服务生效

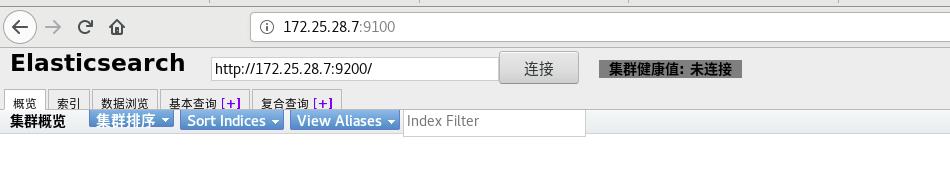

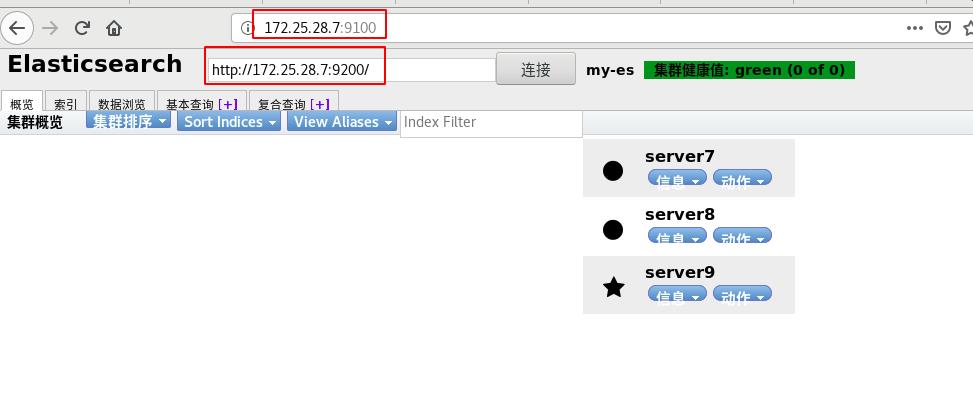

重新访问head插件服务成功!!!

http://172.25.28.7:9100,

监控http://172.25.77.3:9200的elasticsearch,

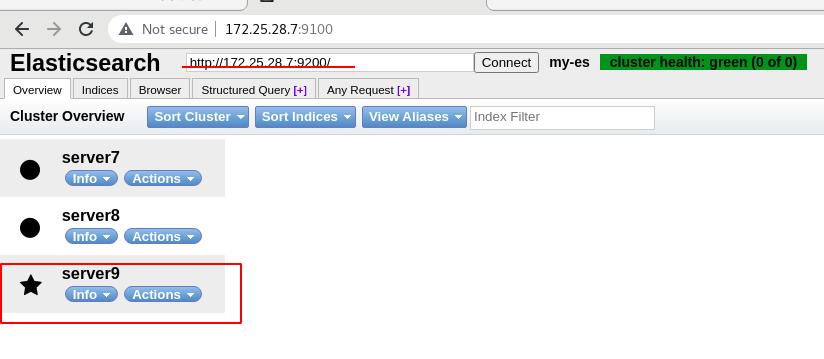

可以看到集群的三个节点。*代表master节点

默认监听在9100端口:

灰色标识没有副本 黄色代表没有主分片丢失

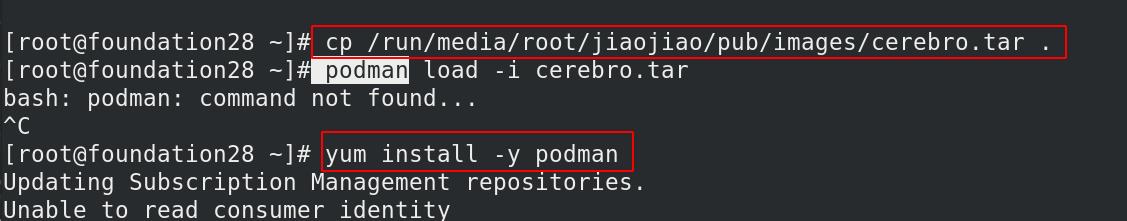

2 cerebro插件

cerebro是镜像,真机是8.2的红帽系统,红帽系统自带podman(等同docker),

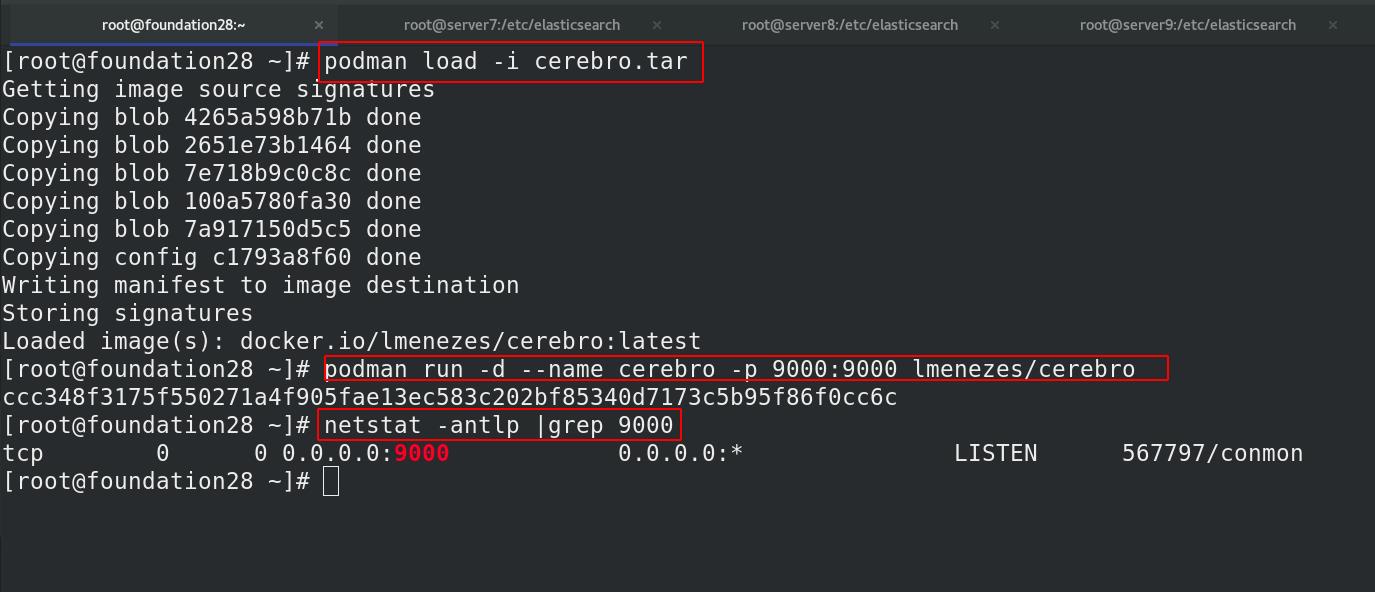

真机导入镜像,

podman run -d --name cerebro -p 9000:9000 lmenezes/cerebro

#运行该镜像,默认开放9000端口

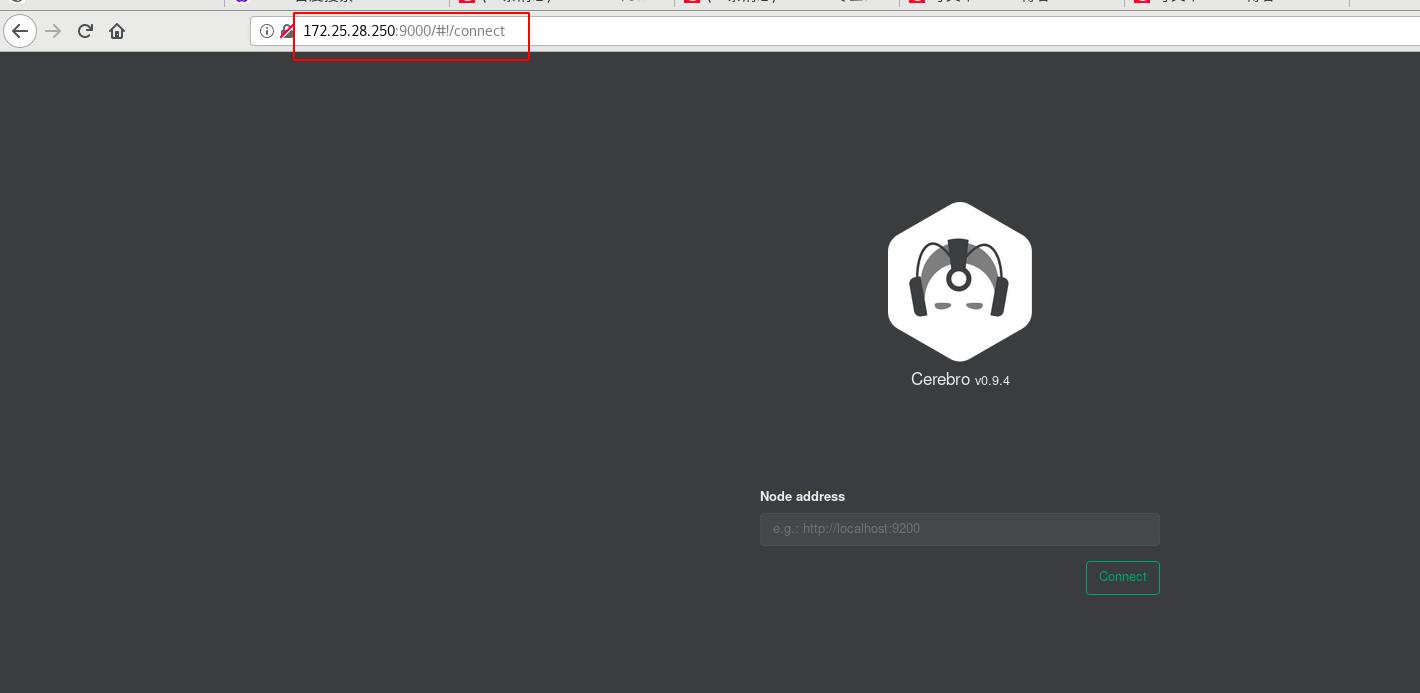

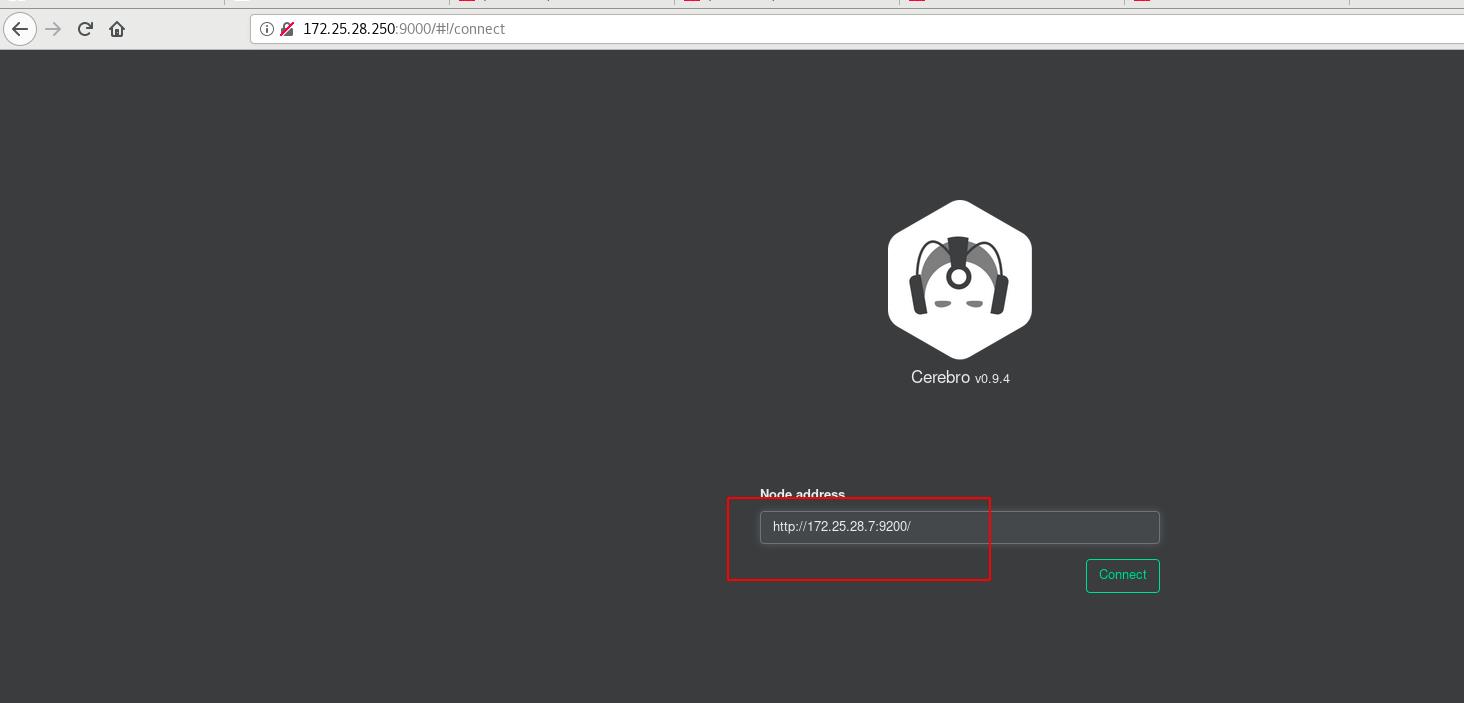

网页访问 http://172.25.28.250:9000,

需要输入监听的地址,http://172.25.28.7:9200(server7,server8,server9的地址都可,ES集群)

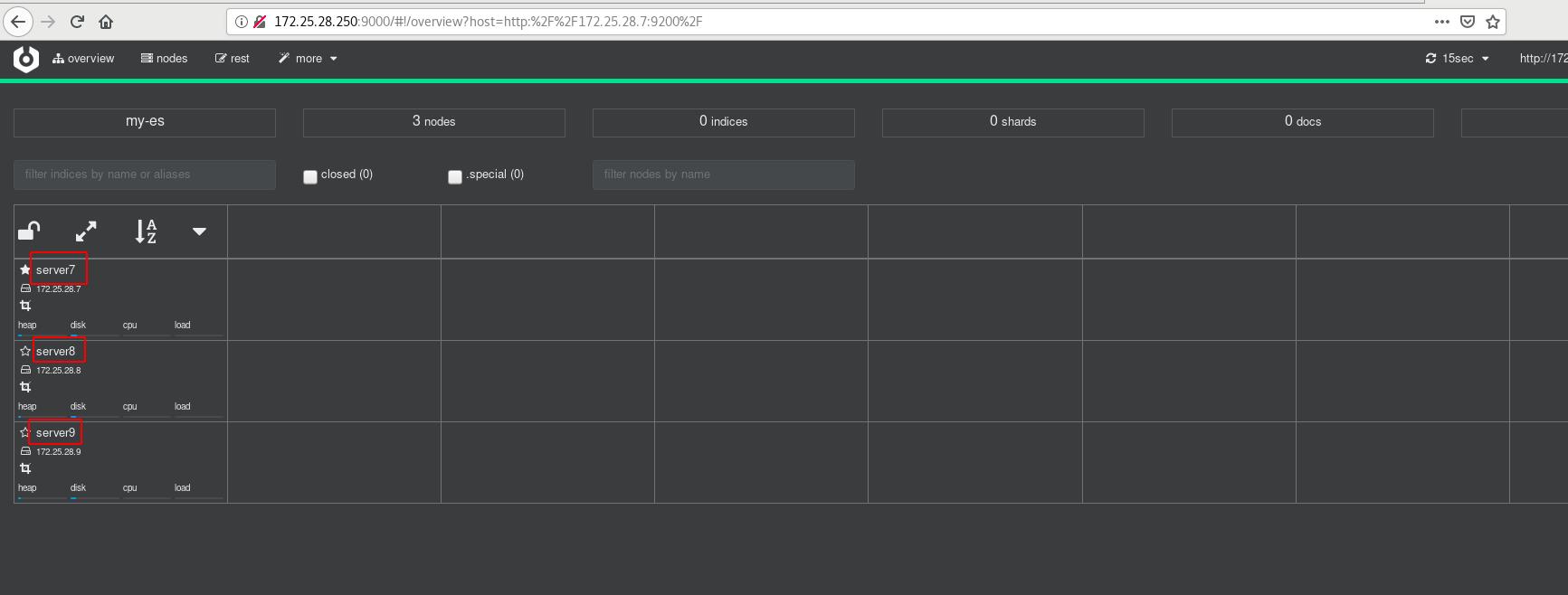

成功进入cerebro

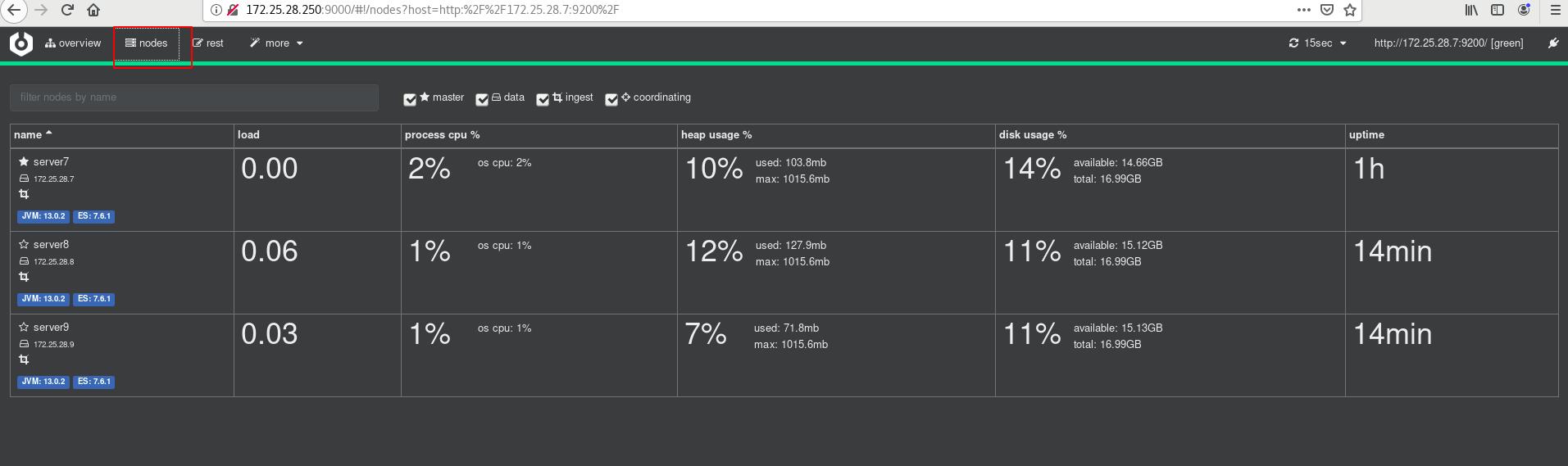

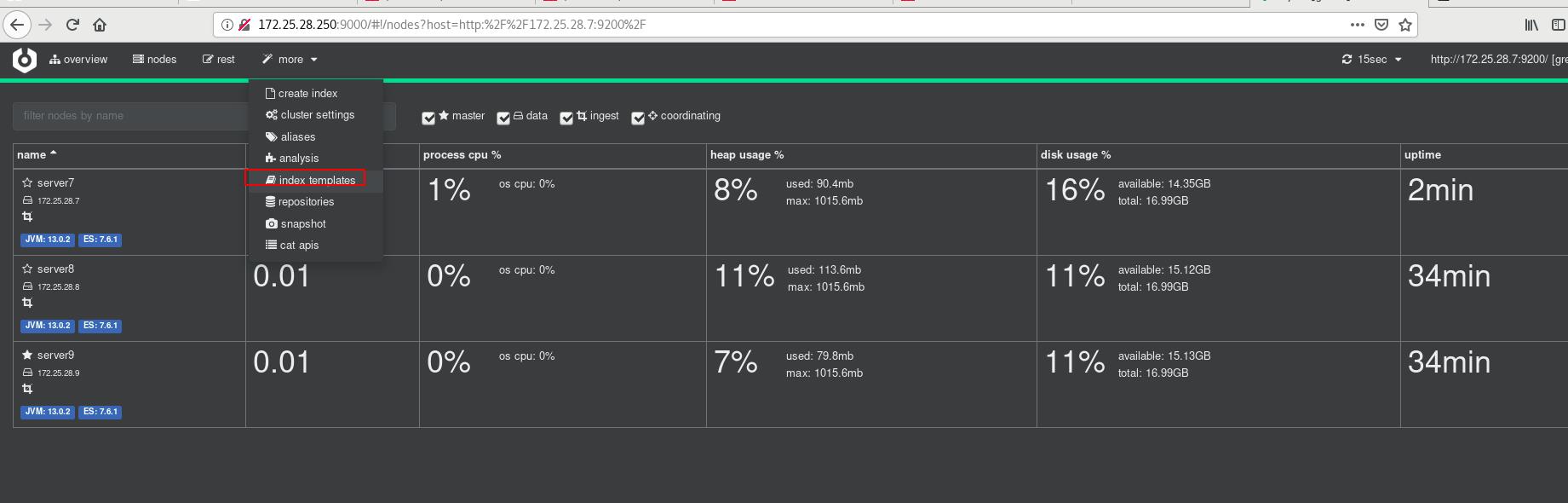

点击nodes,可以看到ES集群中三个节点都在

三 ES节点角色

-

Master:

主要负责集群中索引的创建、删除以及数据的Rebalance等操作。Master不负责数据的索引和检索,所以负载较轻。当Master节点失联或者挂掉的时候,ES集群会自动从其他Master节点选举出一个Leader。 -

Data Node:

主要负责集群中数据的索引和检索,一般压力比较大。 -

Coordinating Node:

原来的Client node的,主要功能是来分发请求和合并结果的。所有节点默认就是Coordinating node,且不能关闭该属性。 -

Ingest Node:

专门对索引的文档做预处理

1 elasticsearch节点优化方式

-

在生产环境下,如果不修改elasticsearch节点的角色信息,在高数据量,高并发的场景下集群容易出现

脑裂等问题。 -

默认情况下,

elasticsearch集群中每个节点都有成为主节点的资格,也都存储数据,还可以提供查询服务。 -

节点角色是由以下属性控制:

node.master: false|true(这个属性表示节点是否具有成为主节点的资格, 注意:此属性的值为true,并不意味着这个节点就是主节点。因为真正的主节点,是由多个具有主节点资格的节点进行选举产生的。)node.data: true|false(这个属性表示节点是否存储数据。)node.ingest: true|false(是否对文档进行预处理。)search.remote.connect: true|false(是否禁用跨集群查询)默认情况下这些属性的值都是true。

节点优化的四种组合:

第一种组合:(默认)

node.master: true

node.data: true

node.ingest: true

search.remote.connect: true

这种组合表示这个节点即有成为主节点的资格,又存储数据。

如果某个节点被选举成为了真正的主节点,那么他还要存储数据,这样对于这个节点的压力就比较大了。

测试环境下这样做没问题,但实际工作中不建议这样设置

第二种组合:(Data node)

node.master: false

node.data: true

node.ingest: false

search.remote.connect: false

这种组合表示这个节点没有成为主节点的资格,也就不参与选举,只会存储数据。

这个节点称为data(数据)节点。在集群中需要单独设置几个这样的节点负责存储数据。后期提供存储和查询服务。

第三种组合:(master node)

node.master: true

node.data: false

node.ingest: false

search.remote.connect: false

这种组合表示这个节点不会存储数据,有成为主节点的资格,可以参与选举,有可能成为真正的主节点。 这个节点我们称为master节点。

第四种组合:(Coordinating Node)

node.master: false

node.data: false

node.ingest: false

search.remote.connect: false

这种组合表示这个节点即不会成为主节点,也不会存储数据, 这个节点的意义是作为一个协调节点,主要是针对海量请求的时候可以进行负载均衡。

第五种组合:(Ingest Node)

node.master: false

node.data: false

node.ingest: true

search.remote.connect: false

这种组合表示这个节点即不会成为主节点,也不会存储数据, 这个节点的意义是ingest节点,对索引的文档做预处理。

2 设定集群中某节点不存储数据,role角色无data

生产集群中可以对这些节点的职责进行划分 建议

集群中设置3台以上的节点作为master节点,这些节点只负责成为主节点,维护整个集群的状态。

再根据数据量设置一批data节点,这些节点只负责存储数据,后期提供建立索引和查询索引的服务,这样的话如果用户请求比较频繁,这些节点的压力也会比较大。

所以在集群中建议再设置一批协调节点,这些节点只负责处理用户请求,实现请求转发,负载均衡等功能

节点需求

master节点:普通服务器即可(CPU、内存 消耗一般)

data节点:主要消耗磁盘、内存。

path.data: data1,data2,data3

这样的配置可能会导致数据写入不均匀,建议只指定一个数据路径,磁盘可以使用raid0阵列,而不需要成本高的ssd。

Coordinating节点:对cpu、memory要求较高。

实验环境:

ES集群server7,server8,server9,其中server9为master

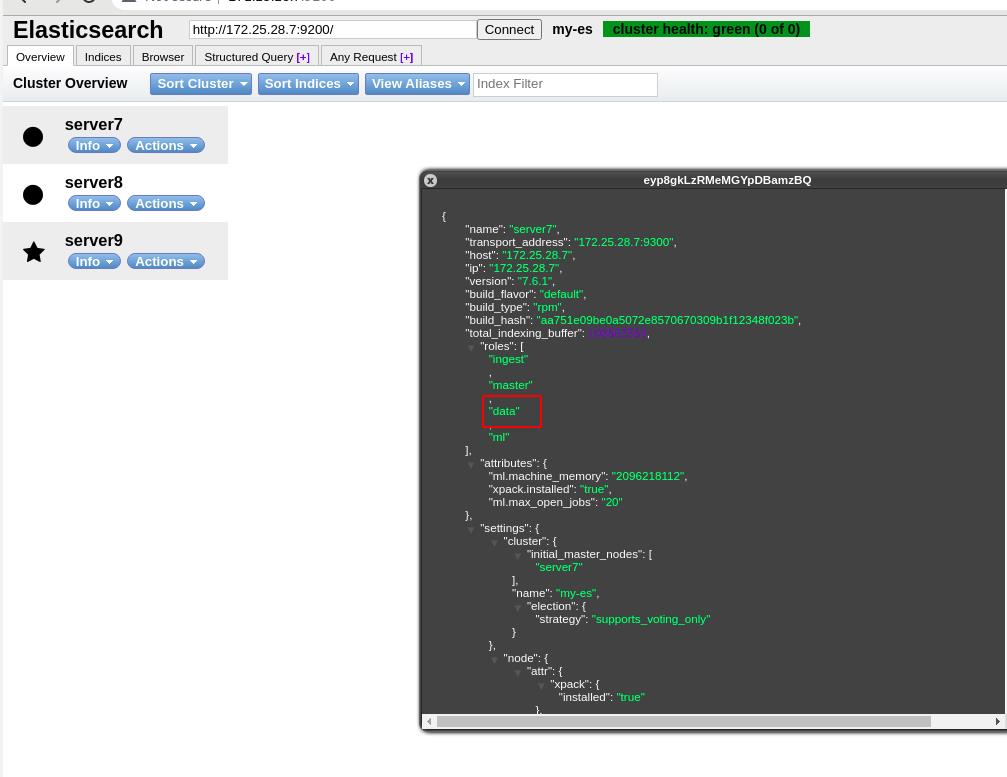

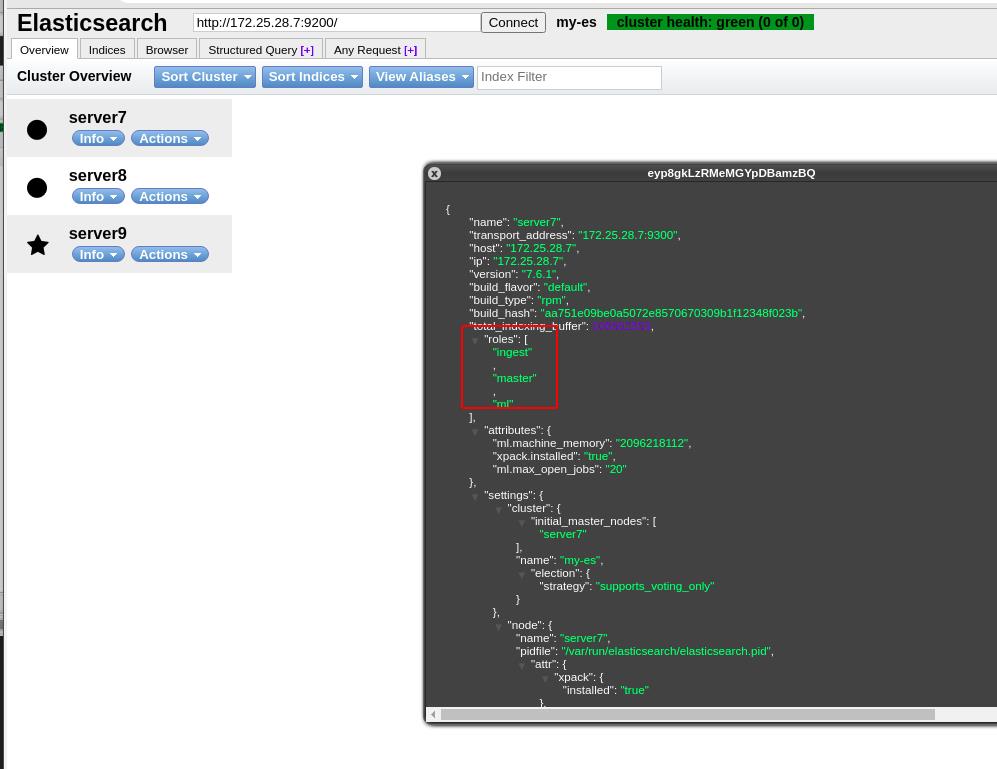

查看server7节点的信息

此时server7中role角色有 Ingest(预处理),Master(整个集群的master),data(存储数据),ml(机器学习)

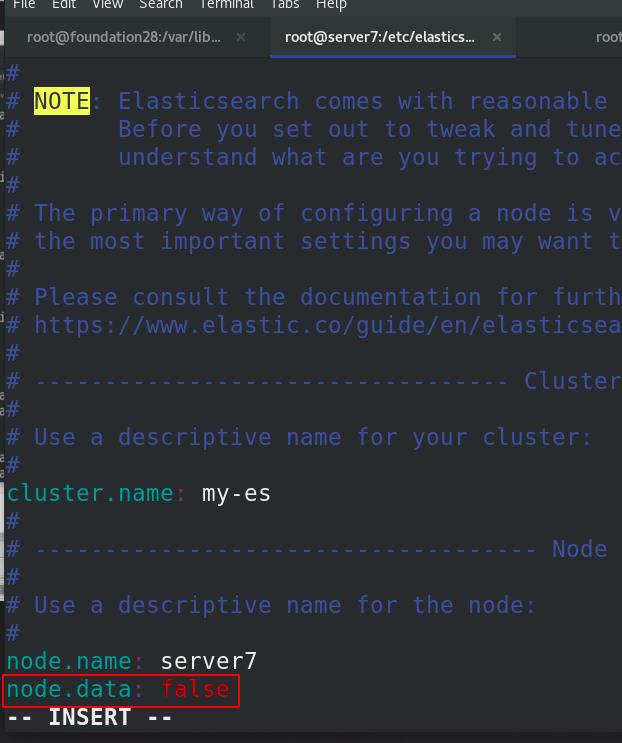

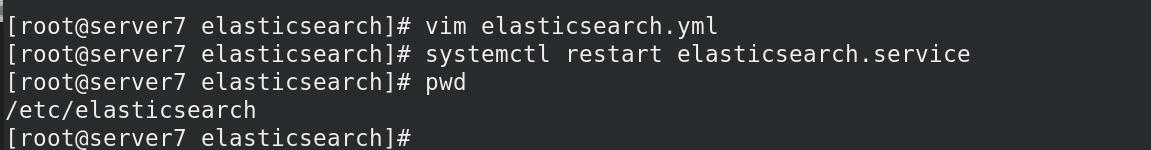

server7主机编辑主编配置文件/etc/elasticsearch/elasticsearch.yml,添加node.data: false语句,表示该主机不存放数据

重启ES服务

查看server7节点的信息

此时server7中role角色有 Ingest(预处理),Master(整个集群的master)和 ml(机器学习),无data

四 节点需求

data节点:容易消耗磁盘,内存;

ELK可以和hadoop结合使用,ELK:存放热数据,hadoop:存放冷数据,存放离线数据

多路径冗余不需要:(ELK本身就是分布式,加大单节点IO)

五 节点扩容

集群名称必须设定一样!!!

六 节点缩容:

本机可以使用localhost/其他使用ip

命令行直接输入,ip换为删除的节点ip(修改ip!!!)

以上是关于ELK日志分析平台之Elasticsearch的主要内容,如果未能解决你的问题,请参考以下文章