logistic回归

Posted 大数据最好

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了logistic回归相关的知识,希望对你有一定的参考价值。

逻辑斯谛回归模型

逻辑斯谛分布

首先介绍逻辑斯谛分布,该分布的定义是

设X是连续随机变量,X服从逻辑斯谛分布是指X服从如下分布函数和密度函数:

其中, 为位置参数,

为位置参数, > 0 为形状参数。

> 0 为形状参数。

可以通过其图像观察:

右边的逻辑斯蒂分布函数以点 中心对称,即满足:

中心对称,即满足:

形状参数 越小,曲线在中心的增长速度越快。

越小,曲线在中心的增长速度越快。

二项逻辑斯蒂回归模型

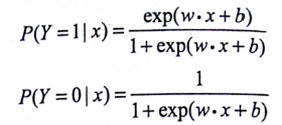

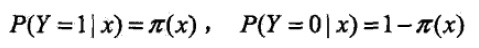

这是一种由条件概率表示的模型,其条件概率模型如下:

其中,exp为以e为底的指数函数,x∈Rn是输入,y∈0,1输出,w,b是模型参数——w是权值向量,b称作偏置,w·x是向量内积。

有了后验概率,逻辑斯蒂回归模型选择二分类中较大的那一个完成分类。

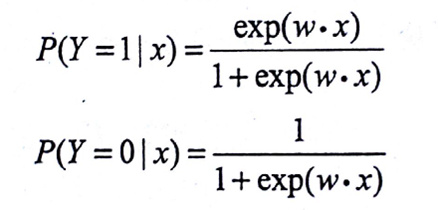

另外,逻辑斯特回归模型还有一个方便的形式,如果将权值向量w和输入向量x拓充为w=(w(1),w(2),…w(n),b)T,x=(x(1),…x(n),1)T,此时逻辑斯谛模型可以表示为:

为什么要重新提一个形式出来呢?这是因为,这个形式跟几率的表达式很像。

定义事件的几率:发生概率与不发生概率的比值—— 。

。

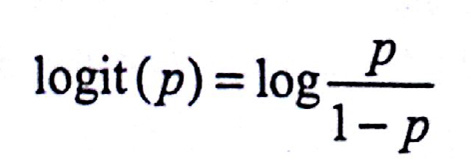

定义对数几率:

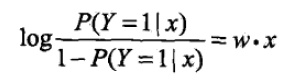

将逻辑斯蒂模型的便捷形式做一个变换恰好可以得到:

这也就是说,在逻辑斯蒂回归模型中,输出Y=1的对数几率是输入x的线性函数。或者说输出Y=1的对数几率是由输入x的线性函数表示的模型,即逻辑斯蒂回归模型。反过来讲,如果知道权值向量,给定输入x,就能求出Y=1的概率:

线性函数w·x的值越接近正无穷,概率值越接近1;反之,越接近负无穷,概率值越接近0——这就是逻辑斯谛回归模型。

模型参数估计

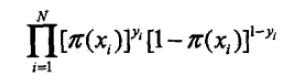

在模型学习的时候,对于给定训练集T = (x1,y1)…(xN,yN),x∈Rn,y∈0,1

设

定义似然函数

则有对数似然函数

这个好说,把后面括号里的负π提到前面去就行了。

对L(w)求极大值就可以得出权值向量w的估计值。

解决以L(w)为目标函数的最优化问题的一般方法是梯度下降法及拟牛顿法,前者书上让参考附录,后者在后面会介绍。

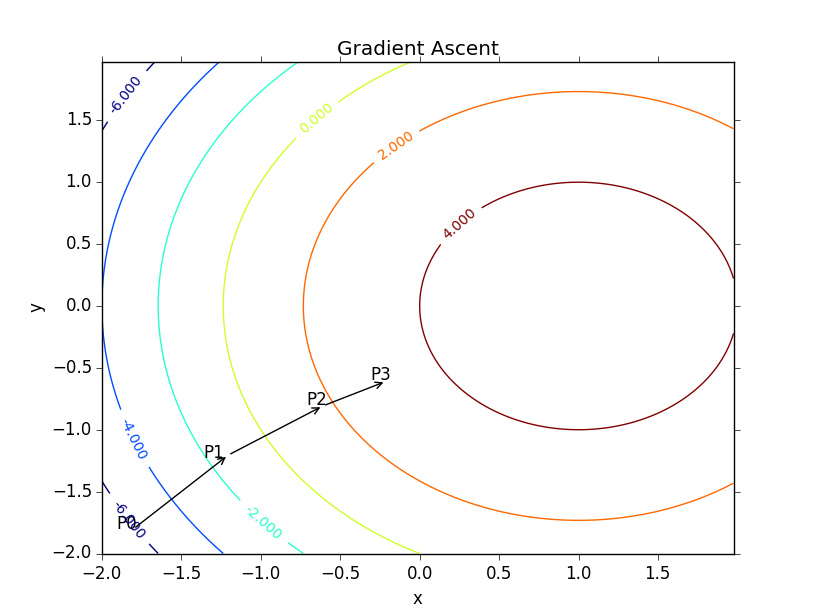

梯度下降:

函数的梯度由其偏导数构成:

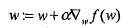

梯度是函数增长最快的方向,记移动补偿为α,则梯度算法的迭代公式为:

假定权值向量w有了,怎么计算模型输出呢?

特征向量乘以权值向量得出一个实数z

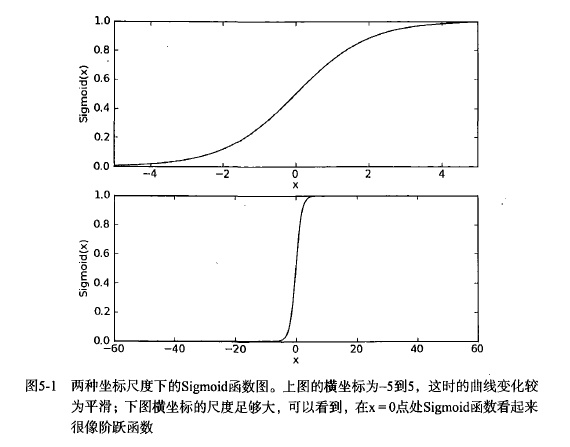

希望通过该实数输出一个0或1的类别,这时候就需要利用Sigmoid函数了:

其图像如下:

将该实数代入Sigmoid函数后,得到一个0~1之间的数,大于0.5归入1,小于0.5归入0即可。

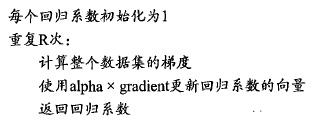

利用Sigmoid函数,梯度上升算法的伪码如下:

以上是关于logistic回归的主要内容,如果未能解决你的问题,请参考以下文章