云计算HCIP实验-OpenStack搭建

Posted 浇、水

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了云计算HCIP实验-OpenStack搭建相关的知识,希望对你有一定的参考价值。

文章目录

前期准备

rhel-server-7.1-x86_64-dvd.iso(必须是7.1)

RHEL7OSP-6.0-2015-02-23.2-x86_64.iso

WinSCP

VMware

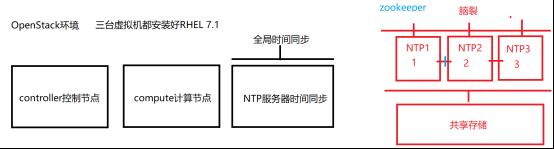

1. 环境规划

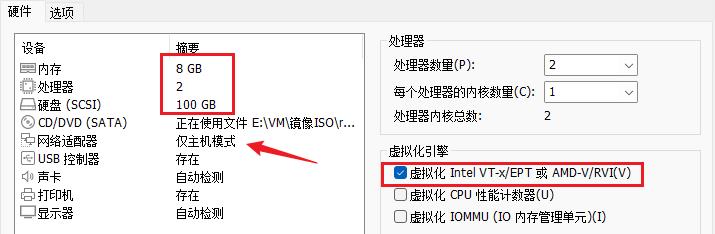

虚拟机要求(按照物理机16G物理内存标准)

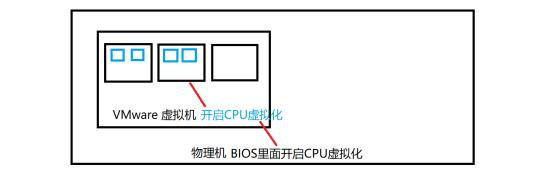

控制节点:内存8G,勾选CPU虚拟化,虚拟网卡(仅主机)

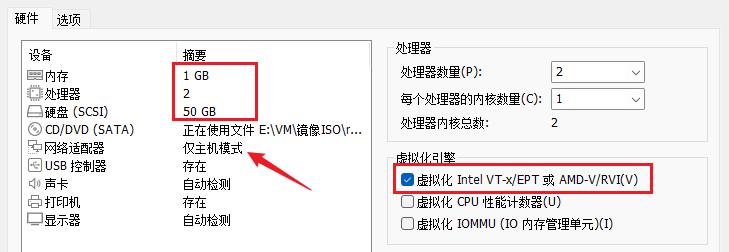

计算节点:内存4G,勾选CPU虚拟化,虚拟网卡(仅主机)

NTP节点:内存1G

controller:

compute:

ntp:

架构:

16G内存建议最小化安装操作系统

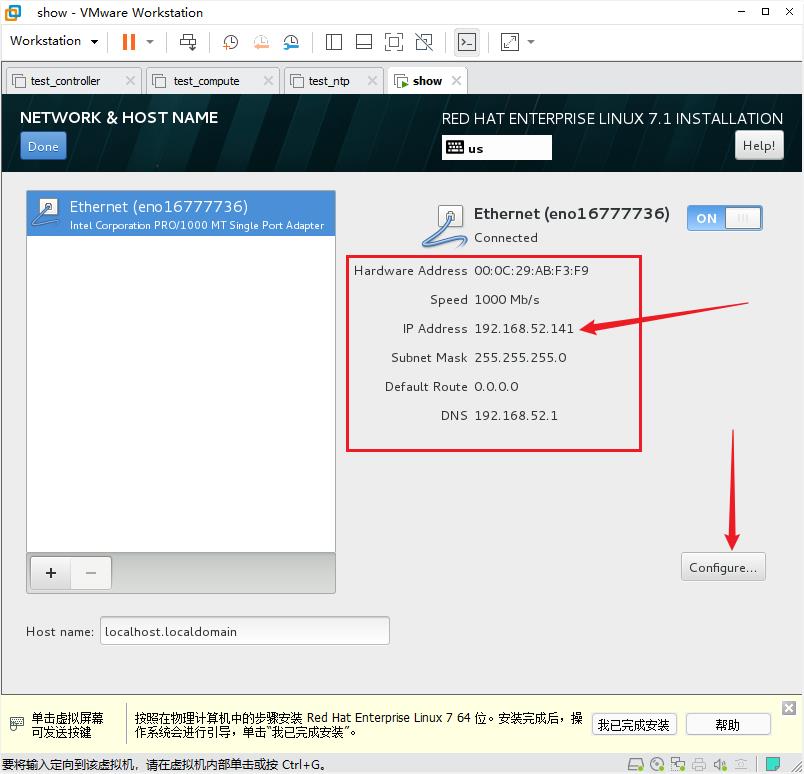

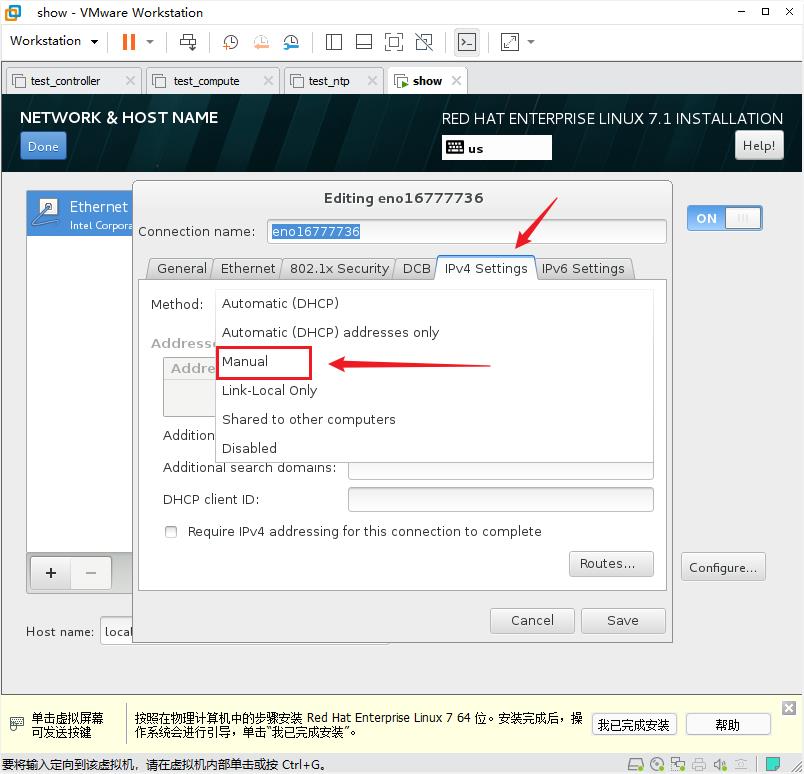

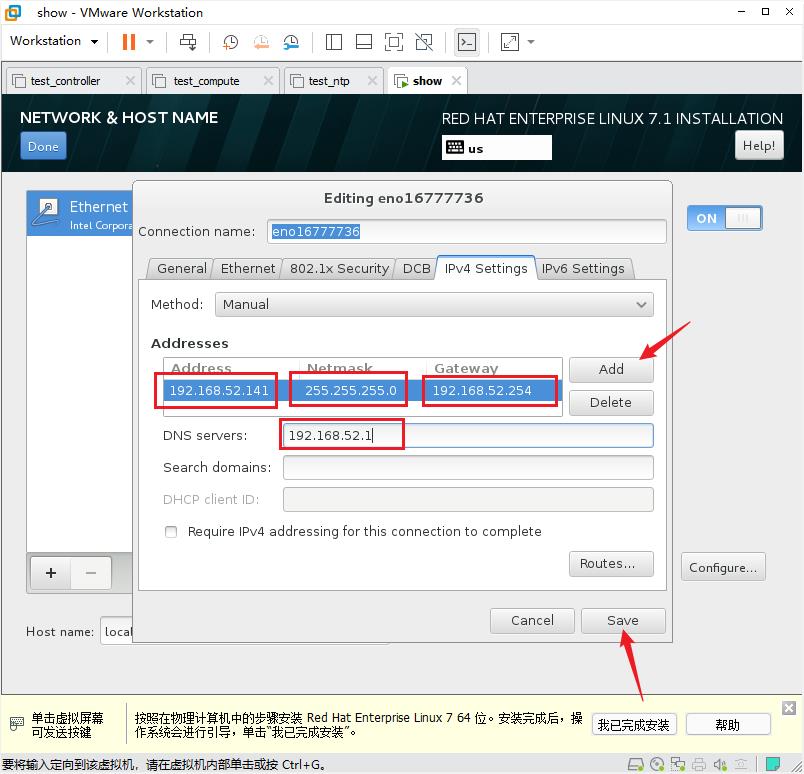

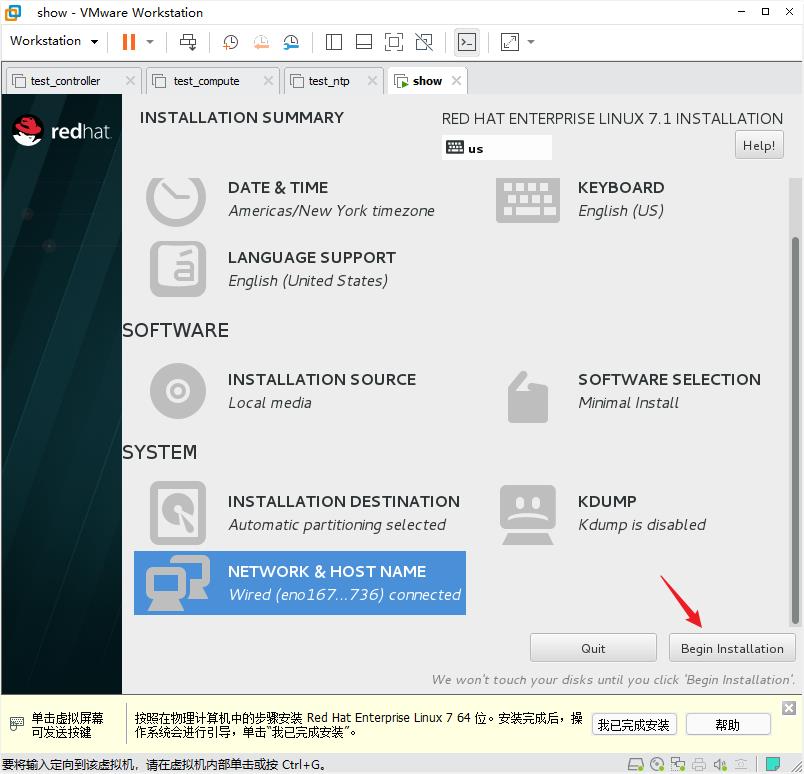

2. 绑定静态IP

安装过程中注意网络配置

获取到ip地址后

按照如上条件安装完三台虚拟机

3. IP及主机名规划

修改controller主机的/etc/hosts 文件

[root@controller ~]# vi /etc/hosts

将/etc/hosts 文件拷贝到另外两台主机上

[root@controller ~]# scp /etc/hosts root@compute:/etc/

[root@controller ~]# scp /etc/hosts root@ntp:/etc/

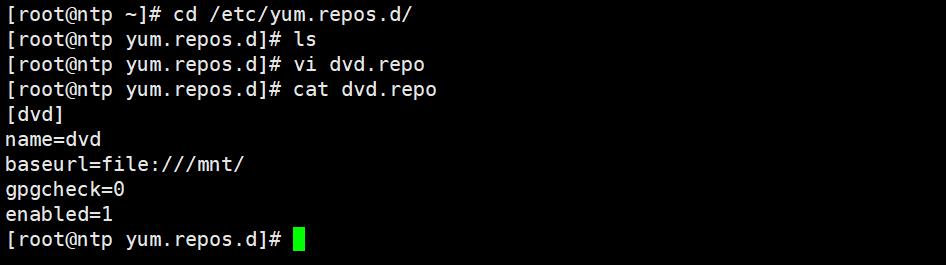

4. 配置OS YUM源

切换到ntp节点

将光盘在虚拟机上进行挂载

将光盘在操作系统中挂载到临时挂载点 /mnt (目的是为了安装httpd服务)

[root@ntp ~]# mount /dev/cdrom /mnt

[root@ntp ~]# cd /etc/yum.repos.d/

[root@ntp yum.repos.d]# vi dvd.repo

[dvd]

name=dvd

baseurl=file:///mnt/

gpgcheck=0

enabled=1

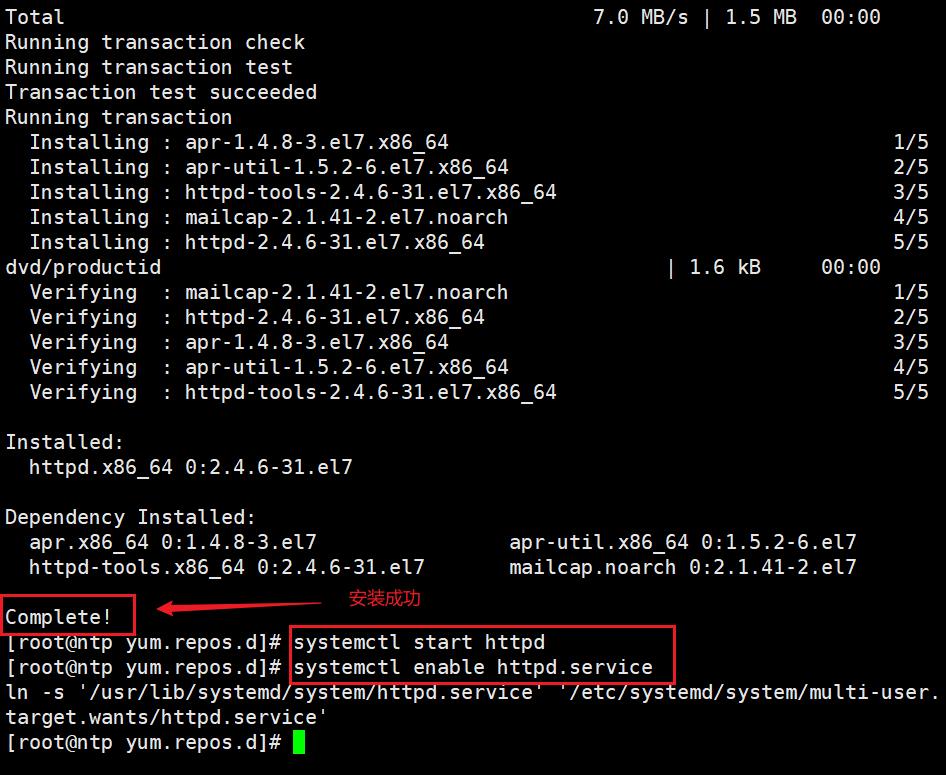

安装并启动http服务

[root@ntp yum.repos.d]# yum install -y httpd

[root@ntp yum.repos.d]# systemctl start httpd

[root@ntp yum.repos.d]# systemctl enable httpd.service

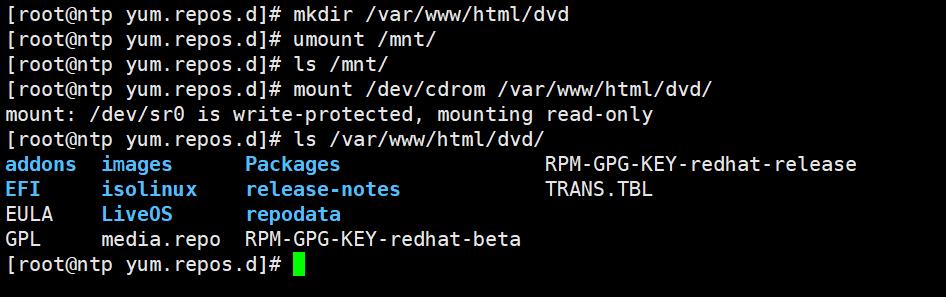

在http服务路径下创建一个文件夹dvd

[root@ntp html]# mkdir /var/www/html/dvd

[root@ntp html]# umount /mnt/

[root@ntp html]# ls /mnt/

[root@ntp html]# mount /dev/cdrom /var/www/html/dvd/

[root@ntp html]# ls /var/www/html/dvd/

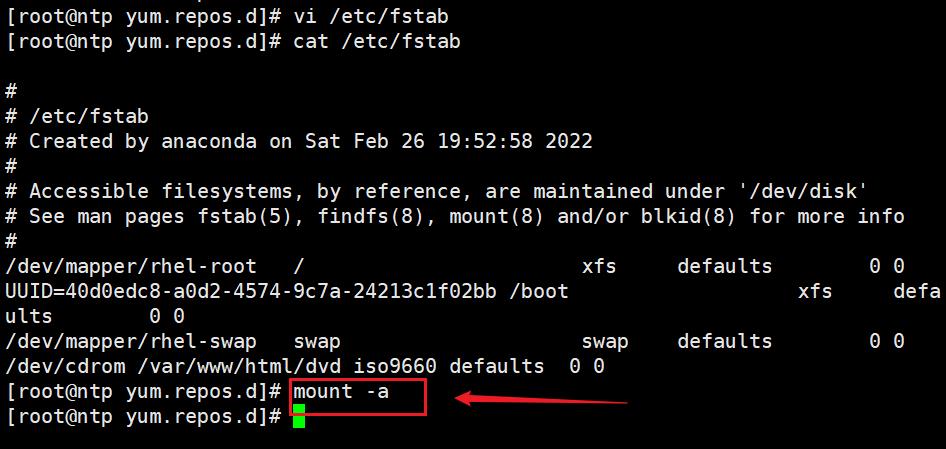

但是这时候一旦重启,光盘挂载就会失效,所以我们要将这个光盘路径进行永久挂载,写入开机自启文件 /etc/fstab

[root@ntp html]# vi /etc/fstab

最下面添加这行

/dev/cdrom /var/www/html/dvd iso9660 defaults 0 0

[root@ntp html]# mount -a

尝试其他两个节点进行远程安装,比如在controller节点上进行yum源配置,地址指向ntp

切换到controller节点

[root@controller ~]# vi /etc/yum.repos.d/dvd.repo

[dvd]

name=dvd

baseurl=http://192.168.52.138/dvd/

gpgcheck=0

enabled=1

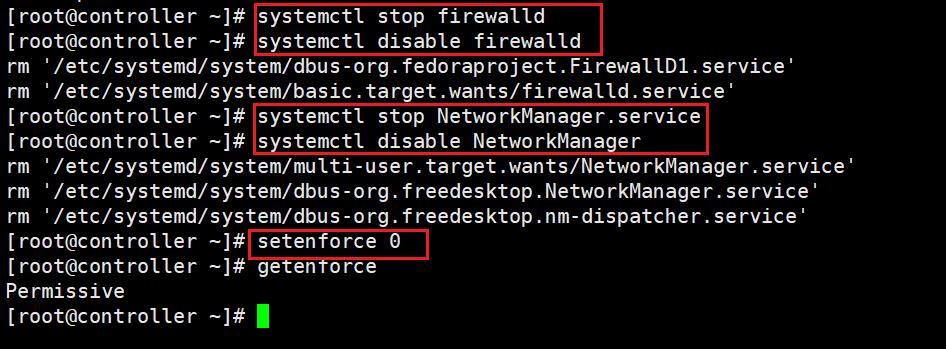

5. 关闭防火墙SELinux NetworkManager

[root@controller ~]# systemctl stop firewalld

[root@controller ~]# systemctl disable firewalld

[root@controller ~]# systemctl stop NetworkManager.service

[root@controller ~]# systemctl disable NetworkManager

[root@controller ~]# setenforce 0

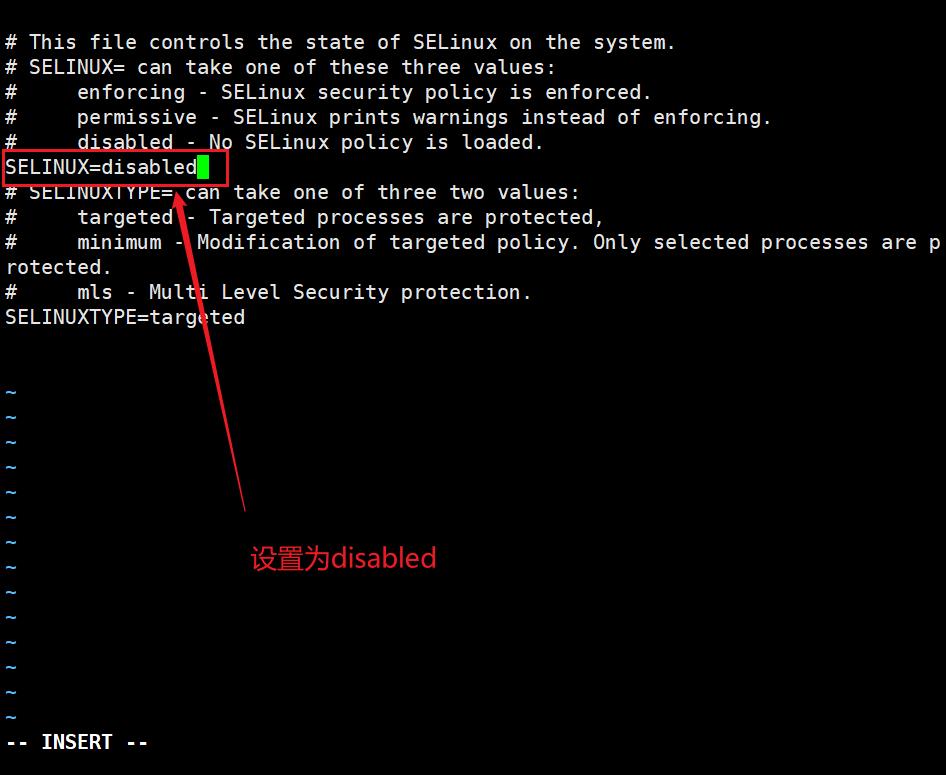

[root@controller ~]# vi /etc/selinux/config

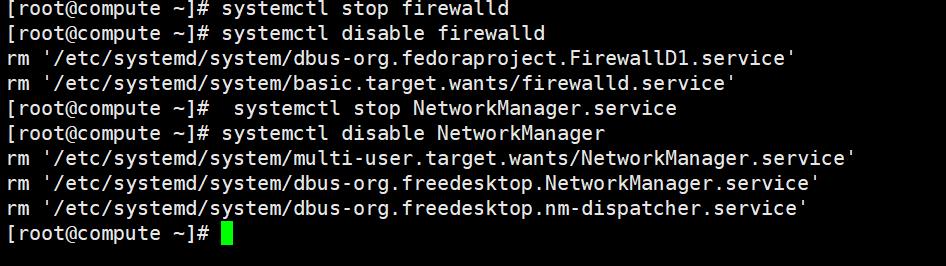

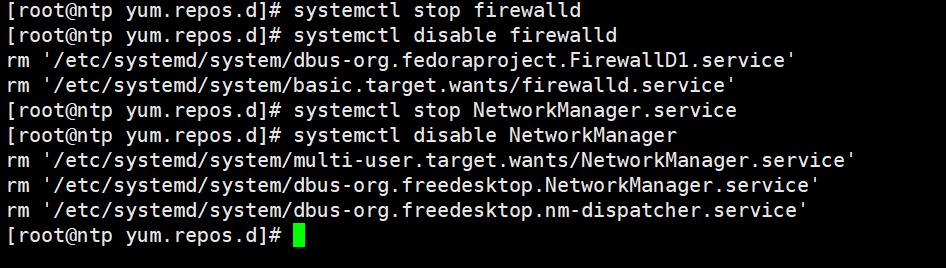

关闭其它两个虚拟机的防火墙和NetworkManager

测试一下yum是否可以正常使用(开启防火墙的情况下controller访问不了ntp的repo文件)

这是未关闭防火墙的结果

6. 配置OpenStack YUM源

切换到ntp节点

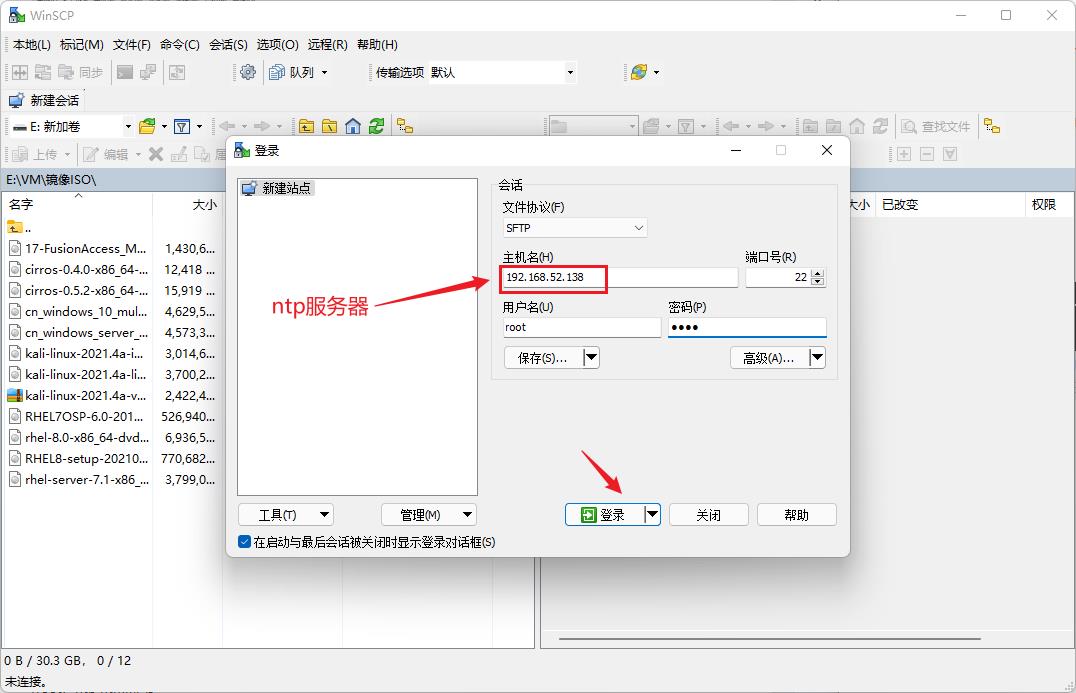

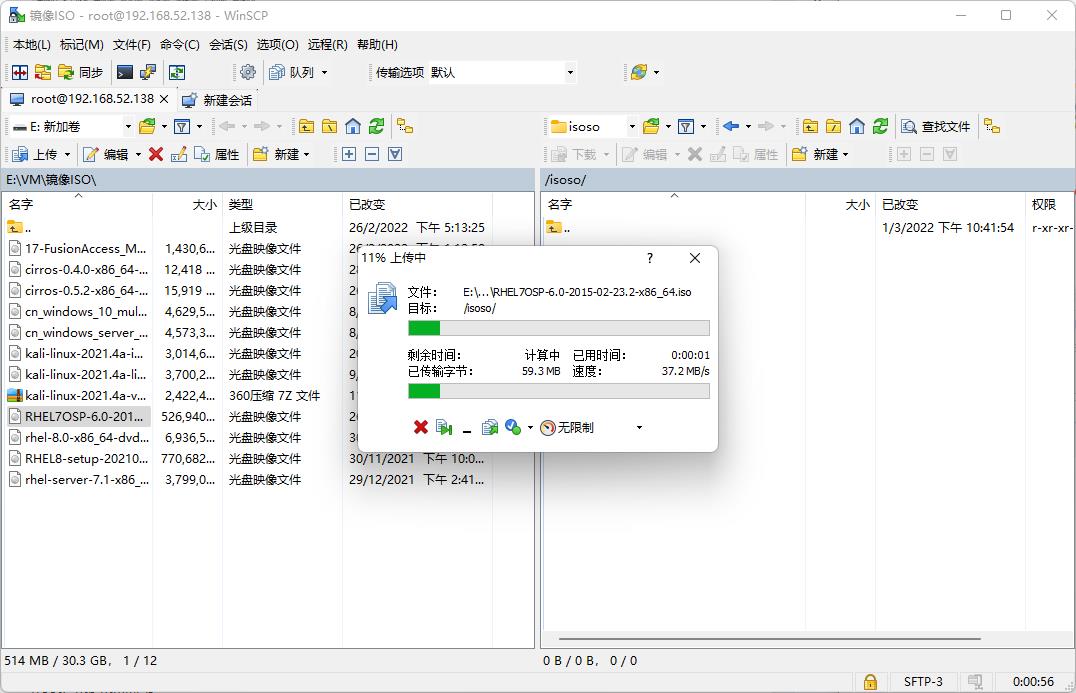

通过WinSCP软件把iso镜像上传到NTP服务器里面

创建临时目录存放iso文件

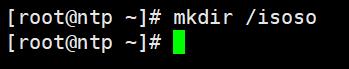

[root@ntp ~]# mkdir /isoso

上传iso到临时目录里面

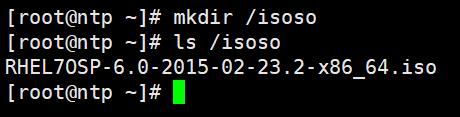

[root@ntp ~]# ls /isoso

把光盘内容进行永久挂载

[root@ntp ~]# cd /var/www/html/

[root@ntp html]# ls

[root@ntp html]# pwd

[root@ntp html]# mkdir openstack

[root@ntp html]# ls

[root@ntp html]# vi /etc/fstab

在/etc/fstab 中加入这行

/isoso/RHEL7OSP-6.0-2015-02-23.2-x86_64.iso /var/www/html/openstack iso9660 defaults 0 0

全部挂载

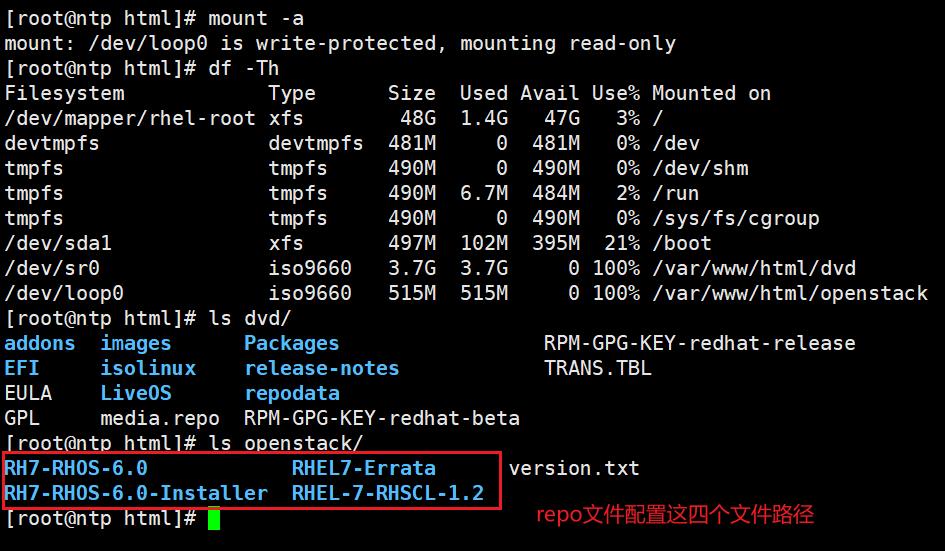

[root@ntp html]# mount -a

[root@ntp html]# df -Th

[root@ntp html]# ls dvd/

[root@ntp html]# ls openstack/

openstack里面有4个目录,意味着要配置4个路径,加上我们之前配置的os路径,一共配置5个。

切换到controller节点

在controller节点上配置好repo文件

[root@controller ~]# cd /etc/yum.repos.d/

[root@controller yum.repos.d]# vi dvd.repo

[dvd]

name=dvd

baseurl=http://192.168.52.138/dvd/

gpgcheck=0

enabled=1

[RH7-RHOS-6.0]

name=RH7-RHOS-6.0

baseurl=http://192.168.52.138/openstack/RH7-RHOS-6.0

gpgcheck=0

enabled=1

[RH7-RHOS-6.0-Installer]

name=RH7-RHOS-6.0-Installer

baseurl=http://192.168.52.138/openstack/RH7-RHOS-6.0-Installer

gpgcheck=0

enabled=1

[RHEL7-Errata]

name=RHEL7-Errata

baseurl=http://192.168.52.138/openstack/RHEL7-Errata

gpgcheck=0

enabled=1

[RHEL-7-RHSCL-1.2]

name=RHEL-7-RHSCL-1.2

baseurl=http://192.168.52.138/openstack/RHEL-7-RHSCL-1.2

gpgcheck=0

enabled=1

测试yum是否正常工作

yum repolist all

yum install -y readline*

readline包也正常安装成功

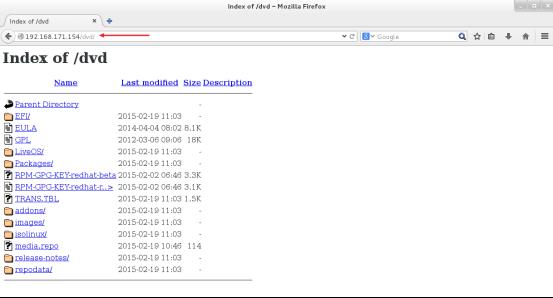

验证,在任意节点上打开一个网页,远程访问,如果可以放到到镜像文件,说明没问题。

[root@controller ~]# firefox http://192.168.171.154/openstack

[root@controller ~]# firefox http://192.168.171.154/dvd

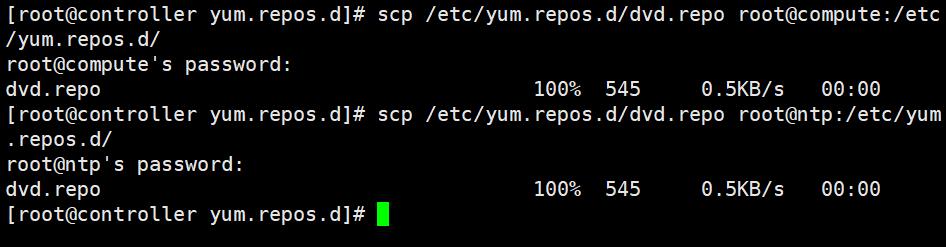

把repo文件复制到compute和ntp节点上

[root@controller ~]# scp /etc/yum.repos.d/dvd.repo root@compute:/etc/yum.repos.d/

[root@controller ~]# scp /etc/yum.repos.d/dvd.repo root@ntp:/etc/yum.repos.d/

7. 配置NTP服务(服务器端配置)

切换到ntp服务器

确认是否安装chrony包,如果没有/etc/chrony.conf就用yum安装chrony包,其他服务器同理

[root@ntp ~]# yum list all |grep chron

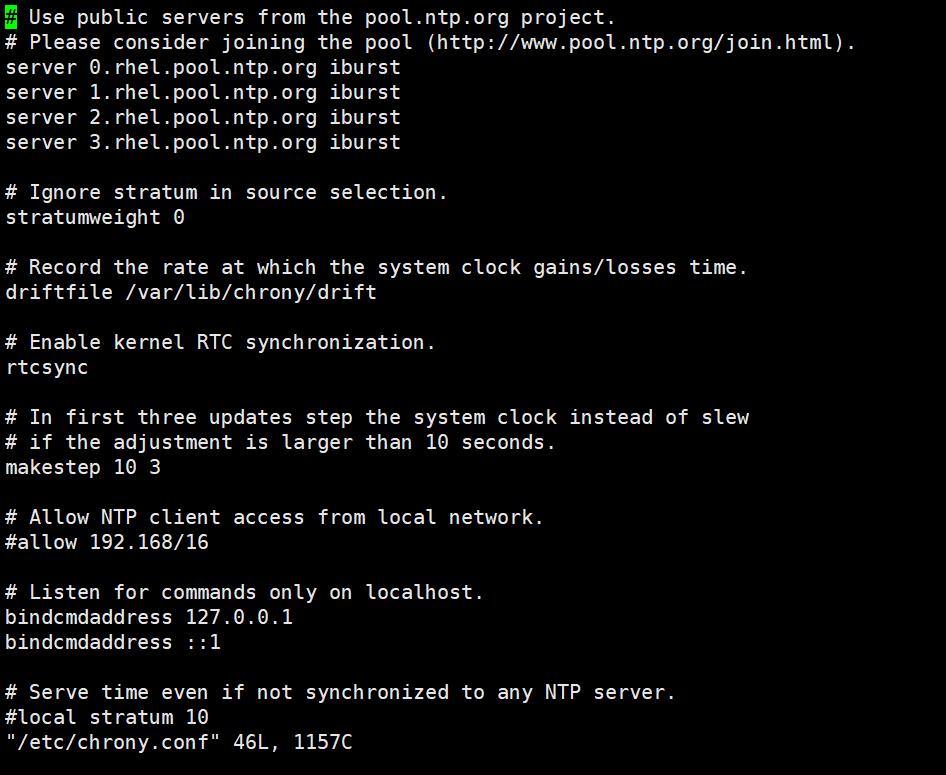

[root@ntp ~]# vi /etc/chrony.conf

安装:

[root@ntp ~]# yum install -y chron*

编辑的内容

#server 0.rhel.pool.ntp.org iburst

#server 1.rhel.pool.ntp.org iburst

#server 2.rhel.pool.ntp.org iburst

#server 3.rhel.pool.ntp.org iburst

allow 192.168.52/24

local stratum 10

改前:

改后:

保存并退出

启动服务

[root@ntp ~]# systemctl restart chronyd.service

[root@ntp ~]# systemctl enable chronyd

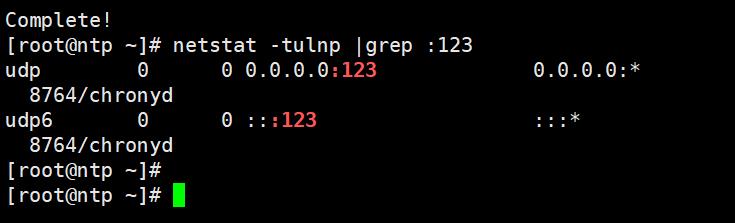

查看监听的端口号 :123

[root@ntp ~]# netstat -tulnp |grep :123

8. 配置NTP服务(客户器端配置)

切换至controller和compute

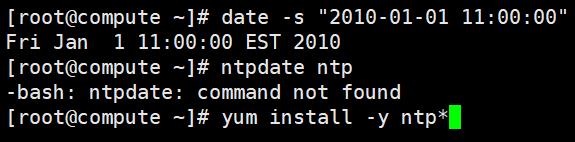

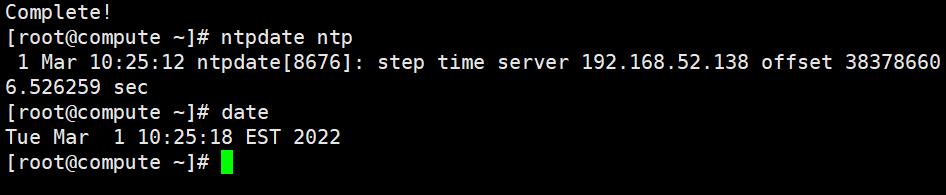

手工随便修改一个时间

然后进行手工同步

同步完成后,检查时间

[root@compute ~]# date -s "2010-01-01 11:00:00"

[root@compute ~]# ntpdate ntp

[root@compute ~]# date

但是每次手工同步都非常的麻烦,所以可以进行配置让它自动同步

[root@compute ~]# vi /etc/chrony.conf

编辑内容

#server 0.rhel.pool.ntp.org iburst

#server 1.rhel.pool.ntp.org iburst

#server 2.rhel.pool.ntp.org iburst

server ntp iburst

默认是每隔5分钟同步一次。

controller 和 compute 都要做时钟同步

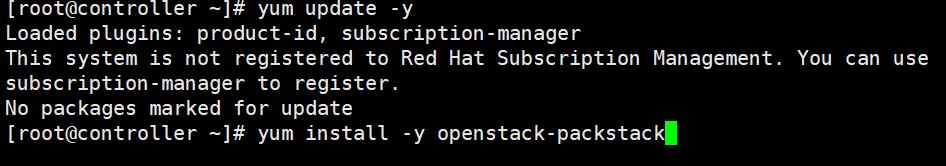

9. 在控制节点上部署PackStack

分别在三个节点上执行更新

[root@controller ~]# yum update -y

安装openstack-packstack

[root@controller ~]# yum install -y openstack-packstack

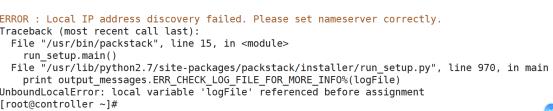

当安装好之后,就会有packstack这个工具,但是执行packstack --help的时候会报错:

这个错误是因为网卡信息里面没有配置DNS,即使我们用不到,但程序要检查。

我们配置DNS

[root@controller ~]# cd /etc/sysconfig/network-scripts/

[root@controller network-scripts]# vim ifcfg-eno16777736

–增加一行DNS–

DNS1=192.168.52.1

#重启网卡

[root@controller network-scripts]# service network restart

之后执行 packstack --help

10. 通过PackStack安装OpenStack

[root@controller ~]# packstack --help |grep ans

–gen-answer-file= 一个绝对路径

可以根据模板来生成一个应答文件,文件里面有安装所需要的所有参数,我们直接去更改文件里面的参数,然后执行这个文件就可以进行安装。

[root@controller ~]# packstack --gen-answer-file=/root/answers.txt

#执行上面命令就可以生成一个应答文件,然后修改这个文件:

[root@controller ~]# vim answers.txt

#修改的内容:(插入模式按/查找)

CONFIG_NTP_SERVERS=192.168.52.138

CONFIG_COMPUTE_HOSTS=192.168.52.136,192.168.52.137

CONFIG_KEYSTONE_REGION=WuHan

CONFIG_KEYSTONE_ADMIN_PW=redhat

CONFIG_HORIZON_SSL=y

CONFIG_PROVISION_DEMO=n

参数配置好之后,就可以直接运行(这时候运行可能会报错mariadb)

[root@controller ~]# packstack --answer-file=/root/answers.txt

会报错:依赖关系包的问题

解决方案:删除,重新安装,然后再次执行

[root@controller ~]# yum remove mariadb

[root@controller ~]# yum install -y mariadb mariadb-server

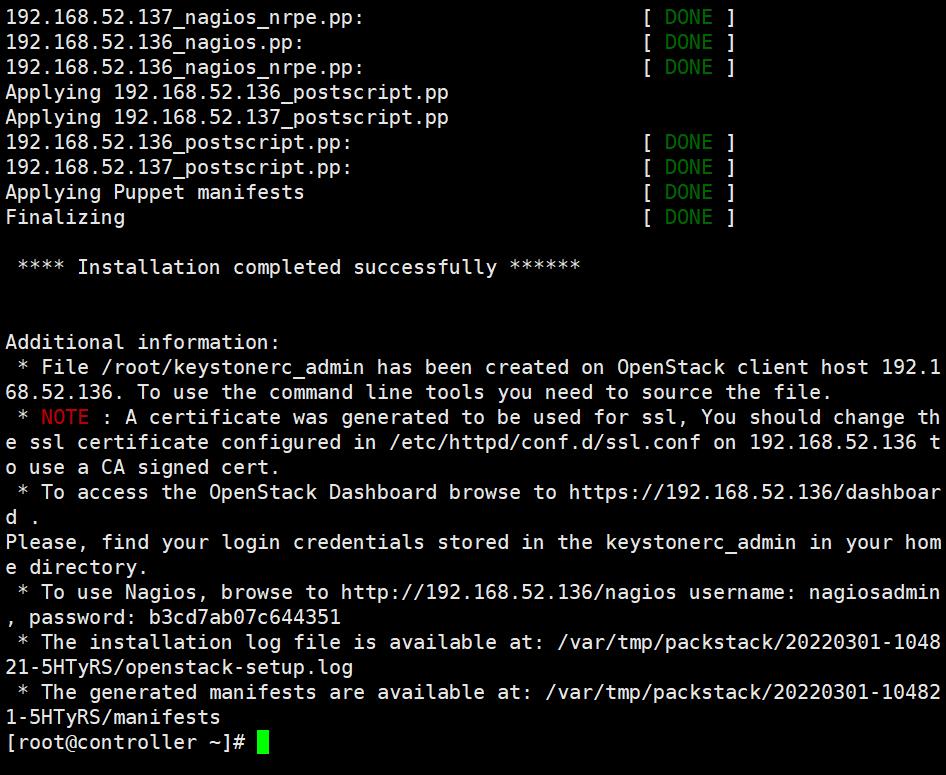

[root@controller ~]# packstack --answer-file=/root/answers.txt

安装成功

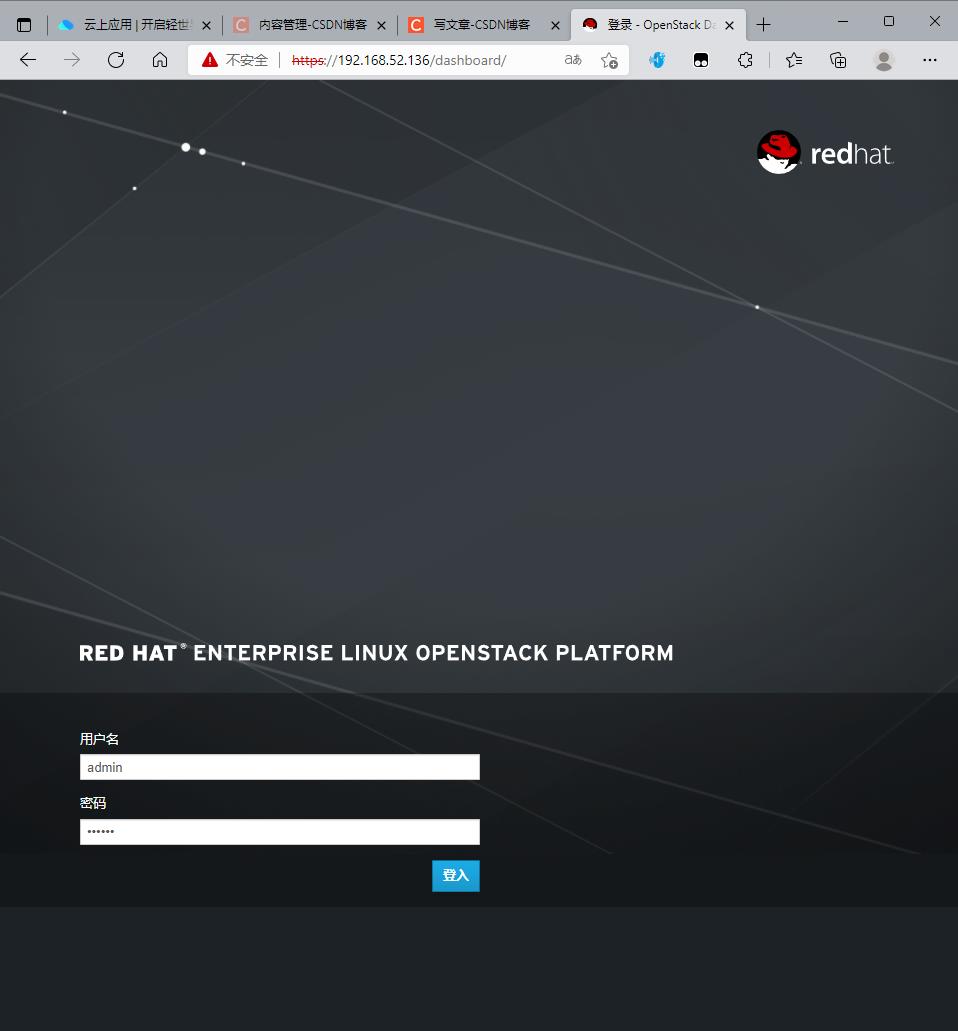

访问192.168.52.136/dashboard/出现如下界面

账号:admin

密码:redhat

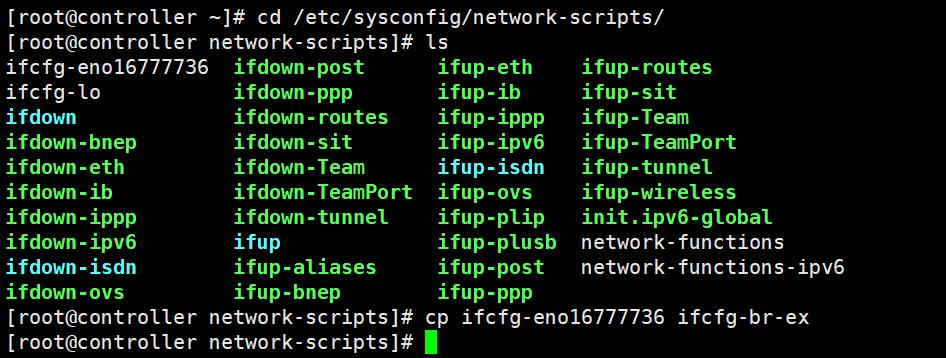

11. 配置网卡信息OVS

[root@controller ~]# cd /etc/sysconfig/network-scripts/

[root@controller network-scripts]# cp ifcfg-eno16777736 ifcfg-br-ex

首先改br-ex

原始网络配置信息

YPE=Ethernet

BOOTPROTO=none

DEFROUTE=yes

IPV4_FAILURE_FATAL=no

IPV6INIT=yes

IPV6_AUTOCONF=yes

IPV6_DEFROUTE=yes

IPV6_FAILURE_FATAL=no

NAME=eno16777736

UUID=172575e6-5ce9-4996-ad28-0cb6bd81fc22

DEVICE=eno16777736

ONBOOT=yes

IPADDR=192.168.52.136

PREFIX=24

GATEWAY=192.168.52.254

DNS1=192.168.52.1

IPV6_PEERDNS=yes

IPV6_PEERROUTES=yes

IPV6_PRIVACY=no

把所有IPV4和IPV6开头的都删除掉

开始更改:

TYPE=OVSBridge

BOOTPROTO=none

DEFROUTE=yes

#IPV4_FAILURE_FATAL=no

#IPV6INIT=yes

#IPV6_AUTOCONF=yes

#IPV6_DEFROUTE=yes

#IPV6_FAILURE_FATAL=no

NAME=br-ex

UUID=172575e6-5ce9-4996-ad28-0cb6bd81fc22

DEVICE=br-ex

DEVICETYPE=ovs

ONBOOT=yes

IPADDR=192.168.52.136

PREFIX=24

GATEWAY=192.168.52.254

DNS1=192.168.52.1

#IPV6_PEERDNS=yes

#IPV6_PEERROUTES=yes

#IPV6_PRIVACY=no

然后修改物理网卡信息:

[root@controller network-scripts]# vi ifcfg-eno16777736

原始信息

TYPE=Ethernet

BOOTPROTO=none

DEFROUTE=yes

IPV4_FAILURE_FATAL=no

IPV6INIT=yes

IPV6_AUTOCONF=yes

IPV6_DEFROUTE=yes

IPV6_FAILURE_FATAL=no

NAME=eno16777736

UUID=172575e6-5ce9-4996-ad28-0cb6bd81fc22

DEVICE=eno16777736

ONBOOT=yes

IPADDR=192.168.52.136

PREFIX=24

GATEWAY=192.168.52.254

DNS1=192.168.52.1

IPV6_PEERDNS=yes

IPV6_PEERROUTES=yes

IPV6_PRIVACY=no

~

删除所有IPV4和IPV6,以及IP地址、子网掩码、DNS

之后修改:注意,DEVICETYPE,OVS_BRIDGE需要手工添加

TYPE=OVSPort

BOOTPROTO=none

DEFROUTE=yes

#IPV4_FAILURE_FATAL=no

#IPV6INIT=yes

#IPV6_AUTOCONF=yes

#IPV6_DEFROUTE=yes

#IPV6_FAILURE_FATAL=no

NAME=eno16777736

UUID=172575e6-5ce9-4996-ad28-0cb6bd81fc22

DEVICE=eno16777736

DEVICETYPE=ovs

DEVICEBRIDGE=br-ex

ONBOOT=yes

#IPADDR=192.168.52.136

#PREFIX=24

#GATEWAY=192.168.52.254

#DNS1=192.168.52.1

#IPV6_PEERDNS=yes

#IPV6_PEERROUTES=yes

#IPV6_PRIVACY=no

~

~

配置好之后,使用命令查看

[root@controller ~]# ovs-vsctl show

重启网卡:

service network restart

以上是关于云计算HCIP实验-OpenStack搭建的主要内容,如果未能解决你的问题,请参考以下文章