Transformer 五年引用超四万,其中六位作者创立五家创业公司

Posted Charmve

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Transformer 五年引用超四万,其中六位作者创立五家创业公司相关的知识,希望对你有一定的参考价值。

点击上方“迈微AI研习社”,选择“星标★”公众号

重磅干货,第一时间送达

选自丨机器之心

时隔五年,Transformer 的八位作者仅有一位还留在谷歌。

如果你在一家大厂做出了一份行业里程碑式的研究,那么接下来的职场生涯你会怎么走?继续留在这家大厂?换一家待遇更好的大厂?还是创业或加入有前景的创业公司?

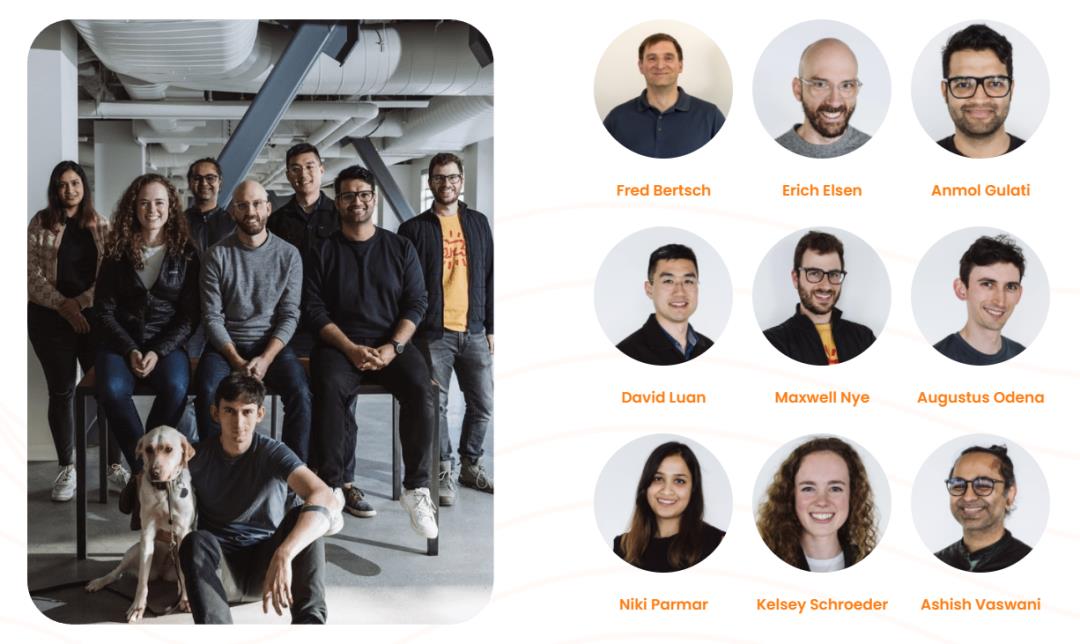

Transformer(出自论文《Attention Is All You Need》)几位作者的选择或许有一定的代表性:其中六人选择创业或加入创业公司,只有一人选择继续留在谷歌,还有一位去了 OpenAI。

图源:推特用户 @Nathan Benaich。

这篇重要论文发表于 2017 年,如今引用量已经突破 41000。论文注释中写道,几位作者对这份研究做出了不同但同等重要的贡献(排名随机)。具体来说,他们的分工可以概括为:

Jakob 提出用自注意力替代 RNN,并开始努力尝试这一想法;

Ashish 和 Illia 一起设计并实现了第一批 Transformer 模型,并重度参与了 Transformer 架构的各方面工作;

Noam 提出了缩放点积注意力、多头注意力和无参数位置表示,并成为几乎每一个细节的参与者;

Niki 在原始代码库和 tensor2tensor 中设计、实现、调优和评估了无数的模型变量;

Llion 还尝试了新的模型变体,负责初始代码库以及高效的推理和可视化;

Lukasz 和 Aidan 花了无数天的时间来设计和实现 tensor2tensor 的各个部分,替换了早期的代码库,极大地改善了结果、加速了研究进度。

可以说,每位作者都有自己擅长的工作,对于行业也都有自己的预判。论文发表五年之后,他们都在做什么呢?以下是我们能够查到的信息。

Ashish Vaswani、 Niki Parmar:投身通用智能

2022 年 4 月 26 日,一家名为「Adept」的公司官宣成立,共同创始人有 9 位,其中就包括 Ashish Vaswani 和 Niki Parmar。

Ashish Vaswani 在南加州大学拿到博士学位,师从华人学者蒋伟(David Chiang)和黄亮(Liang Huang),主要研究现代深度学习在语言建模中的早期应用。2016 年,他加入了谷歌大脑并领导了 Transformer 的研究。

Niki Parmar 硕士毕业于南加州大学,2016 年加入谷歌。工作期间,她为谷歌搜索和广告研发了一些成功的问答和文本相似度模型。她领导了扩展 Transformer 模型的早期工作,将其扩展到了图像生成、计算机视觉等领域。

Ashish Vaswani、Niki Parmar 等人共同创立的 Adept 是一家致力于用 AI 来增强人类能力并最终实现通用智能的公司。在阐述公司创立初衷时,创始人写道,「在谷歌,我们训练出了越来越大的 Transformer,梦想着有朝一日构建一个通用模型来支持所有 ML 用例。但是,这其中有一个明显的局限:用文本训练出的模型可以写出很棒的文章,但它们无法在数字世界中采取行动。你不能要求 GPT-3 给你订机票,给供应商开支票,或者进行科学实验。」

因此,他们打算创建一个通用系统,帮助人们在电脑前完成工作,「你可以把它想象成你电脑里的一个 overlay,它和你一起工作,使用和你一样的工具。使用 Adept,你能专注于你真正喜欢的工作,并要求模型承担其他任务。例如,你可以要求模型生成月度合规报告,所有这些都使用现有的软件,如 Airtable、Photoshop、ATS、Tableau、Twilio。」

Noam Shazeer:神秘创业者

Noam Shazeer 是谷歌最重要的早期员工之一。他在 2000 年底加入谷歌,直到 2021 年最终离职。

曾经,Noam Shazeer 和同事 Georges Harik 花了数年时间分析网页上的数据,理解词组及其协同工作原理。他们收集的数据最终被谷歌用于其 AdSense 产品,该产品会分析网页的文字内容并在上面贴广告。

2021 年,Noam Shazeer 成为了一家隐形初创企业的 CEO,名字叫做「CharacterAI」,关于这家公司的组织架构和业务模式,外界不甚了解。

Jakob Uszkoreit:发明「Transformer」名字的人,转向分子设计

2021 年,Jakob Uszkoreit 和 Rhiju Das 共同创立了 Inceptive,致力于通过高度可扩展的实验和深度学习的奇异结合来实现下一代 RNA 分子的设计。

在谷歌工作期间,Jakob Uszkoreit 参与了组建谷歌助理的语言理解团队,早期还曾从事过谷歌翻译的工作。

在当时《Attention Is All You Need》这项研究中,Vaswani 曾表示:「注意力网络听起来并不吸引人。」

最后,Jakob Uszkoreit 想出了「Transformer」这个名字:「我认为我们正在 transform 某些东西,当然,这只是在玩梗。」

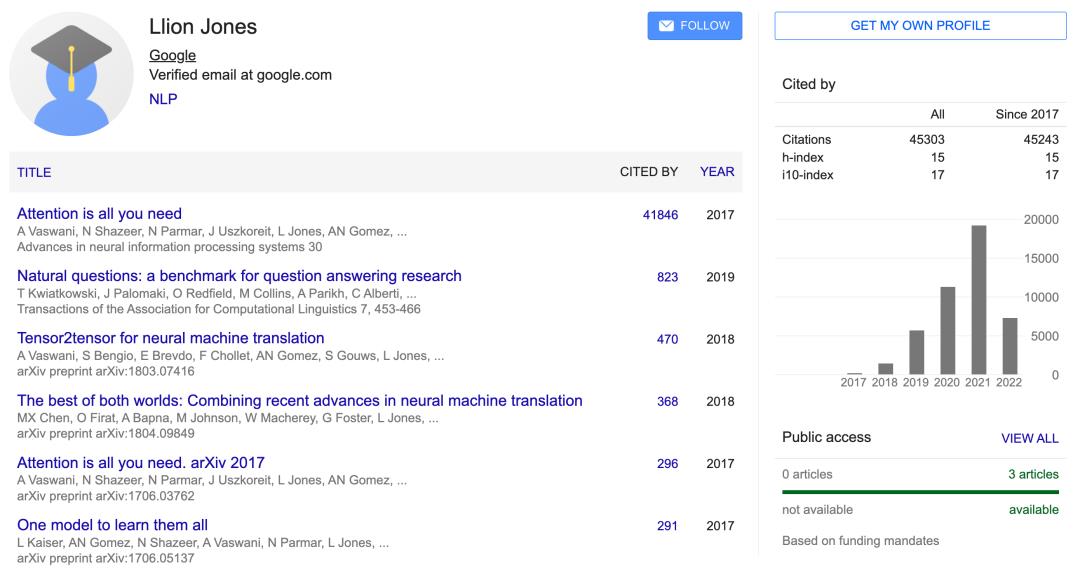

Llion Jones:在谷歌开启下一个十年?

Llion Jones 是目前 Transformer 作者团队唯一还留在谷歌工作的人。

他在英国圭内斯郡南部的 Abergynolwyn 长大,来到谷歌山景城园区之后,他曾感慨:「现在我工作地方的人数,几乎是我长大的村庄里的 100 倍。」

Llion Jones 现年 36 岁,曾在 Abergynolwyn 生活多年,完成在 Coleg Meirion-Dwyfor 的学业之后,他在伯明翰大学获得了计算机科学硕士学位。

但在毕业后的一段时间内,Llion Jones 没找到合适的工作。他曾经将简历投递给谷歌在伦敦的办公室,且经过了两轮电话面试。由于档期问题,Llion Jones 在收到谷歌的最终 offer 之前,已经入职了另外一家公司。

不过,18 个月之后,另一位谷歌招聘人员联系了他,Llion Jones 成为了一名谷歌人。从 2012 年开始,Llion Jones 一直在谷歌工作。这一任职时长差不多超过了谷歌九成员工。

Aidan N. Gomez:创立 NLP 平台,一年融资 1.7 亿美元

2021 年 5 月,Aidan N. Gomez 官宣成立新公司——自然语言处理平台Cohere,基于自己训练的大型 NLP 模型为外界提供 API 服务。

Aidan Gomez 本科就读于多伦多大学,是牛津大学 Yarin Gal 和 Yee Whye Teh 的博士生,曾在谷歌大脑团队的 Geoffrey Hinton 和 Lukasz Kaiser 组内工作。

这家公司的投资阵容颇为豪华:早期投资者包括图灵奖得主 Geoffrey Hinton、GAN 之父 Ian Goodfellow、Uber 首席科学家 Raquel Urtasun、英伟达多伦多研究实验室主任 Sanja Fidler 以及斯坦福大学教授李飞飞等。

GPT-3 等模型的问世让人们看到了大规模预训练语言模型的潜力,也在国内外掀起了一场创业热潮。Cohere 团队的创始成员也都是预训练模型领域的资深研究者。但他们注意到,由于技术门槛过高,大多数人(包括普通开发人员)根本无法使用这项技术,因此他们致力于改变这一现状。

Aidan Gomez 曾表示,为了达成这一使命,他们训练了一个数十亿(未来可能数千亿)参数的语言模型。利用该模型的 API,我们可以完成文本补全、从文本中提取有语义意义的向量、测量段落语义相似性等任务。用户只需要在自己的系统中载入三行代码就可以调用该模型的能力。「无论你是前端还是后端的开发人员,无论你是做 web 还是移动,任何人都可以将 NLP 构建到应用程序中。」Aidan Gomez 在采访中说到。

如今,虽然仅创立一年,这家公司已经拿到了 1.7 亿美元的融资。

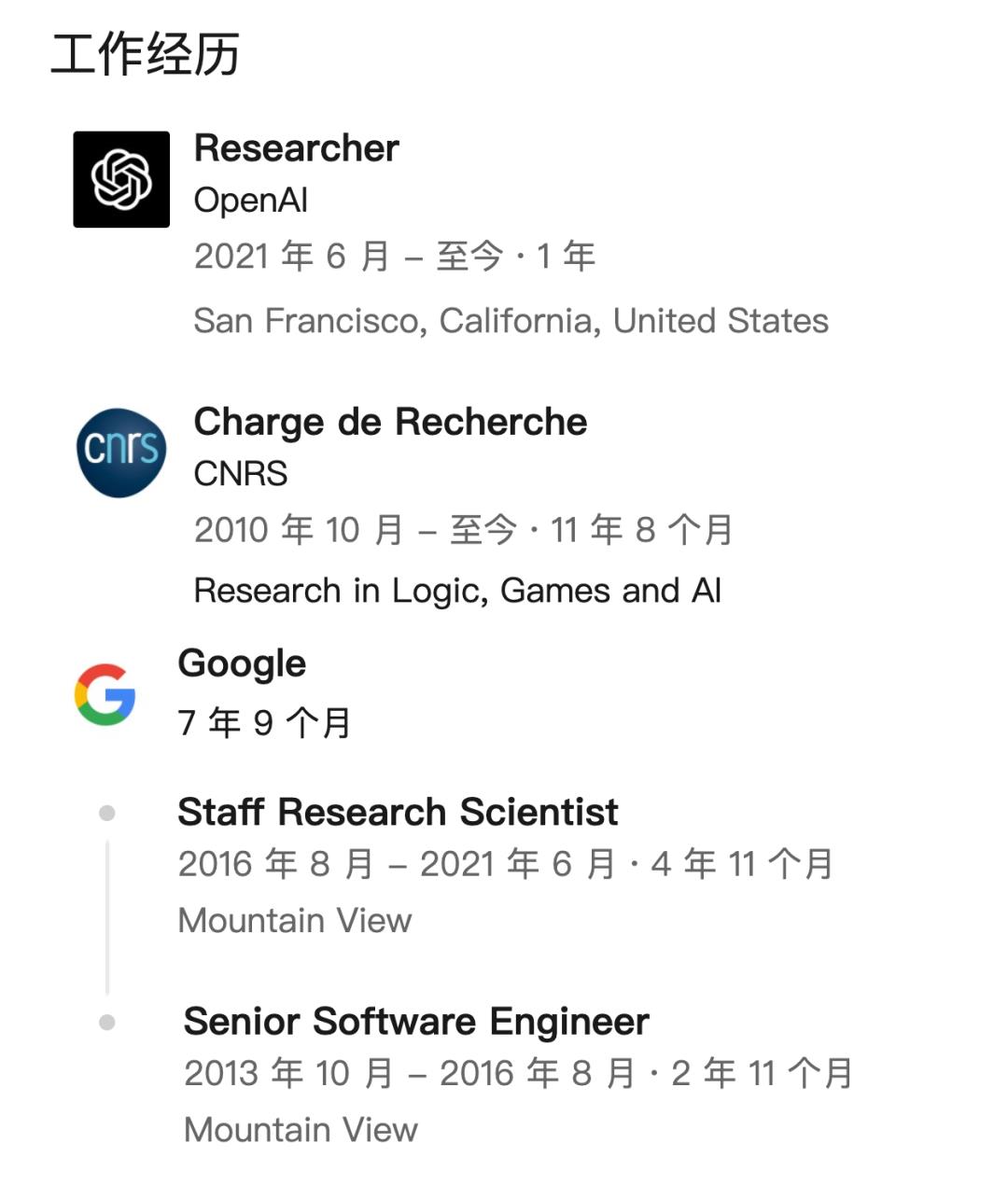

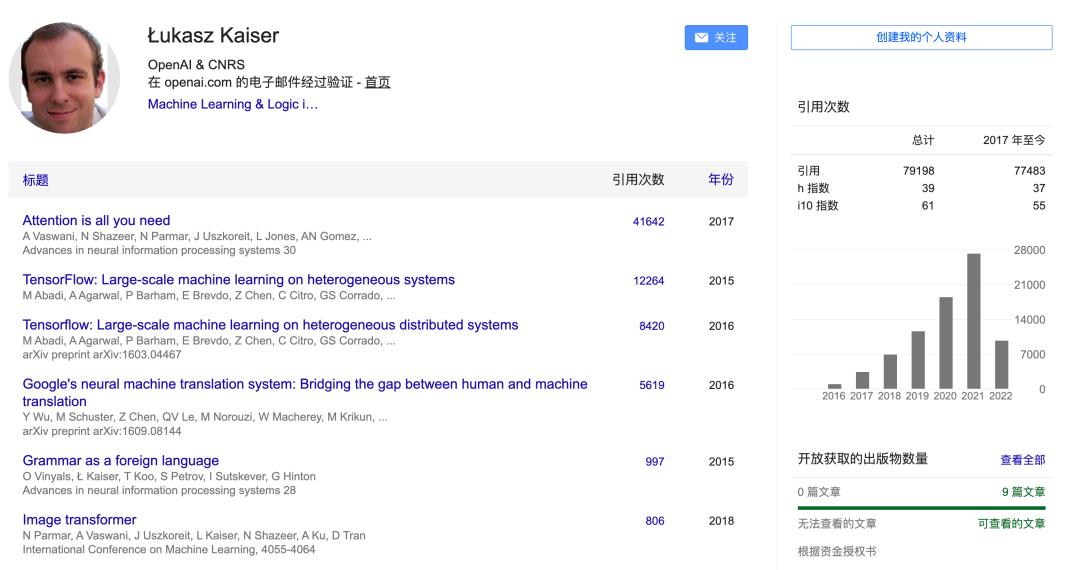

Lukasz Kaiser:跳槽 OpenAI

2021 年 6 月,Lukasz Kaiser 从谷歌跳槽到了 OpenAI。

在 2013 年加入谷歌之前,Lukasz Kaiser 是巴黎狄德罗大学的终身研究员,从事逻辑和自动机理论研究。他于 2008 年在亚琛工业大学获得博士学位,在波兰弗罗茨瓦夫大学获得硕士学位。

Lukasz Kaiser 的研究领域包括深度学习和自然语言处理,在谷歌担任研究科学家期间,他参与了机器翻译、解析及其他算法和生成任务的 SOTA 神经模型设计,是 TensorFlow 系统、Tensor2Tensor 库的共同作者。

他的研究工作还包括使用可满足性求解器和其他符号方法来构建游戏系统和解决程序合成问题,证明关于描述复杂性、博弈论和解决长期未解决问题的自动机的定理。

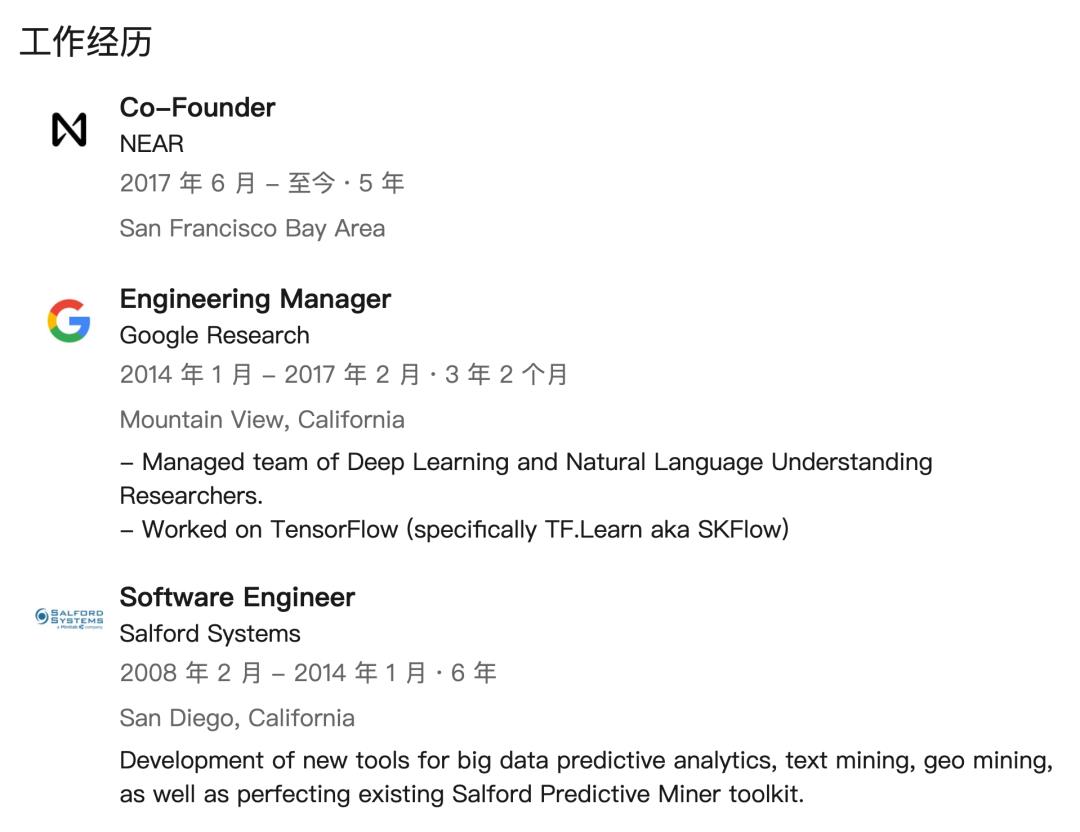

Illia Polosukhin:华丽变身区块链创业大佬

Illia Polosukhin 现在是 NEAR.AI 的联合创始人及 CTO。

Illia Polosukhin 来自乌克兰,在哈尔科夫国立技术大学获得了应用数学和计算机科学硕士学位。移居加利福尼亚之后,他参与了各种机器学习项目,并加入了谷歌研究院,仅用一年就成为了工程主管。

三年后,他决定和 Alexander Skidanov 共同创办 NEAR.AI:「我们坚信『程序合成』这一从人类规范出发研究自动化编程的领域将改变软件开发和整个世界。」

但随着创业过程的深入,他们意识到,即使专注于简单的问题,任务描述也很复杂。描述中使用的概念和语言种类繁多,模型无法捕捉,一些问题也需要逻辑推理步骤和外部数学知识。他们发现,之前的研究结果在实践中尚不可用(最佳模型的准确率约为 12%),机器学习特别是自然语言理解的转折点,似乎还没有出现。

后来,NEAR.ai 这家公司开始转向区块链。Illia 在一篇有关公司转型的博客中写道:

1、考虑到我们在程序合成方面所做的工作,顾问建议我们把研究方向改成为以太坊生成智能合约。目前,普通工程师很难编制可证明的合同,程序合成可以有效解决这个问题;

2、在与想要开发应用程序的人谈过之后,我们逐渐了解到,他们对于「使用区块链构建应用程序,以提供金钱激励和更好的隐私和安全」非常关注。

自此,公司正式改名为 NEAR Protocol。他们组建了一支优秀的人才队伍,包括 3 名 ICPC 金牌得主、3 名 MemSQL 工程师、4 名前谷歌员工,并正在邀请 Web3 领域的专家加入公司。

目前,NEAR Protocol 已经成为一家区块链分布式协议提供商,基于一种名为 Nightshade 的分片方法和共识机制,致力于开发区块链底层架构与 DApp 开发平台,并为开发人员提供事务、智能合约帐户和 gas 费用回扣等协议级别工具。前段时间,该公司宣布完成 3.5 亿美元的最新一轮融资。

© THE END

投稿或寻求报道微信:MaiweiE_com

今年我在GitHub中文开源项目《计算机视觉实战演练:算法与应用》,“免费”“全面“”前沿”,以实战为主,编写详细的文档、可在线运行的notebook和源代码。一经发布连续两周蝉联GitHub中文榜。

项目地址 https://github.com/Charmve/computer-vision-in-action

项目主页 https://charmve.github.io/L0CV-web/

推荐阅读

(更多“抠图”最新成果)

迈微AI研习社

微信号: MaiweiE_com

GitHub: @Charmve

CSDN、知乎: @Charmve

投稿: yidazhang1@gmail.com

主页: github.com/Charmve

如果觉得有用,就请点赞、转发吧!

以上是关于Transformer 五年引用超四万,其中六位作者创立五家创业公司的主要内容,如果未能解决你的问题,请参考以下文章