论文阅读 ActionCLIP: A New Paradigm for Video Action Recognition

Posted WXiujie123456

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了论文阅读 ActionCLIP: A New Paradigm for Video Action Recognition相关的知识,希望对你有一定的参考价值。

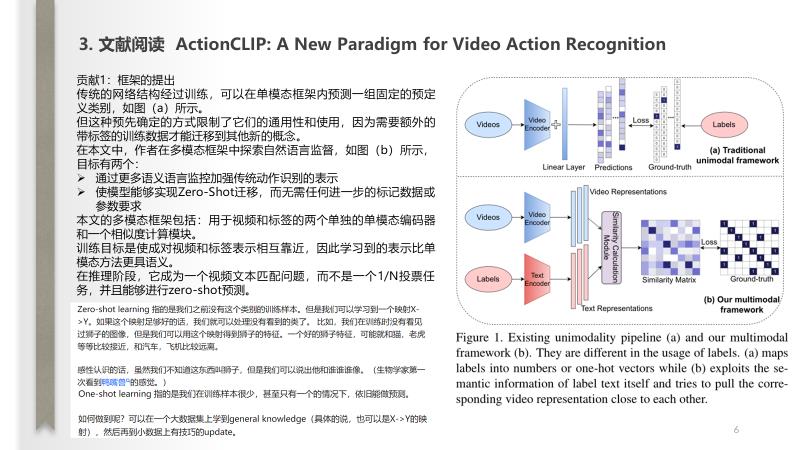

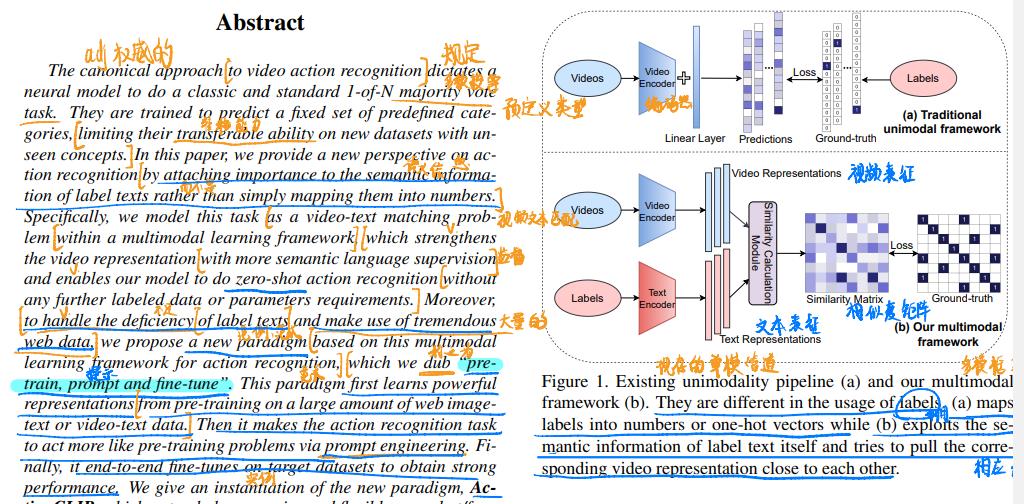

ActionCLIP: A New Paradigm for Video Action Recognition

Computer Vision and Pattern Recognition 2021 浙江大学

task

视频动作识别

阅读记录

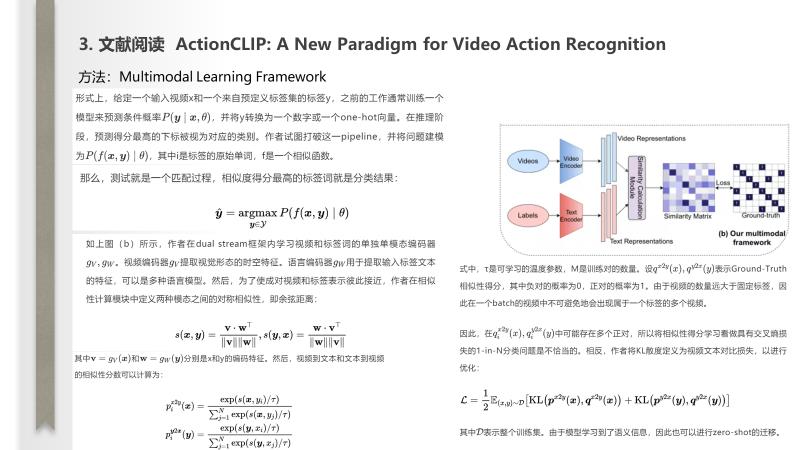

量化两种概率分布P和Q之间差异的方式,又叫相对熵。在概率学和统计学上,我们经常会使用一种更简单的、近似的分布来替代观察数据或太复杂的分布。K-L散度能帮助我们度量使用一个分布来近似另一个分布时所损失的信息量。

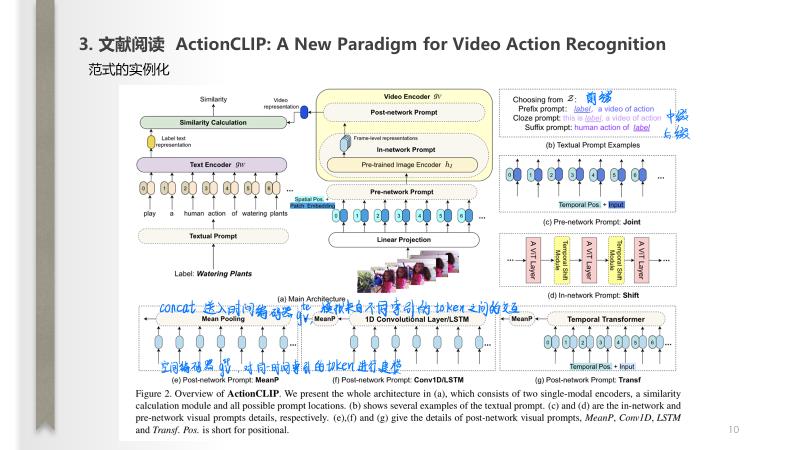

作者采用了预训练的模型CLIP,以避免在第一个预训练步骤中产生巨大的计算资源。因此,此实例化模型称为ActionCLIP,如上图(a)所示。

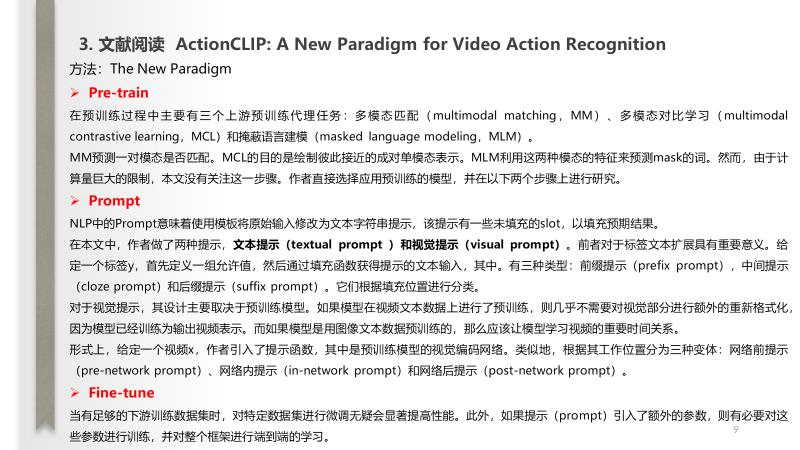

Pre-network Prompt:如上图(c)所示,该类型在送入编码器之前对输入进行操作。空间位置嵌入,额外的可学习时间位置嵌入(指示帧索引)。可以使用原始预训练图像编码,这种方式简称为Joint。

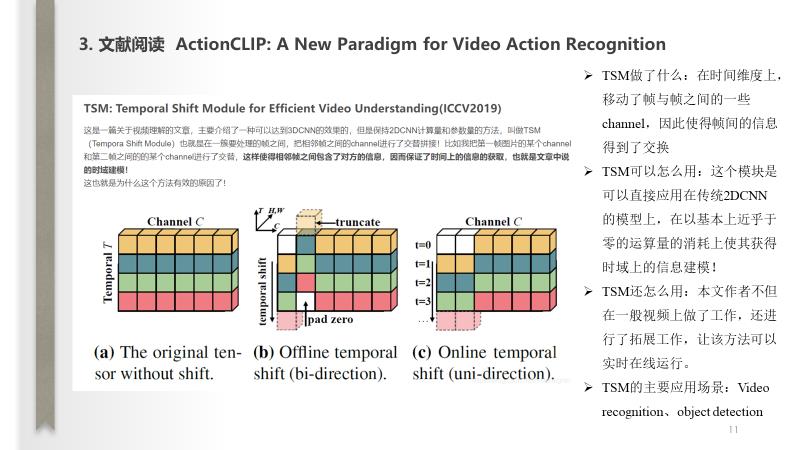

In-network Prompt:如上图(d)所示,这是一种parameter-free prompt,简称为Shift。作者引入了时间移位模块,该模块沿时间维度移动部分特征通道,并促进相邻输入帧之间的信息交换。作者在每两个相邻的层之间插入模块。gv的结构和预训练的权重可以直接重用,该模块不带任何参数。

Post-network prompt:给定一个具有提取帧的视频x,作者使用两个单独的编码器顺序编码空间和时间特征。第一个是空间编码器gv(sp),它只负责对从同一时间索引中提取的token之间的交互进行建模。提取的帧级表示为u_i,然后将concat成,然后送到时间编码器,以模拟来自不同时间索引的token之间的交互。作者为提供四种选择(MeanP。Conv1D,。LSTM,Transf),如上图(e-g)所示。MeanP是时间维度上的平均池化的缩写。Conv1D是应用于时间维度上的1D卷积层。LSTM是一个递归神经网络,Tran为时间视觉Transformer编码器。

说明

以上内容均为作者本人平时阅读并且汇报使用,内容整理全凭个人理解,如有侵权,请联系我;内容如有错误,欢迎留言交流。转载请注明出处,并附有原文链接,谢谢!

此外,我还喜欢用ipad对论文写写画画(个人英文阅读的水平有限),做一些断句、重点勾画等,有兴趣大家可以按需下载:链接

更多论文分享,请参考: 深度学习相关阅读论文汇总(持续更新)

以上是关于论文阅读 ActionCLIP: A New Paradigm for Video Action Recognition的主要内容,如果未能解决你的问题,请参考以下文章