sklearn学习8-----GridSearchCV(自动调参)

Posted lee-yl

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了sklearn学习8-----GridSearchCV(自动调参)相关的知识,希望对你有一定的参考价值。

一、GridSearchCV介绍:

自动调参,适合小数据集。相当于写一堆循环,自己设定参数列表,一个一个试,找到最合适的参数。数据量大可以使用快速调优的方法-----坐标下降【贪心,拿当前对模型影响最大的参数调优,直到最优,但可能获得的是全局最优】。

二、参数使用

class sklearn.model_selection.GridSearchCV(estimator, param_grid, scoring=None, fit_params=None, n_jobs=1, iid=True, refit=True, cv=None, verbose=0, pre_dispatch=‘2*n_jobs’, error_score=’raise’, return_train_score=’warn’)

- estimator:所使用的分类器,比如:estimator=RandomForestClassifier(min_samples_split=100, min_samples_leaf=20, max_depth=8, max_features=‘sqrt‘, random_state=10),并且传入除需要确定最佳的参数之外的其他参数。每个分类器都需要一个scoring参数或者score方法。

- param_grid:值为字典或列表,即需要最优化的参数的取值,param_grid =param_test1,param_test1 = {‘n_estimators‘:range(10,71,10)}

- scoring:准确评价标准,默认为None(使用estimator的误差估计函数),这时需要使用score函数;或者如scoring=‘roc_auc‘,根据所选模型不同,评价准则不同。

- cv:交叉验证参数,默认为None

- refit:默认为True,程序将会以交叉验证训练集得到的最佳参数,重新对所有可用的训练集与测试集进行,作为最终用于性能评估的最佳模型参数。即在搜索参数结束后,用最佳参数结果再次fit一遍全部数据集。

-

iid:默认True,为True时,默认为各个样本fold概率分布一致,误差估计为所有样本之和,而非各个fold的平均。

-

verbose:日志冗长度,int:冗长度,0:不输出训练过程,1:偶尔输出,>1:对每个子模型都输出。

-

n_jobs: 并行数,int:个数,-1:跟CPU核数一致, 1:默认值。

-

pre_dispatch:指定总共分发的并行任务数。当n_jobs大于1时,数据将在每个运行点进行复制,这可能导致OOM,而设置pre_dispatch参数,则可以预先划分总共的job数量,使数据最多被复制pre_dispatch次,进行预测的常用方法和属性

-

grid.fit():运行网格搜索

-

grid_scores_:给出不同参数情况下的评价结果

-

best_params_:描述了已取得最佳结果的参数的组合

-

best_score_:成员提供优化过程期间观察到的最好的评分

三、属性方法:

- grid.fit( train_x, train_y ):运行网格搜索

- grid_scores_:给出不同参数情况下的评价结果

- best_params_:描述了已取得最佳结果的参数的组合

- best_score_:成员提供优化过程期间观察到的最好的评分

四、示例:

from sklearn.grid_search import GridSearchCV

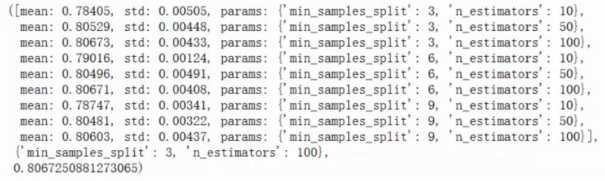

#随机森林的参数 tree_param_grid={‘min_sample_split‘:list((3,6,9)),‘n_estimators‘:list((10,50,100)) grid=GridSearchCV(RandomForestRegressor(),param_grid=tree_param_grid,cv=5) grid.fit(x,y) grid.grid_scores_,grid.best_params_,grid.best_score_

结果:

以上是关于sklearn学习8-----GridSearchCV(自动调参)的主要内容,如果未能解决你的问题,请参考以下文章