单目全向立体相机的标定(一种新的相机形式)

Posted Being_young

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了单目全向立体相机的标定(一种新的相机形式)相关的知识,希望对你有一定的参考价值。

点云PCL免费知识星球,点云论文速读。

文章:Calibration Method of the Monocular Omnidirectional Stereo Camera

作者:Ryota Kawamata Keiichi Betsui Kazuyoshi Yamazaki Rei Sakakibara Takeshi Shimano

编译:点云PCL

欢迎各位加入免费知识星球,获取PDF论文,欢迎转发朋友圈。文章仅做学术分享,如有侵权联系删文。未经博主同意请勿擅自转载。

论文阅读模块将分享点云处理,SLAM,三维视觉,高精地图相关的文章。公众号致力于理解三维视觉领域相关内容的干货分享,欢迎各位加入我,我们一起每天一篇文章阅读,开启分享之旅,有兴趣的可联系微信dianyunpcl@163.com。

摘要

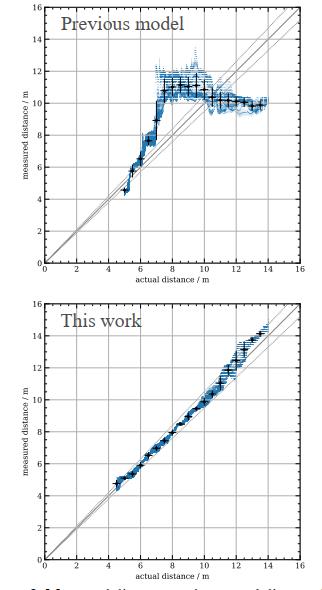

为了在自动驾驶拍摄图像并360度范围的测量物体的距离,需要小巧且低成本的设备,我们一直在开发一种全景立体相机,利用两个双曲面镜和一组镜头和传感器,这使得这款相机结构紧凑,成本低廉。这里我们建立了一种新的相机标定方法,该方法考虑了高阶径向畸变、切向畸变、图像传感器倾斜和透镜-镜面的偏移,我们的方法将上视图和下视图图像的校准误差分别降低了6.0倍和4.3倍,距离测量的随机误差为4.9%,相距14米的物体的系统误差为5.7%,与传统方法相比提高了近9倍,距离误差是由于原型的光学分辨率降低,我们计划在未来的工作中进一步改进。

主要贡献

自动驾驶汽车需要感知周围环境,例如接近的汽车和行人,因此,需要传感器来检测和测量360度范围物体的距离,该传感器的要求是大视场(FoV),能够检测物体,足够的距离精度,以及可承受的成本。一些研究和公司尝试使用激光雷达(光探测和测距)和相机的组合来满足这些要求。在激光雷达的系统中,激光雷达能够提供大视场和1 cm的极高距离精度,相机提供用于目标检测的图像,然而,该系统的主要问题是成本高,这激光雷达的高成本是该系统成为自动驾驶中的最大挑战之一,另一种方案则选择是采用双目立体摄像机,立体摄像机能够使用图像检测物体,并能够计算出适当精度的物体距离,由于单台相机的视场限制在120度左右,因此一种可能的解决方案是在一辆车周围放置多台相机,以实现更大的视场,然而,这使得系统变得昂贵和复杂。解决这个问题的一个可能方法是扩大单个立体相机的视场,为此,我们开发了一种具有新型光学系统的全向立体相机,其设计见我们之前的研究(3,4)。该相机由两个双面双曲镜、一个广角镜头和一个图像传感器组成,该系统满足上述所有要求,首先,双曲面镜可以实现360度的大视场,第二,由于这是一个立体相机,可以同时获得目标检测图像和距离信息,第三,该相机仅利用一组镜头和传感器从两个视点获取立体视觉所需的图像,从而节省了一组镜头和传感器的成本,此外,作为实现360度视野的一种方式,双曲线镜与鱼眼透镜相比具有成本效益,该光学系统设计用于满足14米距离物体5%的距离误差,当带有此摄像头的自动驾驶汽车进入十字路口时,此功能足以定位十字路口的物体,包括其他车辆和行人。

这里还需要开发一种新的校准方法,对传感器图像进行畸变校正,以获得准确的距离信息,因为光学系统非常新颖,FoV比普通透视相机大得多,Zhang提出了一种使用棋盘的方法,可以灵活地放置棋盘,这是一种简单校准方法,Mei和Rives将张的方法扩展到全方位相机,包括使用双曲镜的相机,由于我们的光学系统是由两个双曲面镜和一个广角成像透镜组合而成,因此他们的方法基本上可以应用于我们的系统,但是,它不处理广角成像镜头和系统的一些失真,校准不足也会导致距离信息不准确甚至丢失。

主要内容

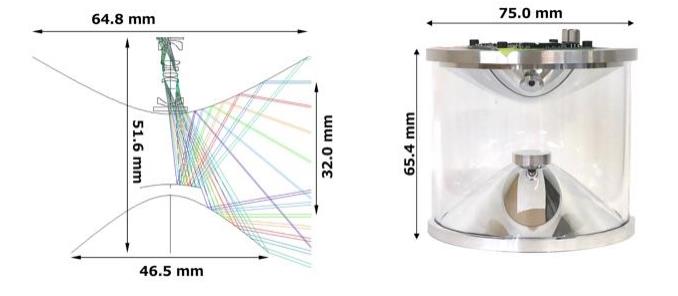

图1,(左)全向立体相机的光学设计,彩色线显示入射光线,这些光线被双曲镜反射并进入透镜系统。(右)按照光学设计建造原型。

全向立体相机的光学设计

全向立体相机的光学设计如图1的左图所示,该系统由两个双曲面镜、一个图像传感器和一个鱼眼状广角透镜单元组成,入射到双曲镜焦点的光线在透镜单元的方向上反射,并在图像传感器上成像,这意味着上下反射镜反射的光线分别构成上视图和下视图图像,前一种光线由上反射镜反射,在传感器的内部区域成像,后一种光线由下反射镜反射,在外部区域成像,透镜单元设计用于减少由反射镜引起的共焦像差和像散,该系统具有成本效益,因为它使用双曲面镜而不是鱼眼透镜来获得360度的图像。另一个原因是,它只使用一组镜头和传感器就可以获得上下图像。相距14米的物体的目标距离误差为5%。当使用两个相距约2米的摄像机时,这种精度反过来对应于相距300米的物体的5%距离误差。

构建的原型

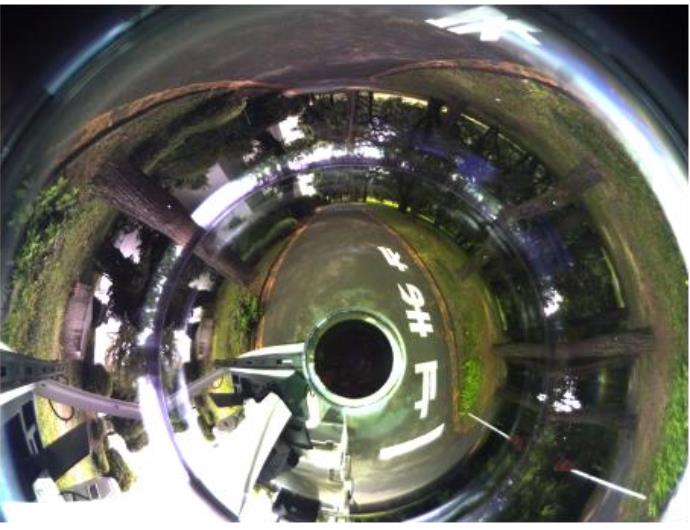

构建的原型显示在图1的右面板中。除了光学设计中描述的部件外,还添加了一个玻璃圆柱体,用于固定上下后视镜。我们使用IDS UI-3592LE-C版本的图像传感器。其分辨率为4912×3684,虽然这种光学系统可以实现360度FoV,但当摄像头安装在汽车的一个角落时,FoV的一部分将变得无效,因此,对于该原型,图像传感器被放置在离轴位置,以使水平FoV为270度,上下图像的垂直视场来自−50度到+10度以及从分别为-20度到+10度。图2显示了原型获得的传感器图像。

图2,该相机拍摄的传感器图像,内部和外部区域分别对应于上视图和下视图图像

新的校准方法

这里将介绍一种新的全向立体相机校准方法。基于Mei和Rives程序,我们新考虑了鱼眼状广角成像透镜、图像传感器的倾斜以及反射镜和透镜之间的偏移。从传感器图像获取距离信息的过程中,有三个步骤:

第一步是展开图像。我们采用圆柱形展开,因为我们聚焦的区域的图像不会因该投影而显著失真。另一个原因是,在短距离配置中,每个图像中的对应点以垂直线对齐,这使得应用传统块匹配过程变得容易。在进行上述圆柱扩展的同时,我们消除了图像失真。这称为摄像机校准程序。

第二步是图像校正,将上视图和下视图图像变换为投影到同一圆柱体上,最后一步是执行块匹配过程以计算两幅图像之间的差异,对于可靠的距离测量,需要精确校准,由于我们的镜头单元有很大的失真,并且原型可能会受到一些失调的影响,因此我们需要一种考虑这些因素的新校准方法。此外,该原型的大视场使得精确校准变得困难。我们的方法基于Mei和Rives的全向相机校准方法,该方法采用了使用标定板的灵活校准方法。该方法采用参数化光学模型来模拟光学系统,如果模型足够精确,在充分再现畸变和未对准的情况下,也可以进行精确的圆柱形膨胀。

为了构造精确的光学模型,基于MEI和 Rives模型,考虑附加的五个因素:高阶径向畸变、切向畸变的径向依赖性、薄棱镜畸变、图像传感器的倾斜和透镜镜偏移。具体公式有兴趣可查看原文。

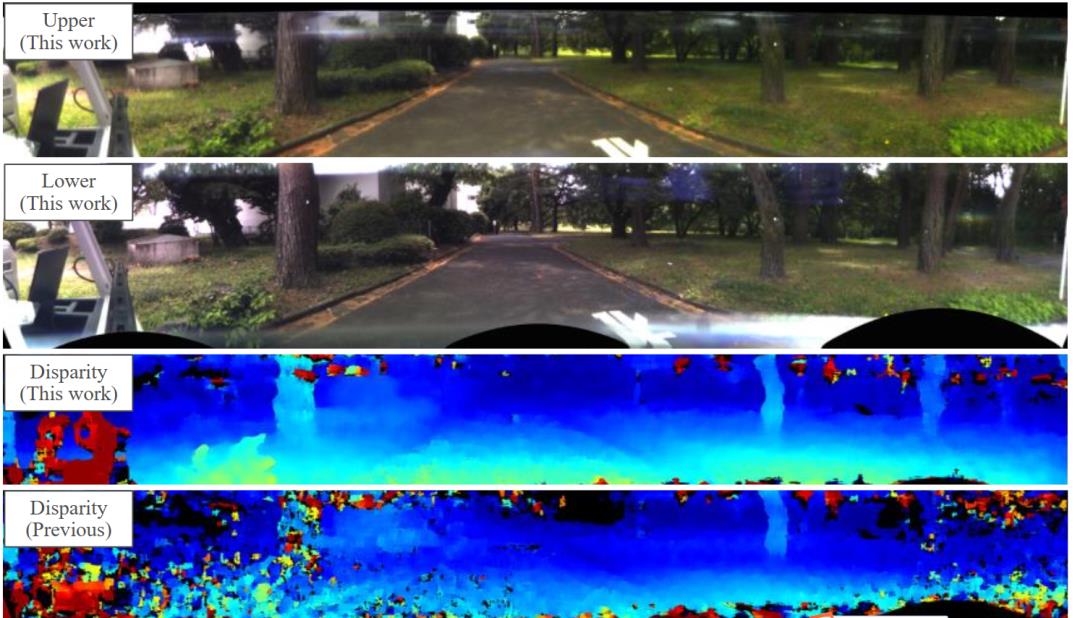

图4,从图2中显示的传感器图像计算图像。(中上部和中上部)使用我们的新光学模型以圆柱体投影的上视图和下视图图像。(中下部)根据上面两幅图像计算的视差图像。近和远的对象分别以红色和蓝色显示。(下)根据使用先前模型校准的上视图和下视图图像计算的视差图像

我们以与OpenCV(开源计算机视觉)库中实现的omnidir::calibrate函数相同的方式对参数进行优化,这里使用圆形网格板,其性能优于棋盘,优化参数如表1和表2所示。圆柱形投影的结果如图4上部两个面板所示,使用OpenCV库中实现的cv::stereoBM函数计算视差图像,如图4中下部面板所示。为了进行比较,我们还在图4的下面板中提供了一个使用先前模型计算的视差图像。我们的标定方法得到了更大的视差和清晰的地面梯度。

实验

校准误差的评估

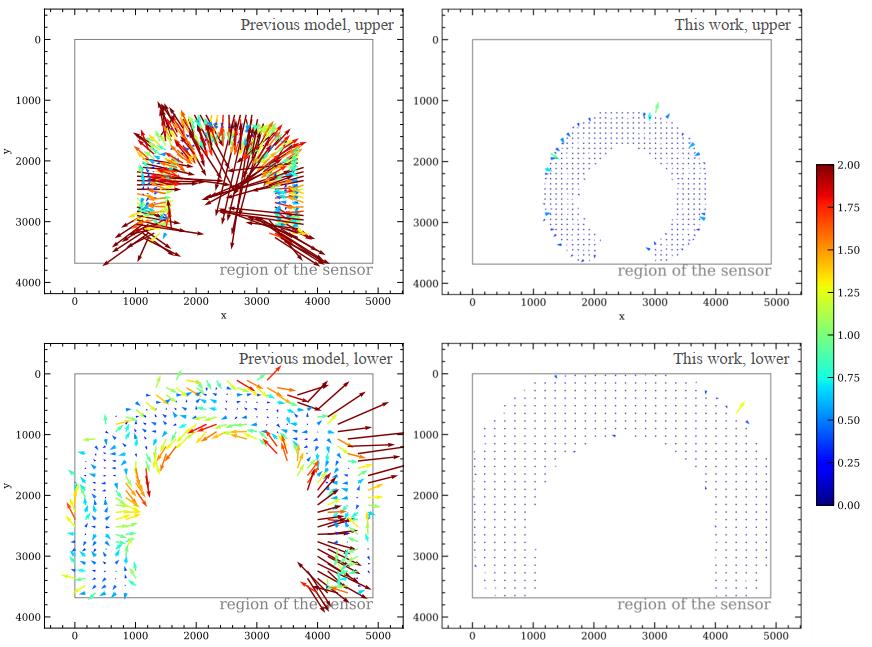

评估校准精度的方法之一是评估传感器图像上模型的精度,我们计算标定板检测到的图像和模型预测的圆位置之间的差异,向量的长度和方向表示模型在每个点的系统误差量和方向。虽然使用之前的模型时仍存在系统误差,但我们的模型显著减少了误差。对于上视图和下视图图像,前一模型的差异均方根分别为1.67像素和1.12像素,这对距离精度具有不可忽略的影响。另一方面,使用我们的光学模型,上视图和下视图图像的均方根分别从1.67像素提高到0.28像素,从1.12像素提高到0.26像素。对于上视图和下视图图像,这分别是改进的6.0倍和4.3倍。4.2. 获得的视差图像和点云为了展示我们相机的精度和局限性,我们在图6和图7中显示了RGB图像、视差图像和点云。在图6中,显示了在内部拍摄的图像和点云。相距14米的物体,包括平坦的地板、植物、木架和桌子都被复制出来。图7显示了在室外拍摄的图像和点云。在14米的范围内,铺砌道路、树木和路缘石的结构被复制。这一结果证明,该摄像机能够满足自动驾驶汽车检测范围内行人、其他车辆和障碍物的要求。

图5,上部分和下部分视图图像检测到的图像和模型预测的圆位置之间的组合差异,左面板和右面板分别显示了先前模型和新光学模型的结果,矢量显示像素单位的位置差异,但放大了200倍,而彩色贴图显示像素单位的差异量,传感器区域显示为灰色矩形

图6,RGB图像、视差图像和内部场景的点云,为清晰起见,我们仅显示视场的180度,A、 B、C和D显示了相应的对象,在对象C的四个表中,最近的和最远的分别位于距离摄像机4.5米和12米的位置

图8,测量距离与实际距离之间的距离介于4.5和14 m之间。蓝色点显示图6所示的点云部分的每个点,黑点表示箱子中的平均值和垂直误差条1𝜎 标准差,粗灰色线表示精确的距离测量,细灰色线显示与真实值的偏差为5%。

总结

我们已经为我们的全向立体相机开发了一种新的校准方法,以便通过短距离配置精确校正畸变,以实现14米距离物体5%的距离误差,在Mei和Rives以前的校准方法的基础上,我们考虑了高阶径向畸变,提高了校准精度,详细介绍了切向失真、图像传感器倾斜和透镜-镜偏移。我们的方法将上视图和下视图图像的校准精度的均方根分别降低了6.0倍和4.3倍。距离的系统误差为5.7%,最大距离为14米的物体,与先前方法计算的距离相比,提高了近9倍,与5%的目标值几乎相同。标准偏差不超过4.9%。作为未来的工作,光学分辨率的提高可导致精度的进一步提高。我们已经证明,我们的摄像头能够定位14米范围内的物体,如行人、其他车辆和障碍物。除了本文描述的距离测量外,自动驾驶还需要目标识别。进一步改进和优化我们的暂定识别系统将使这款相机成为一款经济高效的用于自动驾驶传感器。

参考文献

(1) Ishii, T., Shimano, T., Takemura, M. et al., "Development of Omnidirectional 3 Dimensional Surround Sensing System Composed of Single-Eye Stereo Cameras," JSAE Annual Congress (Spring) Proceedings, No. 52-19 (2019).

(2) Shimano, T., Ishii, T., Ohta, M. et al., "Vertical disparity single-eye stereo camera for wide angle 3 dimensional surround sensing of automobiles," JSAE Annual Congress (Spring) Proceedings, No. 52-19 (2019)

资源

三维点云论文及相关应用分享

【点云论文速读】基于激光雷达的里程计及3D点云地图中的定位方法

3D-MiniNet: 从点云中学习2D表示以实现快速有效的3D LIDAR语义分割(2020)

PCL中outofcore模块---基于核外八叉树的大规模点云的显示

更多文章可查看:点云学习历史文章大汇总

SLAM及AR相关分享

扫描下方微信视频号二维码可查看最新研究成果及相关开源方案的演示:

如果你对本文感兴趣,请点击“原文阅读”获取知识星球二维码,务必按照“姓名+学校/公司+研究方向”备注加入免费知识星球,免费下载pdf文档,和更多热爱分享的小伙伴一起交流吧!

以上内容如有错误请留言评论,欢迎指正交流。如有侵权,请联系删除

扫描二维码

关注我们

让我们一起分享一起学习吧!期待有想法,乐于分享的小伙伴加入免费星球注入爱分享的新鲜活力。分享的主题包含但不限于三维视觉,点云,高精地图,自动驾驶,以及机器人等相关的领域。

分享及合作:群主微信“920177957”(需要按要求备注) 联系邮箱:dianyunpcl@163.com,欢迎企业来联系公众号展开合作。

点一下“在看”你会更好看耶

以上是关于单目全向立体相机的标定(一种新的相机形式)的主要内容,如果未能解决你的问题,请参考以下文章

双目三维重建系统(双目标定+立体校正+双目测距+点云显示)Python