百度上的快速部署的两个平台:EasyDL以及AI Studio体验馆

Posted 卓晴

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了百度上的快速部署的两个平台:EasyDL以及AI Studio体验馆相关的知识,希望对你有一定的参考价值。

本文是摘录自百度AI Studio 部署过程的Notebook原文,以供测试和实验。

简 介: ※ 本次全流程的体验了一下 AIStudio 的新功能“趣味体验馆” 趣味体验馆解决了部署最后一公里的难题,对于开发者而言,无需自行购买服务器进行模型部署,可以节省不小的成本 虽然想法很好,但是目前这个功能还不太完善,体验上比较拉跨,坑很多,有不少功能还实现不了,而且调试非常麻烦 但也算是能用,就是使用成本稍微高了些,不过能白嫖部署服务器,这也不能要求太多 希望 AIStudio 能够持续更新,让这个功能变得更加好用

关键词: AI,Studio,体验馆,部署模型

§01 快速部署

下面是百度的刘聪琳发送过来的百度快速部署的两个平台:

下面总结一下这两个平台的应用。

1.1 EasyDL

▲ 图 EasyDL模型

1.2 趣味体验馆

通过 趣味体验馆 通过一个实例介绍如何使用趣味体验馆创建自己的趣味体验项目。

▲ 图1.2.1 趣味体验馆踩坑指南

点击“运行一下”会自动在自己的账号中创建“趣味体院馆踩坑指南”项目。

§02 运行体验馆

2.1 引入

- 最近 AIStudio 又悄咪咪地上线了一个新功能——趣味体验馆

- 顾名思义,就是一个可以在线体验趣味 AI 模型的功能

- 既然有了新功能,那肯定要抢先尝试一波的啦

- 所以本次项目介绍一下如何将模型部署到 AIStudio 上,并创建趣味体验项目

2.2 趣味体验馆

- 首先,也是最重要的一点,这个新功能在哪??

- 只需要点开 AIStudio 项目页面,就可以看到这个功能卡片了(前提是已经进行了模型部署和服务创建):

实际上需要点击: 趣味体验馆踩坑指南 : https://aistudio.baidu.com/aistudio/projectdetail/2038838/k?channelType=0&channel=0

- 根据提示输入所需要的数据,点击“提交”,即可在线体验,比如这样:

- 是不是很简单,那不赶紧去尝试体验一下

2.3 部署和创建

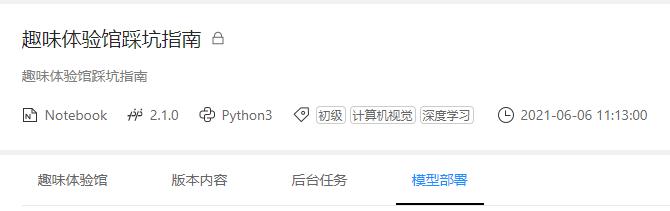

- 趣味体验馆功能依托 AIStudio 的模型部署功能

- 首先需要将模型通过模型部署功能进行部署之后,才可以创建趣味体验馆

- 具体的流程如下图:

▲ 图2.3.1 创建趣味体验馆

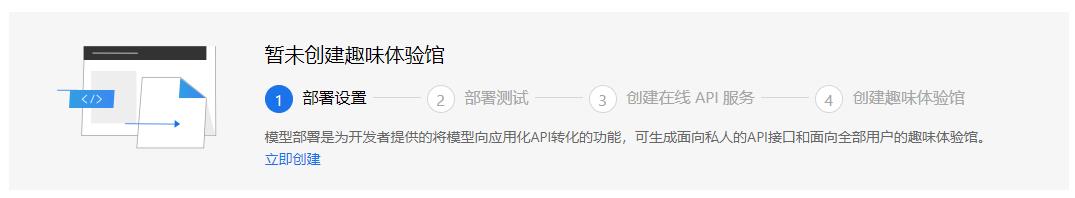

2.3.1 模型部署流程

- 首先选择模型部署选项卡

▲ 图2.3.2 模型部署流程

- 点击立即创建:

▲ 图2.3.3 点击立即创建

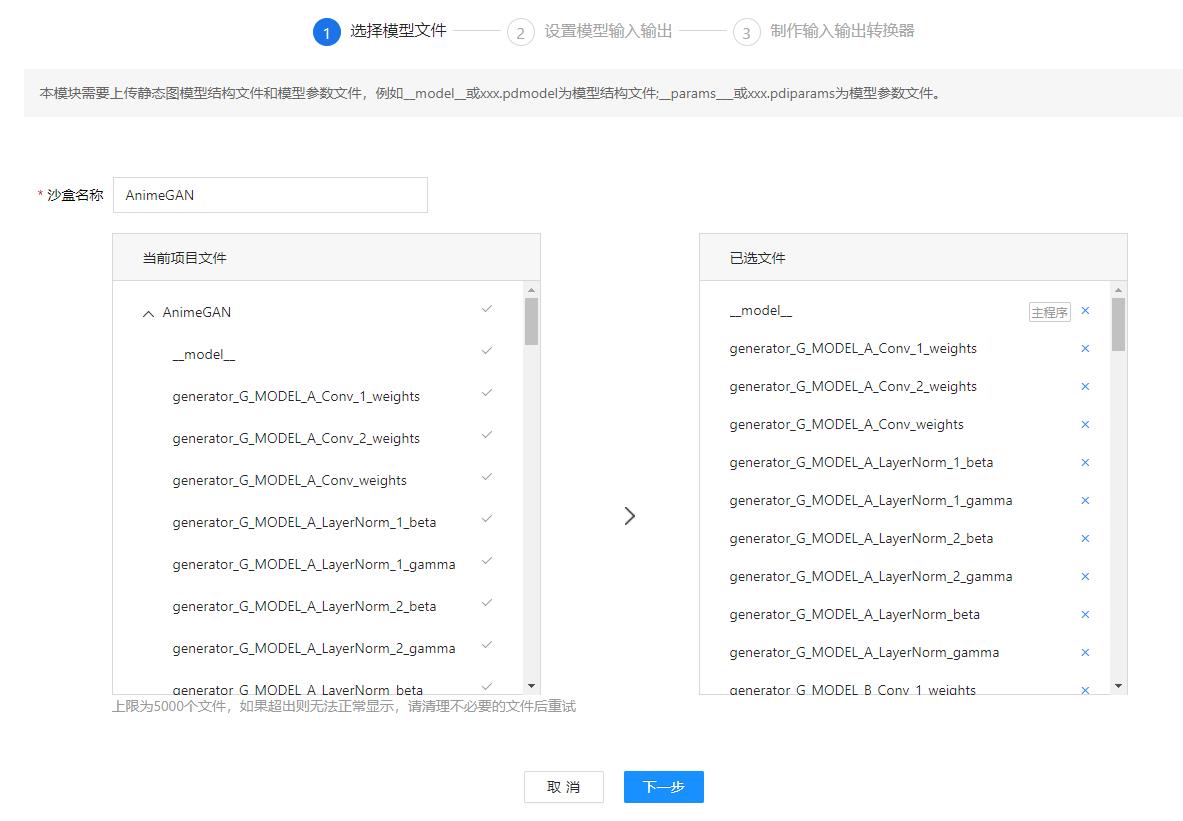

(1)选择模型

- 接下来根据提示选择要部署的静态图推理模型:

-

静态图推理模型一般有如下几种格式:

模型计算图 模型参数 __model__ * model params __model__ __params__ *.pdmodel *.pdiparams -

一般通过静态图 API(paddle.static.save_inference_model)、模型动转静 或 模型转换(X2Paddle) 这三种方式获取

-

选择样例如下:

-

▲ 图2.3.4 选择样例对话框

- 选择完成后选择下一步

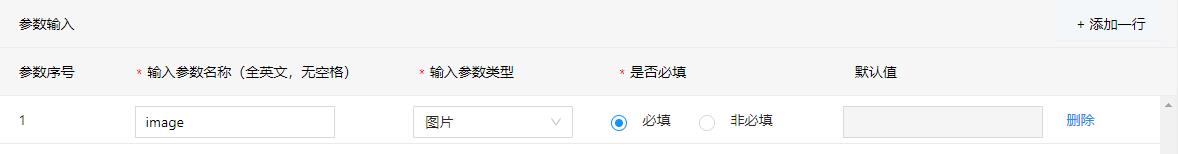

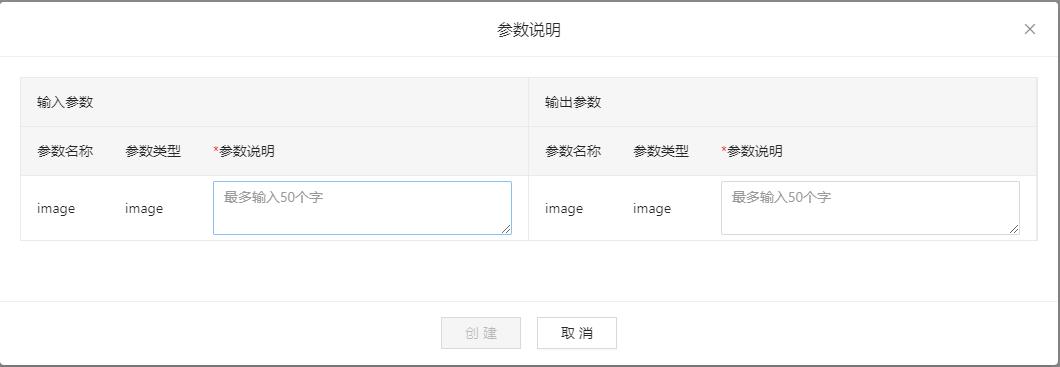

(2)设置模型输入输出

- 根据模型需要和页面提示设置模型的输入输出

- 因为演示的模型是一个图像风格转换的模型,所以输入输出都是图像

- 具体的设置如下图所示:

▲ 图2.3.5 设置模型的输入输出

▲ 图2.3.6 设置模型的输入输出

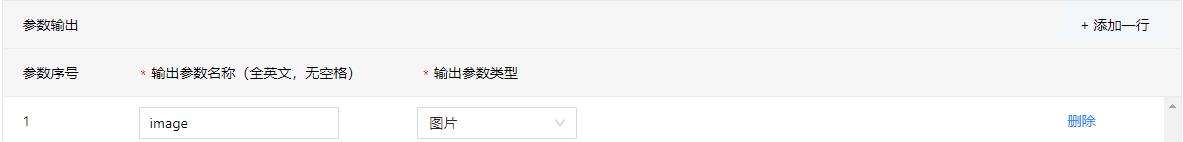

- 重要提示1:其中的参数类型是可以继续往下拉的,如下图:

▲ 图2.3.7 输入参数类型

- 重要提示2:参数类型中的图像类型会将上传的图像自动转换成 Base64 编码作为模型的输入,而非直接传递图像数组,其实还是一个套壳的 Base64 类型而已

- 重要提示3:其中视频、语音类型还未尝试过,不知道具体的处理是怎么样的

- 设置完毕选择下一步

(3)制作输入输出转换器

- 顾名思义,就是编写模型输入预处理和输出后处理的操作代码

- 这是模型部署中最关键的一步,目前坑稍微比较多

- 目前环境中没有 opencv-python (cv2)模块,只能使用 PIL 模块进行图像处理

- 默认图像的 Base64 编码是 RGB 格式的

- 暂时没找到内置的 Base64 与 PIL Image 转换的 API 接口,只能自己写一个

- Base64 编码无论输入输出都是包含文件头的,如:“data:image/jpeg;base64,”

- 为了兼容旧版本模型,该功能目前用的是 paddle 内部的 API 进行推理操作,而非 PaddleInference,无法通过删除输入输出结点实现动态 Shape 推理

- 也就是说必须在保存推理模型时将模型输入设置为动态的 Shape 才可以,如果导出时是固定的,那么推理时也只能使用固定的输入 Shape

- 而且目前需要使用 fluid.DataFeeder 这个旧版本的 API 进行 Feeder 的构建,所以必须提前通过读取模型文件的方式来查找输入的 Tensor 的名称

- 输入参数代码如下:

import re

import base64

import numpy as np

import paddle.fluid as fluid

from PIL import Image

from io import BytesIO

# 将 Base64 转成 PIL Image

def base64_to_pil(image_base64):

"""read image from memory"""

image_base64 = re.sub('^data:image/.+;base64,', '', image_base64) # 需要去除头部格式信息

image_mem = BytesIO(base64.b64decode(image_base64)) # python3

image_pil = Image.open(image_mem).convert('RGB')

return image_pil

# 预处理代码

def preprocess(img):

# 图像缩放

max_size, min_size = 720, 32

w, h = img.size

if max(h,w)>max_size:

img = img.resize((max_size, int(h/w*max_size))) if h<w else img.resize((int(w/h*max_size), max_size))

elif min(h,w)<min_size:

img = img.resize((min_size, int(h/w*min_size))) if h>w else img.resize((int(w/h*min_size), min_size))

# 裁剪图片

w, h = img.size

img = np.array(img)

img = img[:h-(h%32), :w-(w%32), :]

# 归一化

img = img/127.5 - 1.0

return img

def reader_infer(data_args):

"""

reader inter

:param data_args: 接口请求参数

:return [[]], feeder

"""

def reader():

"""

reader

:return:

"""

# image <type 'image'> default value:None

image = data_args['image']

# 格式转换

image = base64_to_pil(image)

# 预处理

image = preprocess(image)

# 根据输入 Tensor 的名称和 Shape 构建 DataFeeder

h, w, c = image.shape

img = fluid.layers.data(name='x2paddle_generator_input', shape=[h, w, c], dtype='float32')

feeder = fluid.DataFeeder([img], fluid.CPUPlace())

return [[image]], feeder

return reader

- 输出参数代码如下:

import re

import base64

import numpy as np

from PIL import Image

from io import BytesIO

# PIL Image 转换为 Base64

def pil_to_base64(image_pil):

"""save PIL image in memory, and convert to base64"""

image_buffer = BytesIO()

# image_buffer = StringIO() # python2

image_pil.save(image_buffer, format='JPEG')

image_bytes = image_buffer.getvalue()

image_base64 = base64.b64encode(image_bytes).decode()

return image_base64

# 后处理

def postprocess(output):

# 反归一化

image = (output.squeeze() + 1.) / 2 * 255

# 限幅

image = np.clip(image, 0, 255).astype(np.uint8)

# 格式转换

image = Image.fromarray(image)

return image

def output(results, data_args):

"""

模型评测结果输出转换

:param results

:param data_args 请求参数

:return dict

"""

# todo

# 后处理

image = postprocess(results[0])

# Base64 编码

code = pil_to_base64(image)

# 加上文件头进行结果返回

return 'image': 'data:image/jpeg;base64,'+code

- 代码写完选择生成沙盒

- 这样一个沙盒就配置完成了

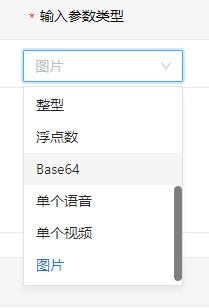

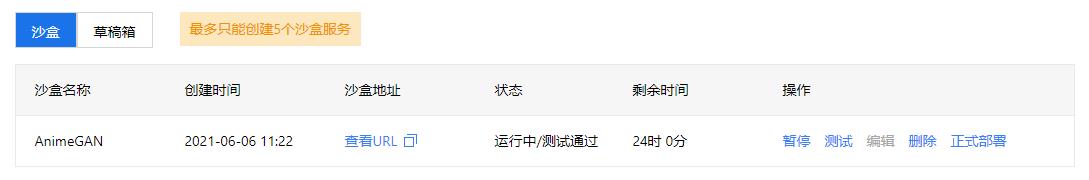

2.3.2 沙盒启动和测试

-

点击下图的启动,即可启动沙盒

▲ 图2.3.8 启动沙盒 -

然后点击测试,即可开始部署测试,其中包含如下两种测试方式:

- 代码:通过脚本代码配置输入进行模型测试

- 可视化:通过可视乎接口进行模型测试

-

除了测试方式之外,还有两个重要模块:

- 请求返回结果:可以通过这里获取模型的输出结果

- 请求日志:可以通过这里了解模型出现的问题

-

选择其中一种方式,填写所需要的输入数据,然后点击发送请求或提交即可测试沙盒服务是否正常运行,样例如下图:

▲ 图2.3.9 模型测试

▲ 图2.3.11 请求返回结果

- 测试验证结果正确之后,提示“测试通过,返回沙盒列表部署”

- 点击沙盒列表返回主页面进行最后的部署

2.3.3 正式部署

- 点击下图中的正式部署即可将模型进行在线部署

▲ 图2.3.13 正式部署模型

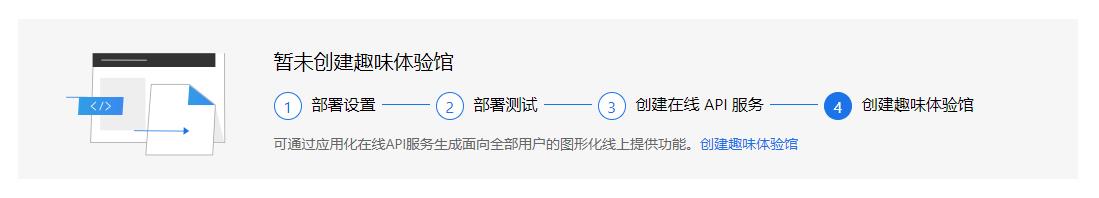

2.4 创建趣味体验馆

- 完成了模型部署,下一步就可以创建趣味体验馆功能了

- 点击下图中的创建趣味体验馆,即可以开始创建

▲ 图2.4.1 创建趣味体验馆

2.4.1 配置名称和介绍

- 首先需要为这个体验项目配置名称和介绍

▲ 图2.4.2 配置项目的名称和介绍 - 完成后选择下一步

2.4.2 配置输入输出信息

- 接下来配置输入输出的介绍信息

▲ 图2.4.3 参数说明 - 最后选择创建即可

2.4.3 体验测试

- 创建完成后,项目页面就会出现趣味体验馆的选项卡,如下图:

▲ 图2.4.4 体验测试过程 - 然后就可以自行进行体验测试了,当然也可以公开项目让大家一起体验有趣的项目

※ 总 结 ※

- 本次全流程的体验了一下 AIStudio 的新功能“趣味体验馆”

- 趣味体验馆解决了部署最后一公里的难题,对于开发者而言,无需自行购买服务器进行模型部署,可以节省不小的成本

- 虽然想法很好,但是目前这个功能还不太完善,体验上比较拉跨,坑很多,有不少功能还实现不了,而且调试非常麻烦

- 但也算是能用,就是使用成本稍微高了些,不过能白嫖部署服务器,这也不能要求太多

- 希望 AIStudio 能够持续更新,让这个功能变得更加好用

■ 相关文献链接:

● 相关图表链接:

以上是关于百度上的快速部署的两个平台:EasyDL以及AI Studio体验馆的主要内容,如果未能解决你的问题,请参考以下文章