达摩院OpenVI几行代码,尽享丝滑视频观感

Posted AI记忆

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了达摩院OpenVI几行代码,尽享丝滑视频观感相关的知识,希望对你有一定的参考价值。

随着网络电视、手机等新媒体领域的快速发展,用户对于观看视频质量的要求也越来越高。当前市面上所广为传播的视频帧率大多仍然处于20~30fps,已经无法满足用户对于高清、流畅的体验追求。而视频插帧算法,能够有效实现多倍率的帧率提升,有效消除低帧率视频的卡顿感,让视频变得丝滑流畅。配合其它的视频增强算法,更是能够让低质量视频焕然一新,让观众享受到极致的播放和观看体验。点击如下链接,立即体验。

学术版模型:https://www.modelscope.cn/models/damo/cv_raft_video-frame-interpolation/summary

应用版模型:https://www.modelscope.cn/models/damo/cv_raft_video-frame-interpolation_practical/summary

视频插帧算法,顾名思义,需要计算原始视频中相邻(多)帧间的运动关系,在相邻帧间插入符合逻辑的中间帧,使中间帧能与原始帧无缝衔接,达到提升视频流畅度的效果

插帧前后的效果对比(左:插帧前,右:插帧后)

一、背景

当前,插帧算法在学术界不断取得突破,多篇文章通过transformer的引入能够有效提升PSNR等验证指标。但当前大多数SOTA模型在一些通用视频的困难场景下(包括但不限于:大运动场景、重复纹理场景、电影中的台标、字幕)生成的中间帧存在明显的瑕疵现象。而上述所提到的场景,也成为了当前视频插帧在业界所面临的最大挑战。此外,当前的大多数插帧算法仅支持生成t=0.5时刻的中间帧,即2倍插帧,无法一次性实现高倍率插帧以及任意指定帧率转换。针对以上问题,达摩院视觉增强团队在Modelscope上线了自研的插帧算法,该算法能够有效提升上述困难场景下的插帧质量,同时该算法支持任意时刻的中间帧生成,输出帧率可由用户任意指定。

二、方法

ours算法采用深度学习方案,完整链路可分为四部分:原始帧间光流预测、光流修复(refine)、中间帧光流估计、中间帧生成。

原始帧间光流预测

当前,绝大多数插帧算法都是基于光流来实现运动估计的。光流能够表征相邻两帧间对应像素点的运动距离大小,反映同一物体的位置对应关系。通常来说,光流预测的精准程度越高,生成的中间帧也更准确。在我们的算法中,复用了RAFT这一光流模型,用于生成F0->1和F1->0。和其它的光流模型相比,RAFT所提出的convex upsample使其在估计快速运动小物体有着更高的准确率。

(输入img0、img1)

Ft->1

Ft->0

光流修复

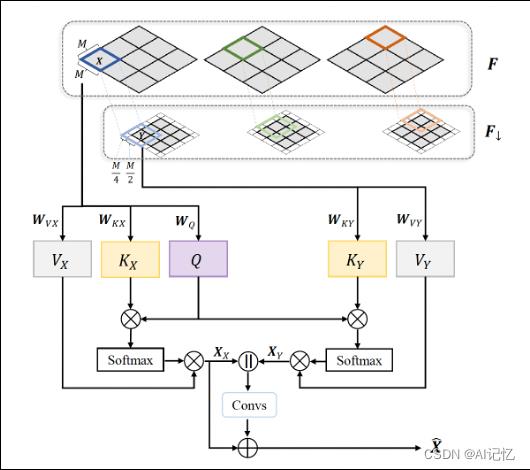

针对RAFT模型所生成的光流,我们引入了基于cross-attention transformer结构来对原始光流进行修复。该结构能够扩大感受野,结合Unet能够有效捕捉大运动场景下的光流。经过修复,我们可以得到对原始帧间的光流F0->1和F1->0实现精准估计

cross-attention transformer[3]

中间帧光流估计

这一步的主要目的是通过F0->1和F1->0去估计Ft->1和Ft->0,这里我们引入了基于四帧输入的光流估计算法。和两帧输入算法相比,该算法能够更好地捕获快速运动物体的加速度,此外,多帧信息的引入,又能够有效提升重复纹理场景光流估计错误的问题。

中间帧光流估计[4]

中间帧生成

这一步借由I1和Ft->1、I0和Ft->0,通过backward warping各自生成中间帧。考虑到潜在的遮挡问题,通过mask对两张图像进行加权融合,即可得到最终的中间帧图像。该部分算法和当前大多数插帧算法无异。

三、效果

1.算法优势和功能支持

基于深度学习方法,针对大运动、重复纹理等困难场景进行了算法改进。针对电影、电视剧、体育赛事视频中常出现的台标、字幕等场景,进行了训练数据构造和增强,大幅提升了算法的实用性。

支持用户指定任意帧率输出,算法可自动计算插帧时刻,并支持任意时刻的插帧

针对部分镜头切换或其它不适合插帧的场景,可进行自动检测和筛选

算法嵌入modelscope开源平台,用户可免费体验。模型调用简单方便,几行代码即可调用pipeline。不仅如此,modelscope兼容主流深度学习框架,提供灵活简单的python SDK,开发者可以方便地对算法进行二次开发,构建自己的专属模型

点击链接 https://www.modelscope.cn/home 进入魔搭社区

2.视频、图像综合增强

插帧算法作为视频增强的一部分,能够有效解决视频卡顿的问题。此外,modelscope社区还上线了包括去噪、超分、调色、上色等多种视频图像修复增强算法。任何低质量的原始视频,都能够在增强修复后变得焕然一新,让你享受到极致高清、饱满、丝滑的视频观看体验。

点击链接https://www.modelscope.cn/models?page=1&tasks=vision-editing&type=cv 可体验多种视觉编辑功能

四、展望

除了视频编辑和修复功能,未来我们还将持续探索插帧技术更为广阔的应用场景。当前随着大模型的兴起和层出不穷的AIGC玩法,插帧在图生视频、图片场景串联转换等领域,仍然存在巨大的潜力等待我们去发掘。

五、参考

[1] Teed, Zachary, and Jia Deng. "Raft: Recurrent all-pairs field transforms for optical flow." European conference on computer vision. Springer, Cham, 2020

[2] Huang, Zhewei, et al. "Real-time intermediate flow estimation for video frame interpolation." Computer Vision–ECCV 2022: 17th European Conference, Tel Aviv, Israel, October 23–27, 2022, Proceedings, Part XIV. Cham: Springer Nature Switzerland, 2022.

[3] Lu, Liying, et al. "Video Frame Interpolation with Transformer." Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2022.

[4] Xu, Xiangyu, et al. “Quadratic video interpolation.” Advances in Neural Information Processing Systems 32 (2019).

以上是关于达摩院OpenVI几行代码,尽享丝滑视频观感的主要内容,如果未能解决你的问题,请参考以下文章

HMS Core Discovery第14期回顾长文|纵享丝滑剪辑,释放视频创作力