GAP全局平均池化

Posted ywheunji

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了GAP全局平均池化相关的知识,希望对你有一定的参考价值。

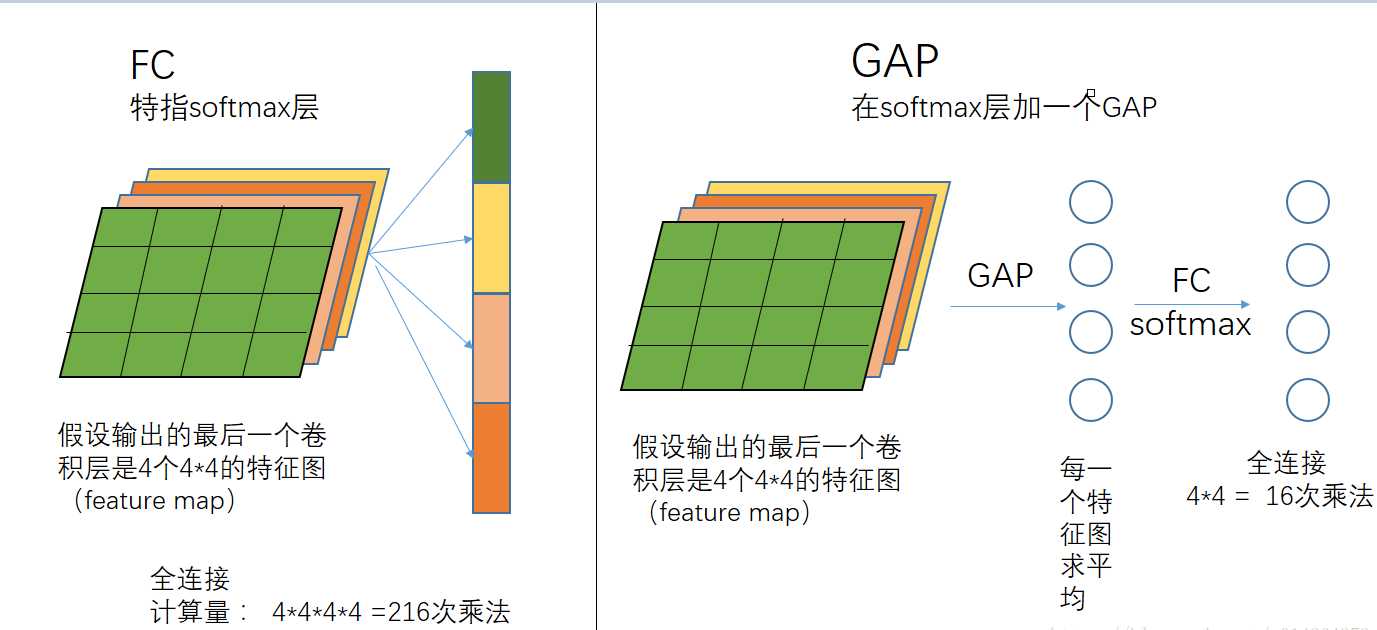

全局就是针对常用的平均池化而言,平均池化会有它的filter size,比如 2 * 2,全局平均池化就没有size,它针对的是整张feature map.

把一整张特征图取平均得到一个值,

全连接的目的,因为传统的网络我们的输出都是分类,也就是几个类别的概率甚至就是一个数--类别号,那么全连接层就是高度提纯的特征了,方便交给最后的分类器或者回归。

但是全连接的参数实在是太多了;

GAP减少了参数的数量,可以减轻过拟合的发生.

以上是关于GAP全局平均池化的主要内容,如果未能解决你的问题,请参考以下文章