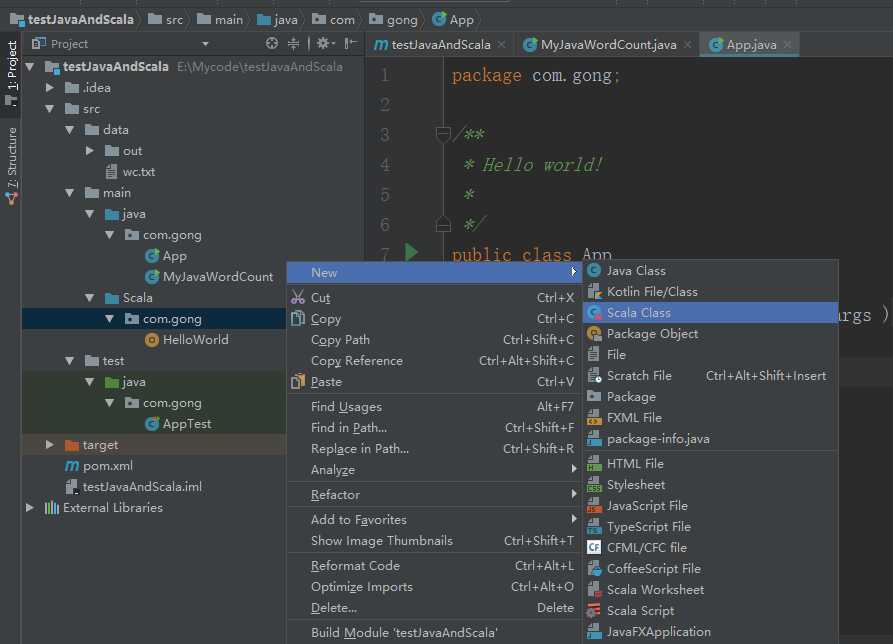

IDEA开发scala版本的spark程序

Posted braveym

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了IDEA开发scala版本的spark程序相关的知识,希望对你有一定的参考价值。

package com.gong import org.apache.spark.{SparkConf, SparkContext} object MyScalaWorldCount { def main(args: Array[String]): Unit = { //参数检测 if(args.length<2){ System.err.println("Usage: MyScalaWorldCount <input> <output>") System.exit(1) } //创建SparkContext val conf = new SparkConf().setAppName("MyScalaWorldCount") conf.setMaster("local[2]") val sc = new SparkContext(conf) //读取数据 val lines=sc.textFile(args(0)) //进行相关计算 val resultRDD = lines.flatMap(_.split("s+")).map((_,1)).reduceByKey(_+_) //保存结果 resultRDD.saveAsTextFile(args(1)) sc.stop() } }

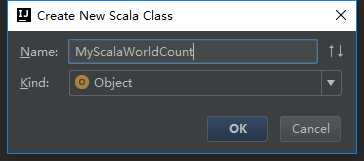

运行程序可以看到报错,因为没有传入输入输出路径

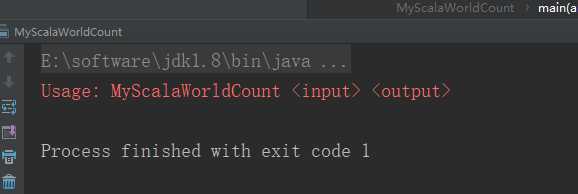

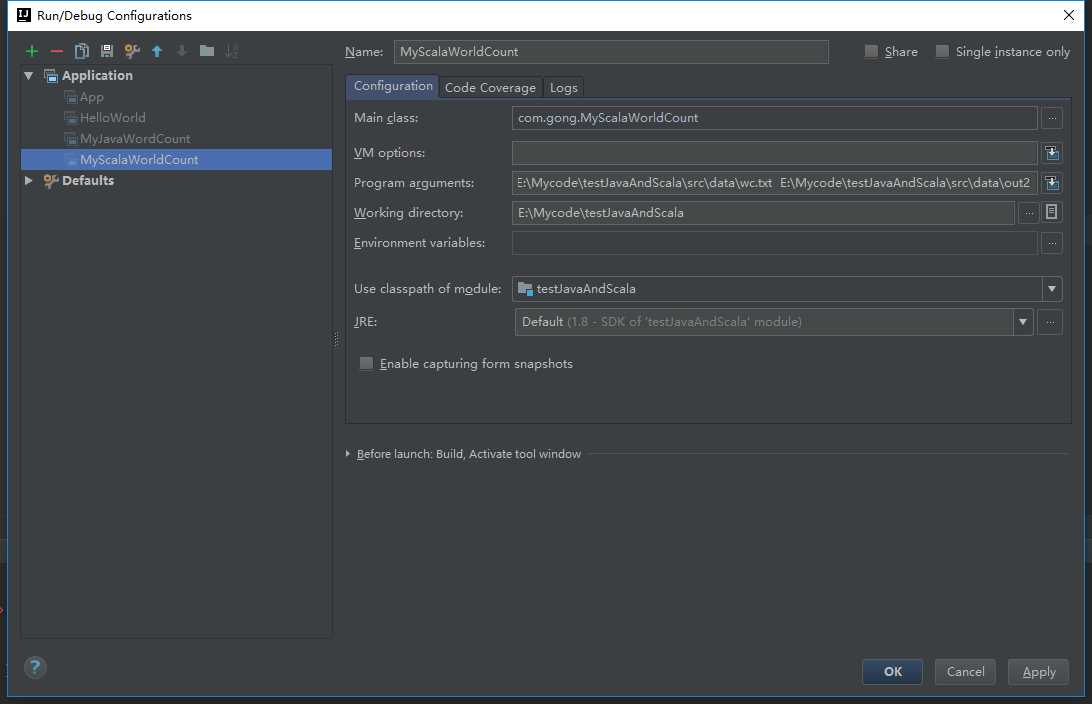

传入参数

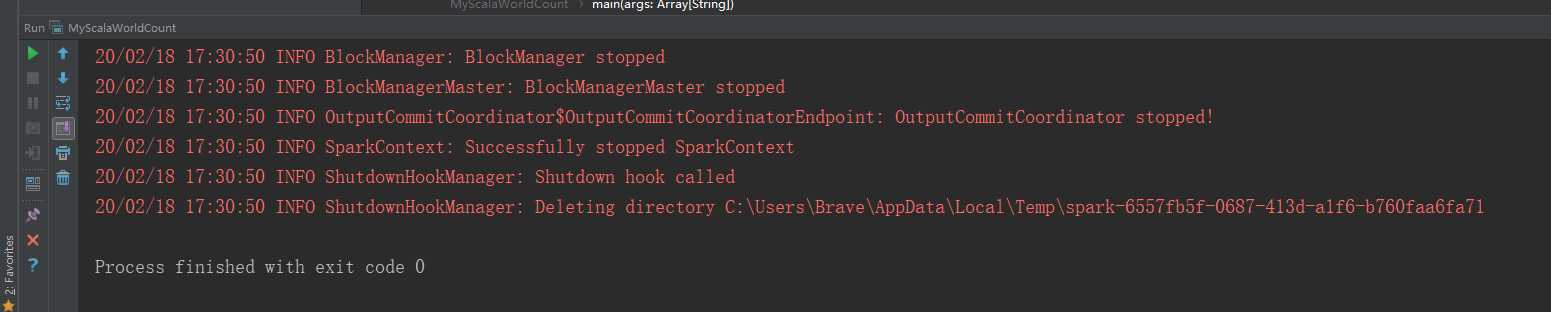

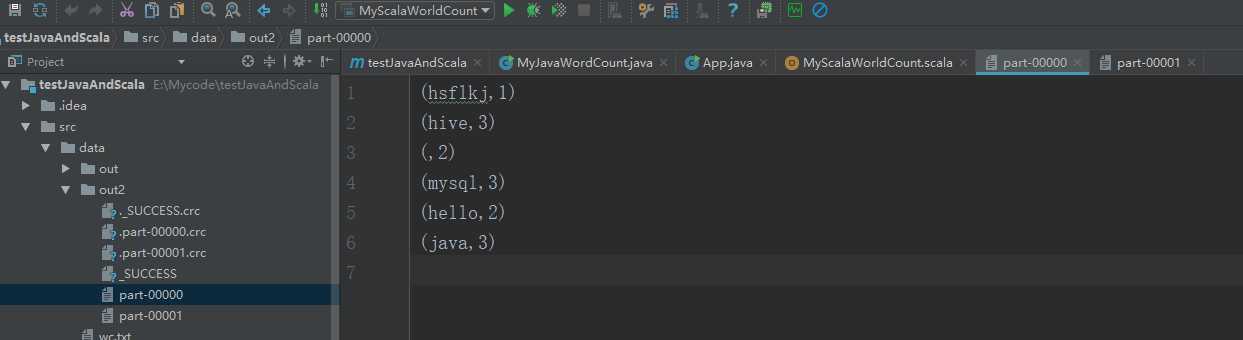

运行程序

以上是关于IDEA开发scala版本的spark程序的主要内容,如果未能解决你的问题,请参考以下文章