轻量级神经网络架构

Posted huanxifan

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了轻量级神经网络架构相关的知识,希望对你有一定的参考价值。

轻量级神经网络架构综述

论文地址轻量级神经网络架构综述

QQ邮箱

伴随着移动互联网的发展,越来越多的移动式应用层出不穷,为了在便携式设备上使用神经网络,需要减小模型的计算量和参数量,轻量型网络应运而生。

目前轻量级神经网络有三个方向:

- 人工设计轻量化神经网络模型

- 基于神经网络结构搜索 (Neural Network Search, NAS)

- 神经网络模型的压缩

1 人工设计轻量化神经网络模型

1.1 使用小卷积核代替大卷积核

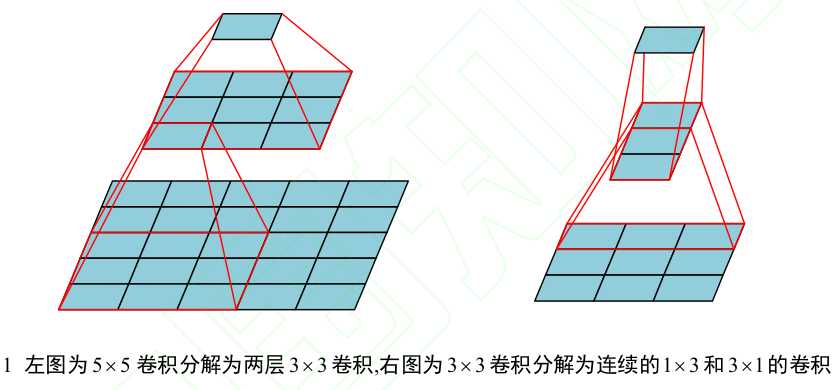

对于5x5大小的感受野,可以通过两个3x3大小的卷积实现,3x3卷积可以通过1x3和3x1卷积实现

1.2 限制中间特征的通道数

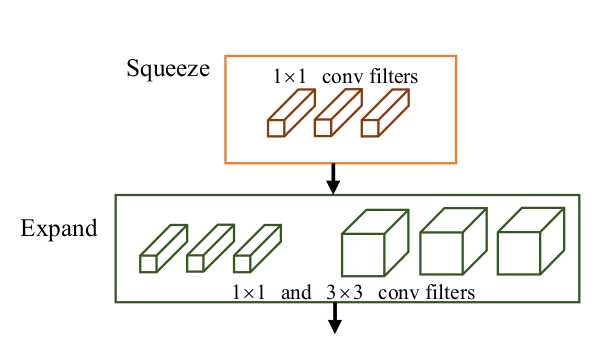

Fire module in Squeeze Net: 首先通过1x1卷积压缩通道数,然后通过1x1和3x3扩张通道数,先squeeze再expand

1.3 分解卷积运算

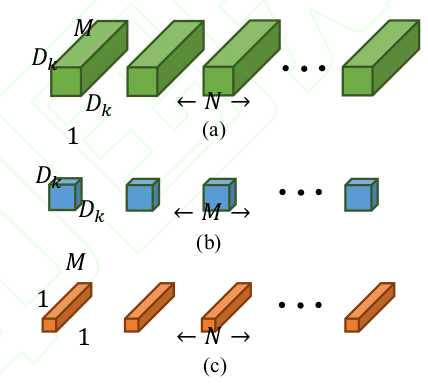

标准卷积操作是将一个卷积核用在输入特征的所有通道上,一方面参数量大,另一方面卷积运算存在很大冗余。深度可分离卷积则是对每个输入通道采用不同的卷积核,成为逐深度卷积,然后通过1x1的逐点卷积扩张通道数。

深度可分离卷积的计算量为标准卷积的1/9,用在了MobileNet系列上

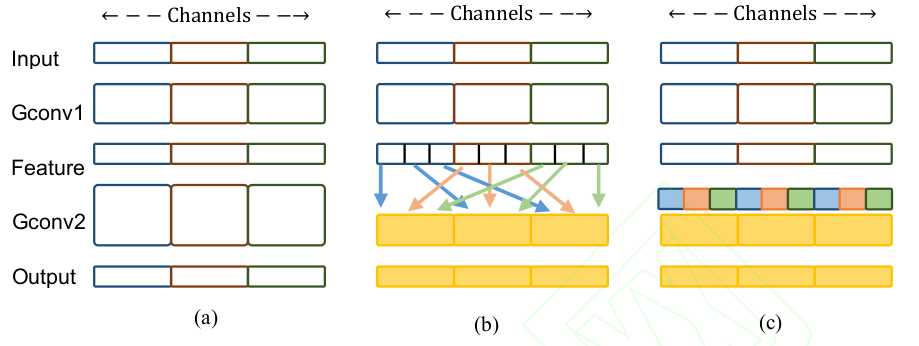

深度可分离卷积的计算量主要集中在1x1的逐点卷积上,ShuffleNet提出了分组卷积,首先将输入通道数分组,在每个组内进行单独的卷积运算。为了增加组之间的信息流动,增加了混洗操作,使得新的分组包含之前各个组的特征。

以上是关于轻量级神经网络架构的主要内容,如果未能解决你的问题,请参考以下文章