模型优化,汇总

Posted hansjorn

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了模型优化,汇总相关的知识,希望对你有一定的参考价值。

1,参考谷歌Inception结构设计思想,可做到如下:(参考深度学习方法(十一):卷积神经网络结构变化——Google Inception V1-V4,Xception(depthwise convolution) https://blog.csdn.net/xbinworld/article/details/61674836 , https://blog.csdn.net/xbinworld/article/details/61210499)

1,Maxout Networks 结构

2,network innetwork结构,很巧妙,这个新加的MLP层就等价于一个1 * 1 的卷积层,这样在神经网络结构设计的时候就非常方便了,只要在原来的卷积层后面加一个1*1的卷积层,而不改变输出的size。注意,每一个卷积层后面都会跟上ReLU。所以,相当于网络变深了,我理解其实这个变深是效果提升的主要因素。使用1*1的卷积,替换FC层;

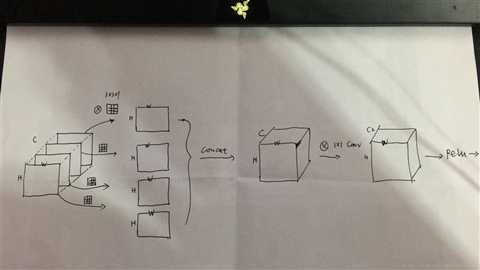

3,inception结构变化;I,在3*3和5*5卷积前面先做1*1的卷积,降低input的channel数量,这样既使得网络变深,同时计算量反而小了;II,用1*3和3*1卷积替代3*3卷积,计算量少了很多,深度变深,思路是一样的。(实际上是1*n和n*1替代n*n,n可以变);

4,Depthwise Separable Convolution;先做channel-wise conv,然后再过1*1卷积,中间没有ReLU,最后有ReLU,(Xception)

4,BN,dropout使用,一般是结合conv,dropout特别是结合FC的使用;一般优先使用BN,随后结合scale,relu,并且conv+bn+scale+relu前向运行的时候可以合并;

6,mobilenet思想;

7, ShuffleNet思想;

以上是关于模型优化,汇总的主要内容,如果未能解决你的问题,请参考以下文章