统计学习方法 李航 提升方法

Posted w-j-c

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了统计学习方法 李航 提升方法相关的知识,希望对你有一定的参考价值。

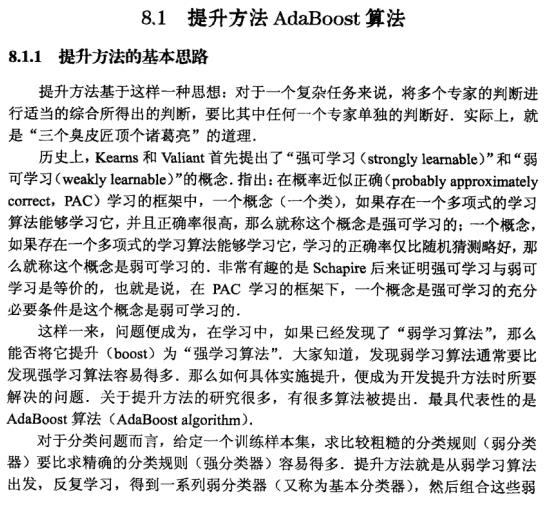

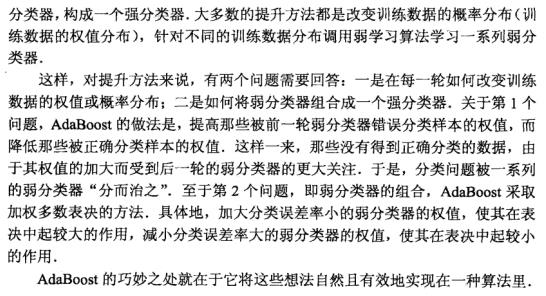

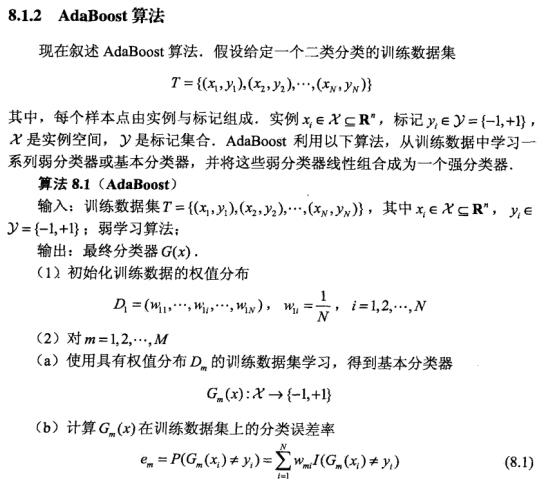

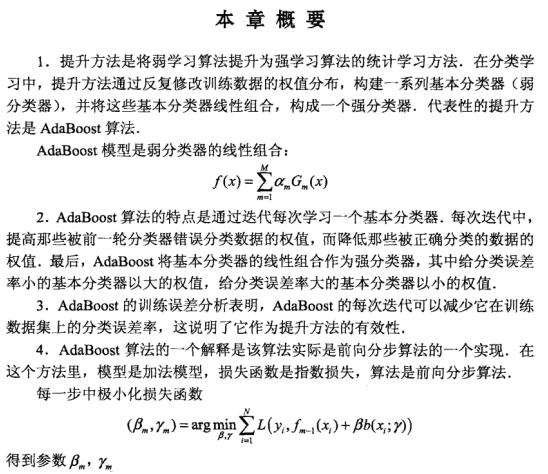

很好理解,就是将一些基本的性能一般的弱分类器组合起来,来构成一个性能较好的强分类器;这其中如果数据一样的话那不是每次训练出的分类器就都一样了嘛,所以在每次训练后要根据训练结果来改变数据的权重;还有一个关键点是通过什么方法来组合这些弱分类器.

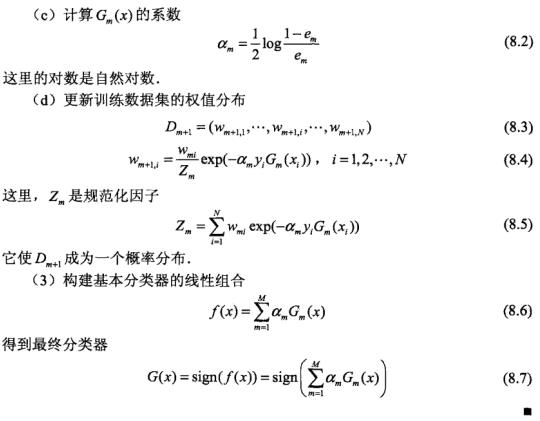

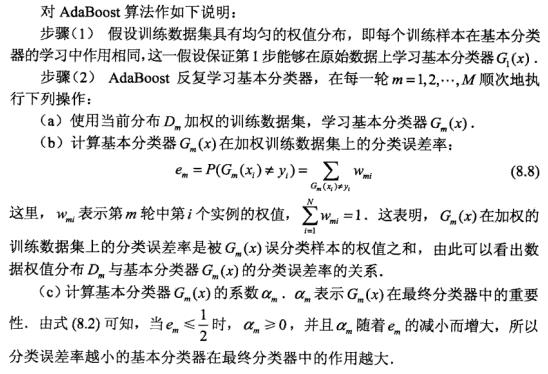

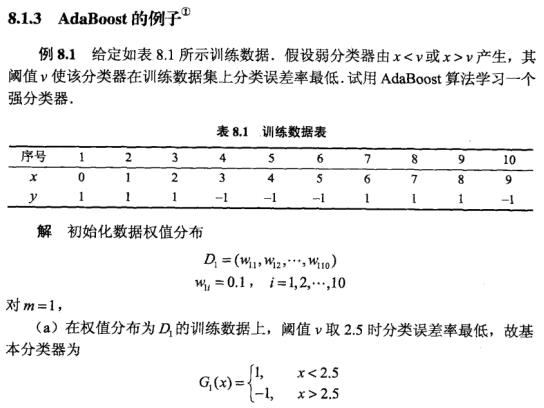

由8.2可看出错误率$e_m$越小,$alpha_m$就越大,又8.4看出权值与$alpha_m$成反比,所以分类正确的数据在下轮分类中权重减小,而这就是改变权重的原理;规范化因子实际上就是凑出来为了使权值求和为1而已;且在最终对分类器进行线性组合时,又和$alpha_m$有关,因此错误率小的分类器起的作用会更大;还要注意$alpha_m$求和不为1,而是以它的符号决定分类出的结果???;要注意这里的第n轮分类器更可能分对第n-1轮未分对的数据,但它不能保证之前分对的数据还是能分对;

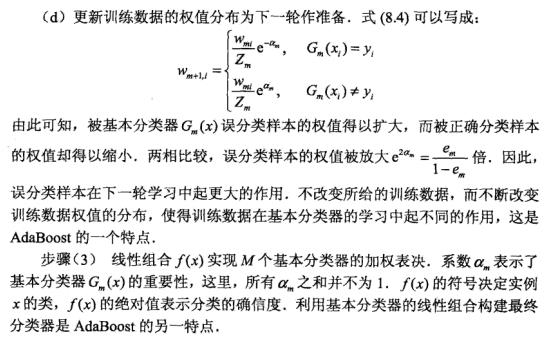

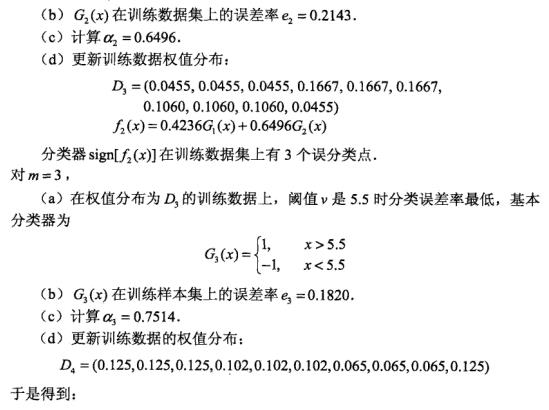

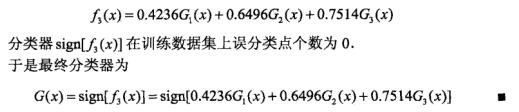

一个例子

概算发的误差分析(表示看不太懂)

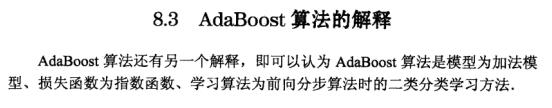

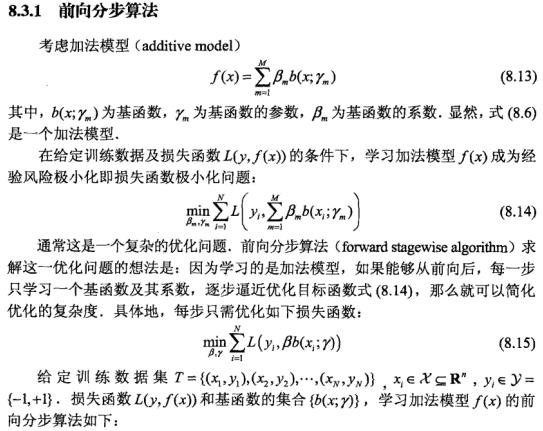

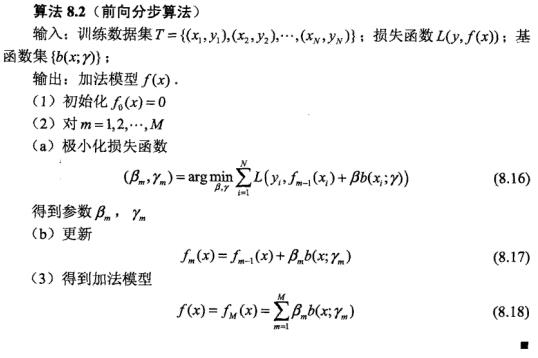

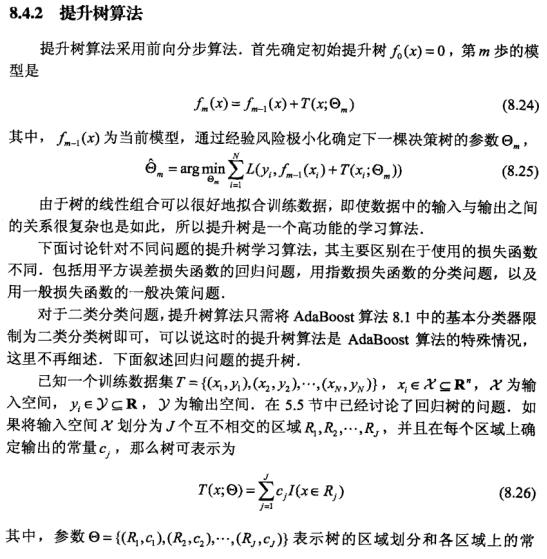

介绍了下前向分布算法,不难理解.

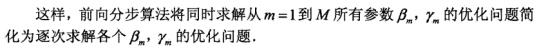

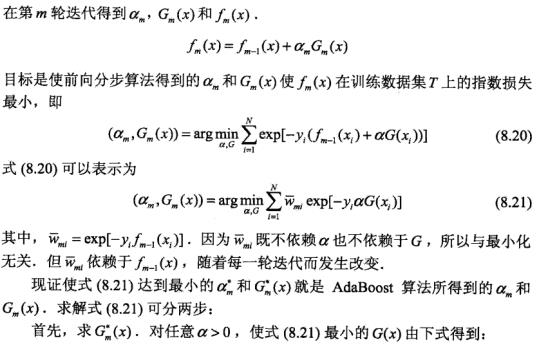

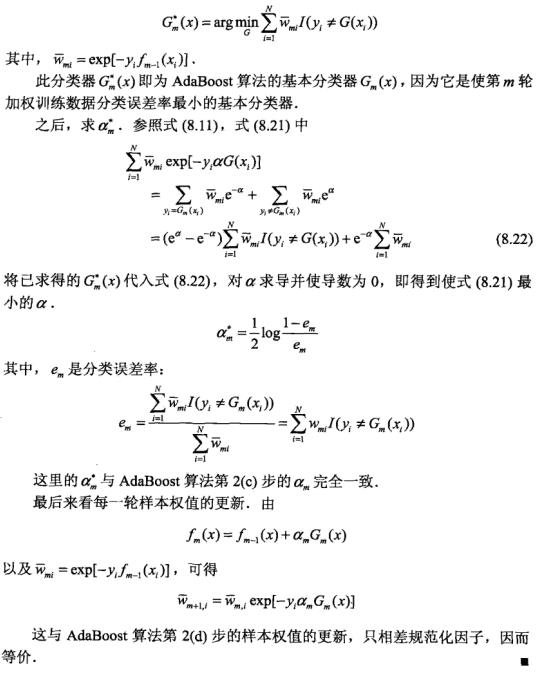

这里它证明了adaboost算法就是前向分布加法算法的特殊例子,这里比较想不通的就是为什么它的损失函数是指数函数,好在文中给出了证明,关键就是在损失函数(指数函数)最小化时,得到的$alpha_m$和$G_m(x)$就是adaboost算法所得到的$alpha_m$和$G_m(x).

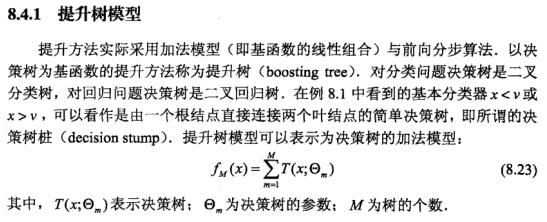

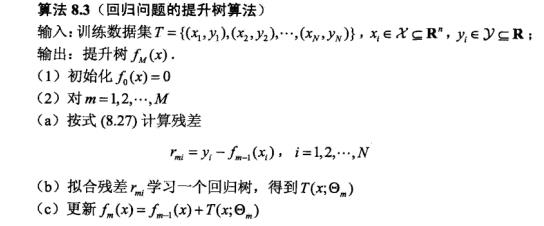

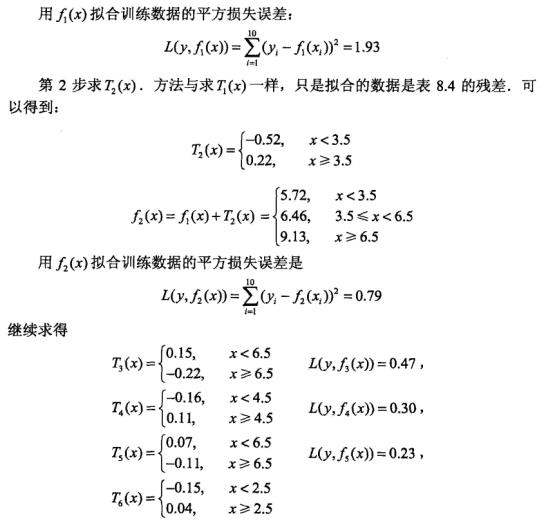

这里实际上就是对所有决策树进行累加,得到最终的结果.

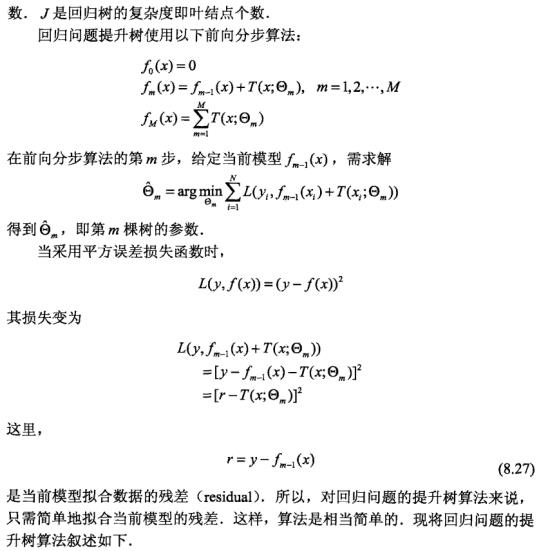

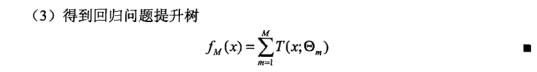

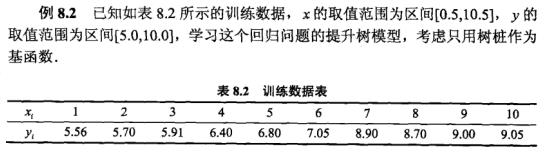

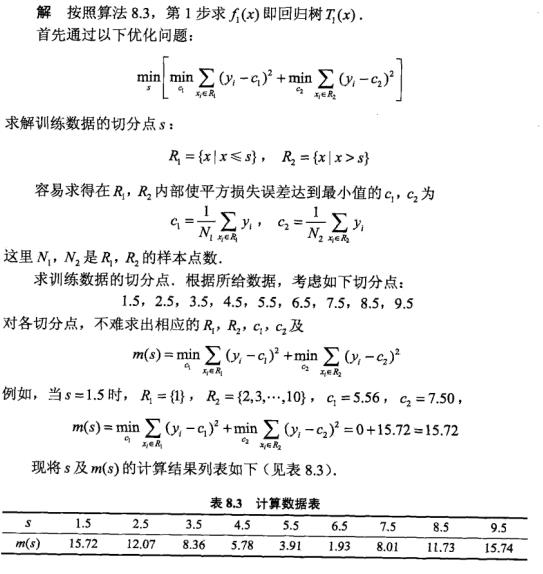

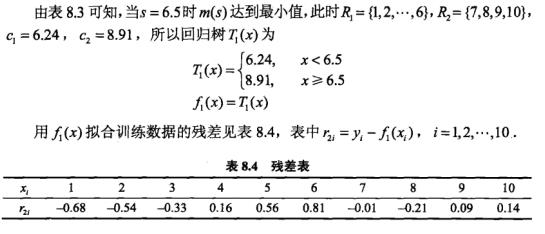

这里一个关键点就是理解残差,实际上它指的是之前形成的提升树的估计值与实际值之前的差距(而在当前步就是对这个差距进行拟合);GBDT思想的一个比方:假如有个人30岁,我们首先用20岁去拟合,发现损失有10岁,这时我们用6岁去拟合刚才剩下的损失(10),发现差距还有4岁,第三轮我们用3岁拟合刚才剩下的差距(4),差距就只有一岁了。如此反复下去,每一轮迭代都是可以减小差距的.

https://blog.csdn.net/qq_39521554/article/details/80714945 这篇博客中的例子也很好,明确说明最终提升树的预测值是每个决策树的结果的累加,每一次生成决策树都是在之前得到的残差之上进行拟合得出的.

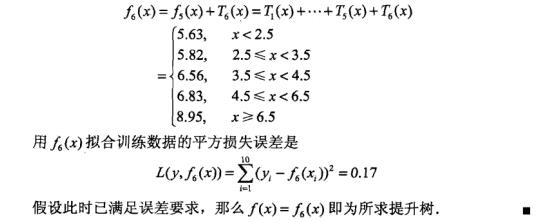

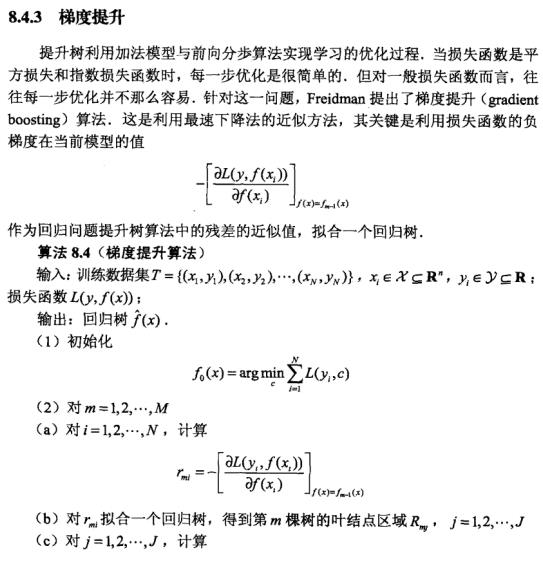

这里就是相当于更一般的情况,即当损失函数过于一般,每一步都不好拟合时,则用负梯度作为ie残差的近似值进行拟合.可参考这篇博客 https://www.jianshu.com/p/0e5ccc88d2cb.

参考:

https://www.cnblogs.com/pinard/p/6140514.html 打的那个年龄比方很好

https://blog.csdn.net/qq_39521554/article/details/80714945 例子挺好的

https://www.jianshu.com/p/0e5ccc88d2cb 讲解梯度提升那块比较详细

以上是关于统计学习方法 李航 提升方法的主要内容,如果未能解决你的问题,请参考以下文章