Scrapy爬虫错误日志汇总

Posted beiyi888

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Scrapy爬虫错误日志汇总相关的知识,希望对你有一定的参考价值。

1、数组越界问题(list index out of range)

原因:第1种可能情况:list[index]index超出范围,也就是常说的数组越界。

第2种可能情况:list是一个空的, 没有一个元素,进行list[0]就会出现该错误,这在爬虫问题中很常见,比如有个列表爬下来为空,统一处理就会报错。

解决办法:从你的网页内容解析提取的代码块中找找看啦(人家比较习惯xpath + 正则),加油 ~

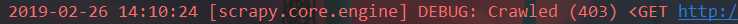

2、http状态代码没有被处理或允许(http status code is not handled or not allowed)

原因:就是你的http状态码没有被识别,需要在settings.py中添加这个状态码信息,相当于C语言中的#define预处理宏定义命令吧(我这么理解)

解决办法:在你的setting.py中,添加这么一句短小精悍的话就OK了,紧接着就等着高潮吧您呐:HTTPERROR_ALLOWED_CODES = [403]

此篇文章持续更新,未完待续....

欢迎大家留下自己的问题,互相讨论,互相学习,互相总结,,,,

以上是关于Scrapy爬虫错误日志汇总的主要内容,如果未能解决你的问题,请参考以下文章