机器学习与Tensorflow——循环神经网络长短时记忆网络

Posted guoruxin

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了机器学习与Tensorflow——循环神经网络长短时记忆网络相关的知识,希望对你有一定的参考价值。

1.循环神经网络的标准模型

- 前馈神经网络能够用来建立数据之间的映射关系,但是不能用来分析过去信号的时间依赖关系,而且要求输入样本的长度固定

- 循环神经网络是一种在前馈神经网络中增加了分亏链接的神经网络,能够产生对过去数据的记忆状态,所以可以用于对序列数据的处理,并建立不同时段数据之间的依赖关系

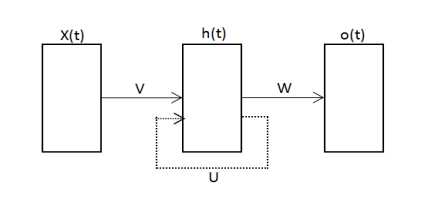

- 循环神经网络是一类允许节点连接成有向环的人工神经网络。如下图:

2.循环神经网络与递归神经网络

- 从广义上说,递归神经网络可以分为结构递归神经网络和时间递归神经网络

- 从狭义上说,递归神经网络可以通常就是指结构递归神经网络,而时间递归神经网络则被称为循环神经网络

3.标准循环神经网络的结构类型(两种)

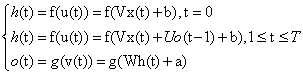

不妨设t时刻,网络的输入向量为x(t),隐含向量为h(t),网络的输出向量是o(t),用V表示输入层与隐含层之间的连接权值,U表示隐含层与隐含层之间的连接权值,W表示隐含层与输出层之间的连接权值,b和a表示隐含层的输出层的偏置

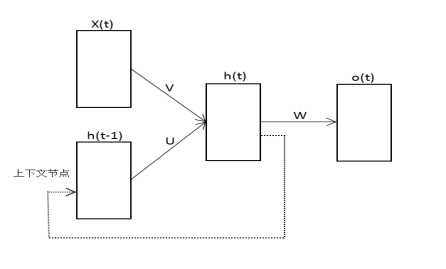

Elman网络:

- 网络结构如下图:

- Elman网络包含从隐含节点到上下文节点的反馈链接,以及从上下文节点调到隐含节点的前馈链接,其中上下文节点的输入是隐含层上一时刻的输出

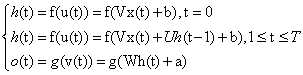

- Elman网络从0时刻到T时刻的计算过程可以描述为:

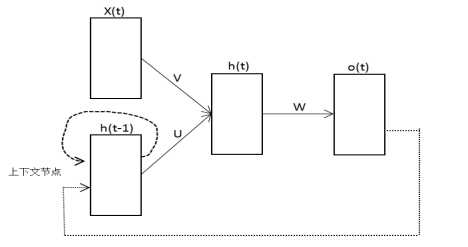

Jordan网络:

- 网络结构如下图:

- Jordan网络包含从输出节点到上下文节点的反馈,以及从上下文节点到隐含节点的前馈链接,其中上下文节点的输入是输出层上一时刻的输出。此外,Jordan网络的上下文节点允许自连接

- Jordan网络从0时刻到T时刻的计算过程可以描述为:

4.长短时记忆网络(long short-term memory,LSTM)

- 长短时记忆网络(LSTM network),又称为长短时记忆循环网络,是一种在经典循环神经网络的基础上发展起来的改进模型。

- LSTM网络的特点在于利用记忆模块代替普通的隐含节点,确保梯度在传递跨越很多时间步骤之后不消失或爆炸,从而能够克服传统循环神经网络训练中遇到的某些困难

- 长短时记忆网络非常适合于从经验中学习分类,以及处理和预测那些在重要事件之间存在未知时长延迟的时间序列

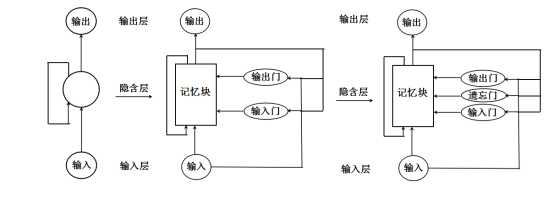

- 循环神经网络和长短时记忆网络之间的对应关系如下图所示:

5.传统记忆块组成

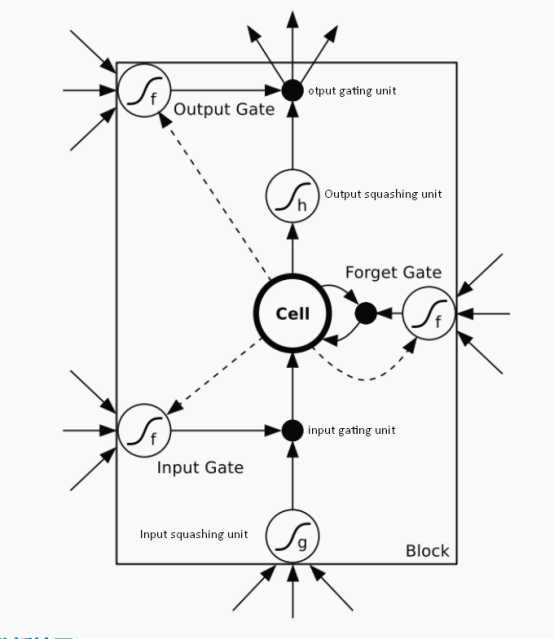

- 传统记忆块有一个或者多个具有内部状态的记忆细胞(memory sell)、一个输入挤压单元(input squashing unit)、一个输入门控单元(input gating unit)、一个输入门单元(input gate unit)、一个输出门单元(output gate unit)、一个输出挤压单元(outnput squashing unit)、和一个输出门控单元(output gating unit)几部分组成。

以上是关于机器学习与Tensorflow——循环神经网络长短时记忆网络的主要内容,如果未能解决你的问题,请参考以下文章