优化算法(Optimization algorithms)

Posted easy-wang

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了优化算法(Optimization algorithms)相关的知识,希望对你有一定的参考价值。

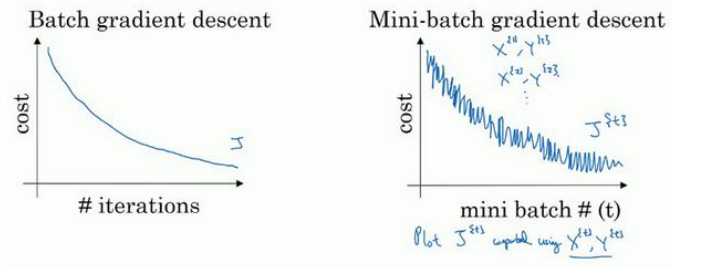

1.Mini-batch 梯度下降(Mini-batch gradient descent)

batch gradient descent :一次迭代同时处理整个train data

Mini-batch gradient descent: 一次迭代处理单一的mini-batch (X{t} ,Y{t})

Choosing your mini-batch size : if train data m<2000 then batch ,else mini-batch=64~512 (2的n次方),需要多次尝试来确定mini-batch size

2.指数加权平均数(Exponentially weighted averages):

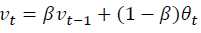

指数加权平均数的公式: 在计算时可视Vt 大概是1/(1-B)的每日温度,如果B是0.9,那么就是十天的平均值,当B较大时, 指数加权平均值适应更缓慢

在计算时可视Vt 大概是1/(1-B)的每日温度,如果B是0.9,那么就是十天的平均值,当B较大时, 指数加权平均值适应更缓慢

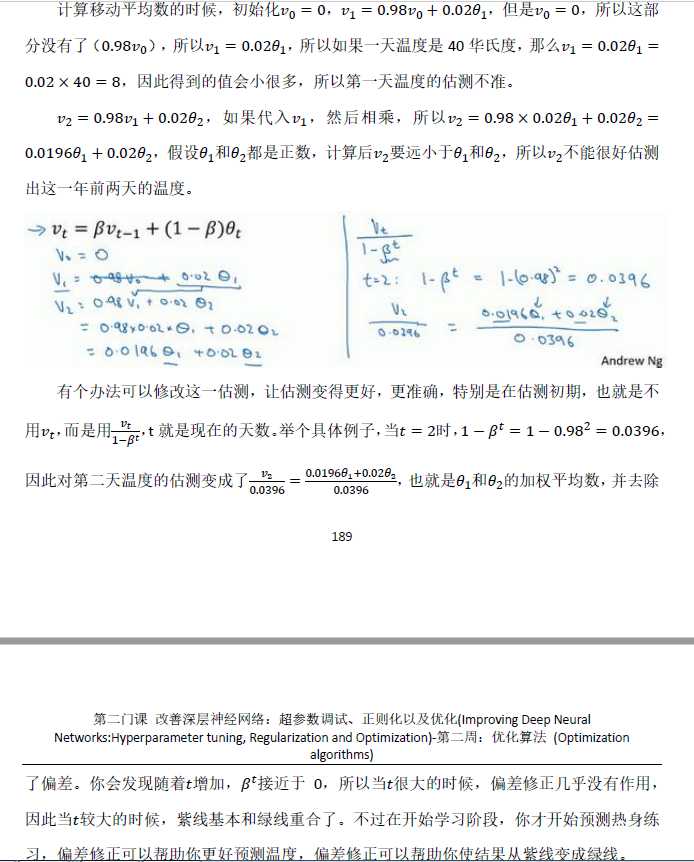

指数加权平均的偏差修正:

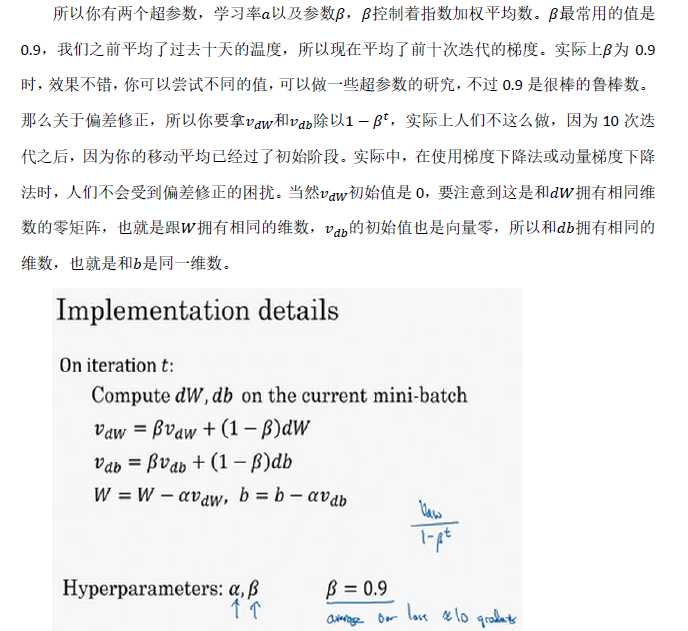

3.动量梯度下降法(Gradinent descent with Momentum)

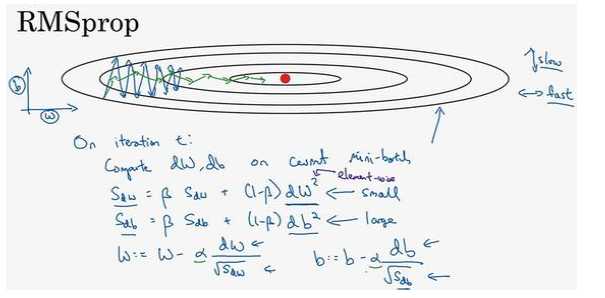

4.RMSprop算法(root mean square prop):

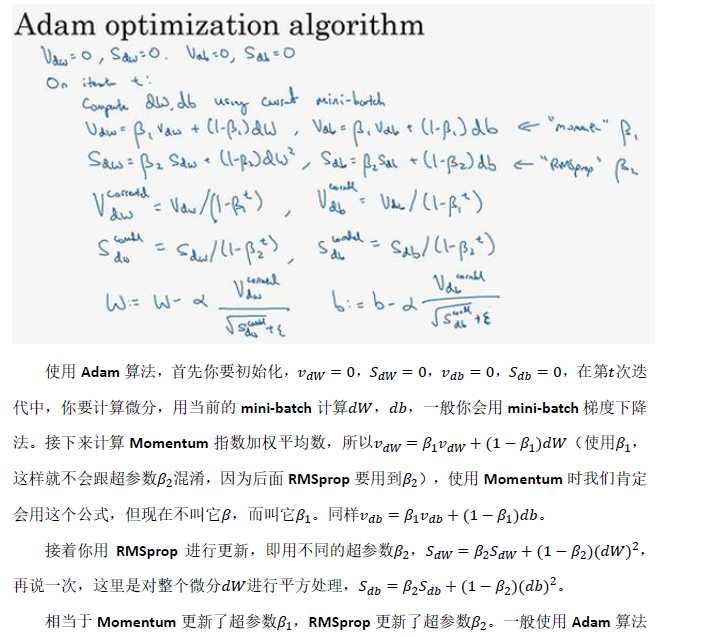

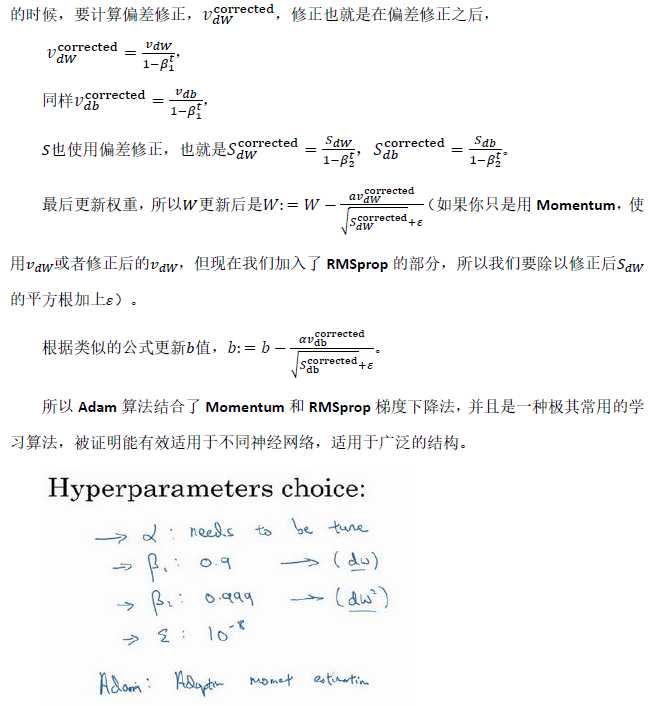

5.Adam 优化算法(Adam optimization algorithm):

Adam 优化算法基本上就是将Momentum 和RMSprop结合在一起

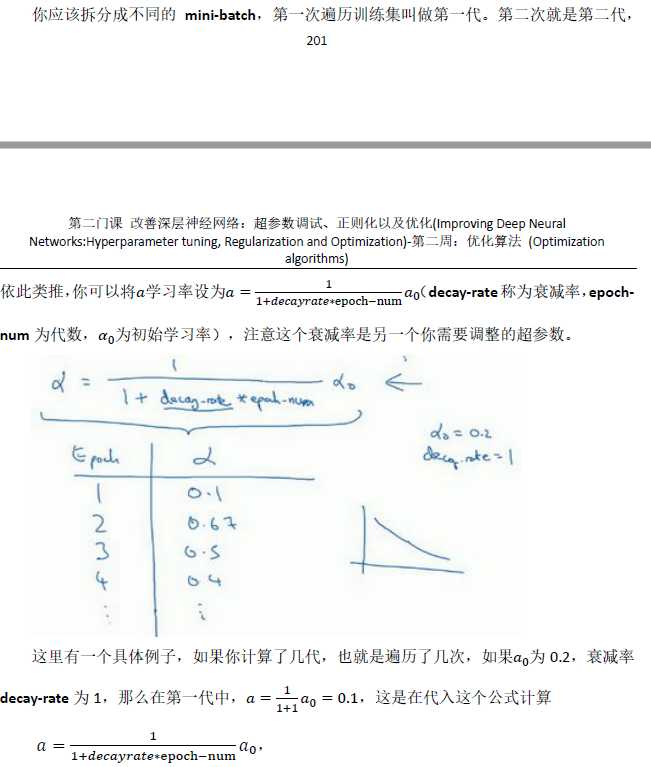

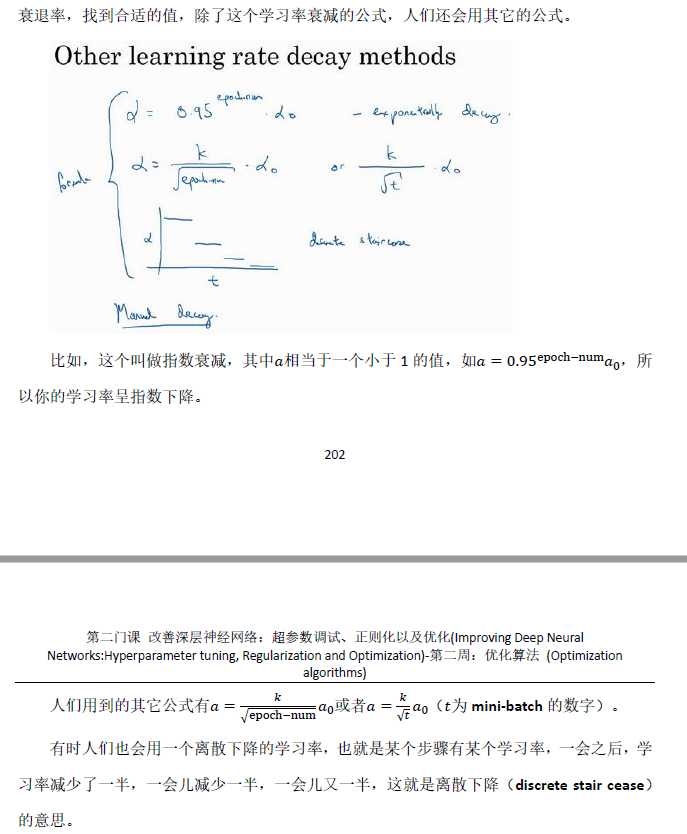

6.学习率衰减(Learning rate decay):

加快学习算法的一个办法就是随时间慢慢减少学习率,这样在学习初期,你能承受较大的步伐,当开始收敛的时候,小一些的学习率能让你步伐小一些。

以上是关于优化算法(Optimization algorithms)的主要内容,如果未能解决你的问题,请参考以下文章

近端策略优化算法(Proximal Policy Optimization Algorithms, PPO)

详解生物地理学优化算法(BBO)Biogeography-Based Optimization

Matlab实现算术优化算法(The Arithmetic Optimization Algorithm)

Matlab实现算术优化算法(The Arithmetic Optimization Algorithm)

标准粒子群优化(Particle Swarm Optimization, PSO)算法

Python使用bayesian-optimization包的BayesianOptimization算法构建贝叶斯优化器获取机器学习模型最优超参数组合实战+代码