激活函数

Posted yongfuxue

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了激活函数相关的知识,希望对你有一定的参考价值。

神经网络需要激活函数的原因

1)非线性激活函数的主要作用:

- 提供网络的非线性建模能力,增强模型的表达能力,双隐层神经网络能够解决任意复杂的分类问题

- 将原始特征从低维空间映射到高维空间(从多项式角度看——它隐含的找到了所需的高次特征项(更好的特征),从而简化了繁重的计算)

2)线性函数不能用作激活函数的原因

- 线性函数的线性组合仍然是线性函数

- 不能解决线性不可分问题

激活函数的分类、演化及优缺点

激活函数的分类

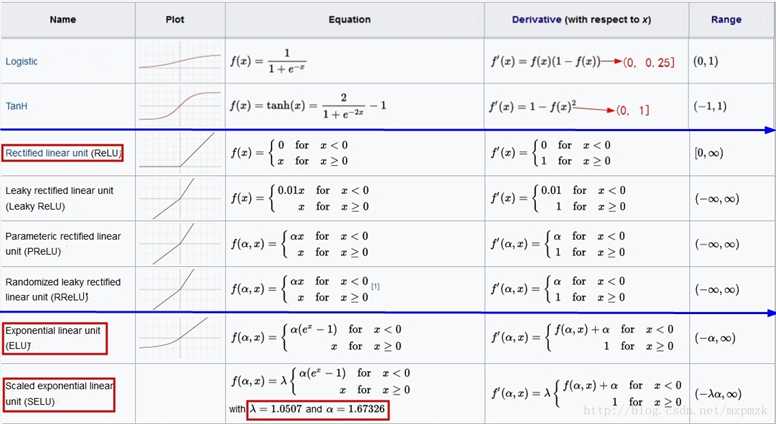

Traditional: sigmoid(logistic)、tanh

RELU Family: RELU、Leaky RELU、PRELU、RRELU

Exponential Family: ELU、SELU

激活函数的演化及优缺点

1)Sigmoid 的优缺点

优点:

可以把输入映射到(0, 1)区间,可以用来表示概率

在物理意义上最为接近生物神经元

缺点:

梯度消失问题

2)Tanh 的优缺点

优点:

0均值,把输入映射到(-1, 1)区间

缺点:

虽然 tanh 的导数区间为(0, 1],但仍然会导致梯度消失问题

3)RELU 的优缺点

优点:

比 sigmoid/tanh 收敛的更快

其导数在其权重和(z) 大于 0 的时候为 1,从而误差可以很好的传播,权重可以正常更新

缺点:

其导数在其权重和(z) 小于 0 的时候为 0,会导致梯度值为0,从而权重无法正常更新

输出具有偏移现象,即输出均值恒大于零

4)ELU

右侧线性部分使得 ELU 能够缓解梯度消失,而左侧软饱能够让 ELU 对输入变化或噪声更鲁棒

以上是关于激活函数的主要内容,如果未能解决你的问题,请参考以下文章