数据分析中几个评估参数

Posted dushangguzhousuoli

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了数据分析中几个评估参数相关的知识,希望对你有一定的参考价值。

在统计学中对变量进行线行回归分析,采用最小二乘法进行参数估计,在数据分析中通常会通过评估参数来评估我们得出的模型对结果的拟合度,通常会用到的参数有:

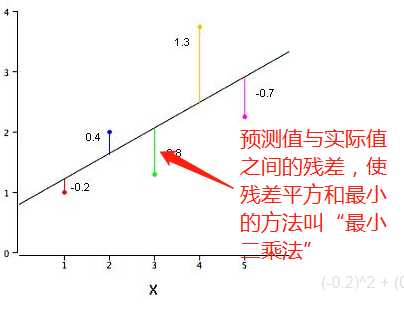

最小二乘法:我们将预测值与实际值之间的差值进行求平方和,这个和我们叫离差平方和,使离差平方和最小的方法叫“最小二乘法”

1、SSE(误差平方和):the sum of squares due to error

2、MSE(均方误差平方和): Mean squares error

3、RMSE(均方根误差平方和): Root mean squares error

4、R-square(确定系数 也叫R^2): cofficient of detrmination

下面对以上几个参数进行总结:

1)SSE(误差平方和)

该统计参数计算的是拟合数据和原始数据对应点的误差平方和,计算公式如下:

SSE=Σ(Y^-Y)^2

SSE越趋近于0,说明模型选择的拟合度越好,预测结果越好。RMSE和MSE的一样也是越趋近于0,模型选择的拟合度越好。

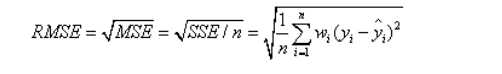

2)MSE(均方误差平方和)

该统计参数计算的是拟合数据和原始数据对应点的误差平方和的均值,即SSE/N (N为样本数):

MSE=SSE/n=Σ(Y^-Y)^2/n

3)RMSE(均方根)

该参数也是回归系统的拟合标准差,即MSE的平方根,

总结:SSE、MSE、RMSE都是原始值与预测值之间的残差平方关系,表现回归中预测值的好坏,这些参数越趋近于0,得出的预测值越好!

4) R-square(确定系数)即R^2

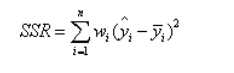

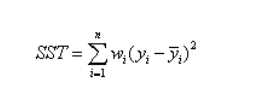

了解确定系数钱,我们先看另外连个参数SSR和SST,因为确定系数由他们两个确定:

(1)SSR:sum of squares of regession,即预测数据与原始数据均值之差的平方和:

(2)SST:Total sum of squares 即原始数据和均值之差的平方和:

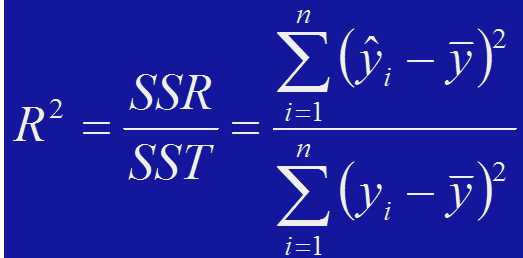

我们可以看出SST=SSE+SSR,而我们的R^2(确定系数)为SSR/SST

R^2=SSR/SST=SST-SSE/SST=1-SSE/SST

总结:

1)、R^2:决定系数,反映因变量的全部变化能通过回归关系被自变量解释的比例

2)、R^2 是非负统计量

3)、R^2的取值范围为0~1,R^2的值越趋近于1表示得出的模型对原始数据的因变量解释下越好,反之越差!

4)、R^2是样本观测值的函数,可决定系数R^2是随着抽样变动而随机变动,为此要对R^2的统计可靠性进行检验。

以上是关于数据分析中几个评估参数的主要内容,如果未能解决你的问题,请参考以下文章