Spark教程-Spark概述及相关组件

Posted guan-li

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Spark教程-Spark概述及相关组件相关的知识,希望对你有一定的参考价值。

1.概述

Spark起源于加州大学伯克利分校RAD实验室,起初旨在解决MapReduce在迭代计算和交互计算中的效率低下问题.目前Spark已经发展成集离线计算,交互式计算,流计算,图计算,机器学习等模块于一体的通用大数据解决方案.

2.Spark组件

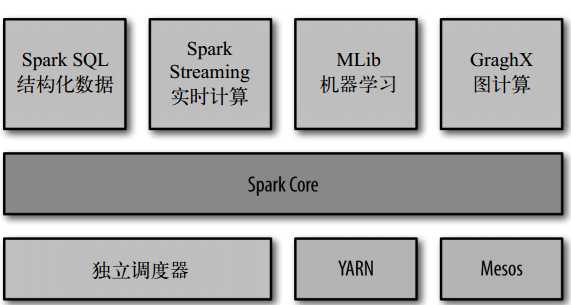

- Spark Core

Spark Core 实现了 Spark 的基本功能,包含任务调度、内存管理、错误恢复、与存储系统

交互等模块。

Spark Core 中还包含了对弹性分布式数据集(resilient distributed dataset,简

称 RDD)定义。

- SparkSQL

SparkSQL是对计算任务的SQL化封装,类似于Hive.

支持多种数据源,如Hive,Json等.

- Spark Streaming

Spark Streaming是Spark的流式计算组件.

- MLlib

机器学习组件,提供了常用的机器学习算法包.

- GraphX

图计算组件,提供的图数据库和常用的图算法包.

- 调度器

支持三种调度器,独立调度器(Spark自带)YARN,Mesos.

3.第一个Spark小程序

启动HDFS,启动Spark

进入shell

bin/spark-shell

bin/pyspark(Python版)

scala> var lines = sc.textFile("/test/hello.txt")

lines: org.apache.spark.rdd.RDD[String] = /test/hello.txt MapPartitionsRDD[5] at textFile at <console>:24

scala> lines.count()

res3: Long = 3

scala> lines.first()

res4: String = hello Spark!以上是关于Spark教程-Spark概述及相关组件的主要内容,如果未能解决你的问题,请参考以下文章