学习记忆循环神经网络心得

Posted iors

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了学习记忆循环神经网络心得相关的知识,希望对你有一定的参考价值。

如有缪误欢迎指正

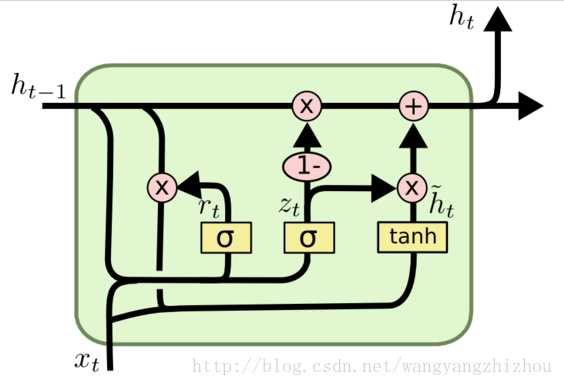

GRU结构向前传播 心得(欢迎指正)

当遗忘门等于0的时候当前信息抛弃 之前记忆前传

当遗忘门等于1 的时候之前记忆抛弃 当前信息前传

当遗忘门的值为0和1之间的时候 调控前传的记忆与信息的比例

QAQ

Q:LSTM与GRU 的区别

A: LSTM 数据量大的时候选用

A: GRU 结构相对简单,但是训练速度会快一些

通常商业应用多选用LSTM

以上是关于学习记忆循环神经网络心得的主要内容,如果未能解决你的问题,请参考以下文章

长短期记忆网络 LSTM 深层循环神经网络 Deep RNN 双向循环神经网络 Bidirectional RNN 动手学深度学习v2

长短期记忆网络 LSTM 深层循环神经网络 Deep RNN 双向循环神经网络 Bidirectional RNN 动手学深度学习v2

Keras深度学习实战——使用长短时记忆网络构建情感分析模型

智者见“智”|如何给神经网络装上记忆机制? 循环神经网络入门