半监督学习

Posted kexinxin

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了半监督学习相关的知识,希望对你有一定的参考价值。

半监督学习

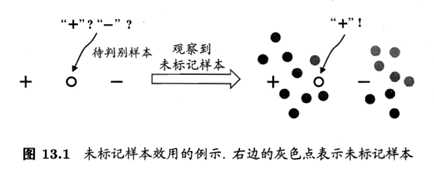

事实上,未标记样本虽然未直接包含标记信息,但若它们与有标记样本是从同样的数据源独立同分布采样而来,则它们所包含的关于数据分布的信息对建立模型将有很大的益。下图给出了一个直观的例子,若仅基于图中的一个正例和一个反例,则由于待判别样本恰位于两者正中间,大体上只能随机猜测;若能观察到图中的未标记样本,则将很有把握地判别为正例。

让机器不依赖外界交互、自动地利用未标记样本来提升学习性能,就是半监督学习(semi-supervised learning)。

要利用未标记样本,必须要做一些将未标记样本所揭示的数据分布信息与类别标记相联系的假设,最常见的是"聚类假设",即假设数据存在簇结构,同一个簇的样本属于同一个类别。半监督学习中的另一种常见的假设是"流形假设"(manifold assumption),即假设数据分布在一个流形结构上,临近的样本拥有相似的输出值。"邻近"程度常用"相似"程度来刻画,因此,流形假设可以看做聚类假设的推广,但流形假设对输出值没有限制,因此比聚类假设的适用范围更广,可用于更多类型的学习任务。事实上,无论聚类假设还是流形假设,其本质都是"相似的样本拥有相似的输出"这个基本假设。

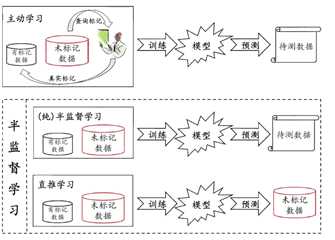

半监督学习可进一步划分为纯(pure)半监督学习和直推学习(transductive learning),前者假定训练数据中的未标记样本并非待预测的数据,而后者则假定学习过程中所考虑的未标记样本恰是待预测数据,学习的目的就是在这些未标记样本上获得最优泛化性能。换言之,纯半监督学习是基于"开放世界"假设,希望学得模型能适用于训练过程中未观察到的数据,而直推学习是基于"封闭世界"假设,仅试图对学习过程中观察到的未标记数据进行预测。

生成方法式

生成方法(generative methods)是直接基于生成式模型的方法,此类方法假设所有数据(无论是否有标记)都是由同一个潜在模型"生成"的。这个假设使得我们能通过潜在模型的参数将未标记数据与学习目标联系起来,而未标记数据的标记则可看作模型的参数,通常可基于EM算法进行极大似然估计求解,此类方法的区别主要在于生成式模型的假设,不同的模型假设将产生不同的方法。

常见的生成式模型有高斯混合模型,混合专家模型,朴素贝叶斯模型。

半监督SVM

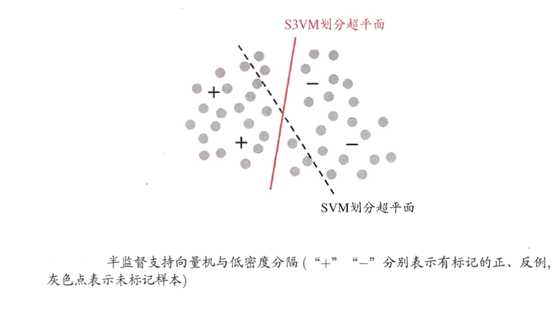

半监督支持向量机(Semi-Supervised Support Vector Machine 简称S3VM)是支持向量机在半监督学习上的推广。在不考虑未标记样本时,支持向量机试图找到最大间隔划分超平面,而在考虑未标记样本后,S3VM试图找到能将两类有标记样本分开,且穿过数据底密度区域的划分超平面,这里的基本假设是"低密度分隔"(low-density separation)

半监督支持向量机中最著名的是TSVM(Transductive Support Vector Machine),与标准SVM一样,TSVM也是针对二分类问题的学习方法。TSVM试图考虑对未标记样本各种可能的标记指派(label assignment),即尝试每个未标记样本分别作为正例或反例,然后再所有这这些结果中,寻找一个在所有样本(包括有标记样本和进行了指派的未标记样本)上间隔最大化的划分超平面,一旦划分超平面得以确定,未标记样本的最终标记指派就是其预测结果。

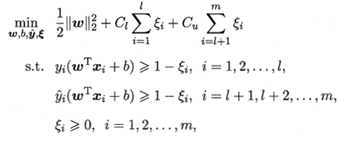

形式化地说,给定和,其中

. TSVM的学习目标是为中的样本给出预测标记

, , 使得

其中,(w,b)确定一个划分超平面;为松弛向量,对应于有标记样本,对应于未标记样本;与是由用户指定的用于平衡模型复杂度、有标记样本与未标记样本重要程度的折中参数。

显然,尝试未标记样本的各种标记指派是一个穷举过程,仅当未标记样本很少时才有可能直接求解,在一般情况下,考虑更高效的优化策略。

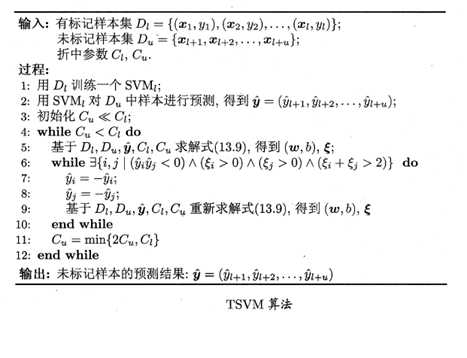

TSVM采用局部搜索来迭代地寻找最优解。具体来说,它先利用有标记样本学得一个SVM,即忽略式中的约束。然后,利用这个SVM对未标记数据进行标记指派(label assignment),即将SVM预测的结果作为"伪标记"(pseudo-label)赋予未标记样本。此时成为已知,将其代入式中即可得到一个标准SVM问题,于是可求解出新的划分超平面和松弛向量;注意到此时未标记样本的伪标记可能不准确,因此要设置比小的值,使有标记样本所起作用更大。接下来,TSVM找出两个标记指派为异类且很可能发生错误的未标记样本,交换它们的标记,再重新基于上式求解出更新后的划分超平面和松弛向量,重复该过程,并逐渐增大以提高未标记样本对优化目标的影响,进行下一轮标记指派调整,直至为止。此时求解得到的SVM不仅给未标记样本提供了标记,还能对训练·过程中未见的示例进行预测。TSVM的算法描述如下图:

显然,搜寻标记指派可能出错的每一对未标记样本进行调整,是一个涉及巨大计算开销的大规模优化问题,因此,半监督SVM研究的一个重点是如何设计出高效的优化求解策略,由此发展出很多方法,如基于图核(graph kernel)函数梯度下降的LDS、基于标记均值估计的meanS3VM等。

以上是关于半监督学习的主要内容,如果未能解决你的问题,请参考以下文章