pyspark建立RDD以及读取文件成dataframe

Posted lee-yl

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了pyspark建立RDD以及读取文件成dataframe相关的知识,希望对你有一定的参考价值。

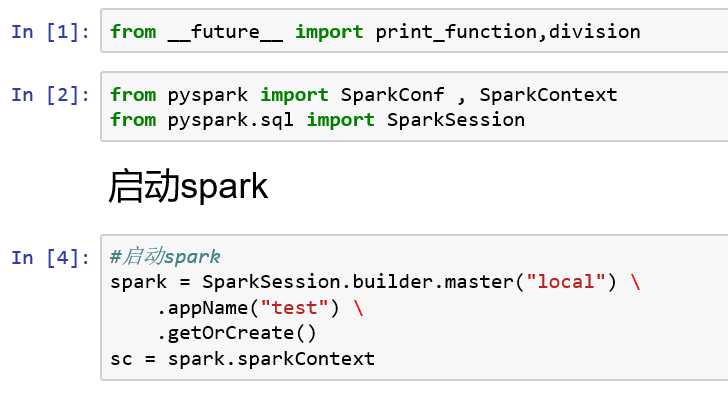

1、启动spark

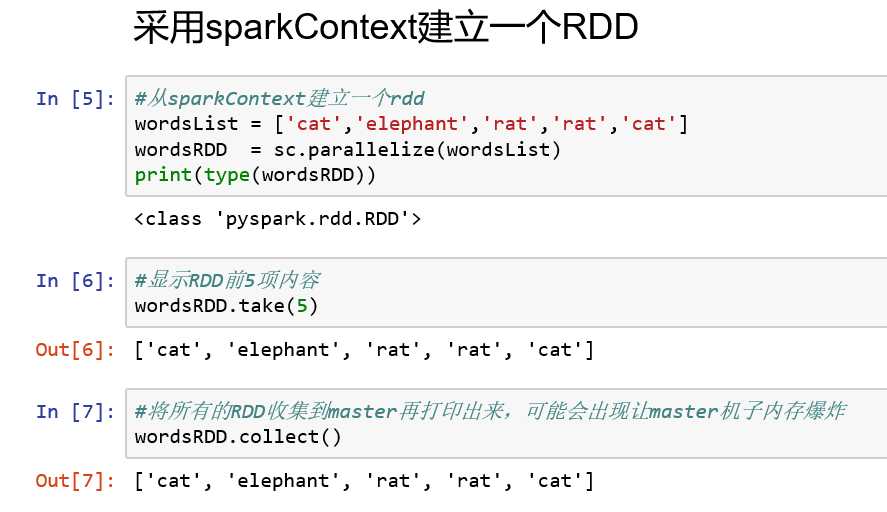

2、建立RDD:

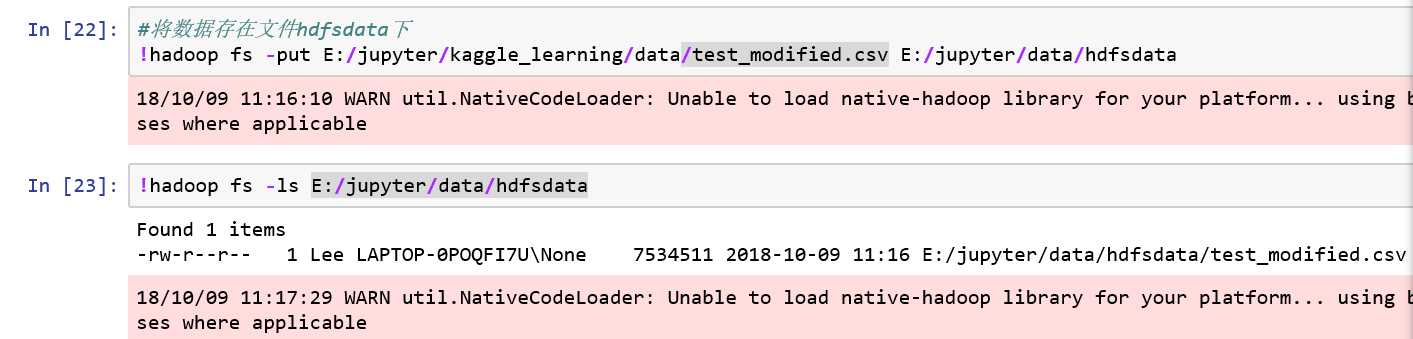

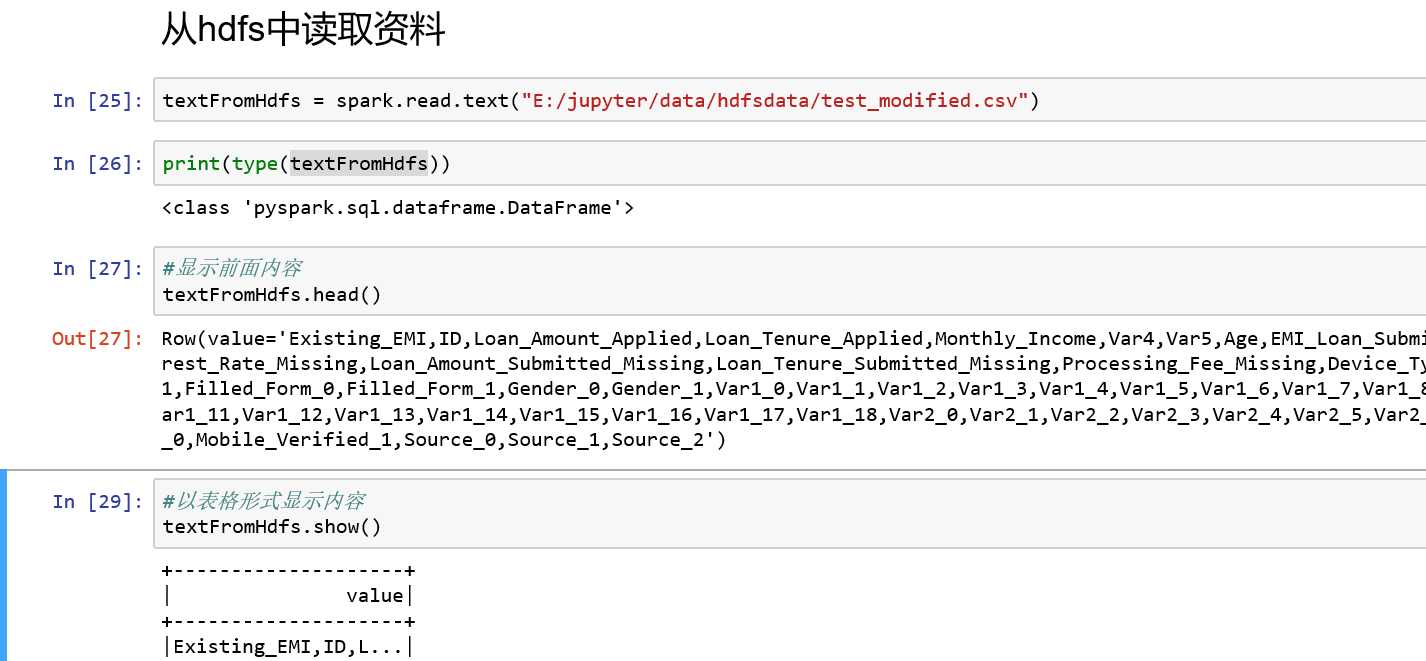

3、从text中读取,read.text

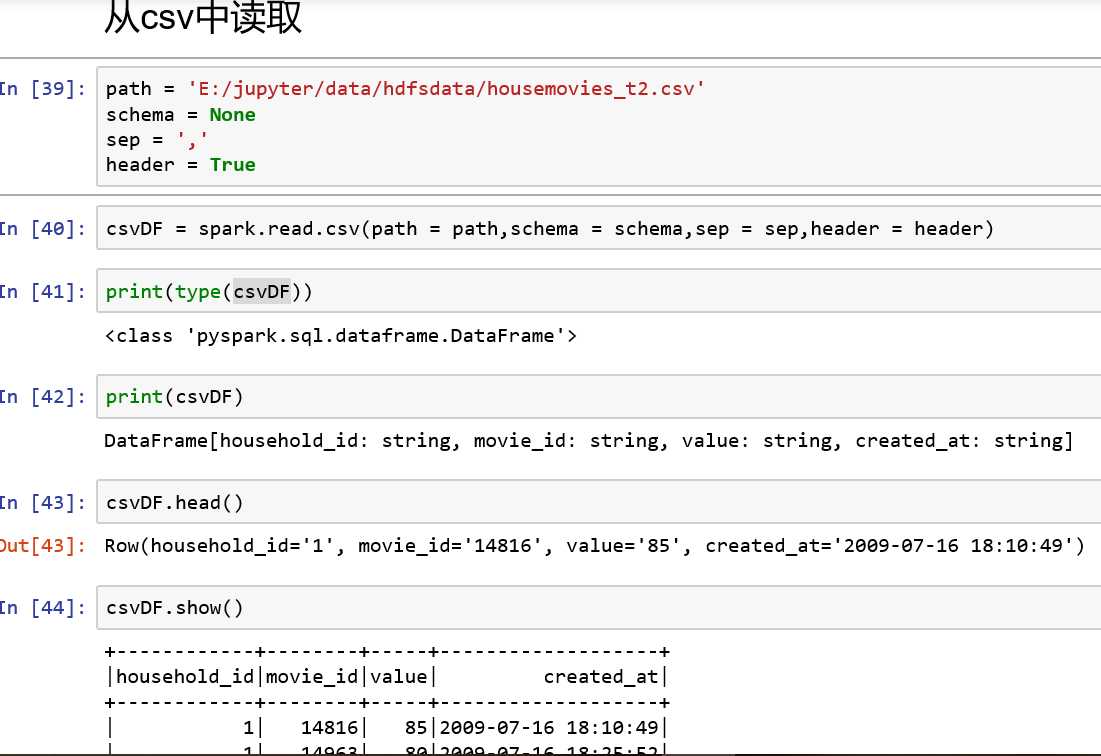

4、从csv中读取:read.csv

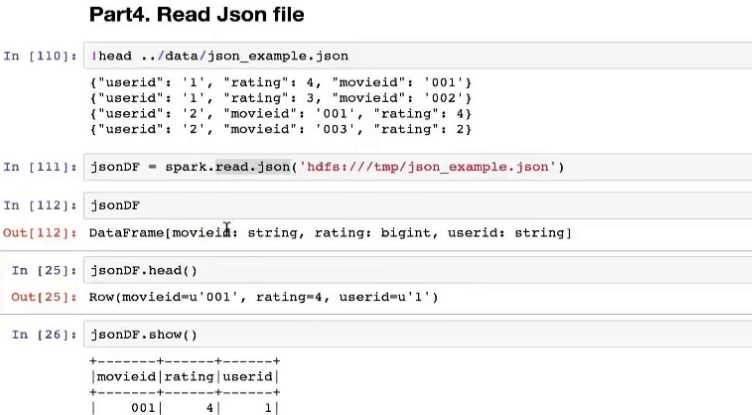

5、从json中读取:read.json

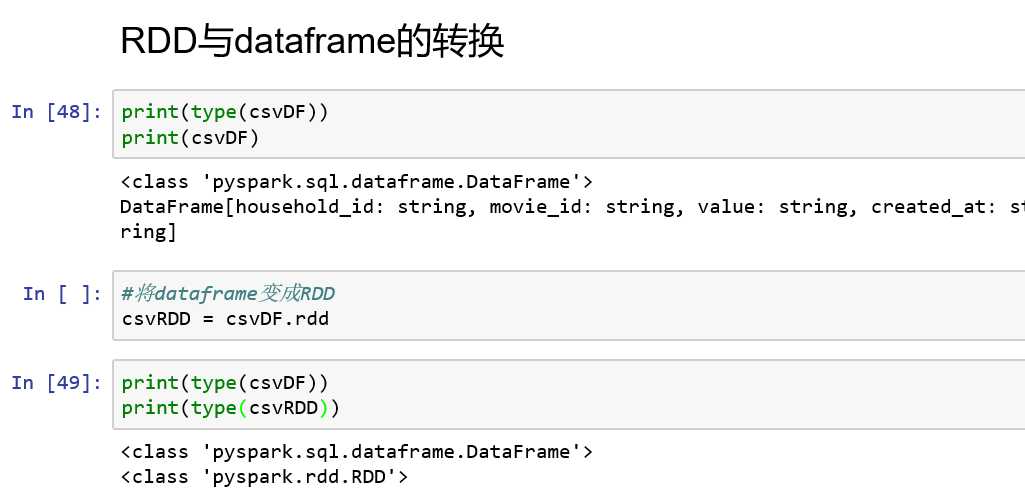

7、RDD与Dataframe的转换

(1)dataframe转换成rdd:

法一:datardd = dataDataframe.rdd

法二:datardd = sc.parallelize(_)

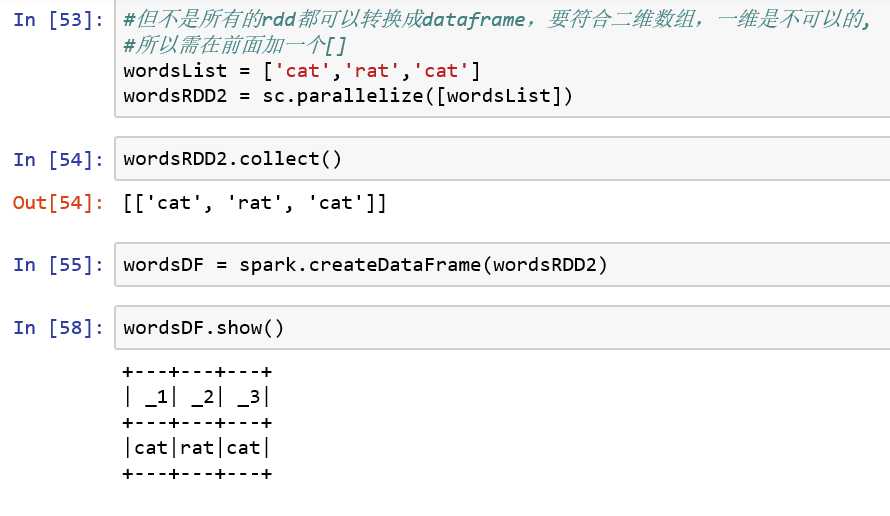

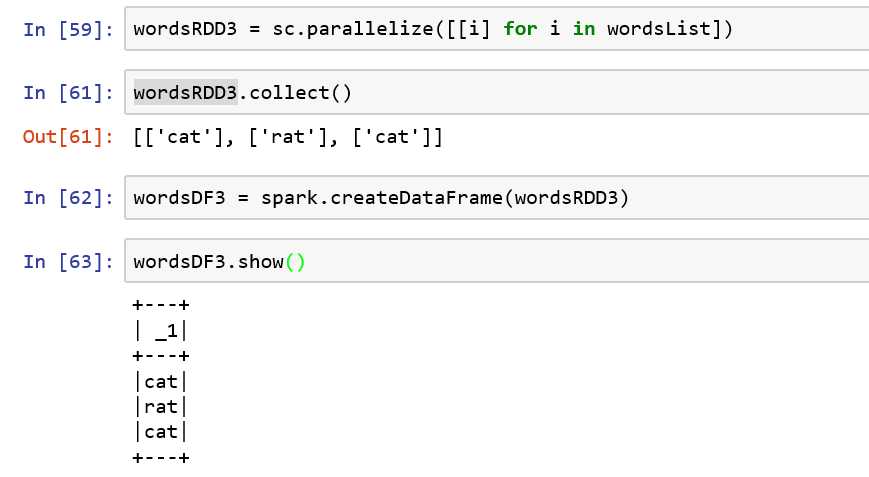

(2)rdd转换成dataframe:

dataDataFrame = spark.createDataFrame(datardd)

以上是关于pyspark建立RDD以及读取文件成dataframe的主要内容,如果未能解决你的问题,请参考以下文章