关于spark与scala版本问题记录

Posted little-horse

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了关于spark与scala版本问题记录相关的知识,希望对你有一定的参考价值。

记录一下版本问题:

spark与scala版本对应问题:

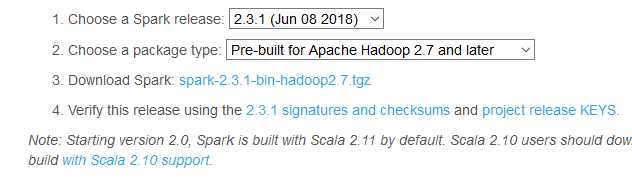

1.官网会给出,如下,spark2.3.1默认需要scala2.11版本

2.在maven依赖网中也可以看到,如下

3.关于idea开发版本中也可以看到所需要依赖的scala版本

通常在file->project structure->global libraries 右侧,点击加号将scala sdk加入后,最右侧有个下拉框,可以看到此idea支持的一些scala版本号

如果通过加入的scala sdk版本超出idea所需要的scala版本会无法使用

4.可以不通过上面的方式加入scala sdk,可以通过pom形式加入所需scala依赖项,也可以开发spark和scala程序

以上是关于关于spark与scala版本问题记录的主要内容,如果未能解决你的问题,请参考以下文章