对faster rcnn 中rpn层的理解

Posted my0213

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了对faster rcnn 中rpn层的理解相关的知识,希望对你有一定的参考价值。

1.介绍

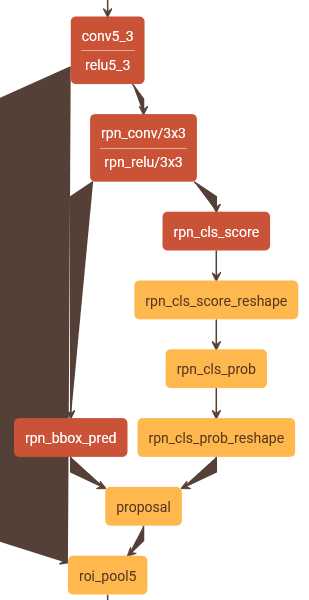

图为faster rcnn的rpn层,接自conv5-3

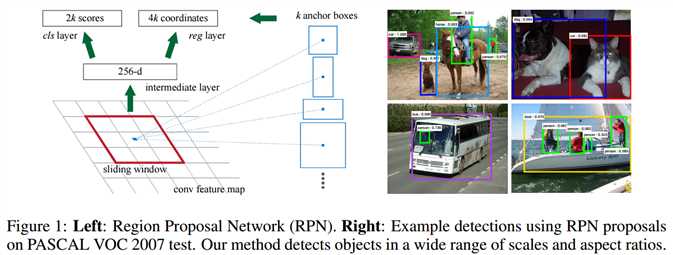

图为faster rcnn 论文中关于RPN层的结构示意图

2 关于anchor:

一般是在最末层的 feature map 上再用3*3的窗口去卷积特征。当3*3的卷积核滑动到特征图的某一个位置时,以当前滑动窗口中心为中心映射到原图的一个区域(注意 feature map 上的一个点是可以映射到原图的一个区域的,这个很好理解,感受野起的作用啊~...),以原图上这个区域的中心对应一个尺度和长宽比,就是一个anchor了。fast rcnn 使用3种尺度和3种长宽比(1:1;1:2;2:1),则在每一个滑动位置就有 3*3 = 9 个anchor。

3 关于结构如图1所示:

1、conv5_3->rpn_conv/3*3->rpn_relu对应于文中进行n*n的卷积。这里输出的维数(output)为512,高H和宽W为输入的图像原始大小的1/16。(1,512,H,W)(前面有四个池化层)

2、rpn_relu->rpn_cls_score->rpn_cls_score_reshape->rpn_cls_prob->rpn_cls_prob_reshape

这里是预测每个点的前景背景概率。rpn_cls_score实际上就是一个1*1的卷积层而已。

如果有A个anchor,每个anchor都有一个前景概率一个背景概率(2*A),输出的大小为(1,2*A,H,W)。

这里的reshape只是为了利用softmax层进行概率的计算而已。

3、rpn_relu->rpn_bbox_pred

这里就是预测每个点的boundingbox。同样的,rpn_bbox_pred也是一个1*1的卷积层而已。输出大小为(1,4*A,H,W) 。

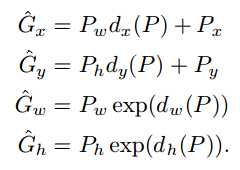

关键在此,这里输出的并不是一个boundingbox的左上右下坐标,而是一个修改量(boundingbox regression)。在r-cnn的supplementary material中,给出了下面几个公式

这里面的

这里面的就是的anchor(高、宽、中心),而里面的

是rpn_bbox层输出的四个值,

就是修改之后的高、宽、中心。

4、(rpn_bbox_pred+rpn_cls_prob_reshape)->proposal_layer

这里的proposal_layer就完成了上述修正,并且进行NMS(非极大抑制)以及概率排序等获得最终的boundingbox。这样就完成了在同一个点上获得不同尺度不同比例的包围盒。

输出大小为:(N,4),这里的 N与NMS以及概率排序阈值有关,得到的就是boundingbox的四个坐标。

4 关于FRCNN box回归为什么采用smooth L1 loss

对于边框的预测是一个回归问题。通常可以选择平方损失函数(L2损失)$f(x)=x^2$。但这个损失对于比较大的误差的惩罚很高。我们可以采用稍微缓和一点绝对损失函数(L1损失)$f(x)=|x|$,它是随着误差线性增长,而不是平方增长。

但这个函数在0点处不可导,因此可能会影响收敛。一个通常的解决办法是在0点附近使用平方函数使得它更加平滑。它被称之为平滑L1损失函数。它通过一个参数$sigma$来控制平滑的区域。

以上是关于对faster rcnn 中rpn层的理解的主要内容,如果未能解决你的问题,请参考以下文章