Spark运行架构章节遇到的问题

Posted hotmemo

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Spark运行架构章节遇到的问题相关的知识,希望对你有一定的参考价值。

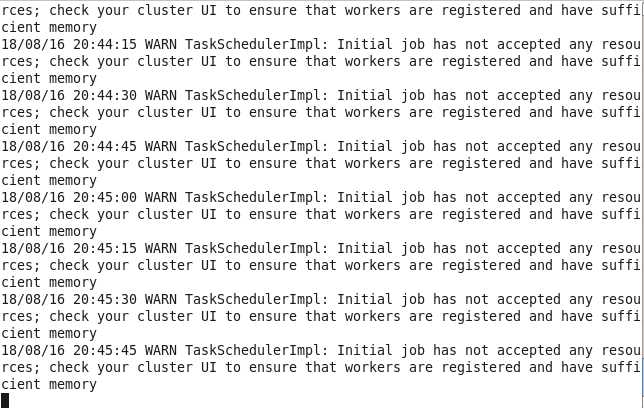

在spark中运行./spark-shell --master YARN-client --num-executors 3 --executor-memory 1g是碰到如下的问题:

biaoshi

表示资源不足,可能是内存不足或者core不足,于是就将1g改为512m,运行成功

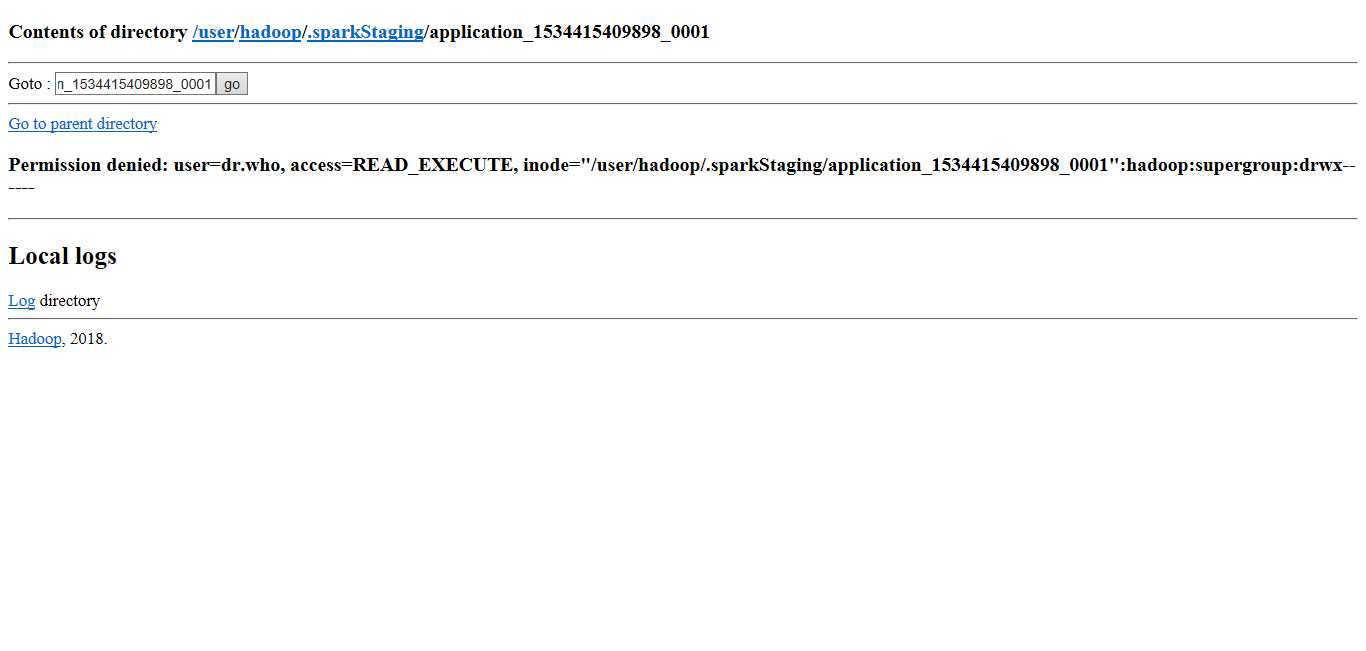

以spark-client运行时候查看hdfs时,以http://hadoop1:50070查看,发现多了一个.sparkStaging文件夹

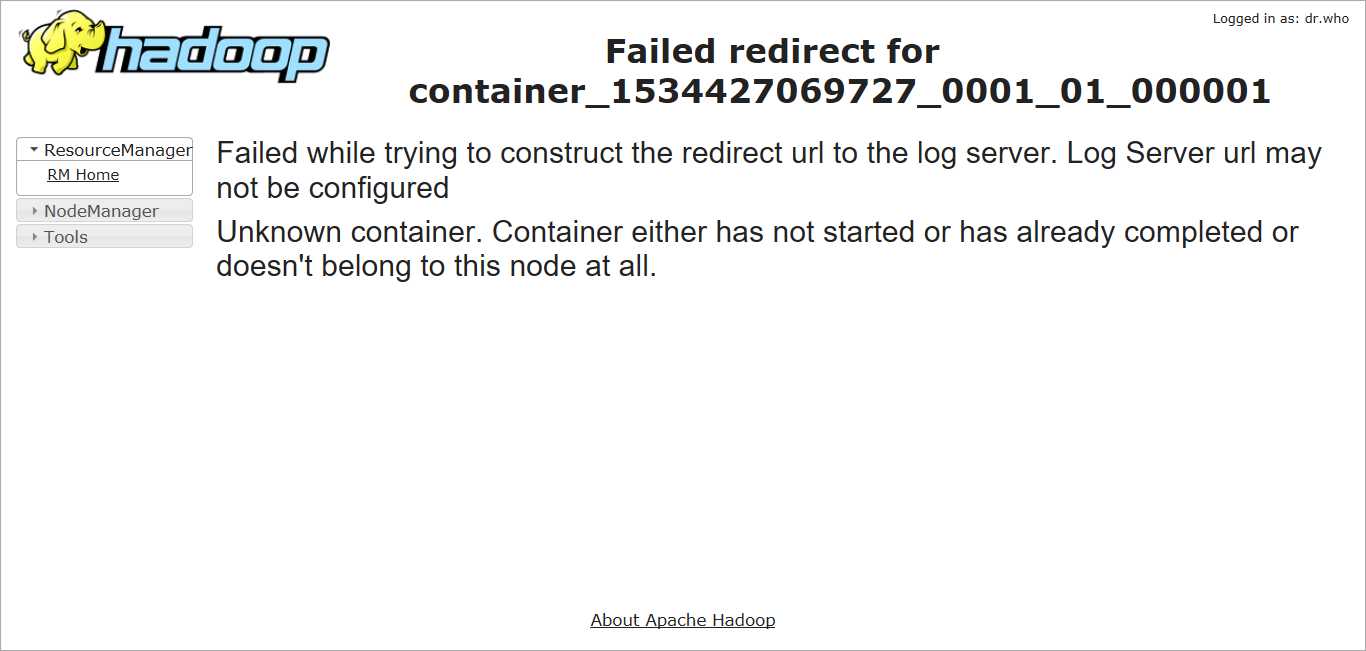

以spark-client运行时碰到如下问题,是因为log server没有开启

解决办法:

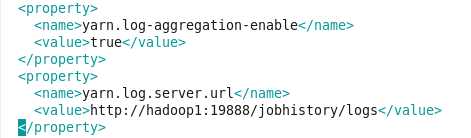

修改mapred-site.xml和 yarn-site.xm

yarn-site.xml添加:

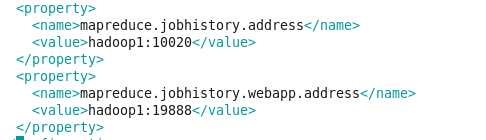

mapred-site.xml添加:

以上是关于Spark运行架构章节遇到的问题的主要内容,如果未能解决你的问题,请参考以下文章

Apache Spark 聚合函数在运行时遇到 ArrayIndexOutOfBoundsException

运行 Spark 时遇到“WARN ProcfsMetricsGetter:尝试计算页面大小时出现异常”错误

遇到的问题---spark---spark OutOfMemoryError: Java heap space

遇到的问题---spark---spark OutOfMemoryError: Java heap space